香港中文大学和思谋科技的研究人员推出强大且高效的图像和视频生成控制方法ControlNeXt,它同时支持图像和视频,并能整合多种形式的控制信息。在这个项目中,我们提出了一种新方法,与 ControlNet 相比,该方法将可训练参数减少了高达 90%,实现了更快的收敛速度和卓越的效率。这种方法可以直接与其他 LoRA 技术相结合来改变风格,并确保更加稳定的生成效果。

- 项目主页:https://pbihao.github.io/projects/controlnext/index.html

- GitHub:https://github.com/dvlab-research/ControlNeXt

- 模型地址:https://huggingface.co/Pbihao/ControlNeXt

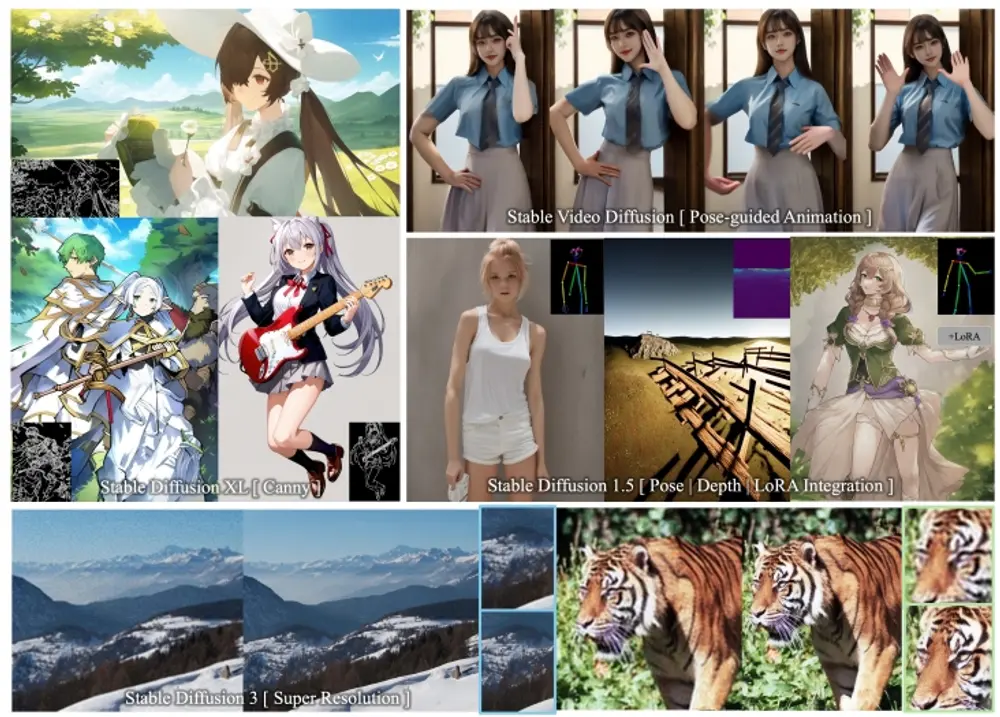

研究人员首先设计了一个更简单且更高效的架构,用最小的成本替换掉了原本复杂的附加分支,相比基础模型,这种简洁的结构也使ControlNeXt能够无缝地与其他LoRA权重结合,无需额外训练即可实现风格改变。在训练方面,与替代方案相比,研究人员将可学习的参数减少了高达90%。此外,研究人员还提出了一种称为Cross Normalization (CN)的方法,作为“零卷积”的替代方案,以实现快速且稳定的训练收敛。研究人员使用不同的基础模型进行了多项实验,证明了我们方法的稳健性。

主要功能:

- 提供对生成图像和视频的精确控制,包括风格、内容和条件等。

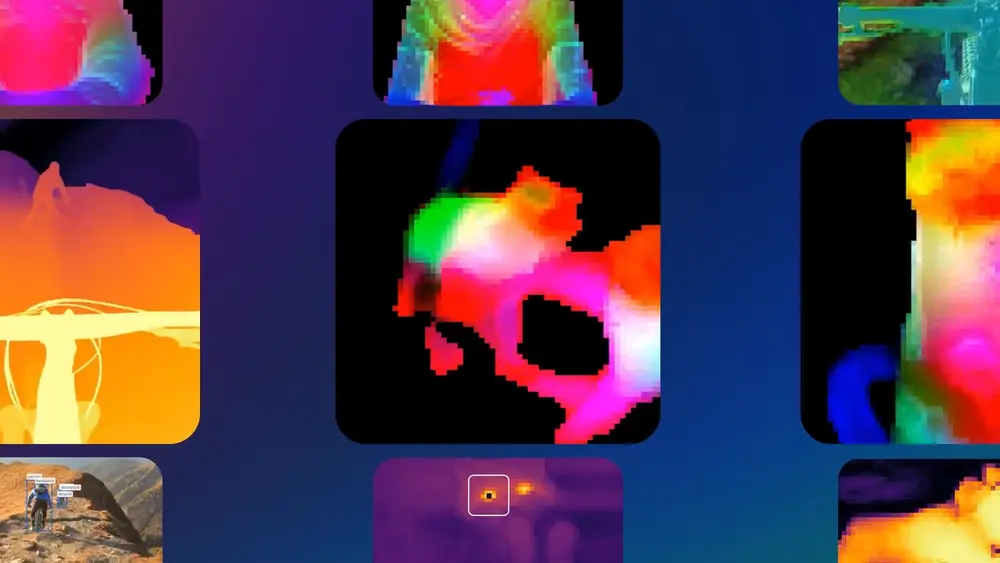

- 支持各种类型的条件控制,如遮罩、深度、边缘检测和姿势等。

主要特点:

- 高效性:与现有方法相比,ControlNeXt大大减少了额外的计算资源需求,特别是对于视频生成。

- 兼容性:可以轻松集成到其他模型和框架中,作为一个即插即用(plug-and-play)的模块。

- 简化架构:通过精简的设计,替换了原有模型中复杂的额外分支,减少了可训练参数的数量。

工作原理:

ControlNeXt首先设计了一个更直接、高效的架构,用轻量级卷积网络替代了原有的控制分支,以最小的额外成本提取条件控制特征。在训练过程中,它通过冻结大部分预训练模型的模块,并选择性地训练一小部分预训练参数,从而避免了过拟合并显著减少了可训练参数的数量。此外,论文还提出了一种称为"Cross Normalization"(交叉归一化)的方法,以替代"zero-convolution"(零卷积),以实现快速且稳定的训练收敛。

具体应用场景:

- 艺术创作:艺术家可以使用ControlNeXt生成具有特定风格或特征的艺术作品。

- 动画制作:在动画产业中,ControlNeXt可以根据角色的姿势序列生成连贯的动作,提高动画制作的效率。

- 个性化内容生成:用户可以根据自己的需求,生成具有个性化特征的图像和视频内容。

- 视频游戏开发:游戏开发者可以利用ControlNeXt快速生成游戏内的角色动画和场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...