随着大语言模型(LLMs)在自然语言处理任务中的显著进步,研究人员开始探索类似的文本到图像合成方法。与此同时,扩散模型已经成为视觉生成的主流方法。然而,由于语言和视觉任务之间存在显著的操作差异,开发统一的方法面临着重大挑战。最近的一些进展试图弥合这一差距,例如 LlamaGen 使用离散图像令牌进行自回归图像生成,但这种方法效率低下。非自回归方法如 MaskGIT 和 MUSE 尽管减少了解码步骤,但在生成高质量、高分辨率的图像方面仍然不足。

- GitHub:https://github.com/viiika/Meissonic

- 模型:https://huggingface.co/MeissonFlow/Meissonic

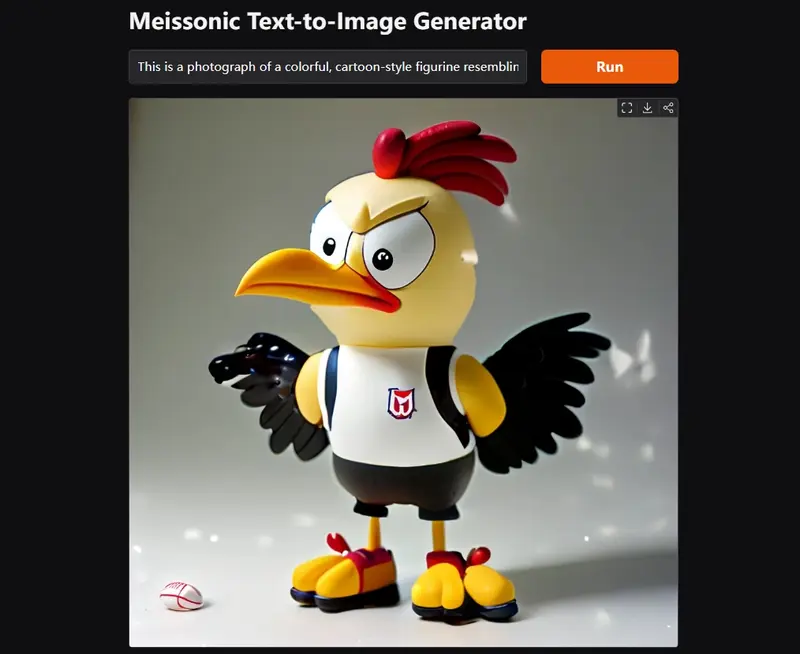

- Demo:https://huggingface.co/spaces/MeissonFlow/meissonic

为了解决上述问题,阿里巴巴集团、Skywork AI、香港科技大学(广州)、香港科技大学、浙江大学和加州大学伯克利分校的研究人员提出了一种新的方法——Meissonic。Meissonic 是一种非自回归 MIM 文本到图像合成模型,旨在生成高质量、高分辨率的图像,并在性能和效率上与最先进的扩散模型相媲美。

主要功能和特点:

- 高效能:Meissonic能够在不需要额外训练或复杂的注意力机制的情况下,快速生成高质量的图像。

- 高分辨率:该模型能够生成高达1024×1024像素的高分辨率图像,细节丰富。

- 零样本学习:这意味着它可以在没有特定训练数据的情况下,通过文本提示生成图像。

- 先进的位置编码和遮罩率作为采样条件:这有助于在生成过程中保持图像细节。

工作原理:

Meissonic使用了一种名为“非自回归遮罩图像建模(MIM)”的技术,它通过并行、迭代细化过程预测所有图像令牌。它结合了多模态和单模态的变换器层,以提高训练效率和性能。此外,它还采用了先进的位置编码策略和优化的采样条件,通过控制噪声和图像令牌的遮罩率来生成图像。

架构创新

- CLIP 文本编码器:Meissonic 使用一个微调的 CLIP 文本编码器,该编码器具有 1024 维的潜在空间,能够高效地将文本转换为潜在表示。

- VQ-VAE 图像编码器和解码器:VQ-VAE 模型使用学习到的码本将原始图像像素转换为离散的语义令牌,从而实现高效的图像表示。

- 多模态变换器主干:多模态变换器主干结合了文本和图像的潜在表示,利用采样参数和旋转位置嵌入进行空间信息编码,提高了模型的表达能力。

- 特征压缩层:特征压缩层用于高效处理高分辨率生成,确保模型在生成高质量图像的同时保持计算效率。

- QK-Norm 层和梯度裁剪:QK-Norm 层用于增强训练稳定性,而梯度裁剪则有助于减少分布式训练期间的 NaN 损失问题。

训练和优化

- 高质量训练数据:Meissonic 使用高质量的训练数据,包括基于人类偏好分数的微条件,以提高图像保真度和分辨率。

- 参数优化:Meissonic 优化到了 10 亿参数,能够在 8GB VRAM 的消费级 GPU 上高效运行,使得推理和微调变得更加方便。

性能评估

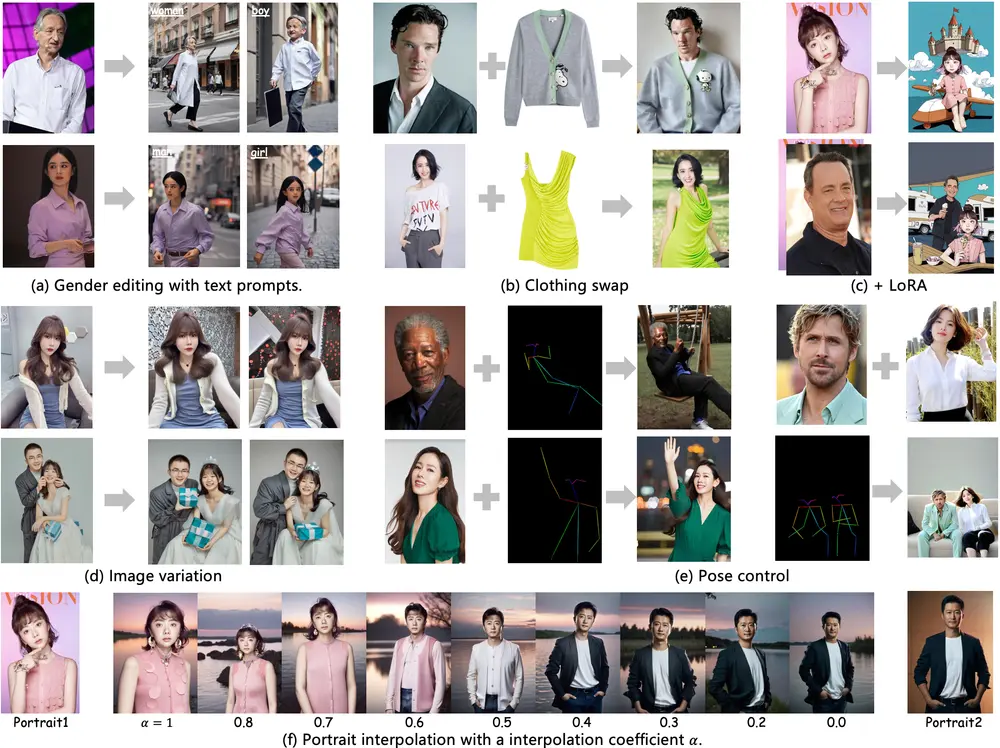

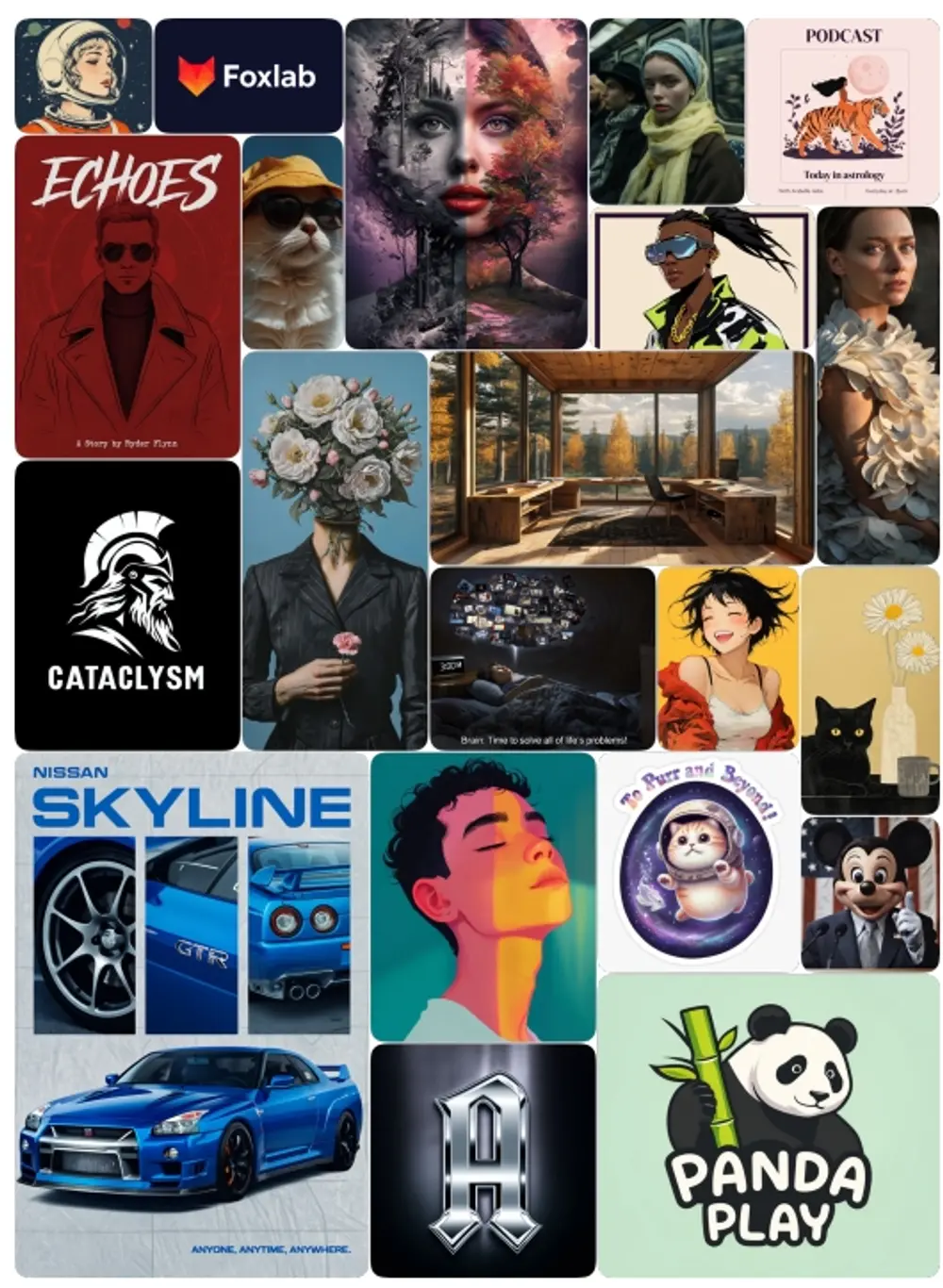

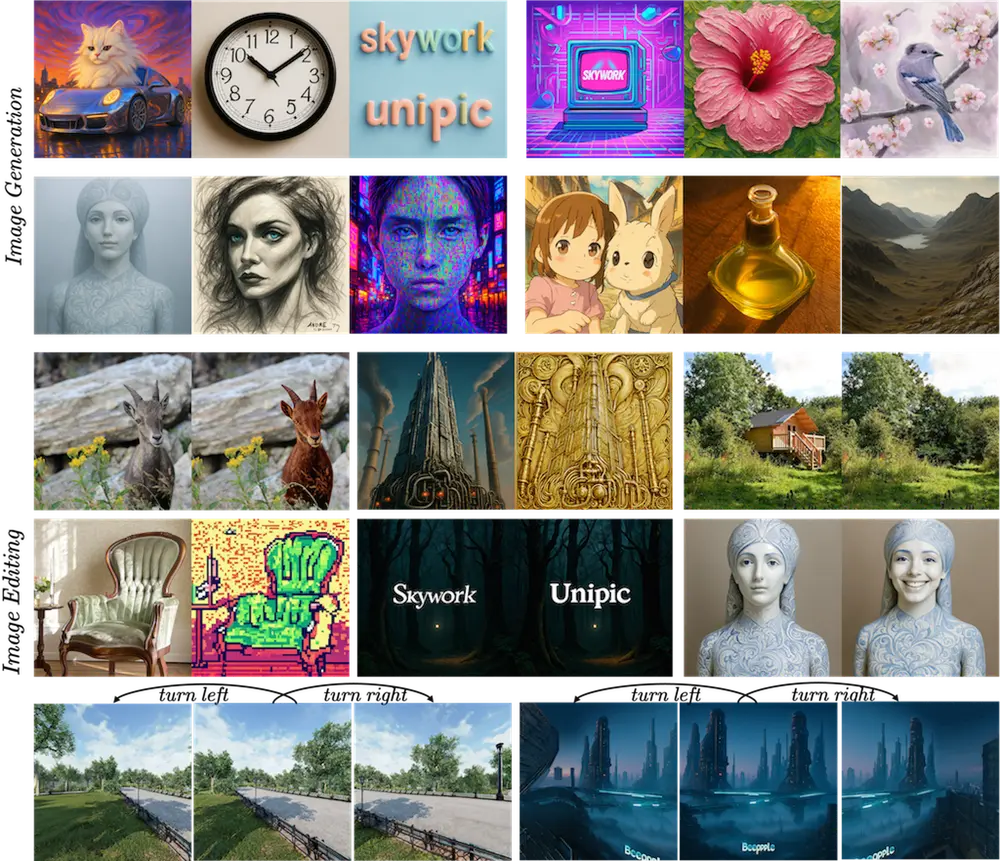

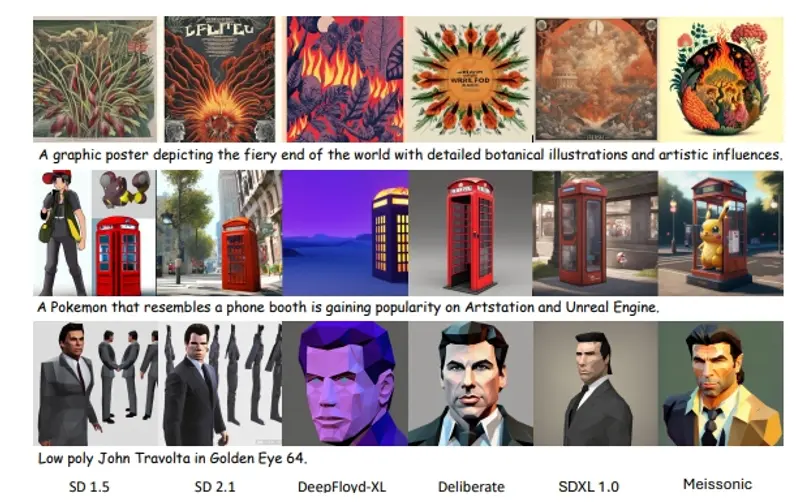

- 定性比较:定性比较显示,Meissonic 在图像质量和文本图像对齐能力方面表现出色。

- 人类评估:使用 K-Sort Arena 和 GPT-4 进行的人类评估表明,Meissonic 在人类偏好和文本对齐方面达到了与 DALL-E 2 和 SDXL 相当的性能。

- 图像编辑任务:在 EMU-Edit 数据集上的基准测试显示,Meissonic 在掩码引导和无掩码编辑方面展示了多功能性,即使在没有特定训练图像编辑数据或指令数据集的情况下也表现优异。

Meissonic 是一种创新的非自回归 MIM 文本到图像合成方法,结合了混合变换器架构、先进的位置编码和自适应掩码率等创新元素。尽管其参数规模仅为 10 亿,Meissonic 在生成高质量、高分辨率图像方面的性能优于更大的扩散模型,同时在消费级 GPU 上保持高效运行。此外,Meissonic 符合移动设备上离线文本到图像应用的最新趋势,为创意工具的使用提供了新的可能性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...