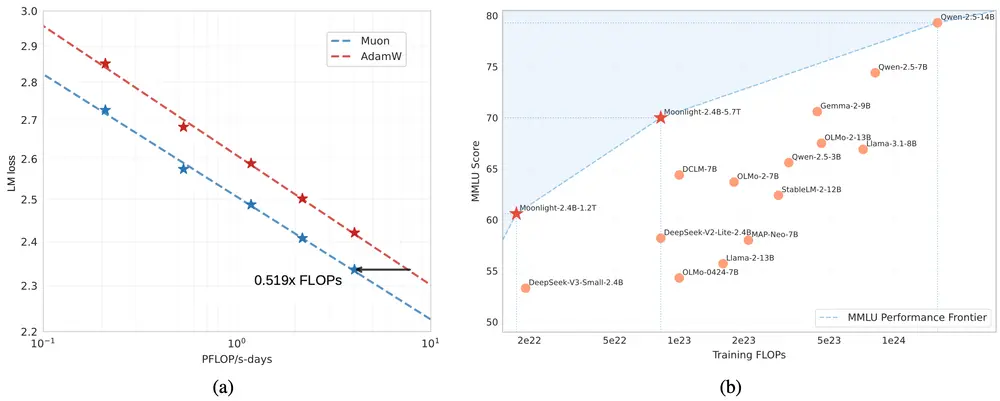

阿里达摩院推出开源多语言大语言模型Babel,旨在解决现有开源多语言模型在语言覆盖上的不足。Babel 支持全球前 25 种使用人数最多的语言,覆盖超过 90% 的全球人口,并特别关注那些被现有模型忽视的低资源语言。通过创新的层扩展(Layer Extension)技术,Babel 提供了两种变体:Babel-9B 和 Babel-83B,分别在高效推理和多语言性能上达到了新的标准。

- 项目主页:https://babel-llm.github.io/babel-llm

- GitHub:https://github.com/babel-llm/babel-llm

- 模型:https://huggingface.co/Tower-Babel

例如,Babel 支持的语言包括英语、中文、印地语、西班牙语、阿拉伯语等,其中印地语和孟加拉语等低资源语言尽管使用人数众多,但往往被现有模型忽视。Babel 通过优化数据清理和训练流程,确保这些语言也能获得高质量的模型支持。

主要功能

- 多语言支持:覆盖全球前 25 种语言,支持超过 90% 的全球人口。

- 高效推理和微调:Babel-9B 设计用于高效的多语言推理和微调,适合研究和本地部署。

- 高性能基准:Babel-83B 是目前领先的开源多语言 LLM,其性能接近商业模型如 GPT-4o。

- 监督微调(SFT):利用开源的监督微调数据集(如 WildChat 和 Everything Instruct Multilingual),Babel 在对话任务中表现出色。

主要特点

- 层扩展技术:通过在模型中添加新层来扩展参数空间,提升模型性能。

- 优化的数据清理流程:针对低资源语言,Babel 采用基于 LLM 的质量分类器来筛选高质量训练数据。

- 平衡高资源和低资源语言:Babel 在高资源语言(如英语、中文)和低资源语言(如印地语、孟加拉语)上均表现出色。

- 开源和可扩展性:Babel 提供了开源的模型和训练代码,便于研究者和开发者进行进一步优化和扩展。

工作原理

- 数据准备:

- 数据收集:从 Wikipedia、新闻数据集(CC-News)、网络语料库(CulturaX)等多源数据中收集训练数据。

- 数据清理:通过规则过滤低质量数据,并使用基于 LLM 的质量分类器筛选高质量数据。

- 去重:通过哈希和图算法去除重复文档。

- 模型扩展:

- 层扩展:在模型的后半部分插入新层,增加参数数量而不破坏原有结构。

- 初始化方法:通过实验选择最优的初始化方法,如复制原始参数并添加少量噪声。

- 模型训练:

- 恢复阶段:使用大规模多语言语料库恢复模型性能。

- 持续训练:增加低资源语言的比例,优化多语言能力。

- 监督微调(SFT):

- 数据集:使用 WildChat 和 Everything Instruct Multilingual 等开源数据集进行微调。

- 训练策略:通过多语言对话数据优化模型的对话能力。

具体应用场景

- 多语言内容生成:

- 为全球用户提供多语言的文本生成服务,支持新闻、教育、娱乐等多种内容创作。

- 例如,Babel 可以生成高质量的多语言新闻报道或教育材料。

- 跨语言翻译:

- 提供高质量的多语言翻译服务,支持从一种语言到另一种语言的准确翻译。

- 例如,Babel 可以将中文内容翻译成西班牙语,或反之。

- 多语言对话系统:

- 为聊天机器人和虚拟助手提供多语言支持,提升用户体验。

- 例如,Babel 可以用于开发支持多种语言的客服聊天机器人。

- 学术研究:

- 为研究者提供开源的多语言模型,支持跨语言的自然语言处理研究。

- 例如,研究者可以利用 Babel 探索多语言模型的性能优化和应用。

- 企业国际化:

- 帮助企业开发多语言产品和服务,支持全球化业务。

- 例如,Babel 可以用于开发多语言的客户服务系统或内容管理系统。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...