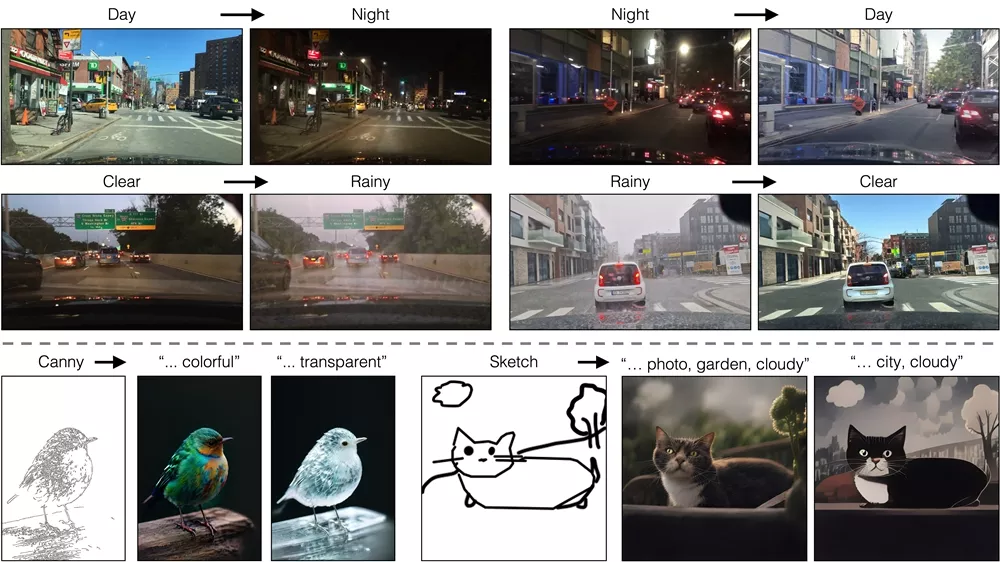

来自卡内基梅隆大学和Adobe的研究人员推出新的图像转换方法img2img-turbo,它能够在单个步骤中将图像从源域转换到目标域,例如从白天的场景转换到夜晚,或者添加和移除天气效果如雾、雪和雨。这种方法基于单步扩散模型(如SD-Turbo),通过对抗性学习目标进行适应,可以在没有成对数据的情况下进行训练。

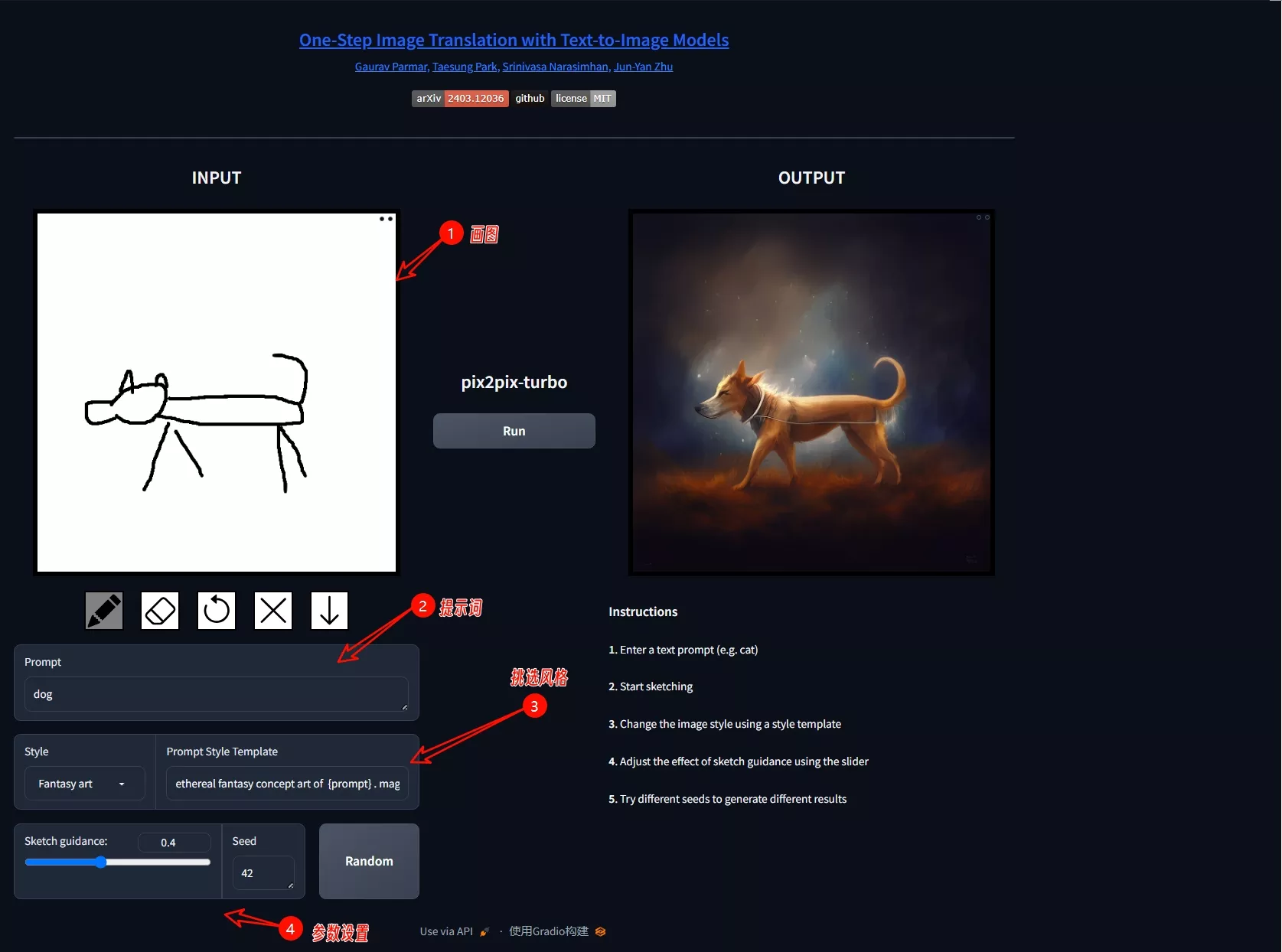

研究团队推出的一步条件模型CycleGAN-Turbo和pix2pix-turbo能够执行各种图像到图像的转换任务,适用于非配对和配对设置。CycleGAN-Turbo在性能上优于现有的基于GAN和扩散的方法,而pix2pix-turbo则与近期的作品(如用于Sketch2Photo和Edge2Image的ControlNet)相当,但仅需一步推理。

主要功能:

- 单步图像翻译: 与传统的迭代去噪过程不同,这种模型能够在一个步骤中完成图像的转换,大大提高了推理速度。

- 无需成对数据: 该方法可以在没有成对图像数据的情况下进行训练,这降低了模型训练的成本和复杂性。

主要特点:

- CycleGAN-Turbo和pix2pix-Turbo: 这两种模型分别用于非成对和成对的图像翻译任务,它们都能够在保持输入图像结构的同时生成视觉上吸引人的输出。

- 高效率: 论文中提到的模型能够在0.3秒内完成512x512图像的转换,显示出高效的推理能力。

工作原理:

- 适应性训练: 通过对抗性学习目标,模型能够适应新的控制条件和领域,同时保留预训练模型的内部知识。

- 生成器架构: 论文提出了一个新的生成器架构,它整合了编码器、UNet和解码器,并通过LoRA适配器进行微调,以减少过拟合和微调时间。

- 细节保留: 为了保留输入图像的高频细节,模型在编码器和解码器之间加入了跳跃连接(skip connections)。

这项工作提出了一种高效且灵活的图像转换方法,它能够在单个步骤中完成复杂的图像转换任务,同时不需要成对的训练数据,适用于多种应用场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...