ComfyUI-DyPE 是一个轻量级自定义节点,实现了 DyPE(Dynamic Position Extrapolation)技术,使预训练的扩散 Transformer(如 FLUX、Nunchaku、Qwen Image、Z-Image)能够直接生成 4096×4096 甚至更高分辨率的图像,且无需微调、不增加推理成本。

- GitHub:https://github.com/wildminder/ComfyUI-DyPE

- 网盘下载:https://pan.quark.cn/s/ef0021c717a2 提取码:BcTn

DyPE 的核心思想是:利用扩散过程天然的“从低频到高频”生成特性,动态调整位置编码。早期步骤聚焦全局结构(低频),后期步骤细化纹理细节(高频),从而避免传统外推方法常见的重复图案、结构崩塌或模糊问题。

核心原理:动态适配频谱演进,突破分辨率瓶颈

传统扩散模型在生成超出训练分辨率的图像时,常因位置编码不匹配导致细节错乱、结构崩塌。ComfyUI-DyPE 采用免训练的 DyPE 技术,从根源上解决这一问题:

- 利用扩散过程的频谱演进特性,在每个采样步骤动态调整模型的位置编码;

- 早期采样阶段聚焦低频结构(如物体轮廓、场景布局),后期阶段专注高频细节(如纹理、边缘),使编码频谱与生成阶段精准匹配;

- 无需修改模型权重,仅通过实时调整位置嵌入,即可让模型稳定生成超原生分辨率图像,且零推理开销,对生成速度几乎无影响。

二、核心特性:多模型兼容+轻量化集成,兼顾灵活与高效

1. 广泛适配主流模型架构

支持 FLUX(标准版)、Nunchaku(量化版 FLUX)、Qwen Image、Z-Image(Lumina 2)等主流扩散变换器模型,无需针对不同模型单独配置,兼容性极强。

2. 超分能力与易用性平衡

- 最高支持 4096x4096 及以上分辨率生成,远超多数模型的原生训练分辨率(如 FLUX 原生 1024x1024);

- 单节点集成设计:仅需在模型加载器后添加“DyPE for FLUX”节点,无需重构现有工作流,新手也能快速上手;

- 完全兼容现有工具链:与 ComfyUI 内置的采样器、调度器及其他优化节点无缝协作,不影响原有创作流程。

3. 细粒度参数控制,适配不同场景

提供多维度可调参数,支持用户根据目标分辨率、图像类型优化生成效果:

- 模型类型自动检测/手动指定,适配不同架构特性;

- 4 种位置编码方法可选(vision_yarn/yaRN/ntk/base),兼顾长宽比鲁棒性、通用性能与细节锐度;

- 动态组件开关、强度缩放、指数调节等参数,可针对 2K-3K、4K+ 等不同分辨率场景精准优化。

快速上手:两步安装+简单配置,即刻启用超分

1. 安装方式(二选一)

方式一:ComfyUI Manager 安装(推荐)

打开 ComfyUI → 启动 ComfyUI Manager → 搜索“ComfyUI-DyPE” → 点击“安装”,重启 ComfyUI 即可生效。

方式二:手动安装

- 进入 ComfyUI 安装目录下的

custom_nodes/文件夹; - 执行克隆命令:

git clone https://github.com/wildminder/ComfyUI-DyPE.git - 启动或重启 ComfyUI,无需额外安装依赖。

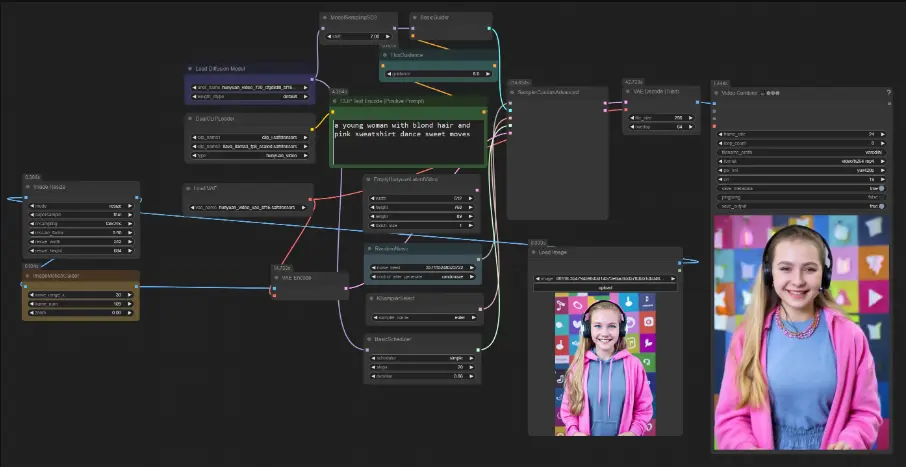

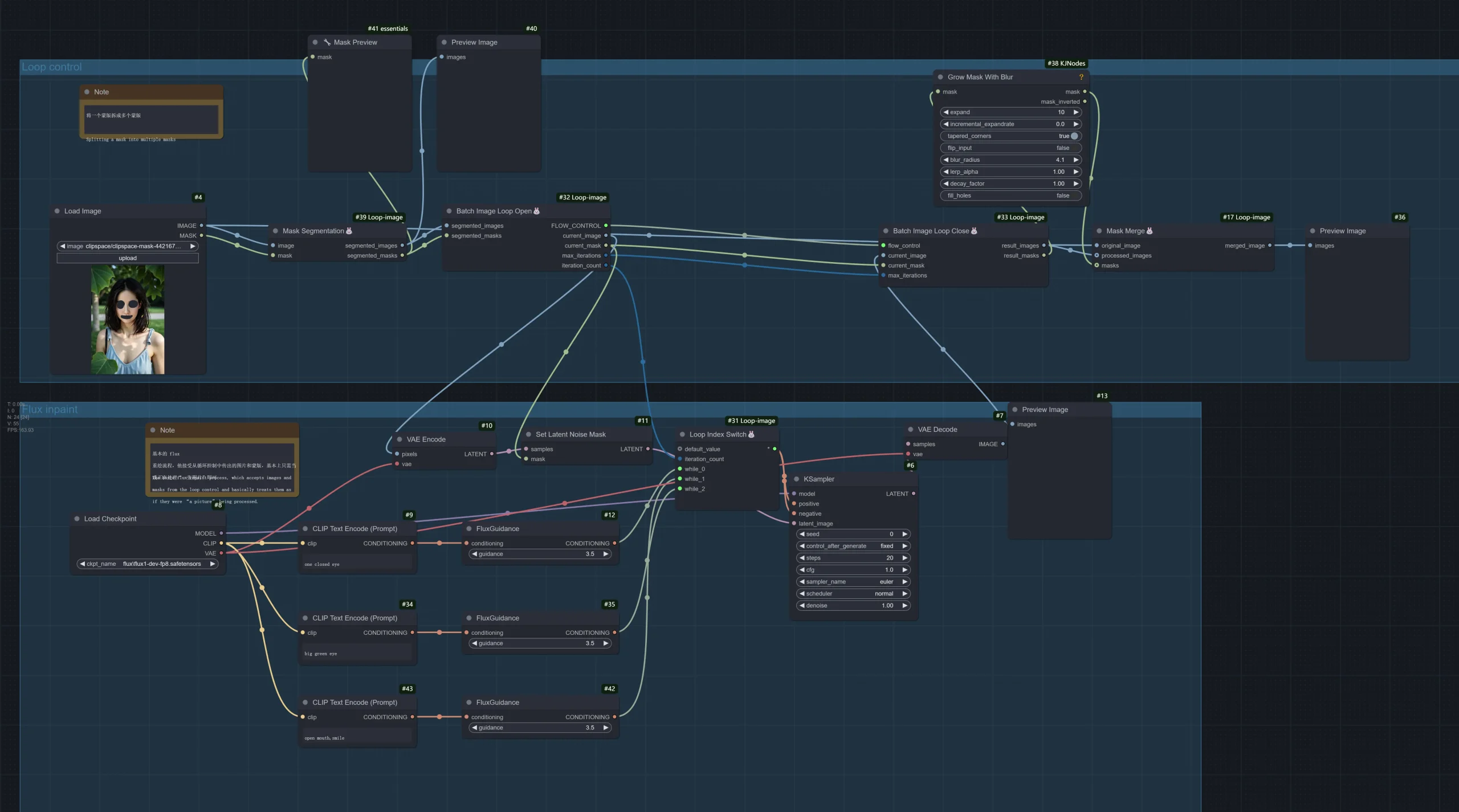

2. 使用流程(6步搞定)

- 用常规加载器加载目标模型(如 FLUX、Qwen Image);

- 在工作流中添加“DyPE for FLUX”节点;

- 将模型加载器的

MODEL输出连接到 DyPE 节点的model输入; - 在 DyPE 节点中设置

width和height,与“空潜在图像”的分辨率保持一致; - 将 DyPE 节点的

MODEL输出连接到 KSampler 的模型输入; - 保持其他参数不变,直接生成即可启用超分功能。

注意:该节点仅修改扩散模型(UNet)的位置嵌入,不影响 CLIP 编码器或 VAE 模型,无需额外调整相关配置。

参数配置指南:按需优化,平衡分辨率与画质

1. 基础配置(必选)

- model_type:默认选择

auto自动检测模型,若识别失败可手动指定(如 FLUX 选flux,Qwen 选qwen); - base_resolution:填写模型原生训练分辨率(FLUX/Z-Image 填 1024,Qwen 填 1328);

- width/height:与空潜在图像分辨率一致(如生成 4K 图像则填 4096x4096)。

2. 进阶优化(可选)

- method:优先尝试

vision_yarn(长宽比鲁棒性强,结构与纹理解耦),极端长宽比场景可切换yaRN;追求稳定性可选ntk; - dype_exponent:2K-3K 分辨率填 1.0,4K+ 填 2.0,略高于原生分辨率填 0.5;

- enable_dype:默认启用(完整 DyPE 算法),若出现细节过度锐化可尝试关闭。

最佳实践与注意事项

- 极端分辨率限制:尽管 DyPE 大幅提升超分能力,但 4096x4096 等极端分辨率仍可能出现轻微伪影(毕竟模型原生训练仅百万像素级,需生成千万像素级图像),可通过后期轻微降噪优化;

- 参数实验建议:不同提示词、模型架构的适配参数存在差异,建议先固定其他参数,仅调整

method和dype_exponent,快速找到最优配置; - 适用场景:适合壁纸创作、印刷素材制作、高清插画生成等需要高分辨率输出的场景,尤其适配对细节连贯性要求高的作品。

ComfyUI-DyPE 以“免训练、轻量化、高兼容”的优势,为扩散模型用户提供了低成本的超分解决方案,无需专业技术即可突破分辨率瓶颈。无论是新手创作者还是资深开发者,都能通过简单配置获得高质量的 4K+ 图像生成能力,进一步拓展 AI 绘画的应用场景。

相关文章