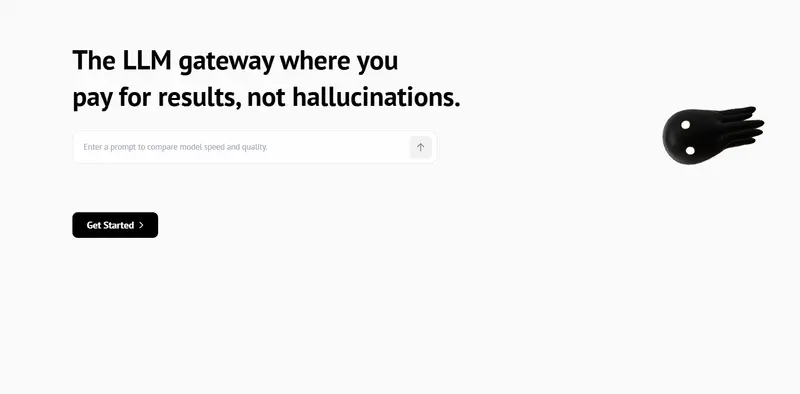

在AI应用快速落地的今天,企业正面临一个现实困境:模型选择多,但管理复杂;性能波动大,输出不稳定;幻觉难以控制,责任归属模糊。

为解决这些问题,新加坡团队 AI FORCE SINGAPORE PTE. LTD. 推出 ZenMux——全球首个融合统一接入、智能路由与模型保险机制的企业级大语言模型(LLM)聚合平台。

ZenMux 目前已开启封闭测试,邀请开发者提前体验“一个API调用所有主流模型”的极简开发模式。

为什么需要ZenMux?

当前企业在集成AI时普遍遇到三大挑战:

- 多模型兼容成本高:每接入一个新模型(如GPT、Claude、Gemini),都需要单独适配接口、认证和计费系统;

- 性能与稳定性不可控:单模型可能延迟、限流或返回低质量结果;

- 缺乏风险兜底机制:当AI产生错误、误导性内容(即“幻觉”)时,缺乏可衡量的责任保障。

ZenMux 的目标不是简单地做一个“模型中转站”,而是构建一套可信赖的AI基础设施层,让企业可以安心将AI深度嵌入核心业务流程。

核心能力:统一、智能、可靠

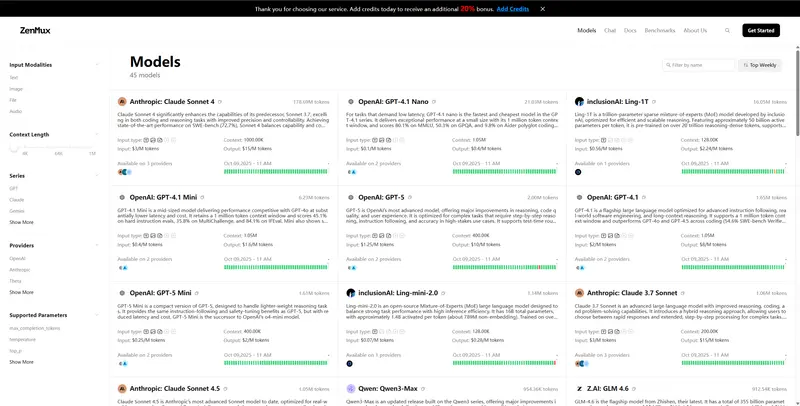

✅ 统一访问:一套代码,对接全球主流模型

ZenMux 提供标准化 API 接口,完全兼容 OpenAI API 协议,支持一键切换以下模型提供商:

- OpenAI(GPT-4, GPT-3.5)

- Anthropic(Claude 系列)

- Google(Gemini)

- DeepSeek

- 更多模型持续接入中

开发者只需编写一次调用逻辑,即可自由调配不同模型资源。

关键优势:

- 单一API端点:无需为每个模型维护独立客户端;

- 统一认证:一个API密钥管理所有服务商权限;

- 集中计费:透明展示各模型使用量与成本分布,便于预算控制。

🔧 智能服务:即将上线的核心功能

ZenMux 不仅是聚合,更是优化。

我们正在推出一系列智能调度能力,确保请求始终获得最优响应。

| 功能 | 说明 |

|---|---|

| 智能路由(即将上线) | 基于任务类型(问答、摘要、代码生成等)、历史表现、延迟和成本,自动选择最合适的模型 |

| 自动故障转移 | 当主模型超时或报错时,无缝切换至备选模型,保障服务连续性 |

| 缓存与负载均衡 | 减少重复计算,提升响应速度,降低整体调用成本 |

这些功能将帮助企业在不增加开发负担的前提下,实现更高性能与更强韧性。

🛡️ 质量保障:行业首创的“模型保险”机制(规划中)

ZenMux 正在构建业内首个面向企业的 AI输出质量保障体系,包含:

- 多模型验证:对关键请求并行调用多个模型,交叉比对结果一致性;

- 实时质量监控:跟踪输出连贯性、事实准确性和格式合规性;

- 模型保险(即将推出):针对特定场景(如金融报告生成、客服应答),提供基于规则的质量承诺,若未达标可触发补偿机制。

这一机制旨在为企业用户提供真正的“兜底”能力,缓解因AI错误导致的运营风险。

名称背后的理念:Zen + Mux

ZenMux 是两个词的融合:

Zen(禅) —— 代表极简与专注

我们相信,最好的技术应该隐藏复杂性。通过自动化编排、统一接口和风险保障,我们将多模型管理简化为:“一个API、一个SDK、一个平台”。

Mux(多路复用器) —— 代表聚合与智能选择

如同网络中的数据分流器,ZenMux 动态路由请求到最适合的模型路径,在性能、成本与准确性之间取得最佳平衡。

产品理念:以禅意心态,驾驭AI之力——千模型合一,简约铸就卓越。

数据统计

相关导航

超算互联网平台

Claude Relay Service

Ngrok.ai

Claw Cloud Run

Google AI Studio

七牛AI 大模型推理

DeepGemini