人们常说:“AI 发展受限于 GPU 短缺。”但事实可能恰恰相反:真正的瓶颈不是算力不足,而是算力浪费严重。

在世界各地的数据中心,大量 GPU 时间以碎片形式悄然流逝——这里几分钟,那里几小时。这些零散的计算窗口转瞬即逝,一旦错过就永远无法回收。就像无法储存的电力、会腐烂的农产品,计算能力也有“保质期”。

我们称之为:易逝算力(ephemeral compute)。

而 Inference.net 正是为此而生——它们构建了一个面向易逝算力的实时市场,让原本将被浪费的 GPU 资源,在到期前被高效利用。

Inference怎么做?

Inference开发了定制化的调度与编排系统,能够聚合跨数据中心的微小空闲时段,形成连续可用的推理资源池。通过这种技术,我们可以:

- 聚合碎片化时间,运行完整的 AI 推理任务;

- 作为这些闲置容量的“最后买家”,获得大幅折扣;

- 将节省的成本 100% 传递给开发者。

结果是什么?

你用更低的价格,获得高性能、低延迟的模型服务;

让本该浪费的算力,转化为真正的智能输出。

为什么这件事重要?

因为 Inference.net 不只是一个推理平台,而是一个市场机制。

Inference相信:

AI 推理的效率市场,将是未来十年推动人工智能普及的核心引擎。

就像电力市场优化能源分配一样,Inference将能源转化为智能的过程变得透明、高效、可扩展。这不仅关乎成本,更关乎谁能在正确的时间,以正确的成本,使用正确的算力。

Inference的目标很明确:加速人类将能源转化为智能的进程,为地球乃至更远的地方创造前所未有的繁荣。

欢迎使用 Inference.net

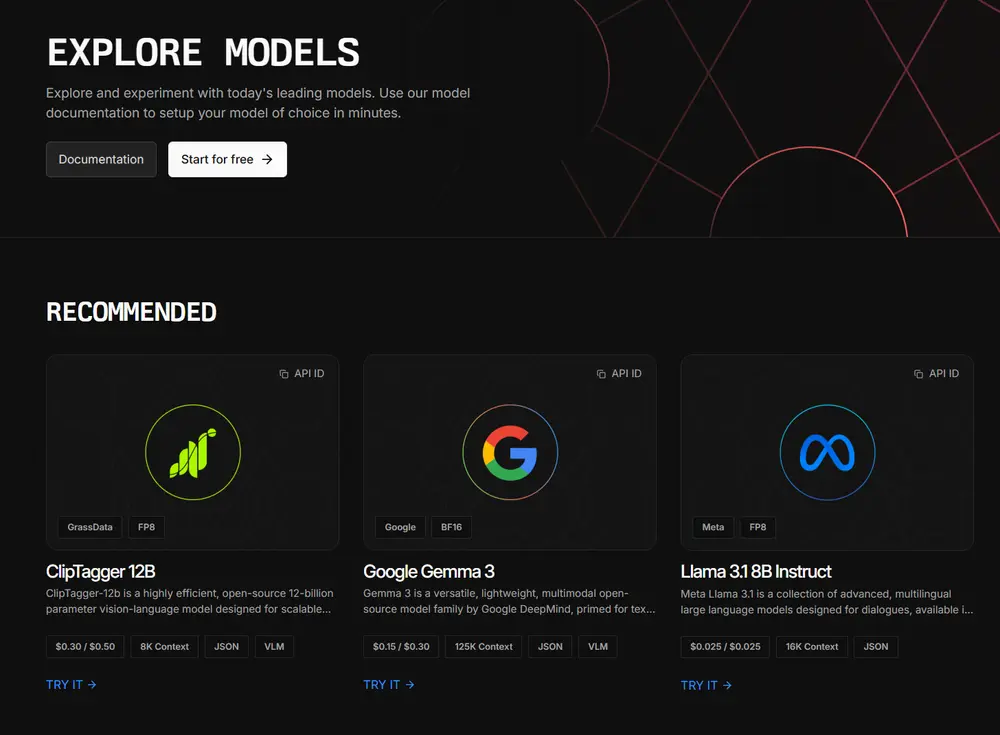

Inference.net 是一个为开源 AI 模型打造的原生推理平台。开发者只需几行代码,即可访问全球领先的开源模型,并按实际使用量付费。

Inference致力于成为构建 AI 应用的最佳起点。

当前支持能力

- 无服务器 LLM 推理:通过 API 调用主流开源语言模型,如 Llama-3.1-8B,仅为你使用的 token 付费。

- LoRA 推理(早期访问):上传你的 LoRA 适配器,通过流式或批量端点进行推理,实现个性化模型部署。

- 图像生成(早期访问):使用 FLUX[DEV]、Stable Diffusion 等先进模型生成图像,按生成次数计费。

所有服务均基于Inference自研的分布式基础设施,具备高可用、低延迟、自动扩缩容等企业级能力。

回到起点:AI 革命是如何展开的?

2022 年 11 月 30 日,OpenAI 发布了 ChatGPT。那一刻,计算机仿佛突然“听懂”了人类的语言。一场技术浪潮就此掀起。

开发者开始设想由自然语言驱动的未来,风险资本涌入 AI 领域,NVIDIA 市值翻倍,旧金山街头挤满了讨论“下一个 AI 应用”的工程师。

2023 年 3 月,GPT-4 发布,闭源模型似乎遥不可及。但很快,变化发生了。

开源的力量:差距正在缩小

虽然 OpenAI 和 Anthropic 等闭源实验室一度领先,但技术壁垒并未持续太久。

Meta 发布 Llama 系列模型,开源社区迅速跟进。在短短几个月内,开源模型在多个任务上达到甚至超越闭源对手的表现。

更重要的是,它们带来了三项关键优势:

- 成本更低:无需支付高昂的 API 费用;

- 透明可控:可审计、可定制、可本地部署;

- 迭代更快:社区驱动,版本更新频繁。

这意味着:AI 的控制权正从少数巨头手中,流向每一位开发者。

Inference.net 的使命:让开源 AI 触手可及

正是在这一背景下,Inference.net 应运而生。

Inference不是一个简单的模型托管平台,而是一个连接全球闲置算力与开源模型需求的网络。

Inference的基础设施设计原则是:

| 特性 | 说明 |

|---|---|

| 🚀 即时访问 | 开箱即用,无需预置资源 |

| 💰 成本极低 | 相比主流云厂商,价格低数倍 |

| 🌍 全球低延迟 | 分布式节点,就近接入 |

| 🔌 开发者友好 | 简洁 API,支持流式响应 |

| 📊 透明计费 | 按 token 或图像生成计费,无隐藏费用 |

| 🔄 自动更新 | 新模型上线即自动可用 |

Inference处理从负载均衡到故障转移的一切底层复杂性,让你专注于构建真正有价值的产品。

为什么现在是关键时刻?

我们正处于一个转折点:

- 闭源模型的技术领先正在消失;

- 开源模型在质量、速度、定制化上全面追赶;

- 更多创新将来自“小团队 + 开源工具”的组合。

Inference.net 的角色,就是为这些创新者提供高性能、低成本、可信赖的推理底座。

就像云计算让服务器资源民主化一样,Inference希望让 AI 推理资源变得普惠。

数据统计

相关导航

Claw Cloud Run

AI21 Studio

Claude Relay Service

DeepSeek API

APIS

UniAPI

Inworld TTS