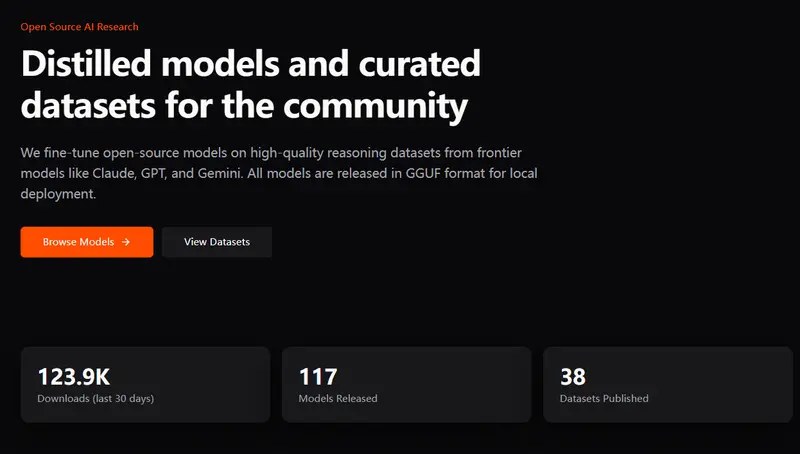

在 API 调用成本高企、闭源模型访问受限的今天,一个由两名大学生自掏腰包组建的小团队——TeichAI——正在用开源的方式,把前沿大模型的“思考方式”带入你的笔记本电脑。

他们的方法很直接:向 Claude Opus、GPT-5、Gemini Pro 等顶级模型提问,收集它们的高质量推理过程(而不仅是最终答案),然后用这些数据去微调开源小模型。最终产出的模型体积小巧、可完全本地运行,却保留了原始模型的逻辑风格与解题能力。

所有成果均以 GGUF 格式开源发布,支持在普通消费级设备上通过 llama.cpp 高效运行。

为什么需要蒸馏?因为“思考过程”比答案更重要

大多数开源模型只能模仿闭源模型的输出,但 TeichAI 关注的是推理轨迹(reasoning traces)——即模型如何一步步推导出结论。

例如,在解决一道数学题时,他们不仅记录“答案是 42”,还保留完整的中间步骤、假设验证和错误修正过程。

这种数据训练出的模型,不仅能给出正确结果,还能像人类一样展示思路,这对教育、代码生成、科学计算等场景至关重要。

技术流程:从提示到本地可运行模型

- 构建高质量推理数据集

团队设计涵盖编程、数学、物理、化学等领域的多样化提示,以高温度(high temperature)和多步推理模式向 Claude、GPT、Gemini 提交查询,捕获丰富、非模板化的响应。 - 高效微调开源基础模型

使用 Unsloth 框架进行 LoRA 微调,显著降低显存占用与训练时间,在有限资源下实现高性能优化。 - 量化与本地部署

所有模型导出为 GGUF 格式,提供 Q4_K_M、Q5_K_S 等多种量化级别,可在 8GB 内存的笔记本上流畅运行。

💡 示例:一个 7B 参数的蒸馏模型,在代码生成任务上接近 GPT-4 的逻辑清晰度,但完全离线、零 API 成本。

开源使命:让强大推理能力回归社区

TeichAI 的核心信念是:顶尖 AI 的推理能力不应被锁在 API 背后。

虽然 Anthropic、OpenAI 和 Google 的模型功能强大,但其使用门槛(费用、网络依赖、隐私风险)让许多个人开发者、学生和小型团队望而却步。

通过开源数据集与模型,TeichAI 希望:

- ✅ 降低高质量推理模型的使用门槛

- ✅ 推动本地 AI 在教育、科研、个人项目中的应用

- ✅ 为社区提供可复现、可审计的蒸馏范例

目前,所有数据集、训练脚本和 GGUF 模型均已公开,欢迎任何人下载、评估或二次开发。

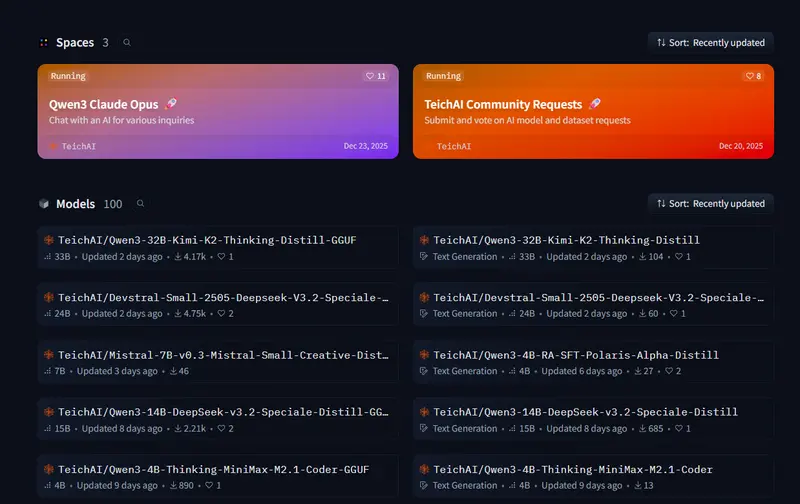

如何获取?

- 模型下载:Hugging Face 上搜索

TeichAI - 格式支持:GGUF,兼容

llama.cpp、LM Studio、Ollama等主流本地推理框架 - 硬件要求:最低 6GB RAM(Q4 量化),推荐 8GB+ 以获得流畅体验

数据统计

相关导航

Nous Research

TTSFM

Inference.net

Fal.ai

Any Gateway

ClawRouter

AUI