来自康奈尔大学的研究团队推出RLCM(Reinforcement Learning for Consistency Models, 一致性模型的强化学习),RLCM提供了一种有效的方法来提升图像生成的速度和质量,同时保持了生成过程的灵活性和适应性。

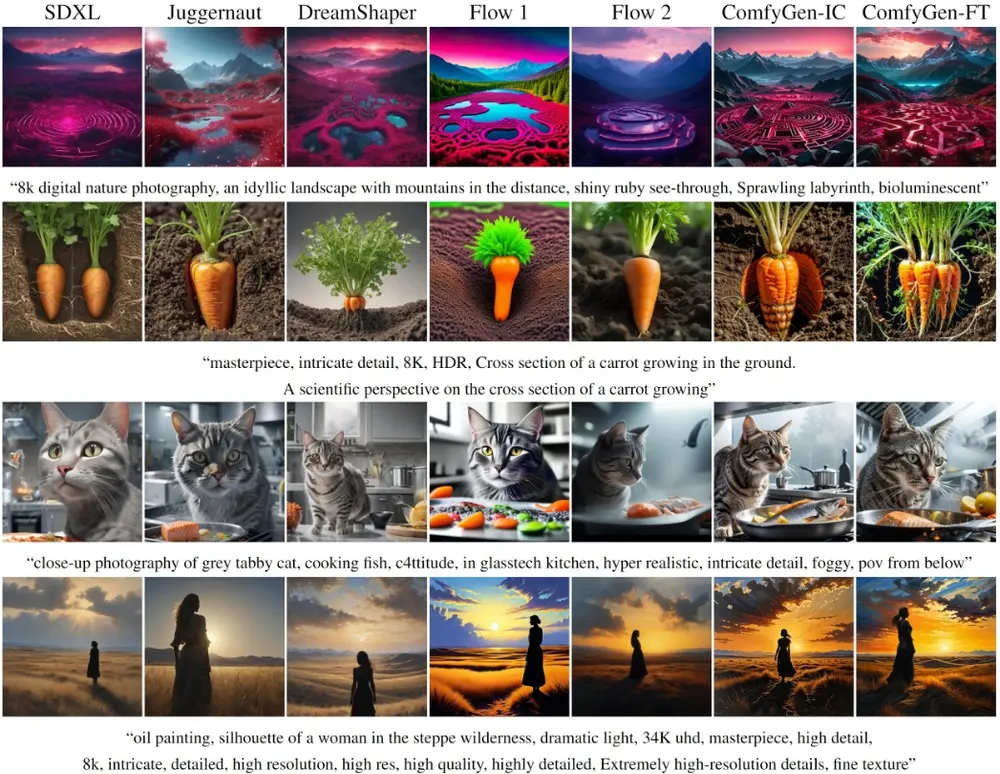

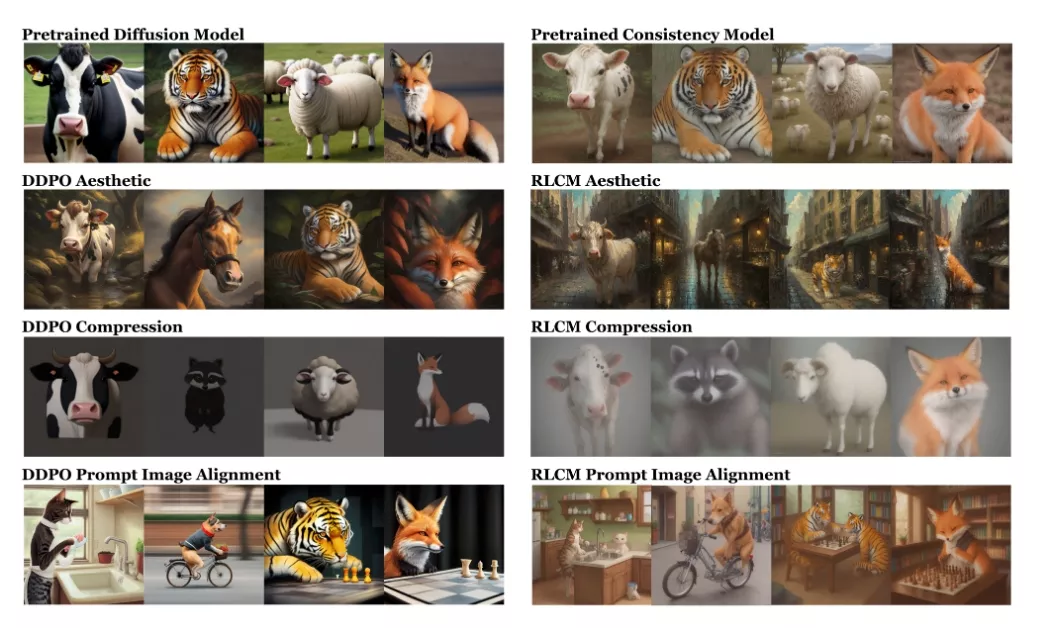

实验结果表明,RLCM能够有效地调整文本到图像的一致性模型,以适应那些难以通过简单提示表达的目标,如图像压缩性,以及那些基于人类反馈的目标,如美学质量。与经过强化学习微调的扩散模型相比,RLCM的训练速度显著提升,生成质量在奖励目标的衡量下也得以改善,并且由于它能在仅两步推理内生成高质量图像,因此也大大加快了推理过程。

例如,你想要创建一幅描述“一只穿着太空服的猫”的图片,通常的图像生成模型可能需要多次尝试和调整才能生成满意的图像。而RLCM方法能够让这个过程变得更快、更准确。

主要功能:

RLCM的主要功能是通过强化学习来优化图像生成模型,使其能够更快地生成高质量、符合特定要求的图像。这就像是给艺术家一个明确的指导,让他们更快地画出你想要的画作。

主要特点:

- 快速生成:RLCM能够通过减少生成图像所需的步骤来加快图像创建的速度。

- 奖励引导:通过奖励机制,模型能够学习生成更符合特定审美或实用性要求的图像。

- 灵活性:RLCM可以适应各种不同的奖励函数,这意味着它可以根据不同的任务需求进行定制。

工作原理:

RLCM将图像生成过程视为一系列的决策步骤,每一步都会根据当前状态(图像的中间表示)来选择最佳的行动(生成图像的下一步)。这个过程通过强化学习算法进行优化,其中模型会根据生成的图像质量获得奖励。随着时间的推移,模型学会了选择那些能够最大化奖励的行动,从而生成更好的图像。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...