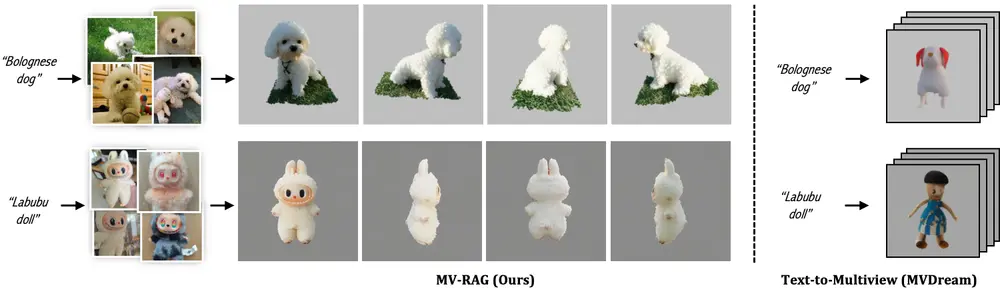

近年来,基于预训练2D扩散模型的文本到3D生成方法取得了显著进展。这类方法通过“蒸馏”2D先验知识,能够生成视觉质量高、多视角一致的3D内容。然而,当面对罕见或未见过的概念(如“博洛尼亚犬”或“Labubu手办”)时,现有模型往往表现不佳——生成结果容易出现结构错乱、语义偏差或视角不一致的问题。

- 项目主页:https://yosefdayani.github.io/MV-RAG

- GitHub:https://github.com/yosefdayani/MV-RAG

- 模型:https://huggingface.co/yosepyossi/mvrag

为解决这一挑战,耶路撒冷希伯来大学的研究团队提出 MV-RAG(Retrieval-Augmented Multiview Diffusion),一种全新的文本到3D生成框架。它不再仅依赖模型内部记忆,而是引入外部视觉知识,通过检索相关2D图像并以此引导生成过程,显著提升了对域外(OOD)概念的建模能力。

问题核心:模型“没见过”的东西,怎么生成?

当前主流文本到3D方法(如 MVDream)依赖于在大规模图文对上训练的2D扩散先验。这些先验虽强,但本质上是封闭的——它们只能复现已知分布内的模式。

当输入提示包含训练数据中稀少或缺失的概念时,模型只能“凭空猜测”,导致:

- 视角之间不一致(比如正面是狗,侧面变成猫)

- 结构失真(四肢错位、比例失调)

- 文本理解偏差(无法准确还原描述细节)

MV-RAG 的思路很直接:如果你没见过这个东西,那就先去“查资料”。

MV-RAG 是如何工作的?

MV-RAG 的核心思想是:将文本提示与从真实世界检索到的相关2D图像结合,共同作为生成条件。整个流程分为五个关键步骤:

1. 文本提示 → 检索相关2D图像

给定一个文本描述(如“a cute Labubu doll wearing a pirate hat”),系统首先在大规模2D图像数据库中检索语义相关的参考图像。这些图像提供了真实世界的视觉先验。

2. 图像编码 → 提取紧凑视觉令牌

检索到的图像通过预训练图像编码器(如 CLIP ViT)提取特征,并经由一个可学习的 Resampler 模块压缩为少量视觉令牌(visual tokens),便于后续融合。

3. 多视图扩散模型 → 生成一致视角

模型基于 MVDream 架构构建,采用多视图扩散结构。其核心机制包括:

- 3D自注意力层:强制不同视角间的几何一致性

- 解耦交叉注意力:分别处理文本条件和图像条件信号

4. 自适应融合 → 动态平衡先验与检索

这是 MV-RAG 的关键创新之一:先导注意力机制(Pilot Attention)。

该模块会评估当前提示是否“熟悉”。如果是常见类别(如“椅子”),则更多依赖模型自身先验;如果是罕见概念(如“机械水母”),则自动增强检索图像的影响权重。

简单说:模型先“想一下自己知道什么”,再“看看网上搜到的图”,然后决定听谁的。

5. 混合训练策略 → 同时学习2D与3D规律

为了使模型既能理解3D结构,又能从非结构化2D图像中推断空间关系,MV-RAG 采用双模式交替训练:

| 训练模式 | 数据来源 | 目标 |

|---|---|---|

| 3D 模式 | 合成3D数据集(多视角渲染) | 从增强视图重建目标视图,学习几何一致性 |

| 2D 模式 | 真实世界图像集合(无配对视角) | 给定K张检索图,预测第K+1张保留视图,模拟检索增强推理场景 |

这种设计让模型学会从零散的2D图像中“脑补”出合理的3D结构。

为什么 MV-RAG 更擅长处理罕见概念?

传统方法在OOD任务上失败,本质上是因为它们缺乏“查证”能力。而 MV-RAG 的优势在于:

- ✅ 外部知识接入:通过检索引入真实图像,弥补模型知识盲区

- ✅ 动态调节机制:不盲目依赖检索,也不固守先验,而是按需融合

- ✅ 真实数据泛化:2D训练模式使其能从互联网级图像中学习多样化表达

这使得它在生成“小众宠物”“潮流玩具”“虚构生物”等复杂对象时,表现出更强的准确性和稳定性。

新基准:OOD-Eval —— 更严苛的测试环境

为了客观评估模型在罕见概念上的表现,研究团队构建了 OOD-Eval 基准,包含:

- 196 个挑战性文本提示

- 聚焦于低频、细粒度或新兴概念(如“Hokkaido dog”、“Blind Box toy”)

- 覆盖动物、玩具、服饰、艺术风格等多个类别

该基准填补了现有评测在域外泛化能力评估上的空白。

实验结果:全面领先

在 OOD-Eval 和标准基准上的测试表明,MV-RAG 在多个维度上优于当前主流方法:

定量表现(4-view setting)

| 指标 | MV-RAG 表现 |

|---|---|

| CLIP Score(文本对齐) | 显著优于所有基线 |

| DINO Score(特征一致性) | 最高 |

| FID(图像质量) | 最优 |

| IR(创新性) | 略低于 MV-Adapter(IM) |

| IS(多样性) | 略低于 Era3D |

注:在真实感与一致性优先的任务中,FID 和 DINO 更具参考价值。

用户研究

人工评分显示,MV-RAG 在以下三项上平均得分最高:

- 真实感(Realism)

- 文本遵循度(Text Alignment)

- 3D一致性(View Consistency)

显著优于 MVDream、ImageDream 等基线模型。

定性对比

在生成“Bolognese dog”、“Plushie octopus”等对象时,基线模型常出现形态扭曲或视角跳跃,而 MV-RAG 能稳定输出结构合理、风格统一的多视图结果。

相关文章