美团LongCat 团队正式推出 LongCat-Flash-Thinking-2601 —— 一款总参数量达 5600 亿、激活参数仅 270 亿 的高效混合专家(MoE)大模型。该模型专为现实世界智能体任务设计,在工具调用、搜索推理、编程等场景中全面领先,并首次引入 “深度思考模式”,显著提升复杂问题的解决能力。

与单纯追求规模不同,LongCat-Flash-Thinking 的核心突破在于系统性训练架构:通过多环境强化学习、抗噪课程训练和任务合成机制,使模型在不完美、高噪声的真实环境中仍能稳健运行。

三大核心技术亮点

1. 多环境强化学习 + 高质量任务合成

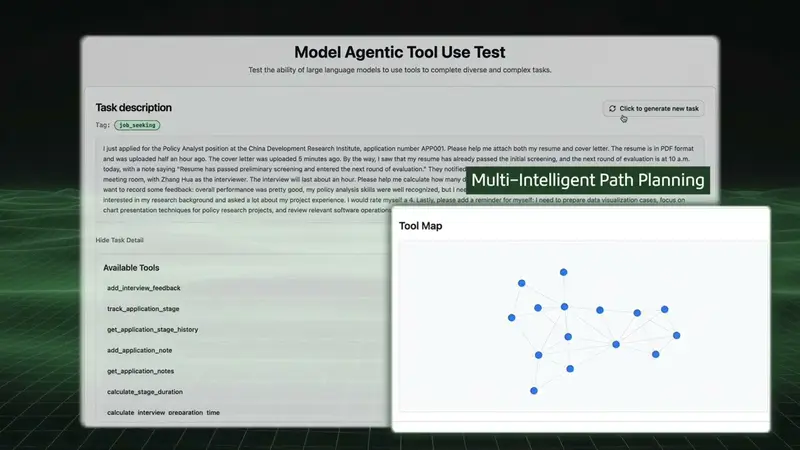

团队构建了多个高复杂度训练环境,每个包含 60+ 工具,并通过依赖图组织成密集交互网络。在此基础上:

- 任务自动生成:从环境子图中采样连通组件,确保任务可执行且具备多工具协同特性

- 多样性控制:动态降低已用工具的采样概率,避免重复

- 多环境联合训练:不同环境的任务按复杂度均衡混合,推演预算动态分配

结果表明,随着训练环境数量增加,模型在域外评估中的表现持续提升,验证了其泛化能力的可扩展性。

2. 抗噪鲁棒训练:直面现实世界的不确定性

真实智能体环境充满缺陷:API 延迟、返回错误、工具缺失等。为此,团队:

- 系统分析现实噪音类型(如响应失败、字段缺失、状态不一致)

- 设计自动化流程将噪音注入训练环境

- 采用课程学习策略:随训练推进逐步增加噪音强度与种类

在专门构建的 τ²-Noise 和 VitaBench-Noise 基准上,LongCat-Flash-Thinking 表现最优,证明其对环境扰动具备强适应能力。

3. 深度思考模式:并行探索 + 迭代总结

为应对极端复杂任务(如数学竞赛、多跳推理),模型支持 深度思考模式:

- 推理广度扩展:并行生成多条高温度思考轨迹,覆盖不同解题路径

- 推理深度扩展:通过专用总结模型提炼关键信息,并递归反馈形成迭代优化循环

- 专项强化训练:额外 RL 阶段专门优化总结能力

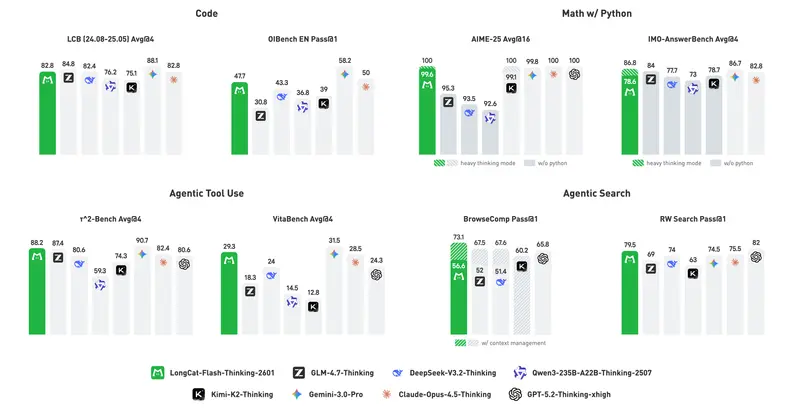

启用该模式后,模型在 AIME-25、IMO-AnswerBench 等高难度数学任务上达到 100.0 / 97.5 等顶尖分数(见下表)。

深度思考模式已在 Longcat AI 平台 上线,支持用户手动触发。

性能表现:全面领先智能体任务

| 任务类别 | 指标 | LongCat-Flash-Thinking-2601 | 最佳竞品 |

|---|---|---|---|

| 智能体工具使用 | τ²-Avg (Avg@4) | 88.2 | 87.4 (GLM-4.7) |

| τ²-Telecom | 99.3 | 98.7 (GPT-5.2) | |

| 智能体搜索 | BrowseComp-zh | 77.7 | 66.6 (GLM-4.7) |

| RW Search | 79.5 | 82.0 (GPT-5.2) | |

| 数学推理(带工具) | AIME-25 | 100.0‡ | 100.0 (Claude/GPT) |

| IMO-AnswerBench | 86.8‡ | 86.7 (Gemini-3-Pro) | |

| 抗噪鲁棒性 | τ²-Noise | 67.1 | 66.0 (GLM-4.7) |

| 泛化能力 | Random Complex Tasks | 35.8 | 32.6 (Claude) |

‡ 表示启用“深度思考模式”后的结果

值得注意的是,尽管总参数量(560B)低于部分竞品(如 Kimi-K2 的 1T),但 LongCat-Flash-Thinking 凭借更高效的架构和训练策略,在多数智能体任务上实现反超。

创新评估:随机复杂任务测试泛化能力

团队提出一种新评估范式:随机复杂任务(Random Complex Tasks)。

- 自动根据关键词生成全新场景

- 随机组合工具集与环境状态

- 要求模型在未见过的工具组合中完成目标

LongCat 在此测试中得分 35.8,显著高于其他模型,证明其具备真正的零样本工具泛化能力。

相关文章