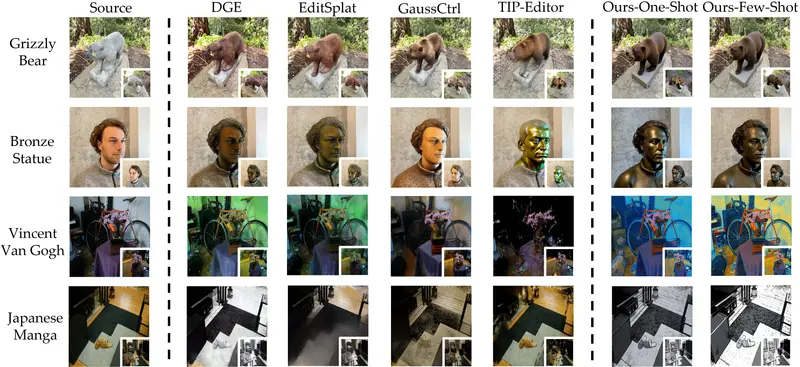

浙江大学和浙江工业大学的研究人员推出新型3D 编辑框架TINKER ,用于高保真度的 3D 编辑,能够在仅有少量输入图像(甚至一张或两张)的情况下实现多视角一致的编辑效果,且无需针对每个场景进行优化。

例如,如果你有一张 3D 场景的图像,并希望将场景中的某个物体的颜色从蓝色改为红色,TINKER 可以在多个视角下实现这一改变,且不需要对每个视角分别进行优化。

主要功能

- 多视角一致编辑:TINKER 能够从少量输入图像(如一张或两张)生成多视角一致的编辑结果。

- 无需场景优化:与以往方法不同,TINKER 不需要针对每个场景进行优化,大大降低了 3D 编辑的门槛。

- 支持多种编辑任务:TINKER 不仅可以进行物体级别的编辑,还可以进行场景级别的编辑,例如改变整个场景的风格。

主要特点

- 高效性:TINKER 通过预训练的扩散模型,无需对每个场景进行优化,显著提高了编辑效率。

- 高质量输出:即使在仅有少量输入图像的情况下,TINKER 也能生成高质量的多视角一致编辑结果。

- 灵活性:支持多种编辑任务,包括物体编辑和场景风格编辑,适用于多种应用场景。

工作原理

TINKER 的工作原理基于两个主要组件:

- 引用多视角编辑器(Referring multi-view editor):通过引用已编辑的图像来指导其他视角的编辑,确保编辑意图在不同视角之间的一致性。

- 任意视角到视频合成器(Any-view-to-video synthesizer):利用视频扩散中的时空先验,从稀疏输入生成高质量的场景补全和新视角生成。

具体步骤如下:

- 数据生成:通过预训练的扩散模型生成多视角一致的编辑数据集,用于训练引用多视角编辑器。

- 场景补全:利用深度信息作为条件,通过视频扩散模型从稀疏编辑视角生成完整的场景。

测试结果

在多个数据集上的实验表明,TINKER 在编辑质量、新视角合成和渲染增强任务上均达到了最先进的性能。例如,在 Mip-NeRF-360 数据集上,TINKER 的编辑结果在 CLIP 文本图像相似度、DINO 相似度和审美评分等指标上均优于现有方法。此外,TINKER 的计算成本较低,可以在单个消费级 GPU 上高效运行。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...