Salesforce、马里兰大学、弗吉尼亚理工大学、纽约大学、华盛顿大学和加州大学戴维斯分校的研究人员推出新型统一多模态模型家族 BLIP3-o ,同时支持图像理解和图像生成任务。多模态模型是指能够处理多种模态(如文本和图像)的模型,而统一多模态模型则进一步将图像理解和图像生成集成到一个框架中。例如,BLIP3-o可以理解图像内容并回答相关问题(图像理解),同时也能根据文本描述生成高质量的图像(图像生成)。

主要功能

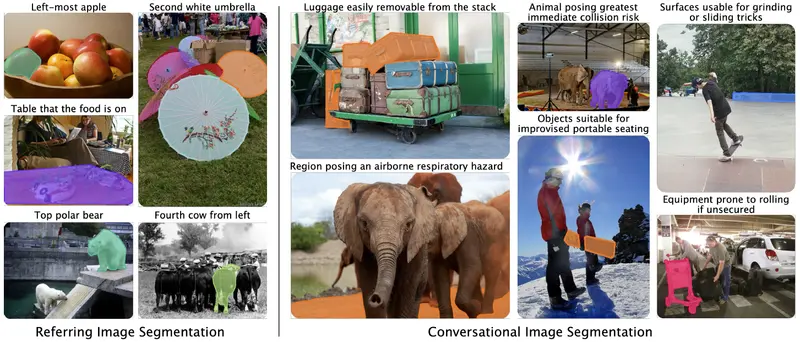

- 图像理解:能够对输入图像进行分析和理解,例如回答与图像内容相关的问题(如视觉问答任务 VQA)。

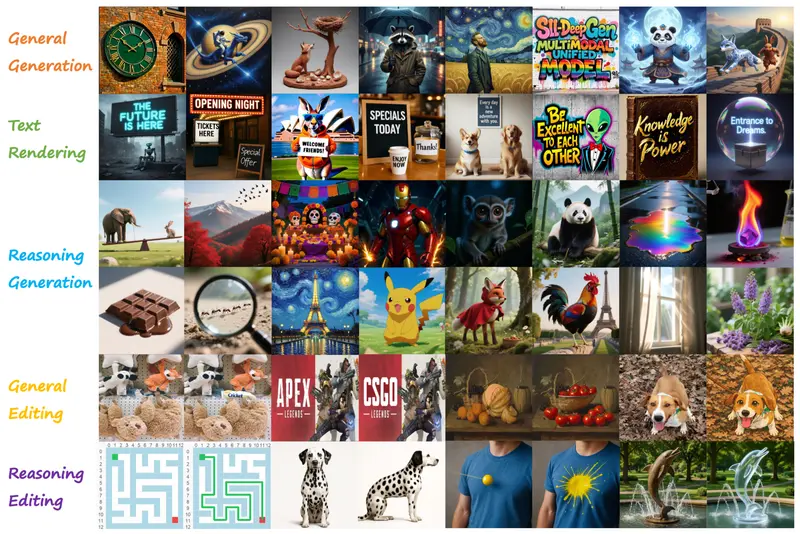

- 图像生成:根据文本描述生成高质量的图像,支持多种场景、对象和风格。

- 指令遵循:能够理解并执行复杂的文本指令,例如生成特定场景的图像或对图像进行编辑。

- 多模态交互:支持图像和文本之间的无缝交互,例如通过文本指令对图像进行编辑。

主要特点

- 创新的架构设计:采用扩散变换器(Diffusion Transformer)来生成语义丰富的 CLIP 图像特征,而不是传统的 VAE(变分自编码器)特征。这种设计提高了训练效率和生成质量。

- 高效的训练策略:采用顺序预训练策略,先训练图像理解任务,再冻结相关模块训练图像生成任务,保留了图像理解能力的同时提升了生成能力。

- 高质量的数据集:精心策划了一个包含 60k 高质量指令调整数据的 BLIP3o-60k 数据集,用于提升模型的视觉审美和指令遵循能力。

- 开源性:模型代码、权重、训练脚本以及预训练和指令调整数据集全部开源,方便研究社区进一步研究和应用。

工作原理

- 图像理解部分:

- 使用 CLIP 模型对输入图像进行编码,提取图像的语义特征。

- 计算目标文本标记与预测文本标记之间的交叉熵损失,优化模型对图像内容的理解能力。

- 图像生成部分:

- 自回归模型根据文本提示生成中间视觉特征。

- 扩散变换器以这些中间特征为条件,生成接近真实 CLIP 特征的图像特征。

- 最终通过扩散解码器将这些特征转换为实际图像。

- 训练策略:

- 顺序训练:先训练图像理解任务,冻结相关模块后再训练图像生成任务,避免了多任务训练中的任务冲突。

- 指令调整:通过 GPT-4o 生成的多样化提示,对模型进行指令调整,提升模型对特定场景和对象的生成能力。

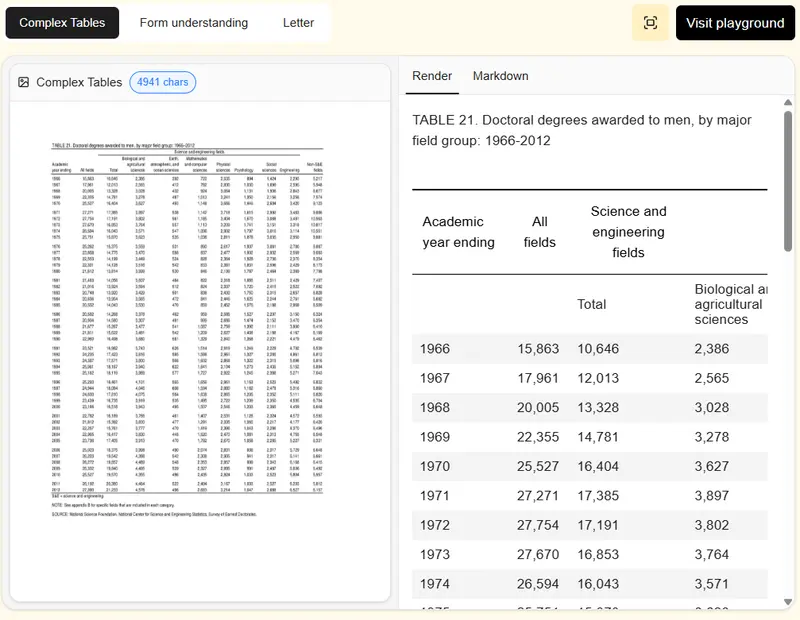

测试结果

- 图像理解任务:

- 在多个基准测试(如 VQAv2、MMBench、MME-P 等)中,BLIP3-o 8B 模型取得了最佳性能,例如在 MME-P 上得分 1682.6,MMMU 上得分 50.6。

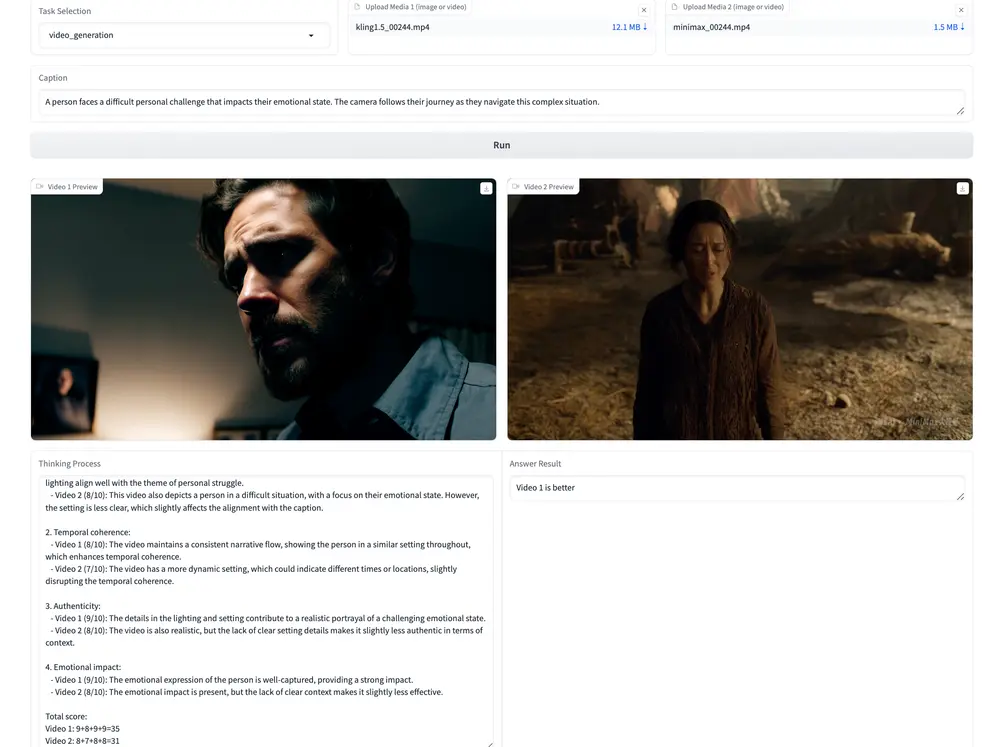

- 图像生成任务:

- 在 GenEval 上得分 0.84,显示了良好的文本对齐能力。

- 在 WISE 任务上得分 0.62,表明模型具有较强的视觉世界知识推理能力。

- 通过人类研究,BLIP3-o 在视觉质量和提示对齐方面均优于 Janus Pro,尽管在 DPG-Bench 上得分略低,但人类评估结果显示其生成图像更具吸引力和对齐性。

- 指令调整效果:

- 使用 BLIP3o-60k 数据集进行指令调整后,模型的视觉审美和指令遵循能力显著提升,生成图像的质量和多样性都有明显改善。

应用场景

- 图像生成:根据用户提供的文本描述生成高质量的图像,例如生成特定场景、对象或风格的图像。

- 视觉问答(VQA):理解图像内容并回答与图像相关的问题,例如在教育、医疗等领域提供视觉辅助。

- 图像编辑:根据文本指令对图像进行编辑,例如添加或删除对象、改变场景风格等。

- 多轮视觉对话:在多轮对话中,根据上下文生成或理解图像,支持更自然的人机交互。

- 多模态内容创作:结合文本和图像生成综合性的多模态内容,例如创作故事书、新闻报道等。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...