艾伦AI研究所和华盛顿大学的研究人员推出机器人行动推理模型MolmoAct ,它通过结构化的三阶段推理流程(感知、规划和控制)将视觉、语言和行动相结合,使机器人能够更智能地执行任务。MolmoAct 的核心在于通过空间推理(reasoning in space)来实现可解释和可引导的行为。

- 官方介绍:https://allenai.org/blog/molmoact

- 模型:https://huggingface.co/collections/allenai/molmoact-689697591a3936fba38174d7

主要功能

MolmoAct 的主要功能是将机器人的感知能力(如视觉输入)和语言指令转化为具体的行动指令。它能够:

- 感知环境:通过深度感知标记(Depth Perception Tokens)理解三维环境。

- 生成规划:通过视觉推理轨迹(Visual Reasoning Trace Tokens)规划动作路径。

- 执行动作:生成精确的低层次动作指令(Action Tokens),驱动机器人完成任务。

例如,在一个“将杯子放入洗碗机”的任务中,MolmoAct 首先通过深度感知标记理解场景的三维结构,然后规划一条从机器人手臂当前位置到杯子位置的路径,并最终生成动作指令来抓取杯子并将其放入洗碗机。

主要特点

- 结构化推理:MolmoAct 采用三阶段推理流程,确保每个阶段的输出都具有明确的空间和语义基础。

- 可解释性:每个推理阶段的输出(如深度图、轨迹图和动作指令)都可以被独立解码和可视化,便于理解模型的决策过程。

- 可引导性:用户可以通过在图像上绘制轨迹来直接引导机器人的动作,而无需依赖复杂的语言指令。

- 数据效率:与现有的机器人模型相比,MolmoAct 在预训练阶段使用的数据量减少了约 90%,但性能却更强。

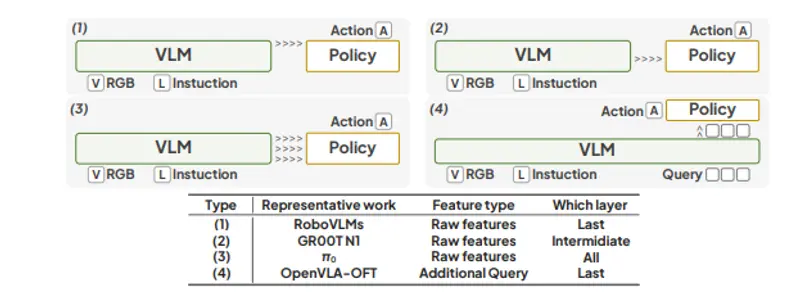

工作原理

MolmoAct 的工作原理可以分为以下几个步骤:

- 深度感知:模型首先将输入的 RGB 图像编码为深度感知标记,这些标记能够捕捉场景的三维结构。

- 视觉推理:基于深度感知标记,模型生成视觉推理轨迹,这些轨迹表示机器人手臂在图像平面上的运动路径。

- 动作预测:最后,模型根据视觉推理轨迹生成精确的动作指令,驱动机器人执行任务。

这种结构化的推理方式类似于人类在执行任务时的思考过程,即先感知环境,然后规划路径,最后执行动作。

测试结果

MolmoAct 在多个基准测试中表现出色:

- 在 SimplerEnv 的视觉匹配任务中,MolmoAct 的零样本准确率达到 70.5%,超过了现有的闭源模型 π0 和 GR00T N1。

- 在 LIBERO 基准测试中,MolmoAct 的平均成功率达到了 86.6%,在长时规划任务中比 ThinkAct 高出 6.3%。

- 在真实世界的微调任务中,MolmoAct 在单臂任务上比 π0-FAST 高出 10%,在双臂任务上高出 22.7%。

- 在开放指令遵循和轨迹引导任务中,MolmoAct 的表现也优于基线模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...