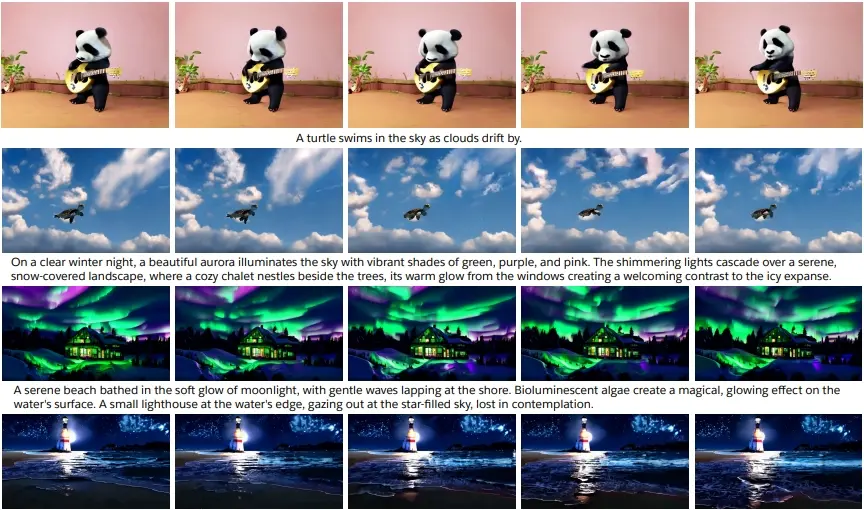

Salesforce推出新的文生视频模型xGen-VideoSyn-1,这个模型能够根据文本描述生成逼真的视频场景,它的设计灵感来源于OpenAI的Sora模型,并在此基础上进行了改进和创新。例如,你有一个能够读懂你想法的视频制作助手。你只需要告诉它你想要看到的场景,比如“一个在月光下波光粼粼的海滩”,它就能创造出一个视频,展现出你所描述的景象。这就是xGen-VideoSyn-1模型的魔力所在。

主要功能:

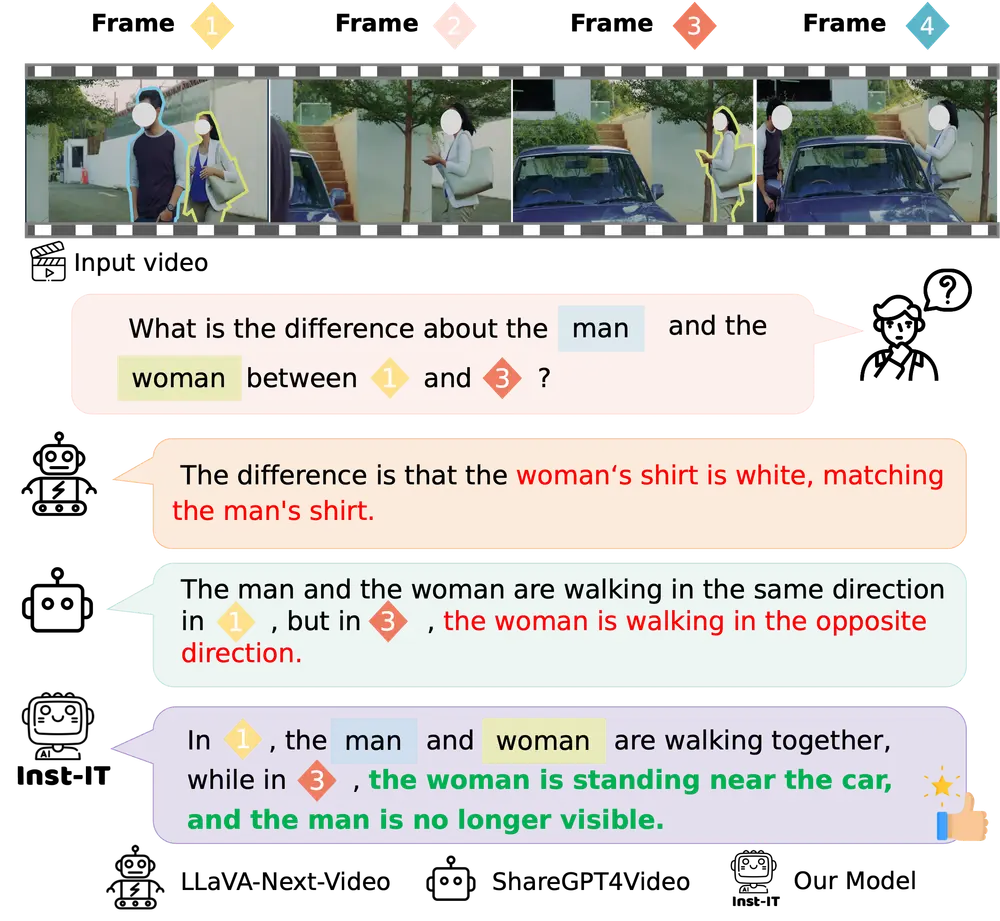

- 文本到视频生成:根据文本描述生成视频内容。

- 高保真度:生成的视频具有较高的清晰度和逼真度。

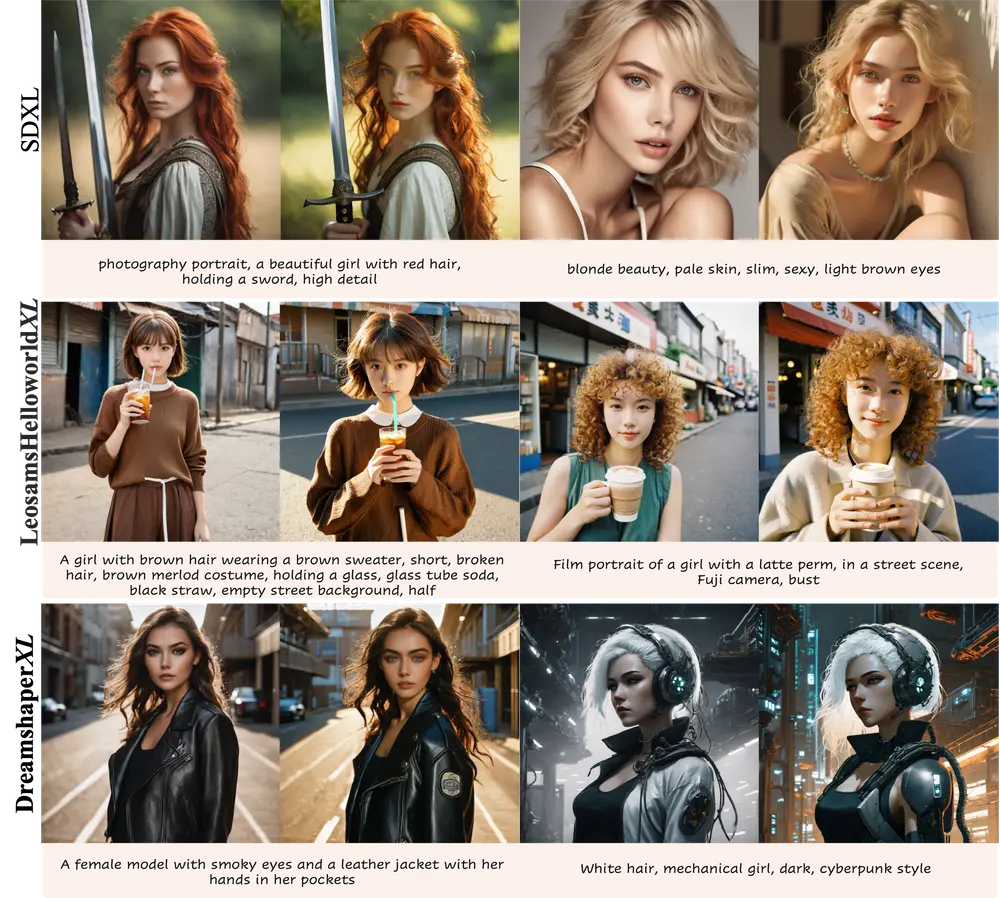

- 多种风格生成:能够根据文本提示生成不同艺术风格(如梵高风格、卡通风格)的视频。

主要特点:

- 压缩表示:使用视频变分自编码器(VidVAE)在空间和时间上压缩视频数据,减少生成长视频的计算需求。

- 分割与合并策略:通过将长视频分割成多个片段来降低计算成本,同时保持视频片段间的时序连贯性。

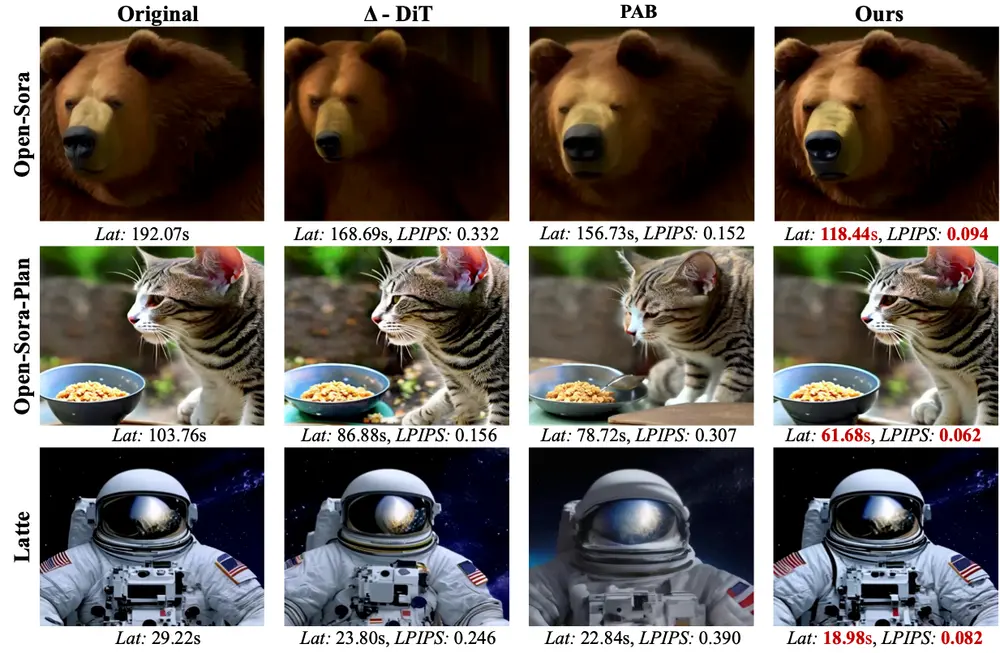

- 扩散变换器(DiT):结合了空间和时间自注意力层,能够在不同时间框架和宽高比下稳健地工作。

工作原理:

- 视频压缩:使用VidVAE将视频数据在空间和时间上进行压缩,生成较短的视觉标记。

- 分割与合并:将长视频分割成多个重叠片段,分别编码,以减少内存需求并保持时序连贯性。

- 扩散过程:采用VDiT模型,通过扩散过程生成视频帧。

- 文本条件:使用语言模型(如T5)编码文本描述,并将其作为条件信息注入到VDiT中。

具体应用场景:

- 内容创作:根据文本描述生成视频,适用于电影制作、游戏设计等领域。

- 社交媒体:用户可以快速生成个性化的视频内容分享到社交平台。

- 教育与培训:通过生成特定场景的视频来辅助教学或模拟训练。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...