新加坡国立大学和字节跳动的研究人员推出一种统一的Transformer模型Show-o,,它统一了多模态的理解和生成。不同于完全自回归模型,Show-o结合了自回归和(离散)扩散建模,以自适应地处理各种混合模态的输入和输出。这种统一的模型灵活地支持了广泛的视觉语言任务,包括视觉问答、文本到图像生成、文本引导的修复/外推以及混合模态生成。例如,你有一个智能助手,它可以看图说话,或者根据你的描述生成图片。Show-o就是这样一个智能助手,但它更厉害,因为它可以用一个模型同时做到这两件事。

主要功能:

- 多模态理解:Show-o能够理解图像内容并回答有关图像的问题。

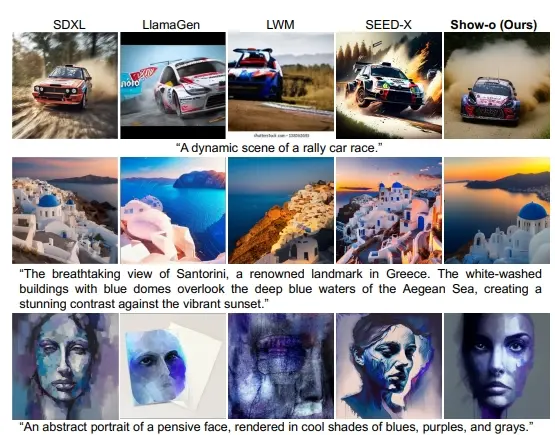

- 文本到图像生成:根据文本描述生成相应的图像。

- 文本引导的图像修复和扩展:对图像的某些部分进行修复或根据文本描述扩展图像内容。

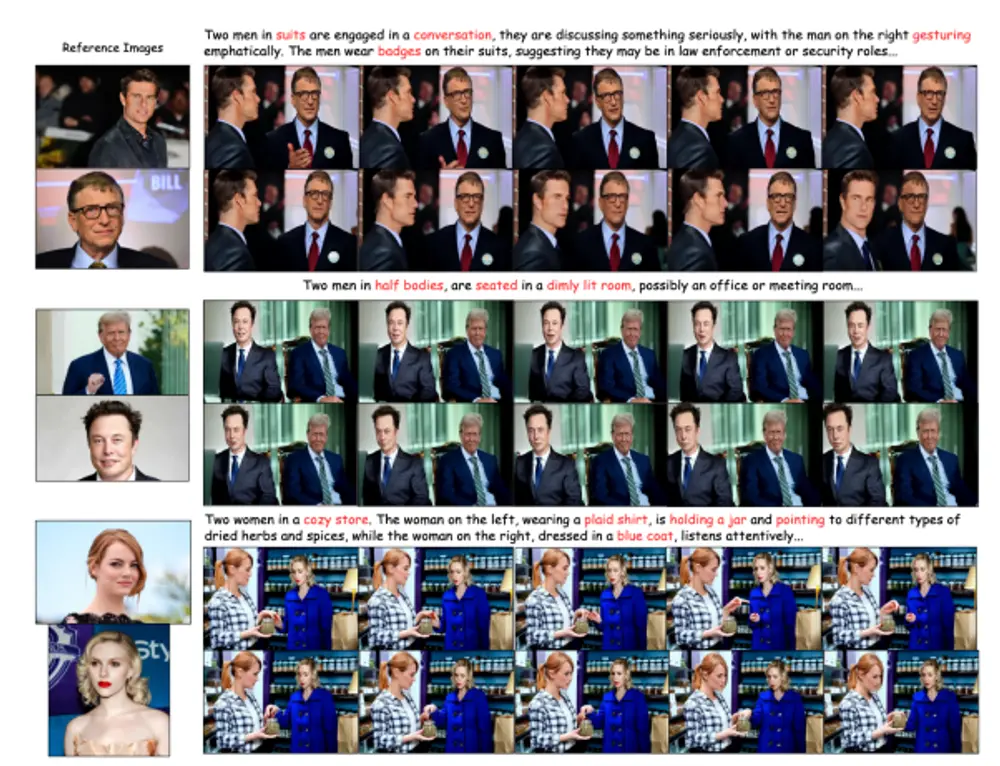

- 混合模态生成:例如,根据文本描述生成视频关键帧。

主要特点:

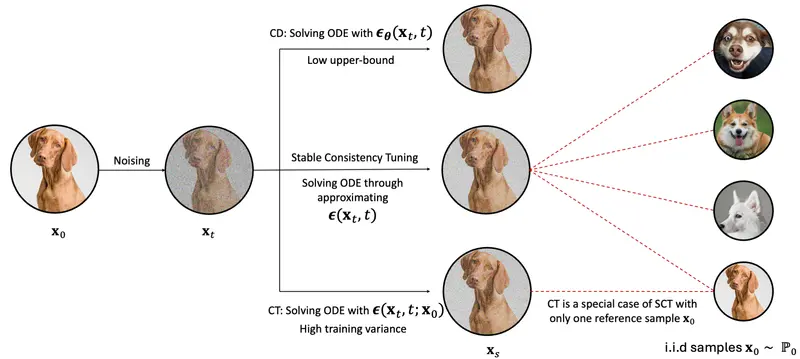

- 统一模型:Show-o将两种不同的建模方式——自回归模型和(离散)扩散模型——结合在一个变换器中,以适应不同模态的输入和输出。

- 灵活性:支持多种视觉-语言任务,不需要为特定任务定制模型。

- 高性能:在多个基准测试中,Show-o展现出与现有专门模型相当或更优的性能。

工作原理:

Show-o的工作原理可以分为以下几个步骤:

- 文本和图像分词:将文本和图像转换成模型可以理解的离散标记。

- 统一提示策略:设计一种格式,将不同模态的数据统一输入到模型中。

- 全注意力机制:Show-o使用一种特殊的注意力机制,可以同时处理文本和图像标记,允许它们以不同的方式相互作用。

- 两阶段学习目标:模型通过预测下一个标记和预测被遮蔽的标记来学习。

具体应用场景:

- 视觉问答:用户可以问Show-o关于图像的问题,比如“图片里有彩虹吗?”Show-o能够理解问题并给出答案。

- 文本到图像:用户给出文本描述,比如“一个穿着晚礼服的女人站在海边”,Show-o能够生成相应的图像。

- 图像修复和扩展:如果一张图片有一部分损坏或不完整,Show-o可以根据周围的内容和文本提示修复或扩展图像。

- 视频生成:Show-o可以根据文本描述生成一系列视频关键帧,为制作视频提供基础。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...