直接偏好优化(DPO)已成为一种强大的方法,用于将文本到图像(T2I)模型与人类反馈对齐。然而,成功应用DPO需要大量的资源来收集和标注大规模数据集,例如数百万张生成的人类偏好注释的配对图像。此外,随着T2I模型的快速改进,这些人类偏好数据集可能会很快过时。为了解决这些问题,图宾根大学、图宾根人工智能中心、慕尼黑机器学习中心、慕尼黑工业大学和Snap的研究人员提出了一种可扩展的方法RankDPO,用于收集用于DPO训练的大规模和完全合成的数据集,旨在提升文本到图像(T2I)模型的性能和安全性。该方法通过生成与人类偏好一致的合成偏好数据集,并使用这些数据来优化T2I模型,从而提高模型在遵循文本提示和视觉质量方面的表现。

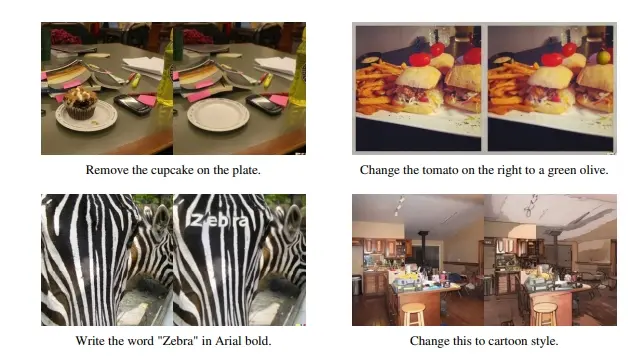

例如,你想要生成一张图片,文本提示是“一只猫拿着一块奶酪”。在没有优化的情况下,T2I模型可能会生成一张猫和奶酪位置不合适或者奶酪看起来不真实的图片。使用RankDPO方法后,模型能够更准确地理解文本提示,并生成一张猫正确拿着奶酪的高质量图片。

主要功能和特点

- 合成偏好数据集(Syn-Pic):通过预训练的奖励函数生成偏好,无需人工标注,提高了数据集收集的效率。

- 排名偏好优化(RankDPO):利用排名反馈增强DPO方法,通过考虑多个模型的预测来提高排名的准确性。

- 成本效益:相比于需要大量人工标注的数据集,这种方法大大减少了数据收集的成本。

- 可扩展性:可以轻松地为新的T2I模型生成和更新偏好数据集,保持数据集的时效性。

工作原理

- 生成图像和偏好:使用不同的T2I模型根据同一文本提示生成多张图像,并利用预训练的奖励模型为这些图像打分,形成排名。

- 排名偏好优化(RankDPO):基于生成的排名数据集,通过优化模型使其生成的图像在排名中更符合预训练奖励模型的偏好。

- 训练和优化:通过比较模型生成的图像与排名中的偏好,调整模型参数以提高图像生成的质量和遵循文本提示的准确性。

方法概述

- 合成偏好数据集:

- 预训练奖励函数:使用预训练的奖励函数生成配对图像的偏好,消除了在注释过程中涉及人类的需求,大大提高了数据集收集效率。

- 大规模数据集:这种方法允许生成大规模的合成偏好数据集,这些数据集可以用于训练和优化T2I模型。

- RankDPO:

- 排名偏好:除了成对偏好,研究人员还引入了RankDPO,使用排名反馈增强基于DPO的方法。

- 跨模型平均:RankDPO允许跨多个模型平均预测,进一步提高模型的性能。

实验结果

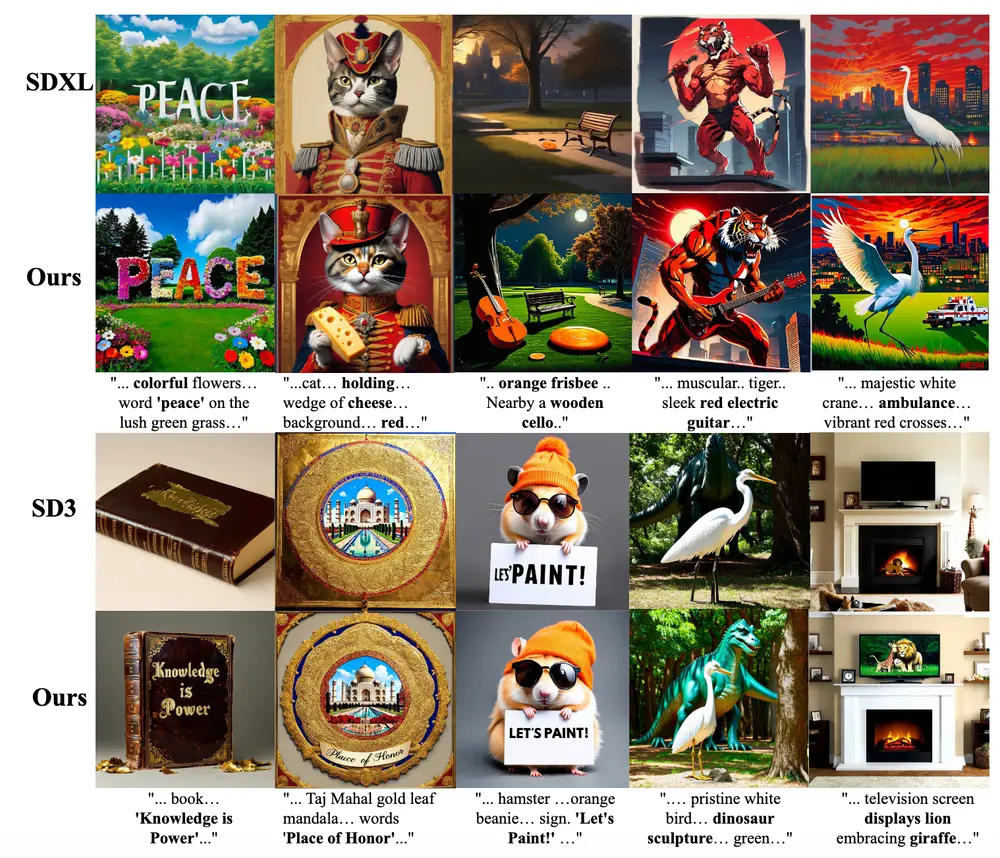

研究人员将RankDPO应用于SDXL和SD3-Medium模型,并使用合成的偏好数据集“Syn-Pic”进行了实验。结果显示:

- 遵循提示:在T2I-Compbench、GenEval和DPG-Bench等基准测试中,模型在遵循文本提示方面的表现得到了显著改进。

- 视觉质量:通过用户研究,模型生成的图像在视觉质量方面也得到了提升。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...