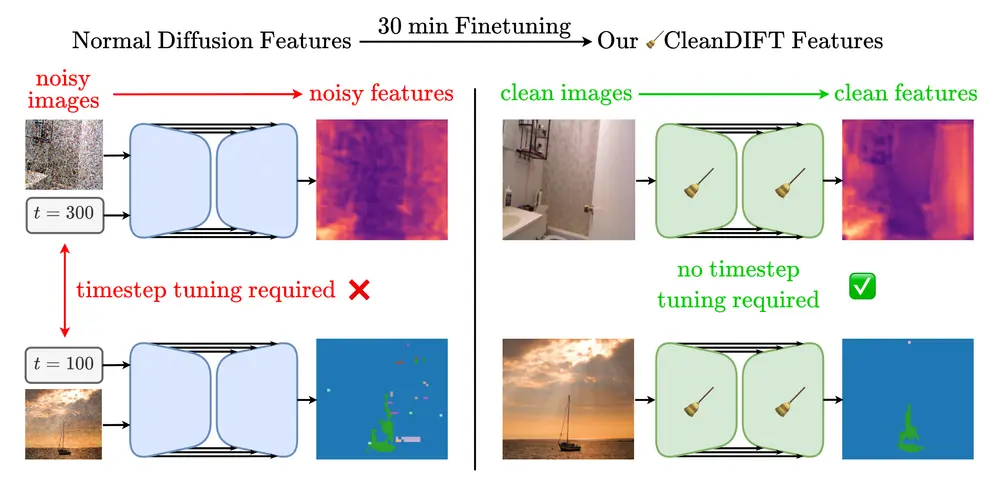

慕尼黑大学的研究人员推出一种名为CleanDIFT的新方法,用于从大规模预训练的扩散模型中提取无噪声、与时间步无关的通用特征表示。这种方法特别针对的是,以往在使用扩散模型提取特征时需要向图像添加噪声,这会降低图像中的信息量并需要针对每个下游任务调整时间步。

- 项目主页:https://compvis.github.io/cleandift

- GitHub:https://github.com/CompVis/cleandift

- 模型:https://huggingface.co/CompVis/cleandift

例如,我们有一个图像识别任务,需要识别图像中的物体和场景。使用传统的扩散模型特征提取方法,我们首先需要向图像添加噪声,然后通过模型提取特征。这不仅会降低图像质量,还可能影响特征的准确性。而CleanDIFT允许我们直接在干净的图像上操作,提取出更准确、更丰富的特征,从而提高下游任务的性能。

主要功能和特点

- 无噪声特征提取:CleanDIFT能够在不添加噪声的情况下提取特征,保留了图像的全部信息。

- 时间步无关:与之前的方法不同,CleanDIFT不需要针对不同的下游任务调整时间步。

- 性能提升:在多种下游任务中,CleanDIFT提取的特征比标准扩散特征表现得更好。

- 成本低廉:CleanDIFT只需大约30分钟的微调,就能在单个A100 GPU上实现。

工作原理

CleanDIFT通过以下步骤工作:

- 特征提取模型初始化:将特征提取模型初始化为扩散模型的可训练副本。

- 清洁图像输入:与接收噪声图像的扩散模型不同,特征提取模型接收干净的输入图像。

- 特征对齐:通过引入时间步条件的特征投影头,将特征提取模型的内部表示与扩散模型的特征进行对齐。

- 损失函数最小化:通过最小化扩散模型特征和特征提取模型特征之间的负余弦相似度来训练模型。

具体应用场景

- 语义对应匹配:在图像间识别和匹配语义上相同的区域。

- 单目深度估计:从单张图像中估计场景的深度信息。

- 语义分割:将图像分割成不同的语义区域,如道路、车辆、行人等。

- 图像分类:识别图像中的主要物体类别。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...