近年来,文本到图像定制技术的进步使得个性化图像的高保真、内容丰富的生成成为可能,允许特定概念在各种场景中出现。然而,当前的方法在结合多个个性化模型时面临挑战,常常导致属性纠缠(即不同概念之间的混淆)或需要为每个概念单独训练模型以保持其独特性。这不仅增加了训练成本,还限制了模型的灵活性和扩展性。

为了解决这些问题,苏黎世联邦理工学院、慕尼黑工业大学、谷歌和弗吉尼亚理工大学的研究人员提出了LoRACLR,这是一种新颖的多概念图像生成方法。LoRACLR能够将多个为不同概念微调的LoRA模型合并为一个统一的模型,而无需额外的单独微调。通过使用对比目标对齐和合并这些模型的权重空间,LoRACLR确保了模型之间的兼容性,同时最小化了干扰,实现了高效、可扩展的多概念图像合成。LoRACLR用于定制化扩散模型(diffusion models),以便在单一模型中合并多个特定概念(如人物、物体或艺术风格)并生成多概念图像。

例如,我们想要生成一张包含多位名人(如Margot Robbie、Taylor Swift)在特定场景(如古老图书馆)中的图片,并且希望这些名人的形象保持其原有的特征。LoRACLR能够在一个统一的模型中整合这些不同的个性化模型(每个模型针对一个特定的名人进行微调),然后生成一个包含所有这些名人的单一图像,同时保留每个人的特点和风格。

LoRACLR的核心创新

1. 低秩适配(LoRA)与对比学习的结合

LoRACLR的核心思想是结合低秩适配(LoRA)和对比学习,以实现多概念模型的有效合并。具体来说:

- 低秩适配(LoRA):LoRA是一种高效的微调方法,通过仅调整模型中的一小部分参数(通常是低秩矩阵),能够在保持原有模型性能的同时,适应新的任务或概念。LoRACLR利用LoRA为每个概念创建一个独立的低秩适配器。

- 对比学习:为了确保不同概念之间的表示不会相互干扰,LoRACLR引入了对比学习的目标。通过对比学习,LoRACLR能够为每个概念强制执行独特且紧密的表示,确保不同概念在共享模型中的清晰分离。

2. 权重空间对齐与合并

LoRACLR通过以下步骤对齐和合并多个LoRA模型的权重空间:

- 初始微调:首先,研究人员为每个概念分别微调一个LoRA模型,生成一组低秩适配器。

- 对比对齐:然后,LoRACLR使用对比学习目标来对齐这些低秩适配器的权重空间。具体来说,对比学习通过最大化相同概念样本之间的相似度,同时最小化不同概念样本之间的相似度,确保每个概念的表示是独特且紧密的。

- 权重合并:最后,LoRACLR将所有对齐后的低秩适配器合并为一个统一的模型。通过这种方式,LoRACLR能够在不增加模型复杂度的情况下,支持多个概念的高效组合。

3. 高效、可扩展的多概念图像生成

通过上述方法,LoRACLR实现了高效、可扩展的多概念图像生成。具体来说:

- 高效性:由于LoRACLR只需要对每个概念进行一次微调,并且通过对比学习对齐权重空间,因此整个过程非常高效,避免了传统方法中需要为每个概念单独训练模型的问题。

- 可扩展性:LoRACLR可以轻松扩展到更多概念,只需为新概念微调一个新的LoRA模型,并将其对齐后合并到现有模型中。这种模块化的设计使得LoRACLR能够灵活应对不同的应用场景。

主要功能:

- 多概念图像生成:合并多个微调过的LoRA模型到一个单一模型中,以便同时生成多个概念。

- 对比学习对齐:使用对比目标(contrastive objective)来对齐和合并这些模型的权重空间,确保兼容性的同时最小化干扰。

主要特点:

- 无需额外微调:LoRACLR可以直接使用现有的LoRA模型,无需重新训练或访问原始训练数据。

- 高效可扩展:LoRACLR通过对比学习实现模型的可扩展组合,使得高质量多概念图像生成无需额外的计算开销。

- 保持概念独特性:通过确保每个模型在其联合组合中独特地代表其相应概念,LoRACLR能够高效、可扩展地进行多概念图像合成。

工作原理:

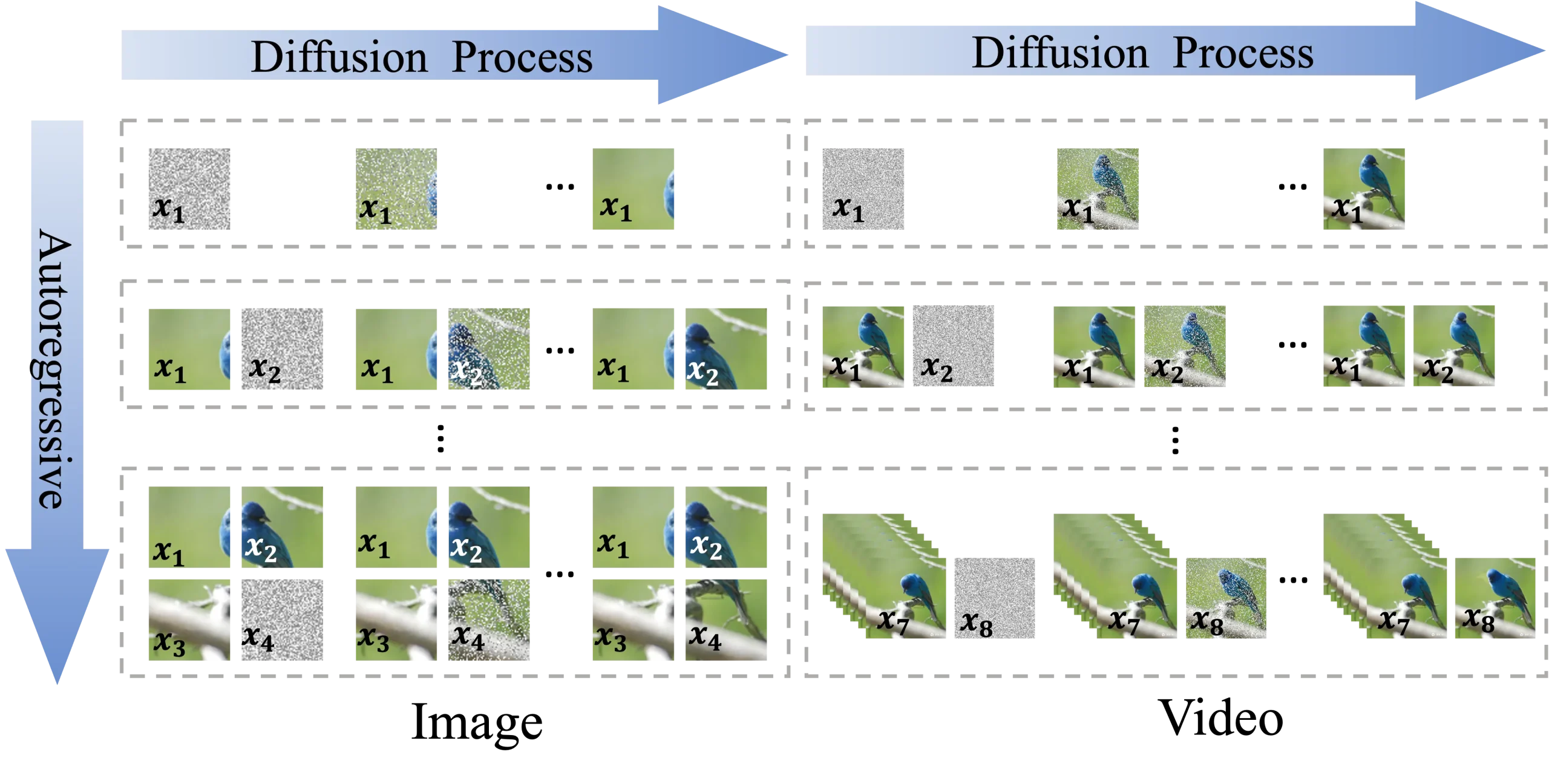

LoRACLR通过以下步骤工作:

- 生成概念特定表示:使用单独预训练的LoRA模型为不同概念生成输入-输出对,建立正负样本对(相关和不相关的概念)。

- 合并表示:将这些表示合并到一个单一模型中,使用新的对比目标来对齐吸引正样本对以确保身份保留,并排斥负样本对以防止跨概念干扰。

- Delta-Based Merging:LoRACLR使用加性Delta(∆W)来合并LoRA模型,而不是直接修改基础权重,通过限制∆W的大小来确保稀疏性和最小调整。

实验结果

1. 多概念图像生成的质量

实验结果表明,LoRACLR在多概念图像生成方面表现出色,能够准确地将多个概念融合到同一张图像中,而不会出现属性纠缠。具体来说:

- 高质量生成:LoRACLR生成的图像具有高保真度和丰富的内容,能够忠实地反映输入文本中描述的多个概念。

- 概念分离:通过对比学习,LoRACLR确保了不同概念之间的清晰分离,避免了属性纠缠问题。即使在复杂的多概念场景中,生成的图像也能够准确地表达每个概念的独特特征。

2. 与其他方法的比较

研究人员将LoRACLR与现有的多概念图像生成方法进行了比较,结果表明LoRACLR在以下几个方面具有显著优势:

- 更好的概念分离:与传统的微调方法相比,LoRACLR能够更好地分离不同概念,避免了属性纠缠问题。

- 更高的效率:LoRACLR通过对比学习对齐权重空间,避免了为每个概念单独训练模型的需求,显著提高了训练效率。

- 更强的泛化能力:LoRACLR的模块化设计使其能够轻松扩展到更多概念,适用于更广泛的应用场景。

相关文章