在上周开幕的 2025 世界机器人大会上,阿里达摩院宣布开源一套完整的具身智能技术体系,包括:

- 视觉-语言-动作模型 RynnVLA-001-7B

- 世界理解模型 RynnEC

- 机器人上下文协议 RynnRCP

这不仅是一次模型发布,更是一次对具身智能开发流程碎片化问题的系统性回应。

机器人上下文协议 RynnRCP:https://github.com/alibaba-damo-academy/RynnRCP

视觉-语言-动作模型 RynnVLA-001:https://github.com/alibaba-damo-academy/RynnVLA-001

世界理解模型 RynnEC:https://github.com/alibaba-damo-academy/RynnEC

WorldVLA 模型:https://github.com/alibaba-damo-academy/WorldVLA

当前,尽管大模型驱动的机器人技术飞速发展,但开发者仍面临诸多现实挑战:

- 模型输出无法对接真实机器人控制;

- 不同传感器、机械臂、AI模型之间缺乏统一接口;

- 仿真策略难以迁移到真机;

- 数据采集、训练、部署链条割裂。

达摩院此次推出的 Rynn 系列,正是试图通过“协议先行 + 模型协同”的方式,打通从感知到执行的全链路。

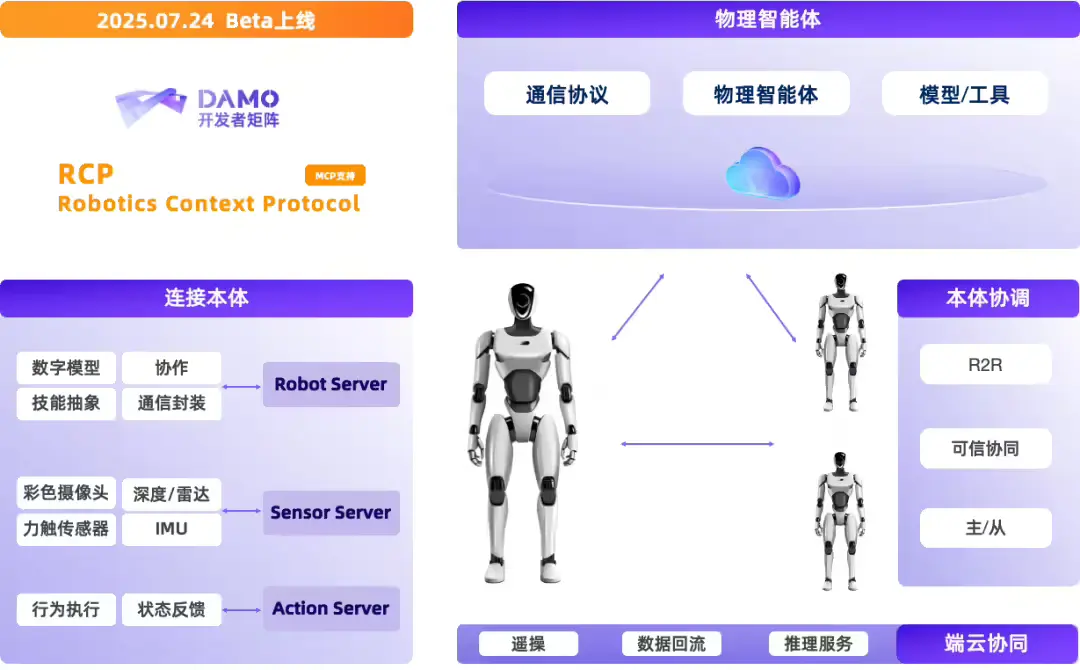

核心突破:提出 RCP 协议,构建机器人领域的“通用语言”

达摩院将 MCP(Model Context Protocol)的理念延伸至机器人领域,首次提出并开源 RynnRCP ——一套面向具身智能的标准化服务协议与框架。

它的目标很明确:让数据、模型和机器人本体之间实现即插即用的兼容适配。

RynnRCP 包含两大核心模块:

1. RCP 框架:连接感知与推理的标准化桥梁

RCP 框架负责:

- 建立机器人本体与各类传感器(摄像头、力矩传感器、IMU 等)的连接;

- 提供统一的能力描述接口(Capability Interface),屏蔽硬件差异;

- 支持多种传输层(如 gRPC、WebSocket)和模型服务(本地/远程)的灵活接入。

这使得开发者无需为每款新设备重写通信逻辑,真正实现“一次对接,多端可用”。

2. RobotMotion:从低频推理到高频控制的实时转换器

大模型通常以秒级频率输出动作指令(如“抓取红色积木”),但真实机器人需要千赫兹级的连续控制信号。

RobotMotion 正是解决这一“频率鸿沟”的关键模块:

- 将离散的高层指令(symbolic command)转化为平滑、符合物理约束的轨迹;

- 支持动态避障、柔顺控制、力反馈调节等高级特性;

- 内置运动插值与异常处理机制,提升执行稳定性。

更重要的是,它提供了一套一体化仿真-真机控制工具链,支持:

| 功能 | 说明 |

|---|---|

| 任务规控 | 图形化定义任务流程 |

| 仿真同步 | 实时映射仿真环境状态 |

| 数据采集与回放 | 记录真实交互数据用于训练 |

| 轨迹可视化 | 直观查看运动路径与误差 |

显著降低了从仿真到真实部署的迁移成本。

目前,RynnRCP 已支持 Pi0、GR00T N1.5 等主流视觉语言动作模型,以及 SO-100、SO-101 等多款机械臂,并持续拓展生态。

开源模型:让机器人“看得懂、想得清、做得对”**

除了协议框架,达摩院还同步开源两款关键模型,分别聚焦动作执行与环境理解。

1. RynnVLA-001-7B:从人类视频中学“像人一样操作”

RynnVLA-001 是一个 7B 参数的视觉-语言-动作(VLA)模型,其训练方式别具一格:

- 基于大量第一人称视角(egocentric)操作视频进行预训练;

- 学习人类手部运动轨迹与物体交互模式;

- 隐式迁移至机械臂控制,无需显式标注动作标签。

这意味着,模型学到的不是“坐标+角度”的机械指令,而是更接近人类直觉的操作语义。

实验表明,使用 RynnVLA-001 控制的机械臂,动作更加连贯、自然,在抓取、放置、开合等任务中表现出更强的适应性。

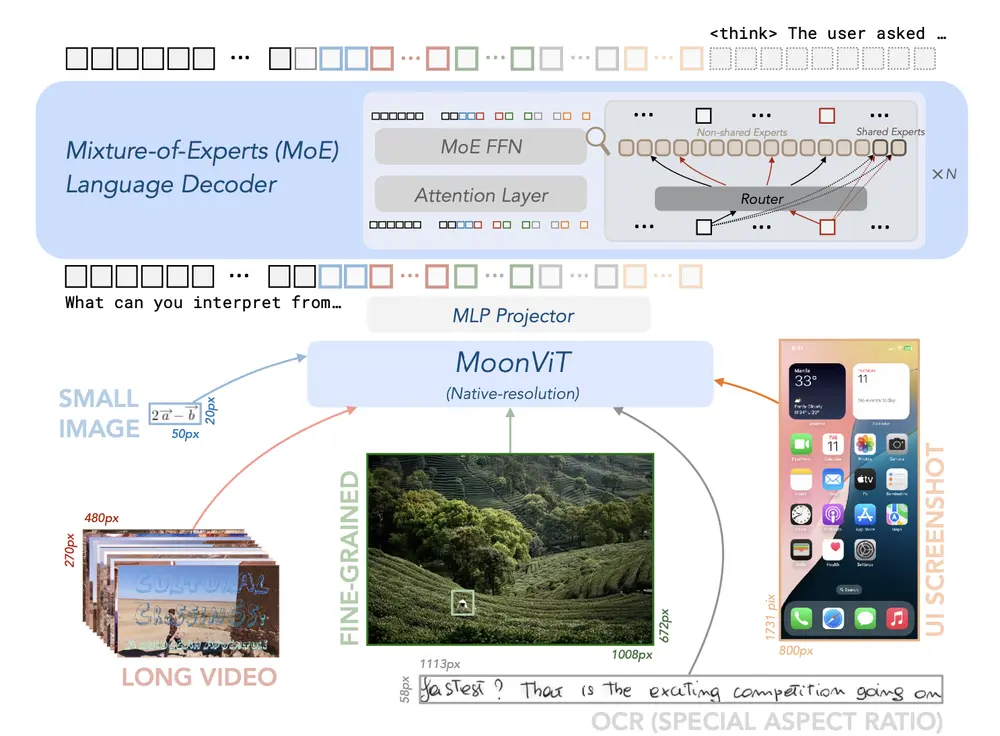

2. RynnEC:赋予机器人“理解物理世界”的能力

传统视觉模型擅长识别“这是什么”,但在具身场景中,机器人还需要知道:

- 物体的位置关系(左/右、上/下)

- 功能属性(可抓取、可打开、可移动)

- 数量与状态(是否空、是否打开)

为此,达摩院推出 RynnEC(Rynn Embodied Context) ——一个多模态世界理解模型。

它能从视频序列中提取并结构化表达场景信息,在无需3D建模的前提下,实现:

- 连续空间感知(Spatial Awareness)

- 目标精准定位与分割

- 多维度语义解析(位置、功能、数量等共11个维度)

例如,当指令为“把左边那个能打开的盒子拿过来”,RynnEC 可准确识别出符合“左侧”“容器类”“有盖子”等条件的目标。

这种能力使其在复杂室内环境(如家庭、办公室)中具备更强的实用潜力。

生态协同:不止于单点突破

值得注意的是,达摩院在上月还开源了 WorldVLA 模型,首次将世界模型与动作生成模型融合:

- 同时建模环境演化与动作响应;

- 在抓取任务中,成功率提升 4%;

- 视频生成质量更高,动作与场景更协调。

这一系列动作表明,达摩院正在构建一个协议统一、模型协同、软硬一体的具身智能开发生态。

为什么这很重要?

Rynn 系列的价值,不在于某一项指标的领先,而在于它尝试回答一个根本问题:

如何让大模型真正“落地”到物理世界?

它的答案是:

- 先建标准:用 RCP 协议解决“接不上”的问题;

- 再优模型:用 RynnVLA 和 RynnEC 解决“看不懂”“做不对”的问题;

- 最后打通流程:通过仿真-真机一体化工具降低迁移门槛。

这套方法论,既适合科研团队快速验证算法,也适合企业构建可落地的机器人应用。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)