面壁智能正式推出 MiniCPM-V 4.0 —— MiniCPM-V 系列中最新的高效多模态模型,参数总量仅 4.1B,却在图像理解能力上实现显著突破。

- GitHub:https://github.com/OpenBMB/MiniCPM-o

- 模型:https://huggingface.co/openbmb/MiniCPM-V-4

- GGUF:https://huggingface.co/openbmb/MiniCPM-V-4-gguf

该模型在权威评测平台 OpenCompass 上综合得分达 69.0,超越了同规模甚至更大模型,包括:

- Qwen2.5-VL-3B-Instruct(3.8B)(得分 64.5)

- MiniCPM-V 2.6(8.1B)(得分 65.2)

- 以及广泛使用的闭源模型 GPT-4.1-mini-20250414

凭借小巧的参数量与高效的架构设计,MiniCPM-V 4.0 不仅性能领先,更成为移动端部署的理想选择。例如,在 iPhone 16 Pro Max 上运行开源 iOS 应用时:

- 首 token 延迟低于 2 秒

- 解码速度超过 17.9 tokens/s

- 运行稳定,无明显发热现象

这意味着用户可在本地设备上流畅使用高性能视觉理解功能,无需依赖云端服务。

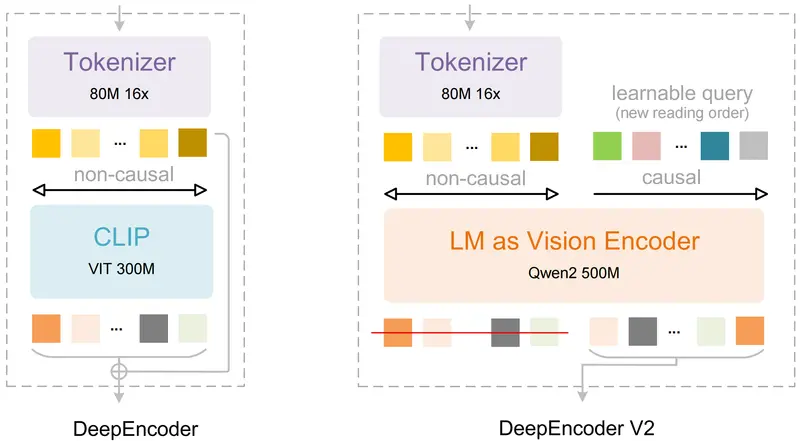

模型架构:轻量设计,能力不减

MiniCPM-V 4.0 基于以下核心组件构建:

- 视觉编码器:SigLIP2-400M

- 语言模型基座:MiniCPM4-3B

总参数量控制在 4.1B,通过精细化架构优化和训练策略升级,在保持低资源消耗的同时,显著提升了推理效率与语义理解能力。

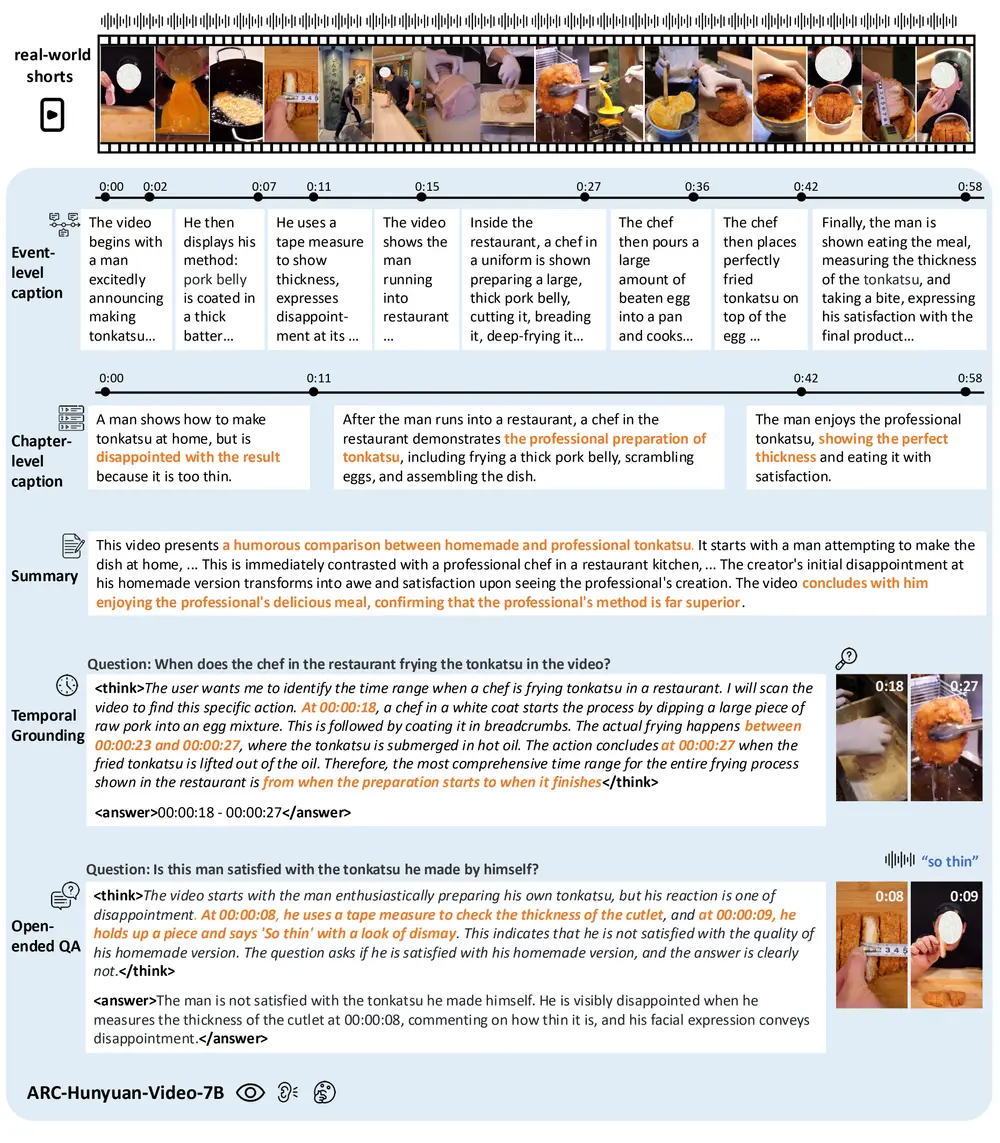

它延续了 MiniCPM-V 2.6 在以下任务中的优势:

- 单图理解(图文匹配、描述生成)

- 多图推理(跨图关系分析、事件推断)

- 视频理解(帧序列建模、动作识别)

并在复杂场景下的上下文建模与细节捕捉能力上进一步提升。

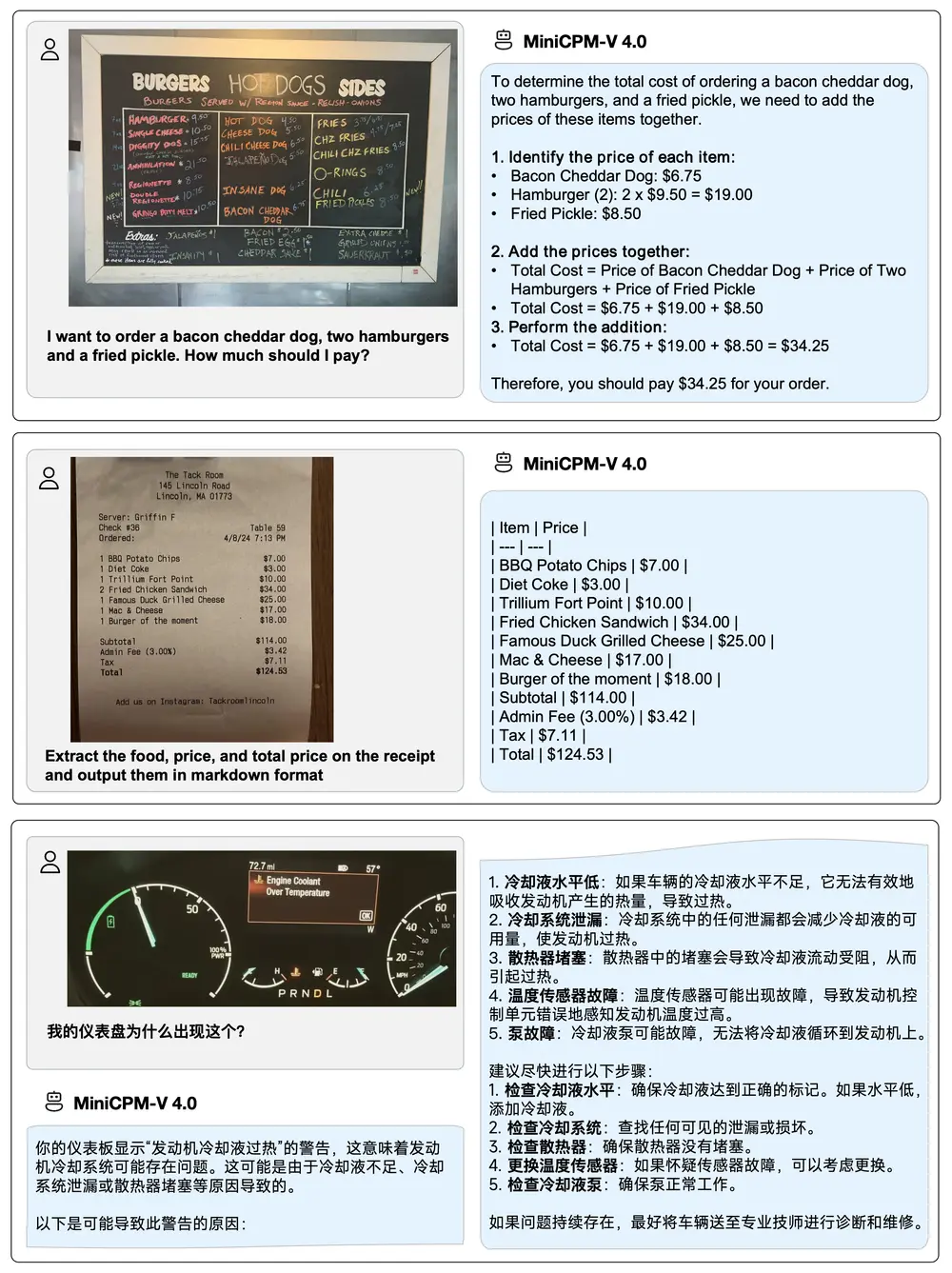

核心亮点

🔥 更强的视觉理解能力

在 OpenCompass 多项评测中,MiniCPM-V 4.0 实现全面领先:

| 模型 | 参数量 | OpenCompass 平均分 |

|---|---|---|

| MiniCPM-V 4.0 | 4.1B | 69.0 ✅ |

| MiniCPM-V 2.6 | 8.1B | 65.2 |

| Qwen2.5-VL-3B-Instruct | 3.8B | 64.5 |

| GPT-4.1-mini-20250414 | - | <69.0 |

尤其在 多图理解 与 视频问答 任务中表现突出,能够准确识别图像间逻辑关系,并对动态过程进行合理推断。

🚀 更高效的端侧推理

MiniCPM-V 4.0 从架构层面针对边缘设备进行优化,具备出色的运行效率:

- 在 iPhone 16 Pro Max 上:

- 首 token 延迟:<2 秒

- 解码速度:17.9 tokens/s

- 内存占用低,长时间运行无发热降频问题

- 在并发请求场景下,展现出优异的吞吐能力,适合集成至高可用本地应用。

这一表现使其成为目前少数能在移动设备上实现实时交互式多模态体验的开源模型之一。

💫 更便捷的使用方式

为降低使用门槛,面壁智能提供了多样化的部署与调用方式:

✅ 支持主流推理框架:

llama.cpp(轻量级C++推理)Ollama(本地模型管理)vLLM/SGLang(高吞吐服务部署)LLaMA-Factory(微调与训练支持)

✅ 提供 开源 iOS 应用:

- 可直接在 iPhone 和 iPad 上安装运行

- 支持图像上传、实时对话、历史记录保存

- 完全本地运行,保障隐私安全

✅ 配套发布《使用手册》:

- 结构清晰,涵盖部署指南、性能测试、真实示例

- 包含 Web Demo 快速体验入口

- 开发者可一键启动本地服务

为什么 MiniCPM-V 4.0 值得关注?

| 维度 | MiniCPM-V 4.0 的价值 |

|---|---|

| 性能 vs. 规模 | 以不到 4.5B 参数超越更大模型,性价比极高 |

| 端侧适配性 | 真正在移动端实现“低延迟 + 高质量”响应 |

| 开源开放 | 全流程可本地运行,支持私有化部署 |

| 生态友好 | 兼容主流框架,易于集成进现有系统 |

它不仅是一个技术突破,更是推动多模态AI平民化、设备化、隐私化的重要一步。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...