让机器人叠衣服,听起来简单,做起来极难。

布料柔软、易变形,同一件T恤每次摆放的形态都不同。这种高度的可变性使得机器人难以像抓取刚性物体那样,靠预设动作完成操作。更别说还要应对不同款式——无袖、短袖、长袖、裤子……每种衣物的折叠逻辑都不一样。

传统方法通常依赖人工标注关键点或人类演示(如模仿学习),但这类方式泛化能力弱,换一种衣服就得重新训练。

现在,来自新加坡国立大学、新加坡国立大学广州研究院、南京大学、北京大学和上海交通大学的研究团队,提出了一种新框架 MetaFold ——一个能听懂指令、适应多种衣物、实现自动化折叠的机器人系统。

它的核心思路很清晰: 把“想怎么折”和“怎么动手”分开处理。

为什么 MetaFold 更强?

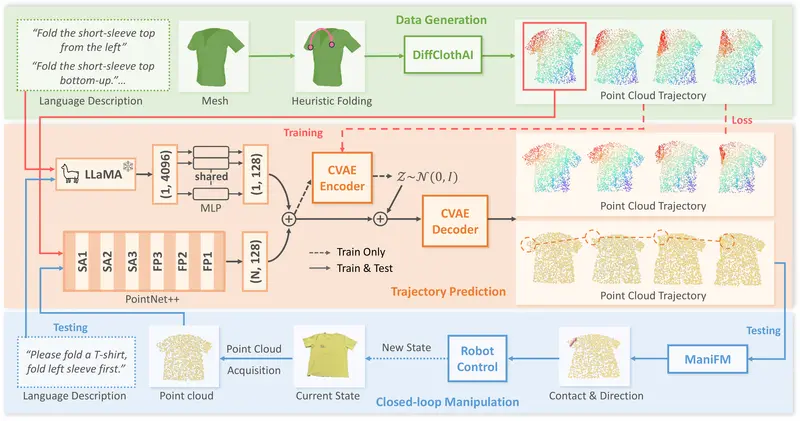

MetaFold 的创新在于模块化架构:将任务规划(该往哪折)与动作执行(怎么抓、往哪放)解耦,分别由两个独立模块完成。

- 上层:语言引导的轨迹生成

用户用自然语言下达指令,比如:“先把T恤的左袖子折过来。”

系统结合当前衣物的点云状态和语言描述,生成后续折叠的点云轨迹——也就是衣物在空间中应该变成什么样子。 - 下层:基于基础模型的动作预测

生成的轨迹输入到 ManiFoundation(一种通用机器人操作基础模型)中,由它预测具体的机器人动作:从哪里接触布料、施加多大力、朝哪个方向移动。 - 闭环反馈:实时调整

每次动作执行后,系统重新扫描衣物当前状态(通过深度相机获取点云),对比目标轨迹,动态修正下一步操作,形成闭环控制。

这种“规划+执行+反馈”的结构,使系统既能理解语义指令,又能灵活应对布料形变,显著提升了在真实环境中的鲁棒性。

如何训练?大规模数据集支撑

为了支持多类别衣物的学习,研究团队构建了 MetaFold 数据集:

- 包含 1210 件不同类型的衣物(无袖、短袖、长袖、裤子)

- 覆盖 3376 条折叠轨迹

- 每条轨迹配有自然语言描述,用于训练语言-动作对齐能力

数据在 DiffClothAI 模拟环境中生成,使用启发式算法自动规划合理折叠路径,再添加语言标注。这种方式避免了大量人工标注,同时保证了轨迹的合理性。

可视化显示,系统能准确捕捉不同衣物的折叠阶段:

- 无袖上衣:1个阶段

- 短袖/长袖:各3个阶段

- 裤子:2个阶段

用户可通过语言指令选择起始状态和目标步骤,系统即刻生成对应轨迹。

核心优势一览

| 特性 | 说明 |

|---|---|

| ✅ 多类别泛化 | 支持多种衣物类型,无需为每类单独训练模型 |

| ✅ 语言交互 | 支持自然语言指令,提升人机协作灵活性 |

| ✅ 模块化设计 | 规划与执行分离,便于迭代与扩展 |

| ✅ 闭环控制 | 实时感知+反馈调整,适应真实环境扰动 |

| ✅ 大规模数据 | 自动化生成带语言标注的轨迹数据集 |

实验结果:全面领先

在多个测试中,MetaFold 表现出明显优势:

- 在 MetaFold 数据集上

折叠成功率达 88%,显著高于 UniGarmentManip(71%)和 GPT-Fabric(34%)。 - 语言泛化能力测试(Cloth3D 数据集)

面对训练中未见过的语言指令,MetaFold 成功率达 97%,而基线方法仅为 47%,显示出强大的语义理解能力。 - 真实机器人实验

在物理机器人平台上测试,成功率达到 90%,验证了其在现实场景中的可行性。

这项技术意味着什么?

MetaFold 不只是一个“叠衣服”的demo。它代表了机器人操作向通用化、语义化、闭环化迈进的重要一步。

- 它证明了任务规划与动作执行分离的架构,在处理高自由度柔性物体时的有效性。

- 它展示了语言+点云+基础模型协同工作的潜力,为未来家庭服务机器人提供了可行路径。

- 更重要的是,它让普通人也能通过自然语言参与机器人控制,降低了使用门槛。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...