要点提炼:

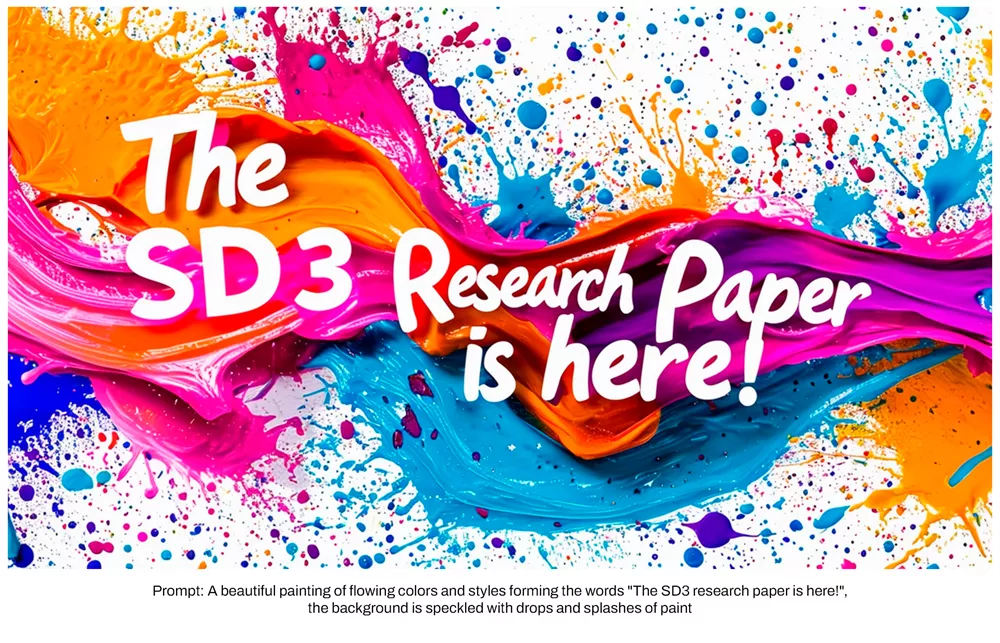

- Stability AI发布了深入剖析Stable Diffusion 3核心技术的研究论文

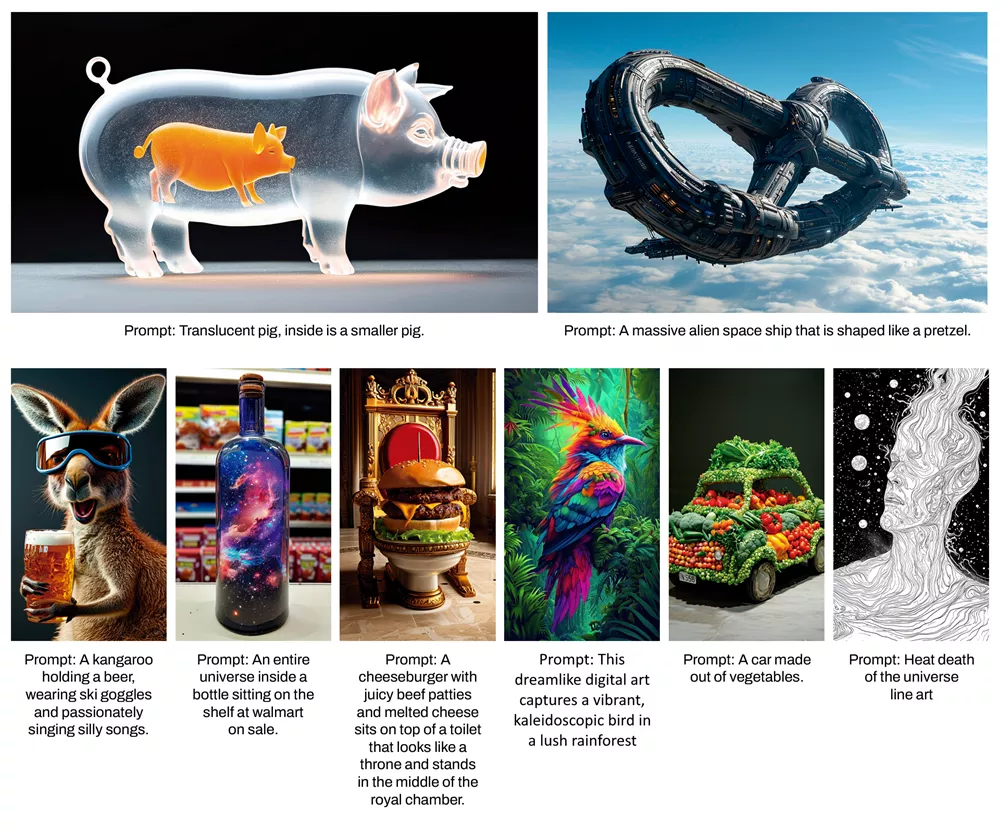

- 基于人类偏好评估,Stable Diffusion 3在遵循提示内容及排版质量上超越了DALL·E 3、Midjourney v6和Ideogram v1等当前顶级文生图模型

- 创新的MMDiT架构为图像和文本表示分别设置了独立权重集,相较于SD3先前版本,这一改进显著提升了对文本的理解力和拼写准确性

性能比较

为了评估性能,开发人员基于人类反馈,将Stable Diffusion 3的输出图像与其他多种开源模型进行了比较,这些模型包括SDXL、SDXL Turbo、Stable Cascade、Playground v2.5和Pixart-α,同时研究人员还对比了DALL·E 3、Midjourney v6和Ideogram v1等商业模型。

在测试过程中,评估者会收到来自每个模型的示例输出,并根据模型输出与给定提示的匹配程度(“提示遵循度{prompt following}”)、文本的渲染质量(“排版{typography}”)以及图像的审美标准(“视觉美学{visual aesthetics}”)来选出最佳结果。结果显示,“Stable Diffusion 3”在上述所有评估标准中均达到或超越当前最先进水平。

测试结果表明,Stable Diffusion 3在上述所有方面均能与目前最先进的文本到图像生成系统相媲美,甚至在某些方面表现更优。

在消费级硬件的推理测试中,研究人员发现最大的SD3模型拥有80亿个参数,能够适配RTX 4090的24GB 显存。当使用50个采样步骤时,该模型能在34秒内生成分辨率为1024x1024的图像。此外,为了降低硬件门槛,Stable Diffusion 3在首次发布时将提供多个版本,参数范围从800m到80亿不等。

MMDiT架构详解

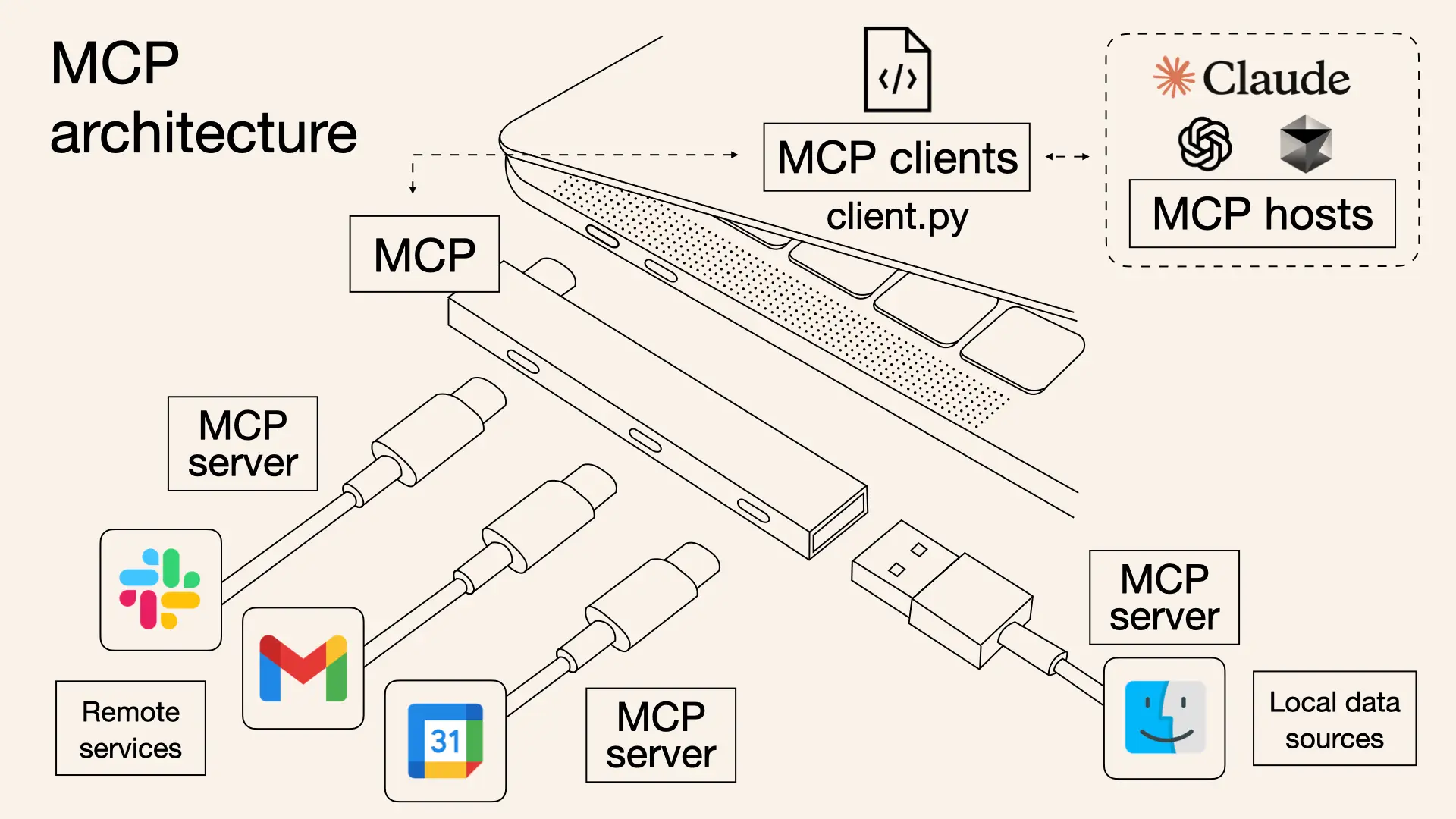

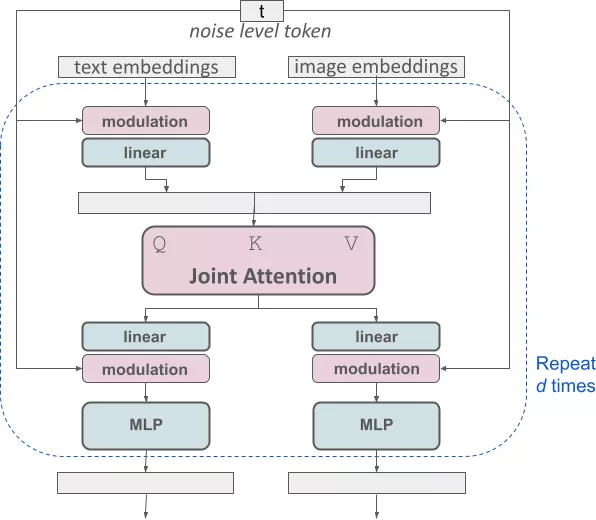

为了进行文本到图像的生成,Stable Diffusion 3必须同时考虑文本和图像这两种模态。因此,研究人员称这种新架构为MMDiT,这是对其能够处理多种模态的能力的参考。

与Stable Diffusion的早期版本类似,研究人员利用预训练模型来推导出合适的文本和图像表示。具体来说,研究人员采用了三种不同的文本嵌入器——两个CLIP模型和T5——来编码文本表示,同时,也利用了一个改进的自编码模型来编码图像令牌(tokens)。

Stable Diffusion 3架构是在Diffusion Transformer(“DiT”,2023年提出)的基础上构建的。鉴于文本和图像嵌入在概念上的差异,研究人员为这两种模态分别设置了独立的权重。

如上图所示,这相当于为每种模态分配了两个独立的变换器,但在进行注意力操作时,研究人员会将这两种模态的序列相结合,以便各自在其空间内工作,同时考虑到另一种模态的信息。

通过这种方法,图像和文本令牌之间的信息得以流通,从而提高了生成输出的整体理解和排版质量。此外,这种架构还易于扩展到其他多种模态,如视频。

Stable Diffusion 3凭借改进的提示遵循能力,使模型能够专注于生成不同主题和品质的图像,同时保持图像风格的高度灵活性。

主要特点:

- 多模态处理:MM-DiT能够同时处理图像和文本两种模态的信息。这意味着模型可以更好地理解文本描述,并将其转化为相应的图像内容。

- 双向信息流:在MM-DiT中,图像和文本信息可以在网络内部双向流动。这种设计允许模型在生成图像时考虑到文本的上下文,从而生成更符合文本描述的图像。

- 可扩展性:MM-DiT的架构允许通过增加模型的深度(即注意力块的数量)和注意力头的数量来扩展模型的规模,以适应更复杂的任务。

- 性能提升:论文中的实验结果表明,MM-DiT在多个评估指标上优于现有的一些基础模型,如UViT(Unified Vision Transformer)和DiT(Denoising Diffusion Transformer)。

工作原理:

MM-DiT的架构基于DiT(Denoising Diffusion Transformer),它使用了一个图像编码器、一个图像到三角平面(triplane)的解码器,以及一个基于三角平面的神经辐射场(NeRF)。图像编码器使用预训练的视觉Transformer模型(如DINOv1)将RGB图像投影成一组潜在向量。这些向量包含了图像的全局和局部特征,并用于重建3D对象。图像到三角平面的解码器将这些潜在向量转换为三角平面-NeRF表示,这是一种紧凑且富有表现力的3D表示方法。NeRF模型由多层感知器(MLP)组成,负责预测空间中3D点的颜色和密度。

通过重新加权改进Rectified Flow

Stable Diffusion 3采用了一种Rectified Flow(RF)框架,在训练过程中,数据和噪声通过线性轨迹进行连接,从而得到更直接的推理路径,这允许模型在采样时使用更少的步骤。此外,研究人员还在训练过程中引入了一种新型的轨迹采样计划。这个计划给予轨迹中部更多的权重,因为研究人员假设这些部分会带来更具挑战性的预测任务。

为了验证此方法,研究人员与LDM、EDM和ADM等其他60种扩散轨迹进行了比较,采用了多个数据集、指标和采样器设置。结果显示,尽管之前的RF公式在少量步骤的采样方案中有所改进,但随着步数的增加,其相对性能逐渐下降。然而,重新加权的RF变体在性能上始终保持一致的提升。

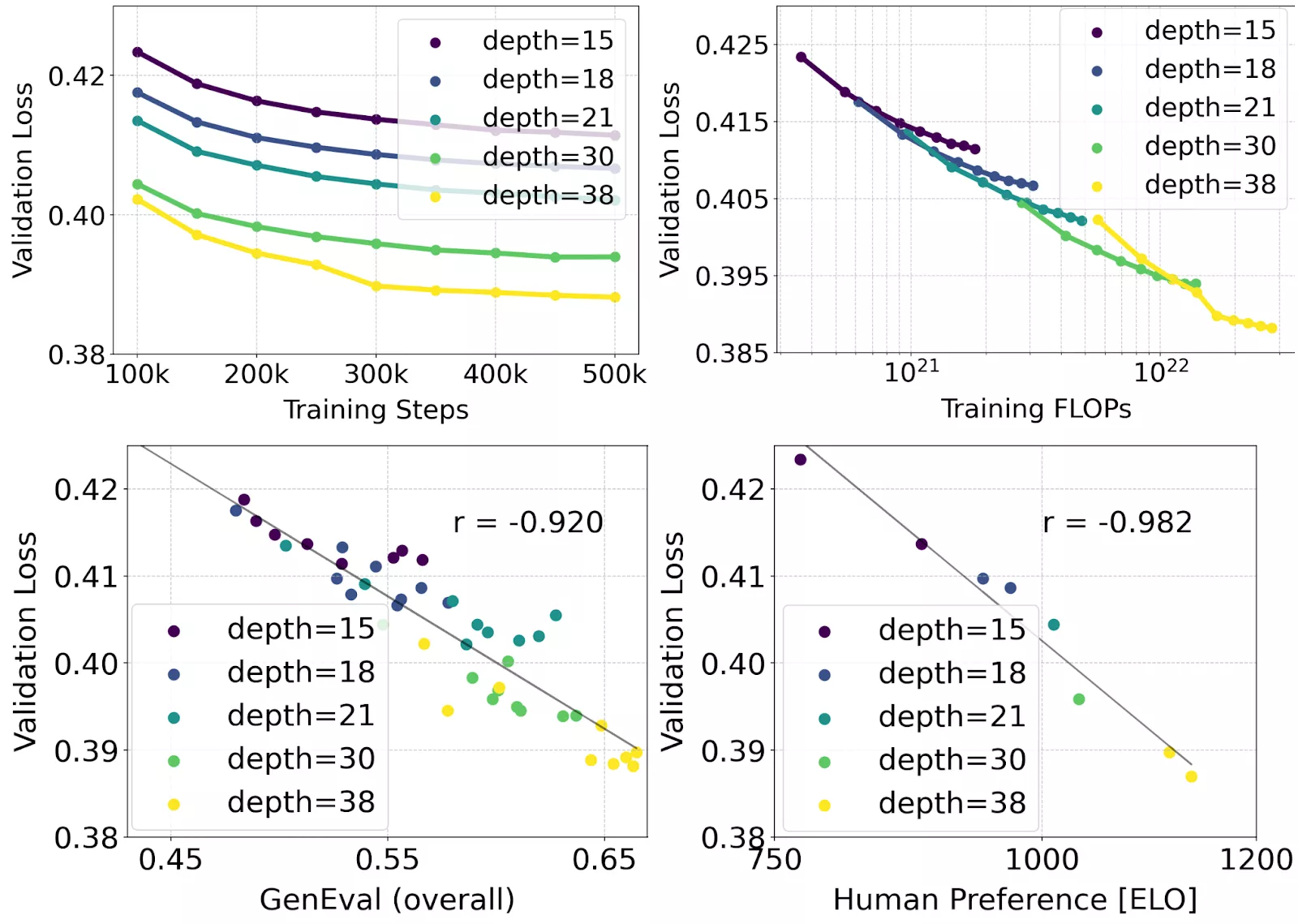

为了研究重新加权的修正流在文本到图像合成方面的扩展性,研究人员采用了MMDiT作为主干网络。研究人员训练了从15个区块、包含4.5亿参数的模型,到38个区块、拥有80亿参数的模型,并观察到随着模型大小和训练步骤的增加,验证损失呈现出平稳下降的趋势(上排)。为了检验这是否真正转化为模型输出的有意义改进,研究人员还评估了自动图像对齐指标(GenEval)以及人类偏好评分(ELO)(下排)。

结果表明,这些指标与验证损失之间存在强烈的相关性,这证实了验证损失是预测整体模型性能的有效指标。此外,扩展趋势没有显示出饱和的迹象,这让研究人员对未来继续提高模型性能充满了期待。

Rectified Flow主要特点:

- 改进数据生成过程:论文中提到,Rectified Flow通过在数据和噪声之间建立一条直线路径,简化了传统的扩散模型中复杂的数据生成过程。这种方法减少了迭代次数,提高了生成效率,使得模型能够在更短的时间内生成高质量的图像。

- 提高训练效率:通过引入Rectified Flow,论文中的模型在训练过程中更加高效。这不仅减少了计算资源的需求,还缩短了训练时间,使得模型能够更快地收敛到最优解。

- 提升图像质量:论文展示了Rectified Flow在生成高分辨率图像方面的优越性能。通过对比实验,作者证明了Rectified Flow模型在图像质量上超越了现有的一些先进模型,如SDXL和DALL-E 3。

- 优化噪声采样技术:论文中对现有的噪声采样技术进行了改进,通过偏向感知上相关的尺度来训练Rectified Flow模型。这种改进使得模型在生成图像时能够更好地捕捉细节和纹理,提高了图像的真实感。

- 多模态信息流:论文还提出了一种新的基于Transformer的架构,该架构允许图像和文本信息在网络内部双向流动。这种设计充分利用了Rectified Flow的特性,使得模型在处理文本到图像的转换任务时更加灵活和强大。

- 可扩展性:论文中的Rectified Flow模型展示了良好的可扩展性,可以通过增加模型的深度和宽度来提升性能。这种可扩展性为未来模型的进一步优化和扩展提供了可能性。

灵活的文本编码器

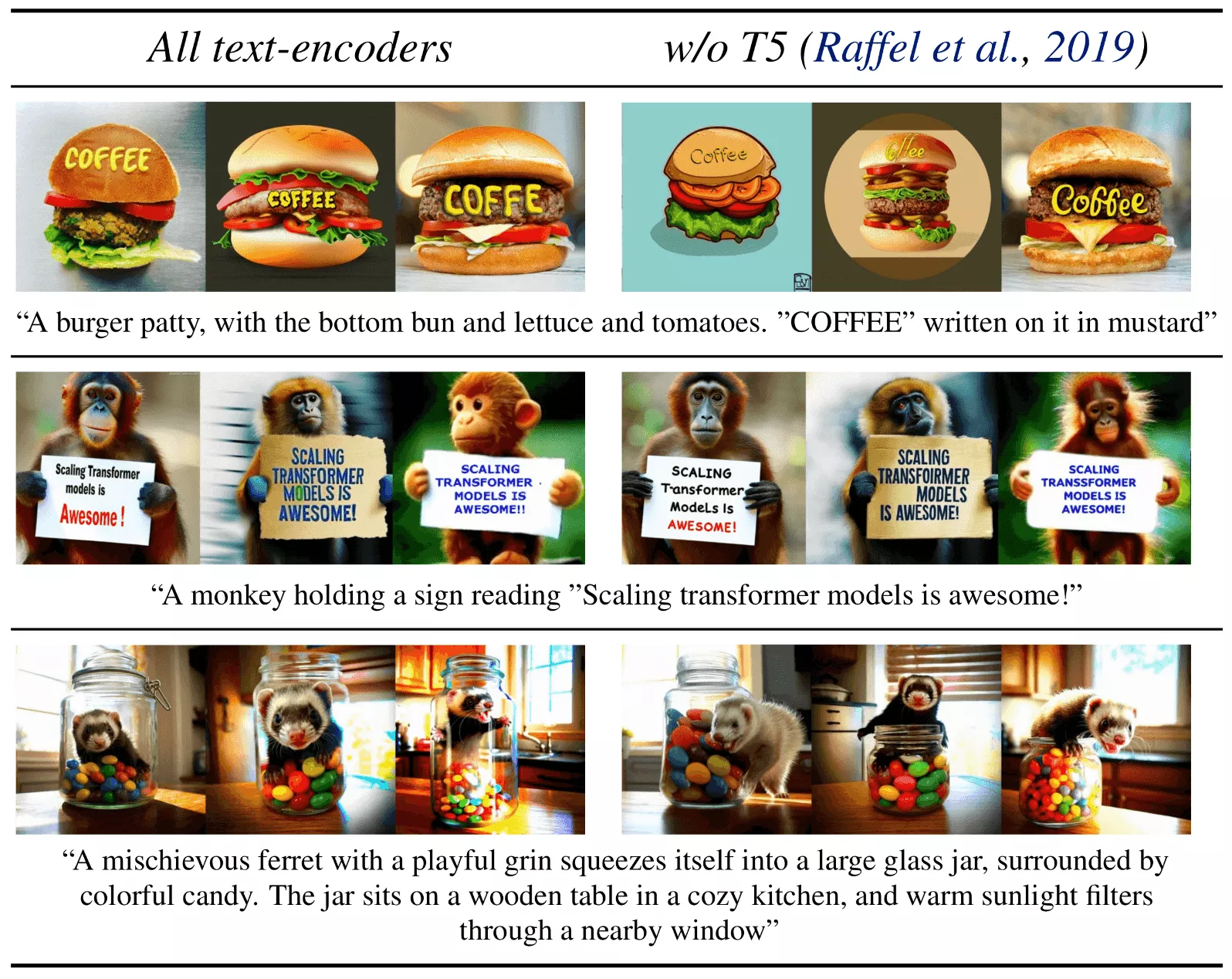

通过在推理阶段移除内存占用大的47亿参数T5文本编码器,SD3可以显著降低内存需求,而性能损失几乎可以忽略不计。移除这个文本编码器对视觉美学没有影响(无T5的胜率:50%),并且如上图中“性能”部分所示,仅会导致文本贴合度略有下降(胜率46%)。然而,若要充分发挥SD3在生成文字内容的能力,研究人员建议保留T5,因为在没有T5的情况下,研究人员发现排版生成的性能降幅较为显著(胜率降至38%),如下方示例所示:

相关文章