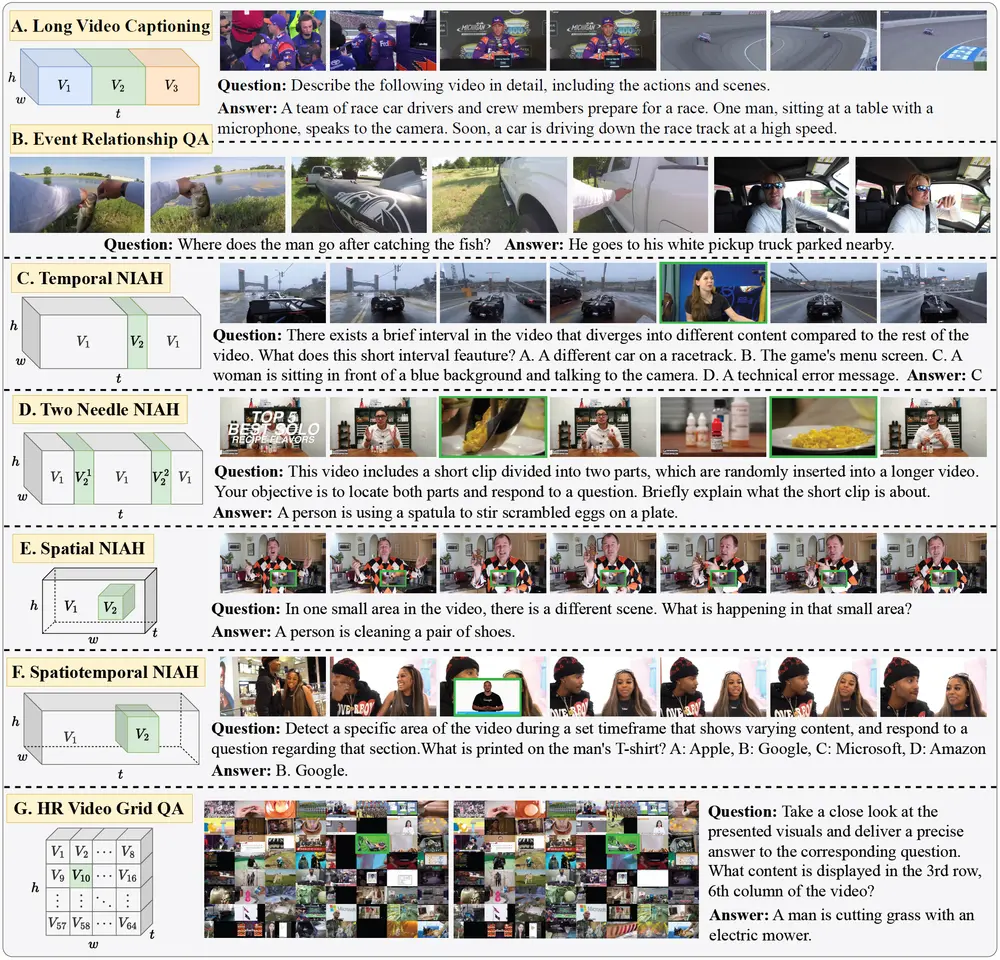

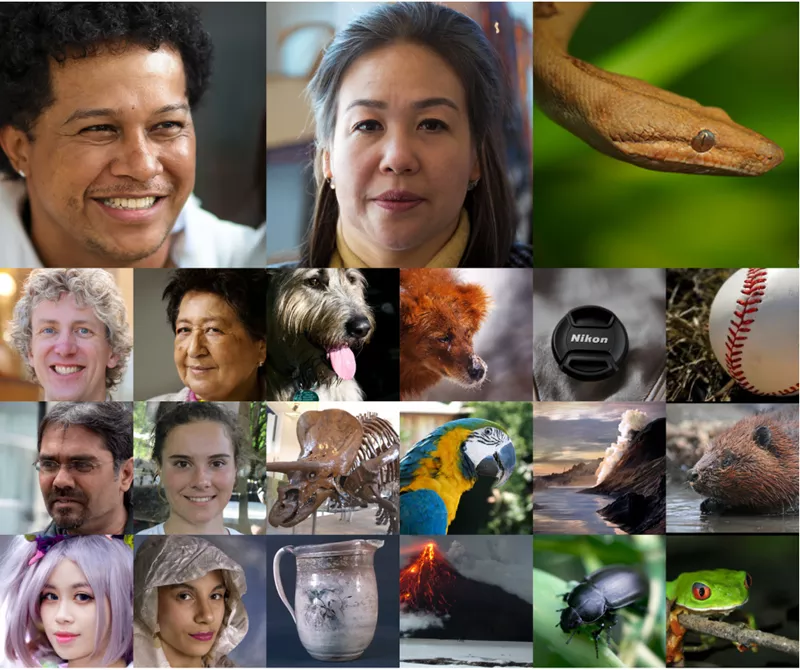

Stability AI、慕尼黑大学和Birchlabs的开发人员提出了一种名为Hourglass Diffusion Transformer(HDiT)的新型图像生成模型,该模型在保持高分辨率图像合成能力的同时,实现了线性(O(n))的计算复杂度增长,从而在像素空间直接生成图像。

HDiT模型基于Transformer架构,结合了Diffusion Transformers(DiT)和Hourglass Transformers的设计,使得模型能够在高分辨率下直接进行训练,而不需要依赖于多尺度架构、潜在自编码器或自条件化等技术。

项目主页:https://crowsonkb.github.io/hourglass-diffusion-transformers

特点:

- 线性复杂度: HDiT在目标分辨率增加时,计算复杂度保持线性增长,这使得模型能够扩展到高分辨率(例如1024x1024像素)的直接像素空间图像合成。

- 无需高分辨率特定训练技巧: HDiT能够在不使用渐进式增长或多尺度损失等高分辨率特定训练技巧的情况下,与现有模型在ImageNet 2562数据集上竞争。

- 高效的Transformer架构: HDiT通过引入Hourglass结构,有效地利用了Transformer的层次化特性,同时避免了全局自注意力机制的二次方复杂度。

- 直接在像素空间生成: HDiT能够在像素空间直接生成图像,而不需要依赖于潜在空间的表示,这简化了整体架构并提高了生成图像的质量。

实现方法:

- Hourglass结构: HDiT采用了Hourglass结构,这是一种层次化的Transformer架构,通过在不同分辨率层次上交替缩短和扩展序列长度来提高效率。

- 局部注意力机制: 在高分辨率层次上,HDiT使用局部注意力(如Neighborhood Attention)来处理细节,而在低分辨率层次上使用全局注意力来保持图像的全局一致性。

- 自适应位置编码: HDiT使用了自适应的旋转位置编码(RoPE),这是一种改进的位置编码方式,能够更好地处理图像的层次结构。

- 损失权重调整: HDiT采用了软最小信噪比(soft-min-snr)损失权重策略,以改善模型在不同噪声水平下的训练表现。

- 高效的Transformer块设计: HDiT的Transformer块设计采用了GEGLU激活函数,并在前馈网络中应用了自适应的缩放因子,以提高模型的稳定性和性能。

HDiT通过结合高效的Transformer架构和Diffusion模型,实现了在高分辨率下直接生成高质量图像的能力,同时保持了计算效率,为未来的图像生成发展提供了一个有前景的方向。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...