尽管AI模型在编程领域的应用日益广泛,甚至被大型科技公司视为提升开发效率的关键工具,但微软的一项新研究表明,即便是最先进的AI模型,在处理软件调试任务时仍面临显著挑战。这一发现为当前AI编码工具的能力设定了更为清晰的边界,同时也提醒开发者和企业不要过度依赖这些技术。

AI编码工具的现状与局限

谷歌首席执行官孙达尔·皮柴和Meta首席执行官马克·扎克伯格等科技领袖都曾对AI生成代码的潜力表示高度认可。例如,谷歌内部25%的新代码由AI生成,而Meta也在积极推广其AI编码工具的应用。然而,微软研究部门Microsoft Research的最新研究却揭示了一个令人清醒的事实:即便是一些顶级AI模型,在处理软件调试问题时的表现远未达到人类专家的水平。

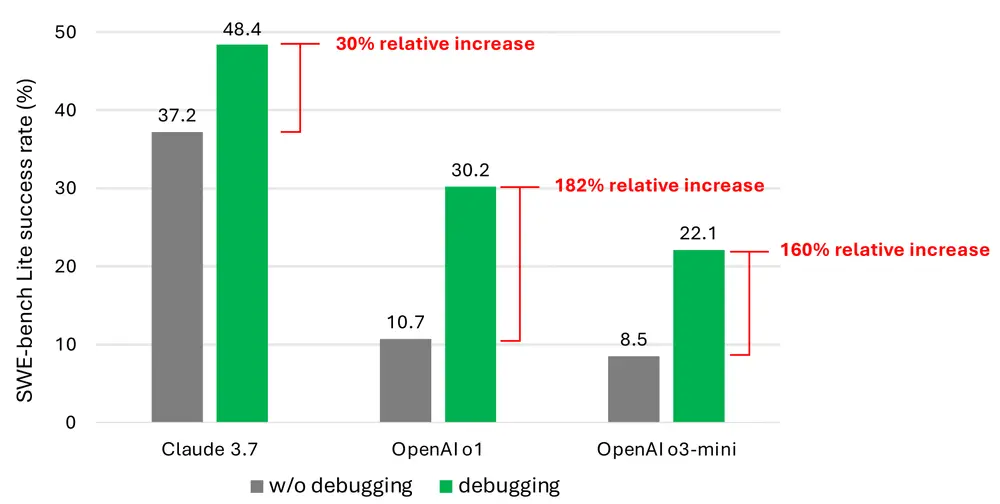

研究团队测试了包括Anthropic的Claude 3.7 Sonnet、OpenAI的o1和o3-mini在内的九种不同模型,要求它们解决SWE-bench Lite基准测试中的300个调试任务。结果显示,这些模型的成功率普遍较低:

Claude 3.7 Sonnet表现最佳,平均成功率为48.4%; OpenAI的o1紧随其后,成功率为30.2%; o3-mini则仅为22.1%。

值得注意的是,即使是表现最好的模型,也无法完成超过一半的任务。

问题的核心:数据匮乏与工具使用能力不足

研究指出,AI模型在软件调试中表现不佳的原因主要有两个方面:

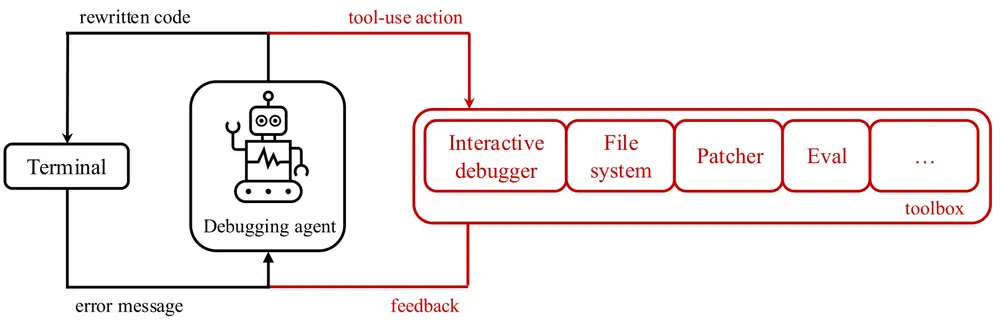

难以有效使用调试工具

即便这些模型可以访问Python调试器等工具,它们往往无法正确选择或操作适合特定问题的工具。这表明模型缺乏对工具适用性的理解。训练数据不足

研究合著者推测,当前模型的训练数据中缺乏足够的“顺序决策过程”数据——即记录人类在调试过程中如何逐步分析问题、尝试解决方案并最终修复漏洞的数据。这种数据的缺失限制了模型在复杂调试场景中的表现。

合著者在论文中写道:“我们坚信,通过专门训练或微调模型,可以让它们成为更强大的交互式调试工具。但这需要收集更多关于调试轨迹的数据,以帮助模型学习如何高效地分析和解决问题。”

AI生成代码的安全隐患

这项研究的结果并不孤立。此前已有研究表明,AI生成的代码往往存在安全隐患或逻辑错误。例如,对热门AI编码工具Devin的评估显示,它在20项编程测试中仅完成了3项任务。这些问题的根本原因在于,AI模型在理解复杂的编程逻辑和上下文关系方面仍然存在明显短板。

此外,AI生成代码的可维护性也引发了担忧。由于代码质量参差不齐,开发者可能需要花费额外的时间来审查和修复AI生成的内容,从而抵消了效率提升带来的优势。

行业领袖的反思:编程职业不会消失

尽管AI编码工具的能力有限,但这一领域仍然是投资和研发的重点方向。然而,越来越多的科技领袖开始质疑“AI将完全取代程序员”的观点。

微软联合创始人比尔·盖茨认为,编程作为一项职业将继续存在,并强调AI的作用是辅助而非替代人类开发者。Replit首席执行官Amjad Masad、Okta首席执行官Todd McKinnon和IBM首席执行官Arvind Krishna也持相似看法,他们认为AI工具的价值在于提高生产力,而不是完全自动化编程工作。

未来展望:AI与人类协作的必要性

微软的研究为AI编码工具的发展敲响了警钟,但它也指明了未来的改进方向。要让AI模型在软件调试和其他编程任务中表现得更加出色,关键在于以下几点:

丰富训练数据:收集更多关于人类调试过程的轨迹数据,帮助模型学习如何分析问题并提出解决方案。 增强工具使用能力:提高模型对调试工具的理解和操作能力,使其能够根据具体情况选择合适的工具。 优化人机协作:而非单纯追求自动化。AI应被视为开发者的助手,而不是完全替代品。

相关文章