宇树科技(Unitree)近日宣布开源其全新的机器人学习框架 —— UnifoLM-WMA-0,一个专为通用机器人学习设计的世界模型–动作(World Model–Action)架构。该模型跨越多种机器人本体形态,旨在通过构建对物理交互的深层理解,推动机器人从“执行指令”向“自主决策”迈进。

- 项目主页:https://unigen-x.github.io/unifolm-world-model-action.github.io

- GitHub:https://github.com/unitreerobotics/unifolm-world-model-action

- 模型:https://huggingface.co/unitreerobotics/UnifoLM-WMA-0

什么是 UnifoLM-WMA-0?

UnifoLM-WMA-0 是宇树科技在机器人感知与决策领域的重要探索成果。其核心是一个能够理解机器人与环境之间物理规律的世界模型。这一模型不仅模拟现实世界的动态变化,还能用于生成策略、优化控制,是实现具身智能的关键组件。

该架构支持两大核心功能:

1. 仿真引擎(Simulator Engine)

作为交互式模拟器运行,可根据当前状态和未来动作序列,生成高保真的视觉与物理反馈视频。

这为机器人训练提供了丰富的合成数据来源,大幅降低真实世界试错成本。

2. 策略增强(Policy Enhancement)

与策略网络中的“动作头”对接,利用对未来交互过程的预测,提前评估动作后果,从而优化决策路径。

这种“预演-反馈”机制显著提升了复杂任务下的鲁棒性与成功率。

技术实现路径

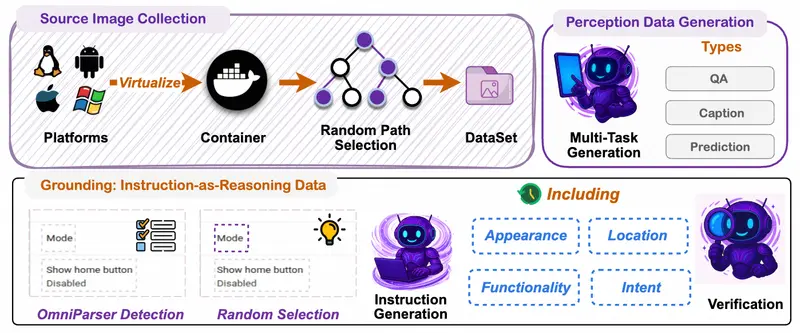

为了构建具备物理理解能力的世界模型,团队采用了以下关键技术流程:

微调视频生成模型

基于 Open-X 数据集 对视频生成模型进行微调,使其适应机器人操作场景。模型以 图像 + 文本指令 为输入,输出未来交互的视频序列,模拟任务执行全过程。

双模式运行架构

UnifoLM-WMA-0 支持两种运行模式:

- 决策模式:预测未来的物理交互,辅助策略网络生成更优动作

- 模拟模式:根据给定动作序列,生成逼真的环境响应视频,用于离线训练或验证

动作可控生成

在宇树自研的五个开源机器人数据集上完成训练后,模型展现出精确的动作条件生成能力。实验表明,系统可基于当前画面及指定动作,生成高度一致的后续交互视频。

长期交互生成能力

模型支持多步预测,可用于规划长时程任务,如连续整理物品、分步装配等,展现了良好的时间一致性与物理合理性。

实际应用表现

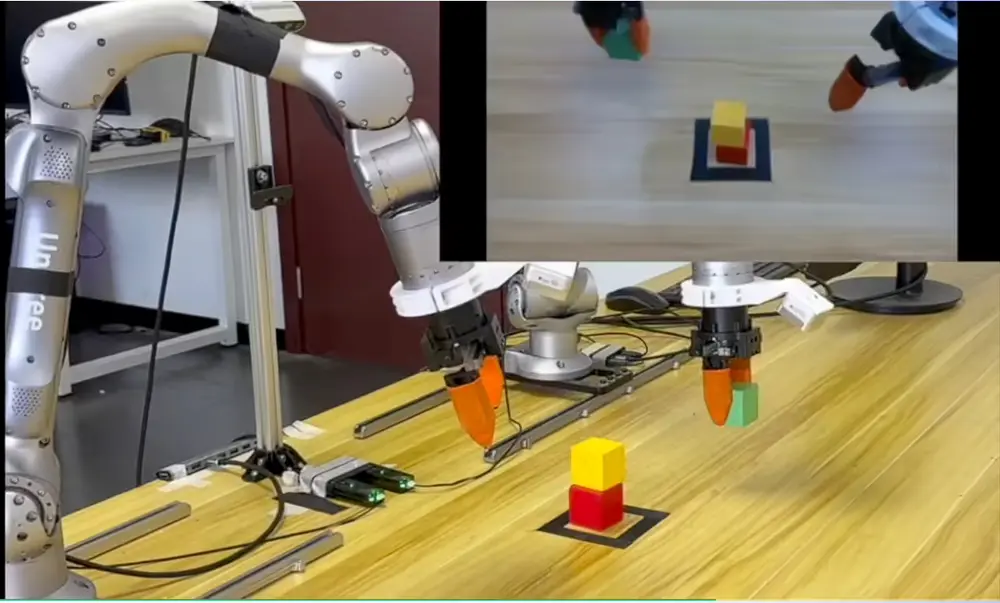

测试中,搭载 UnifoLM-WMA-0 的机器人成功完成了多项精细操作任务,包括:

- 将木块按红→黄→绿顺序叠放

- 整理散落的橡皮与笔

- 将黑色相机精准放入包装盒内

这些任务不仅要求空间感知能力,还需对物体间的接触力、摩擦、重力等物理特性有准确建模 —— 而这正是世界模型的价值所在。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)