大语言模型(LLM)的性能和泛化能力在很大程度上依赖于其预训练数据的质量和多样性。然而,传统的数据整理方法往往将质量和多样性视为独立的目标,先进行质量过滤,再平衡领域分布。这种顺序优化忽略了两者之间的复杂相互作用——高质量数据可能带有领域偏差,而多样化数据则可能降低整体质量。如何在有限的训练预算下同时优化这两个维度,成为提升模型性能的关键挑战。

为了解决这一问题,字节跳动推出了QuaDMix,一个全新的统一数据选择框架,旨在系统地平衡 LLM 预训练中的数据质量和多样性。通过结合多个质量标准和领域分类,QuaDMix 在多个基准测试中实现了平均7.2% 的性能提升,展示了联合优化策略的显著优势。

QuaDMix 的核心设计

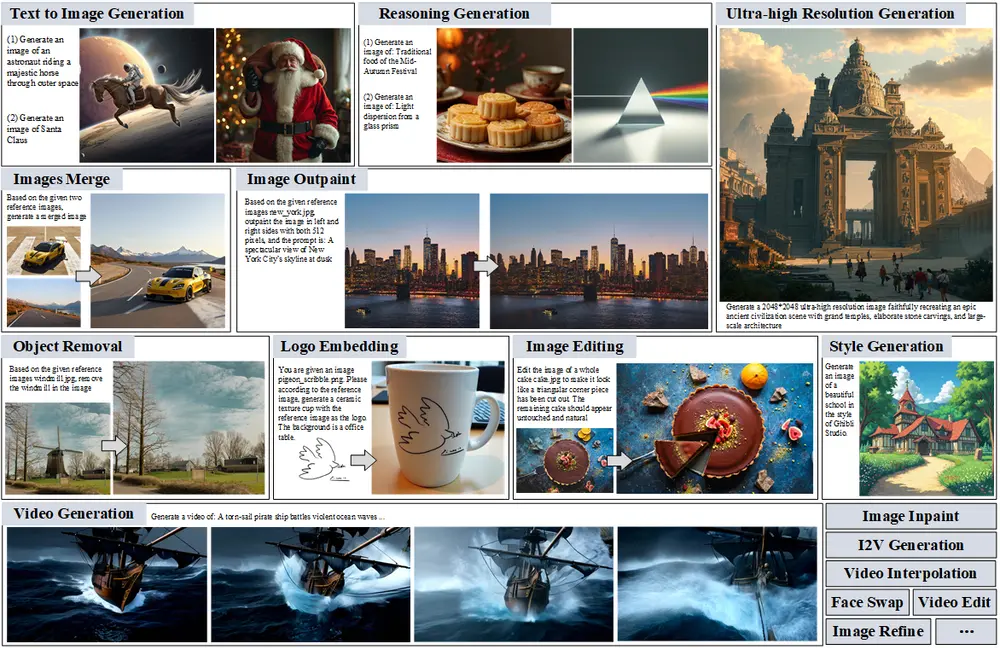

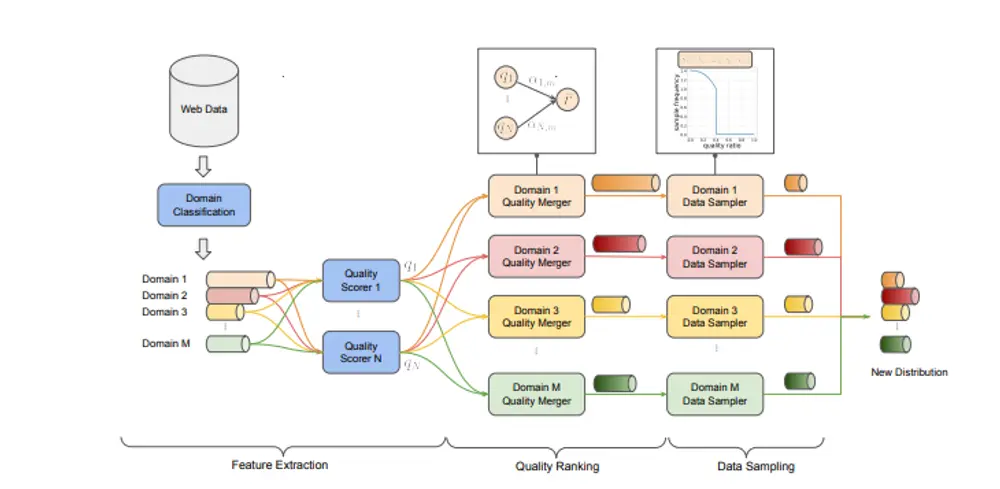

QuaDMix 的核心思想是将数据质量和多样性纳入一个统一的框架中,通过参数化函数动态调整每个样本的采样概率,从而实现两者的平衡。其工作流程分为三个主要阶段:

特征提取:每个文档都会被标注多个质量分数和领域标签。这些分数经过归一化处理后,结合特定领域的权重计算出一个聚合质量分数。 质量聚合:通过加权合并多个质量标准(如语义清晰度、语法正确性等),生成每个样本的综合质量评分。这种方法能够有效减少单一指标带来的偏差,提升整体评估的鲁棒性。 质量-多样性感知采样:使用基于 Sigmoid 函数的采样机制,在优先选择高质量样本的同时,通过参数化控制确保领域多样性。最终采样概率既反映了样本的质量,也考虑了领域分布的均衡性。

代理模型优化:高效探索高维参数空间

为了找到最优的采样配置,QuaDMix 引入了一种基于代理模型的优化方法:

大规模代理实验:在不同的参数设置下训练数千个小型代理模型,快速评估不同数据组合对下游任务的影响。 回归模型预测:基于这些代理实验的结果,使用 LightGBM 回归模型预测性能表现,从而识别最佳的采样参数配置。

这种方法避免了直接训练完整模型所需的高昂计算成本,同时能够高效探索高维参数空间,使数据选择更紧密地与预期的下游任务需求对齐。

实验结果与关键发现

研究团队在 RefinedWeb 数据集上验证了 QuaDMix 的效果,并从头开始训练了一个 5.3 亿参数的模型。与随机选择(Random Selection)、Fineweb-edu、AskLLM 等基线方法相比,QuaDMix 在九个不同的基准测试中取得了39.5% 的平均得分,明显优于其他方法。

以下是实验中的主要观察结果:

联合优化胜过孤立优化:联合优化数据质量和多样性始终优于单独关注某一维度的方法,证明了两者之间存在复杂的交互关系。 代理模型的可靠性:小型代理模型的性能与大规模模型高度相关,验证了基于代理优化的有效性。 任务特定优化的效果:针对特定下游任务优化的数据混合进一步提升了任务性能,表明 QuaDMix 的灵活性和适应性。 多质量标准的优势:合并多个质量标准不仅减少了单一指标的偏差,还提高了模型的整体鲁棒性。 多样性的边际效应:将 token 多样性扩展到一定阈值以上会产生递减收益,说明精心策划的质量比单纯追求数量更重要。

QuaDMix 的核心优势

统一优化质量与多样性:QuaDMix 将数据质量和多样性整合到一个框架中,解决了传统方法中两者割裂的问题。 任务导向的数据选择:通过代理模型评估目标,QuaDMix 能够根据特定下游任务的需求优化数据选择。 高效的计算资源利用:基于代理模型的优化方法显著降低了计算成本,无需进行详尽的大规模训练。 持续提升下游性能:在不增加计算预算的情况下,QuaDMix 能够持续提升模型在多种任务中的表现。

未来展望

尽管 QuaDMix 已经取得了令人瞩目的成果,但研究团队指出,未来仍有改进空间:

完善参数空间:当前的参数化函数可以进一步优化,以更好地捕捉质量和多样性之间的复杂关系。 提高代理模型的保真度:提升代理模型对大规模模型性能的预测精度,有助于更准确地指导数据选择。 扩展应用场景:将 QuaDMix 应用于更多类型的模型和任务,例如多模态模型或领域特定模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...