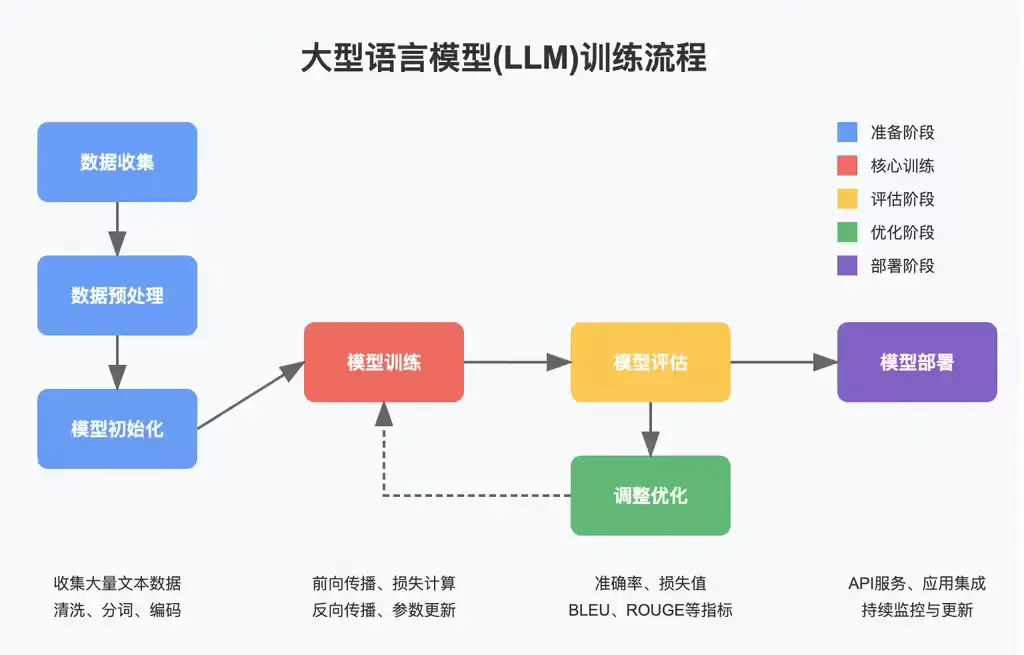

近年来,基于大语言模型(LLM)的多智能体系统在多个领域展现出强大的能力,包括代码生成、数学推理、机器人技术和聊天机器人等。然而,这些系统的设计往往依赖于手动配置,导致高昂的人力成本和有限的可扩展性。

为了解决这一问题,来自 Sea AI Lab、中国科学院大学、新加坡国立大学和上海交通大学 的研究人员提出了一种创新方法——FlowReasoner,一种查询级元代理,能够根据每个用户的独特需求动态生成个性化的多智能体系统。

背景与挑战

传统的多智能体系统尽管功能强大,但存在以下主要问题:

手动设计成本高:当前的多智能体系统通常需要人工设计工作流程,耗费大量时间和资源。 缺乏灵活性:现有的“一刀切”方法难以适应不同用户的具体需求。 可扩展性有限:基于图或编程代码的方法虽然尝试自动化工作流程设计,但其复杂性限制了系统的扩展能力。

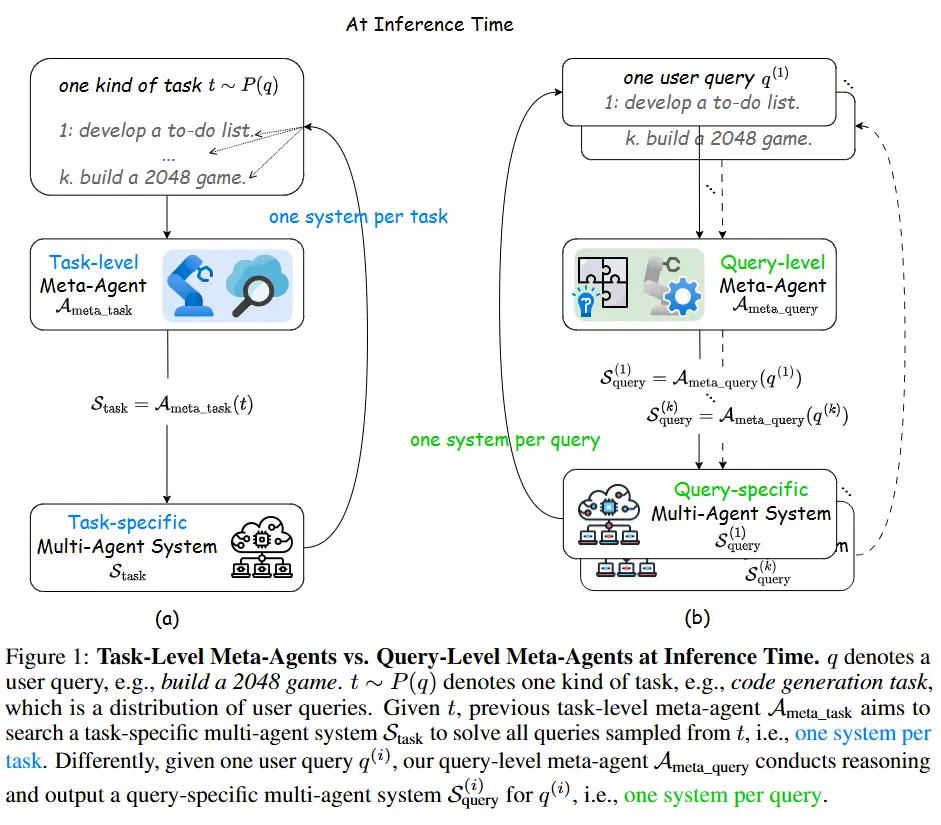

此外,尽管一些最先进的方法(如 Aflow、ADAS 和 MaAS)通过搜索或优化技术提升了自动化水平,但它们仍然专注于任务级解决方案,无法针对每个查询进行个性化调整。

为应对这些挑战,研究人员提出了 FlowReasoner,旨在通过强化学习和外部执行反馈,为每个用户查询生成定制化的多智能体系统。

FlowReasoner 的核心特点

1. 查询级元代理

FlowReasoner 是一种查询级元代理,能够在每次接收到用户查询时,动态生成一个优化的多智能体系统。这种方法避免了传统系统中固定的、通用的工作流程设计,转而根据具体需求生成个性化方案。

2. 强化学习与外部执行反馈

FlowReasoner 的训练过程结合了 强化学习 和 外部执行反馈,使其能够不断优化生成的工作流程。研究人员开发了一种多用途奖励机制,重点优化三个关键维度:

性能:确保生成的系统能够高效完成任务。 复杂性:避免生成过于复杂的工作流程,降低资源消耗。 效率:提高系统的运行速度和响应能力。

3. 无需复杂搜索算法

与现有方法不同,FlowReasoner 不依赖复杂的搜索算法或精心设计的搜索集,而是通过深度学习模型直接生成优化的工作流程,从而显著降低了计算开销。

实验与评估

为了验证 FlowReasoner 的效果,研究人员选择了三个数据集进行详细评估:

BigCodeBench:用于工程导向的任务。 HumanEval 和 MBPP:用于算法挑战的代码生成场景。

FlowReasoner 与以下三类基线进行了对比:

单模型直接调用:使用独立 LLM(如 GPT-4o-mini 或 o1-mini)直接完成任务。 手动设计的工作流程:包括 Self-Refine、LLM-Debate 和 LLM-Blender 等方法。 自动化工作流程优化方法:如 Aflow、ADAS 和 MaAS。

实验结果表明:

FlowReasoner-14B 的性能优于所有竞争方法,总体性能比最强基线(MaAS)高出 5 个百分点。 相较于其底层工作模型 o1-mini,FlowReasoner 的性能提升高达 10%。 在泛化能力测试中,当工作模型替换为 Qwen2.5-Coder、Claude 或 GPT-4o-mini 时,FlowReasoner 依然表现出显著的迁移能力,保持了稳定的性能。

FlowReasoner 的优势

个性化生成

FlowReasoner 能够根据每个用户的查询动态生成优化的工作流程,避免了传统系统中固定设计的局限性。高效且灵活

通过强化学习和外部执行反馈,FlowReasoner 在性能、复杂性和效率之间实现了平衡,生成的系统更加高效且易于扩展。降低人力成本

自动化生成工作流程的过程大幅减少了对人工设计的依赖,降低了开发和维护成本。广泛的适用性

FlowReasoner 的迁移能力使其能够适配不同的工作模型,适用于多种应用场景,包括代码生成、算法推理和复杂任务规划。

未来展望

FlowReasoner 的提出标志着多智能体系统设计迈向了一个新的阶段。未来的研究方向可能包括:

更广泛的应用场景:将 FlowReasoner 应用于更多领域,如自然语言处理、医疗诊断和金融建模。 进一步优化性能:探索更高效的强化学习算法和奖励机制,以进一步提升生成系统的性能。 实时交互能力:增强 FlowReasoner 的实时交互能力,使其能够动态调整工作流程以适应变化的用户需求。

相关文章