插件LM Studio Nodes for ComfyUI为 ComfyUI 提供了一套自定义节点,通过官方 lmstudio Python SDK 深度集成 LM Studio 的功能。它允许您在 ComfyUI 工作流中直接利用本地运行的模型进行各种生成任务。

节点提供以下功能:

- 统一生成:支持基于文本提示、图像提示或两者结合生成文本。

- 图像到文本:使用视觉模型生成图像的详细文本描述。

- 文本生成:基于给定提示使用语言模型生成文本,支持流式输出。

- 模型管理:列出可用模型、将模型加载到内存(带 TTL)以及卸载模型。

- 模型选择:根据类型(LLM/视觉)和文本过滤器动态选择模型。

- 设置辅助:辅助节点用于检查 SDK 安装、列出模型和提供下载指导。

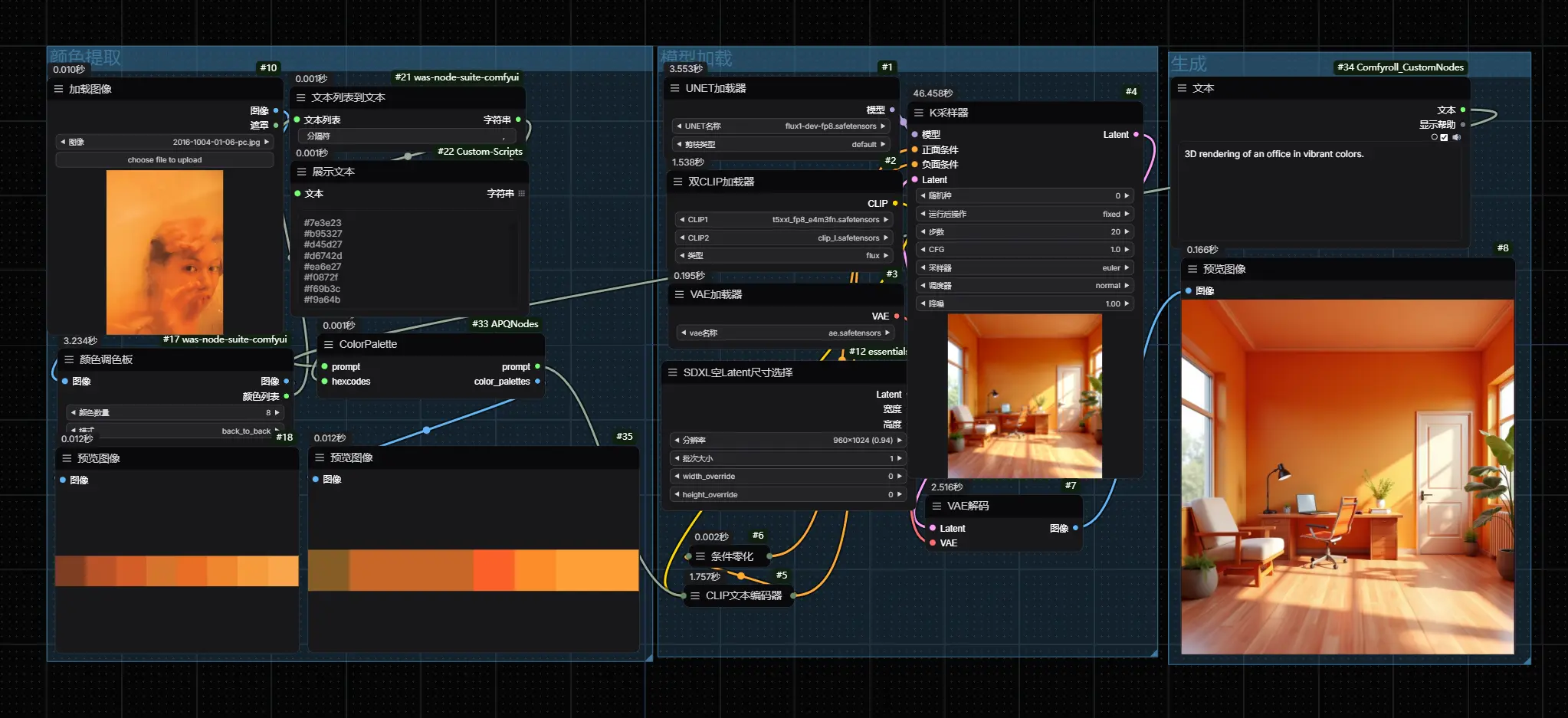

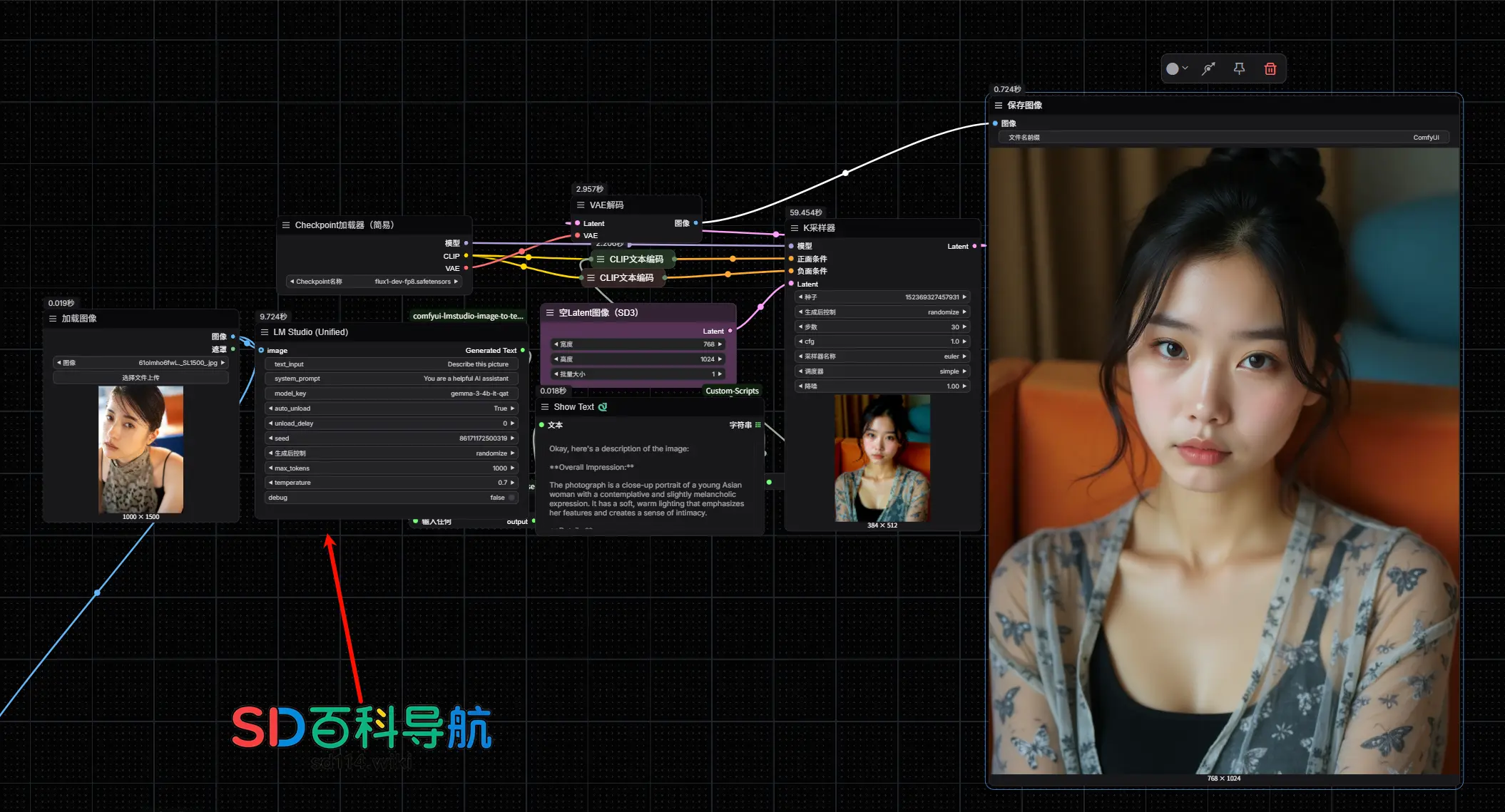

工作流示例

以下是 LM Studio 节点在 ComfyUI 工作流中的使用示例:

功能特性

- 使用官方

lmstudioPython SDK,确保稳健的连接和交互。 - 支持纯文本、纯图像(视觉)以及文本+图像组合输入。

- 使用

model_key字符串(如llama-3.2-1b-instruct)标识模型。 - 提供专用节点处理特定任务(图像到文本、文本生成)。

- 包含用于管理模型内存的节点(加载/卸载/列出)。

- 提供动态模型选择器节点,便于工作流构建。

- 设置节点提供 SDK 安装和获取模型的指导。

- 可自定义系统提示以设置上下文。

- 可控制生成参数,如

max_tokens、temperature和seed。 - 文本生成节点支持可选的流式输出。

- 支持调试模式,提供详细的控制台日志记录。

- 自动连接到 LM Studio 服务器(无需在节点中指定 IP/端口)。

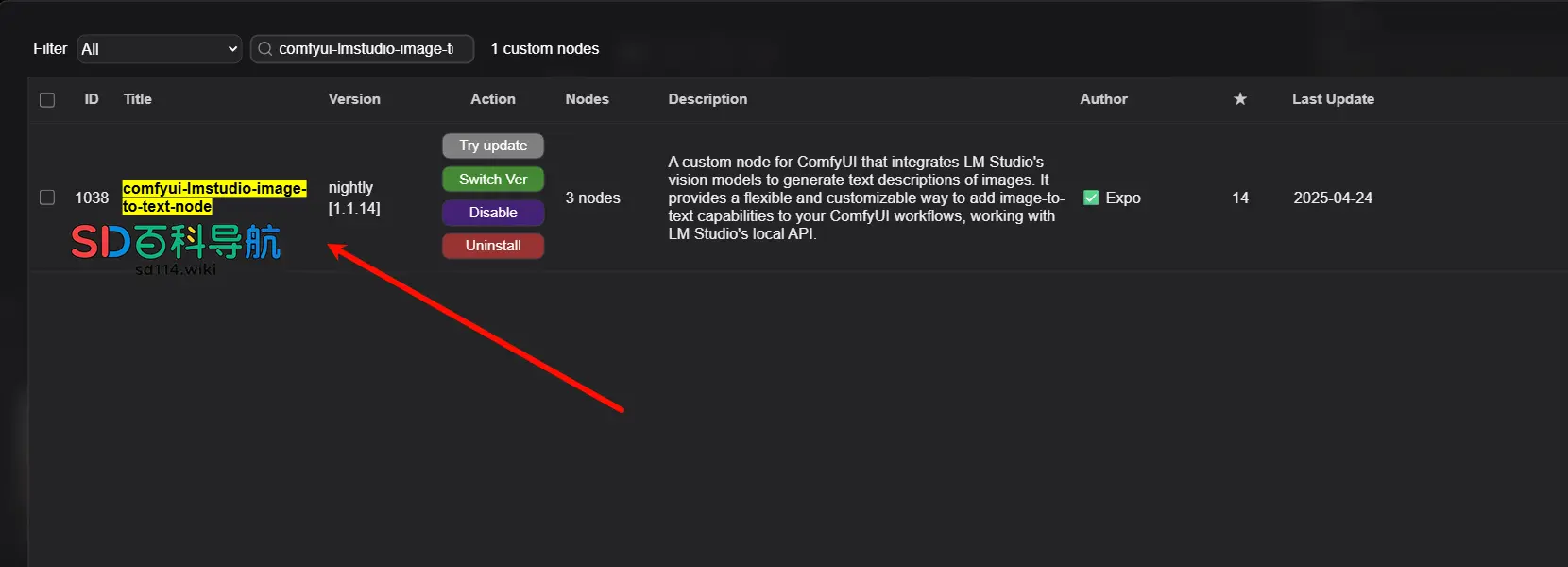

安装方法

通过ComfyUI Manager进行安装,搜索“comfyui-lmstudio-image-to-text-node”点击安装,安装后重启ComfyUI即可使用。

使用方法

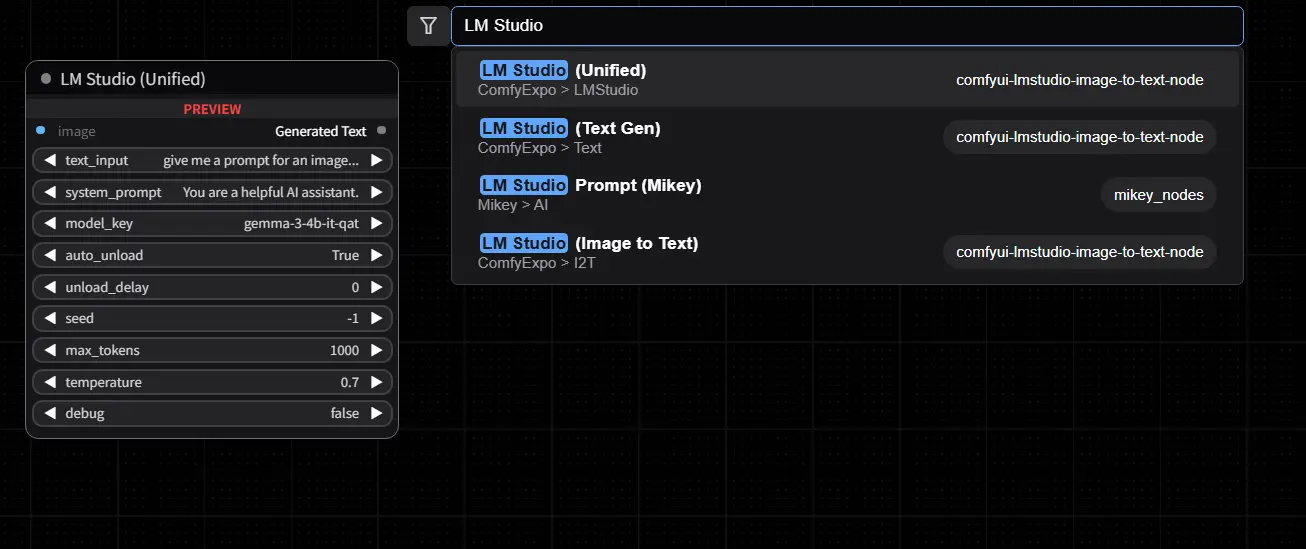

通过右键单击画布并搜索节点名称(例如“LM Studio Unified (Expo)”)将节点添加到工作流。

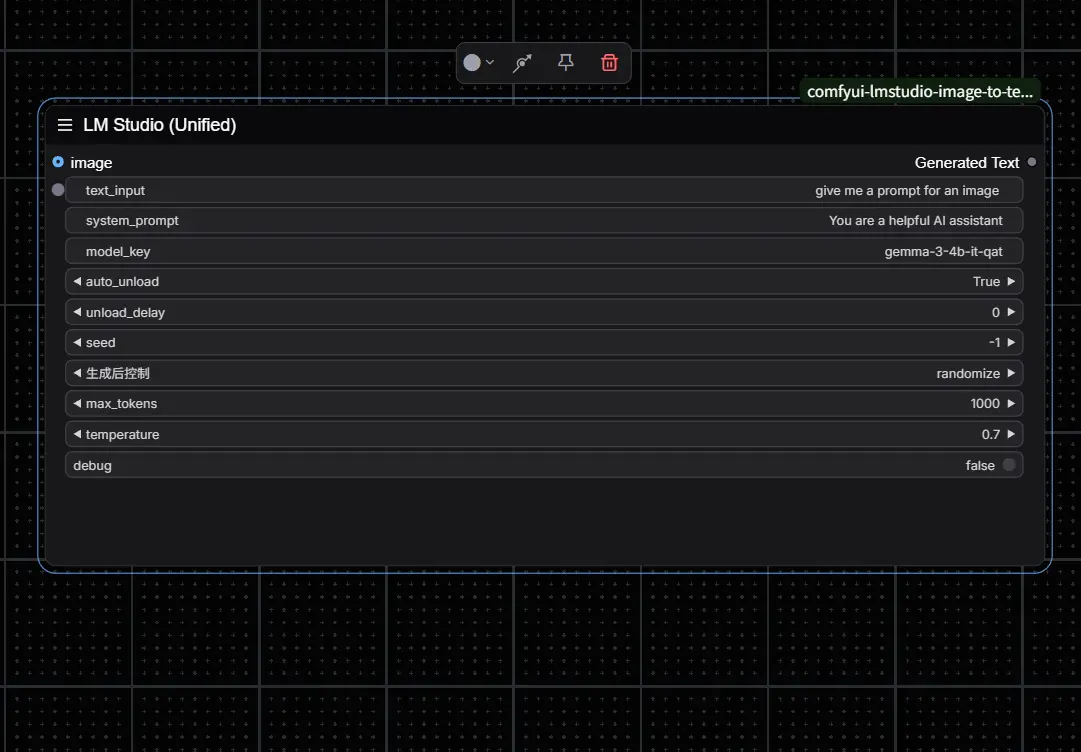

LM Studio Unified (Expo)

处理纯文本、纯图像或文本+图像组合的生成。

输入:

model_key(字符串,必填):使用的 LM Studio 模型关键字(如llama-3.2-1b-instruct或视觉模型关键字)。默认:llama-3.2-1b-instruct。system_prompt(字符串,必填):AI 的系统提示。默认:“您是一个乐于助人的 AI 助手。”seed(整数,必填):用于可重复性的种子(-1 表示随机)。默认:-1。image(图像,可选):输入图像(需要支持视觉的model_key)。text_input(字符串,可选):文本提示。默认:“”。max_tokens(整数,可选):响应的最大令牌数。默认:1000。temperature(浮点数,可选):生成温度。默认:0.7。debug(布尔值,可选):启用控制台日志记录。默认:False。

输出:

- 生成文本(字符串):模型的响应。

(注:必须提供 image 或 text_input 中的至少一个才能运行节点。)

LM Studio I2T (Expo)

使用视觉模型为图像生成文本描述。

输入:

model_key(字符串,必填):支持视觉的 LM Studio 模型关键字。默认:qwen2-vl-2b-instruct。system_prompt(字符串,必填):AI 的系统提示。默认:“这是一个用户与助手之间的对话。助手是描述图像的专家,注重细节和准确性。”seed(整数,必填):用于可重复性的种子(-1 表示随机)。默认:-1。image(图像,必填):需要描述的输入图像。user_prompt(字符串,可选):关于图像的提示。默认:“详细描述此图像。”max_tokens(整数,可选):响应的最大令牌数。默认:1000。temperature(浮点数,可选):生成温度。默认:0.7。debug(布尔值,可选):启用控制台日志记录。默认:False。

输出:

- 描述(字符串):生成的文本描述。

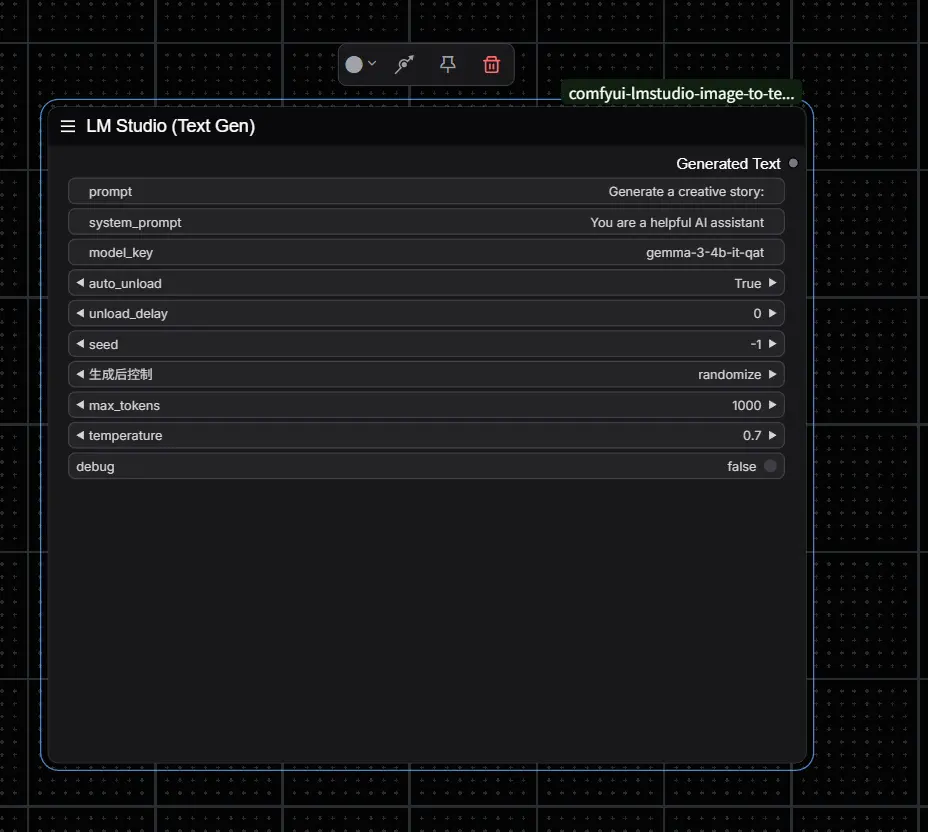

LM Studio Text Gen (Expo)

基于文本提示使用语言模型生成文本。

输入:

model_key(字符串,必填):LM Studio 语言模型的关键字。默认:llama-3.2-1b-instruct。system_prompt(字符串,必填):AI 的系统提示。默认:“您是一个乐于助人的 AI 助手。”seed(整数,必填):用于可重复性的种子(-1 表示随机)。默认:-1。prompt(字符串,可选):用于文本生成的输入提示。默认:“生成一个创意故事:”。max_tokens(整数,可选):响应的最大令牌数。默认:1000。temperature(浮点数,可选):生成温度。默认:0.7。stream_output(布尔值,可选):流式输出响应片段(注:ComfyUI 中的最终输出仍为完整文本)。默认:False。debug(布尔值,可选):启用控制台日志记录。默认:False。

输出:

- 生成文本(字符串):生成的文本。

(注:需要非空的 prompt 才能运行。)

LM Studio Model Mgr (Expo)

通过 LM Studio SDK 管理加载的模型。

输入:

action(下拉菜单,必填):执行的操作(列出、加载、卸载)。默认:列出。model_key(字符串,可选):要加载或卸载的模型关键字。加载/卸载时必填。默认:“”。model_type(下拉菜单,可选):按类型过滤模型(全部、LLM、嵌入)。默认:全部。load_ttl(整数,可选):加载模型的存活时间(秒),即最后使用后保留在内存中的时间。用于加载操作。默认:3600。debug(布尔值,可选):启用控制台日志记录。默认:False。

输出:

- 结果(字符串):确认消息或模型列表。

LM Studio Model Sel (Expo)

根据过滤器动态提供模型关键字,便于连接到其他节点。

输入:

model_type(下拉菜单,必填):列出的模型类型(LLM、视觉)。默认:LLM。filter_text(字符串,可选):用于过滤模型名称/关键字的文本。默认:“”。

输出:

- 模型关键字(字符串):按字母顺序排序的第一个匹配模型的

model_key,若无匹配则返回默认值。

(注:此节点在工作流加载时尝试列出 SDK 可用的模型。构建工作流时确保 LM Studio 服务器正在运行。)

LM Studio Setup (Expo)

提供与 SDK 设置和模型发现相关的辅助操作。

输入:

action(下拉菜单,必填):执行的操作(安装 SDK、获取模型、列出模型)。默认:列出模型。model_key(字符串,必填):与操作相关的模型关键字(用于获取模型)。默认:llama-3.2-1b-instruct。

输出:

- 结果(字符串):状态消息、命令指导或模型列表。

(注:安装 SDK 尝试运行 pip install lmstudio。获取模型 提供使用 lms CLI 工具的说明。)

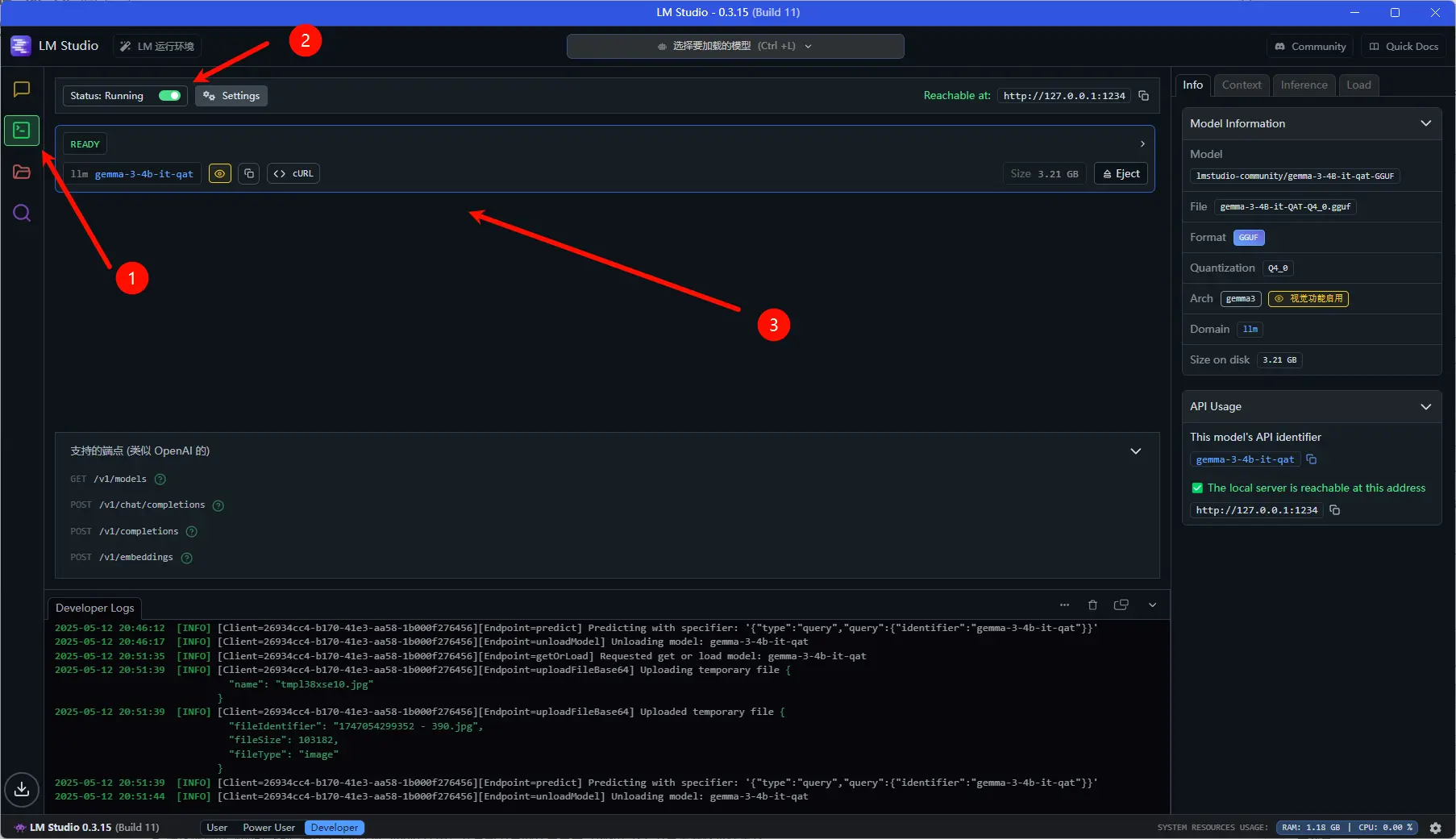

LM Studio 设置

- 在您的机器上安装并运行 LM Studio。

- 在 LM Studio 中下载所需模型(确保为图像任务下载视觉模型)。

- 转到 LM Studio 的“服务器”选项卡(图标为

<->)。 - 选择要加载的模型并点击“启动服务器”。

- LM Studio 服务器必须保持运行状态,以便 ComfyUI 节点能够连接和正常工作。

注意事项

- 这些节点使用官方

lmstudioPython SDK,自动处理与运行中的 LM Studio 服务器的连接(通常为localhost:1234)。无需在节点中输入 IP/端口。 - 使用 LM Studio 中找到的

model_key(如Org/ModelName-Format)作为model_key输入的标识符。 seed输入允许生成可重复的输出。设置为 -1 时每次运行使用随机种子。- SDK 使用

这些节点利用官方 lmstudio Python SDK,取代了之前直接通过 OpenAI 兼容 API 端点交互的方式,提供了更稳健的集成和 SDK 特定功能访问。

故障排除

如果遇到任何问题:

- 在相关节点上启用

debug输入(设置为 True)。 - 检查 ComfyUI 控制台中的错误消息和节点的详细调试输出。

- 验证 LM Studio 应用程序是否正在运行,并且服务器已启动并加载了模型。

- 确保提供的

model_key存在于您的 LM Studio 库中,并且与节点的任务兼容(例如,I2T 节点需要视觉模型)。 - 确认

lmstudioPython 包已正确安装在您的 ComfyUI 环境中。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...