ComfyUI LLM Toolkit是一个专为 ComfyUI 打造的自定义节点集合,旨在将多种大语言模型(包括云端和本地模型)无缝集成到工作流中。无论是文本生成、图像创作,还是未来的视频生成,这款工具都能为你提供灵活且高效的解决方案。

核心功能

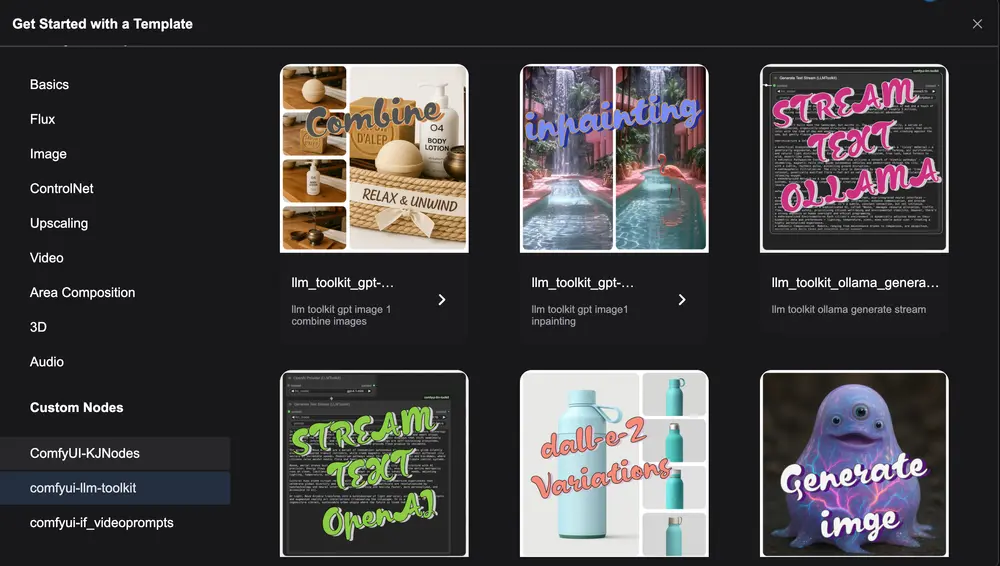

多模型支持:支持多种 LLM 提供商,包括 OpenAI(云端)和 Ollama(本地),并计划扩展更多提供商。 上下文传递设计:使用单一“context”输入/输出架构,确保数据在节点之间高效流动,极大提升工作流的灵活性。 独立运行能力:文本和图像生成器等节点无需连接即可单独运行,方便快速测试和迭代。 流式内容输出:节点界面上直接显示流式输出,便于实时监控生成过程。 模板与配置管理:内置多种模板,支持动态获取模型列表,并允许用户通过 .env文件或界面直接管理 API 密钥。强大的图像生成功能:利用 OpenAI 的最新 gpt-image-1 模型,支持基于文本生成图像、根据参考图像编辑等功能。

安装与配置

安装步骤

1、将项目克隆到 ComfyUI 的 custom_nodes 目录:

cd /path/to/ComfyUI/custom_nodes

git clone https://github.com/yourusername/comfyui-llm-toolkit.git2、安装依赖项:

cd comfyui-llm-toolkit

pip install -r requirements.txt3、重启 ComfyUI 即可加载新节点。

配置 API 密钥

API 密钥可以存储在根目录下的 .env 文件中:

OPENAI_API_KEY=your_openai_key

# 根据需要添加其他提供商的密钥

或者,你也可以直接在节点界面中输入 API 密钥。

使用方法

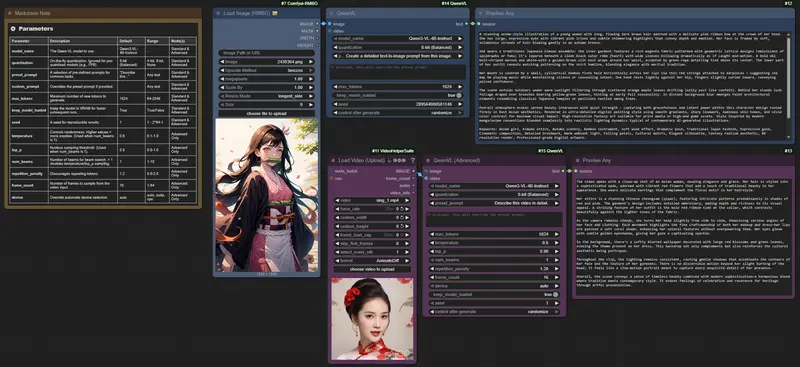

LLM 提供商选择器节点

功能:选择 LLM 提供商和模型。 特点: 动态更新可用模型列表。 根据提供商需求,自动显示或隐藏 IP 和端口字段。 输出包含提供商配置的“context”。

生成文本节点

功能:基于所选模型生成文本。 操作步骤: 将该节点与 LLM 提供商选择器节点通过“context”端口连接。 节点会自动检测输入中的提供商配置。 可通过下拉菜单覆盖默认模型。

输出:“context”中包含原始输入数据和 LLM 响应。

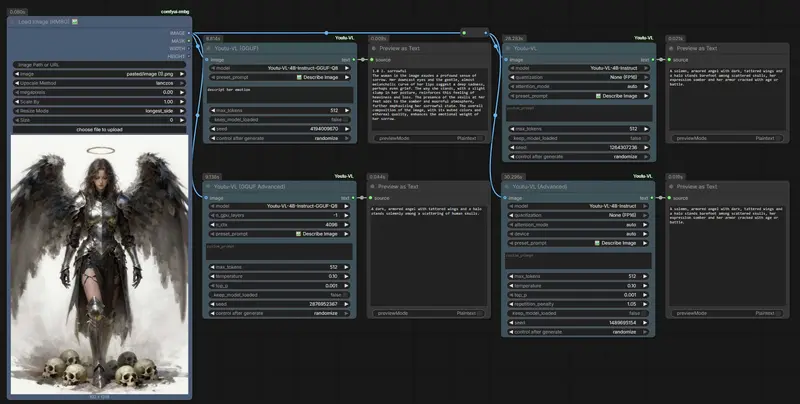

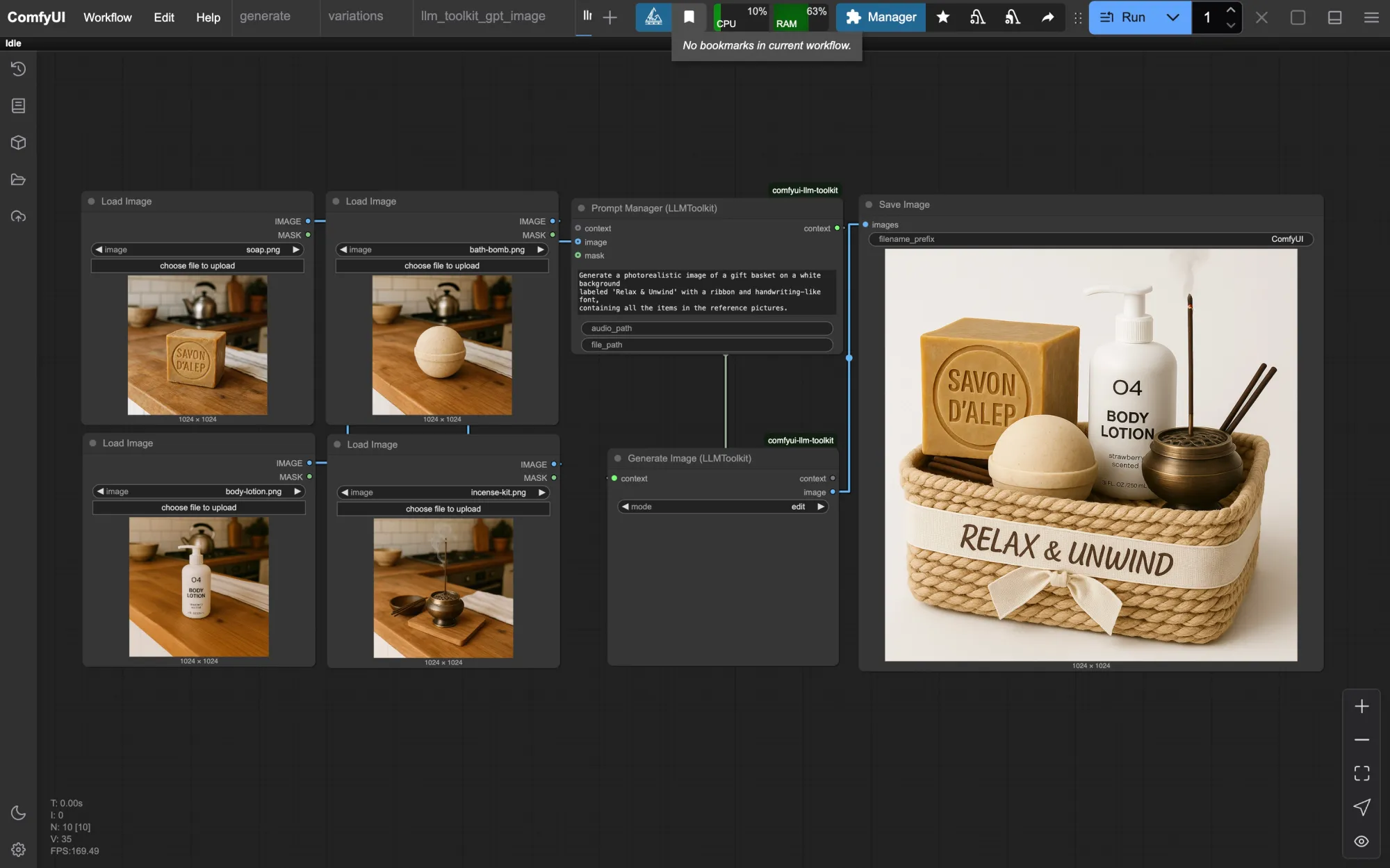

生成图像节点

功能:利用 OpenAI 的 gpt-image-1 模型生成或编辑图像。 特点: 支持基于文本生成图像。 支持根据参考图像进行编辑,例如蒙版区域修改。 提供多种模板,可在 LLM Toolkit 的模板浏览器中找到。

提示优化:gpt-image-1 对提示质量高度依赖,建议明确描述任务。

单输入/单输出架构的优势

ComfyUI LLM Toolkit 采用统一的“context”输入/输出架构,具有以下优势:

单一连接点:每个节点只有一个名为“context”的输入和输出,简化了连接逻辑。 智能数据处理:节点从“context”中提取所需信息,并将自身生成的数据追加到输出中。 级联数据流:数据在节点间流动时逐步累积,确保整个工作流的信息完整性。

示例工作流:节点 A → B → C

节点 A 创建包含提供商配置的“context”。 节点 B 接收 A 的“context”,提取配置并生成 LLM 响应,追加到“context”中。 节点 C 接收 B 的“context”,此时已包含所有上游数据。

这种设计允许:

链式执行多个 LLM 操作。 在整个工作流中保留和累积数据。 轻松与其他 ComfyUI 节点集成。

支持的提供商

OpenAI(默认模型:gpt-4o-mini) 支持文本生成和图像生成(gpt-image-1、DALL-E 系列)。

Ollama(本地模型) 提供完全隐私的本地推理能力。

更多提供商即将推出...

故障排除

如果遇到问题,请尝试以下步骤:

模型列表未更新: 确保 ComfyUI 正确配置服务器。 检查浏览器是否启用了 JavaScript。 验证 .env文件中的 API 密钥是否正确。

导入错误: 确保已安装所有依赖项: pip install -r requirements.txt。确认自定义节点放置在正确的目录中。 安装后重启 ComfyUI。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...