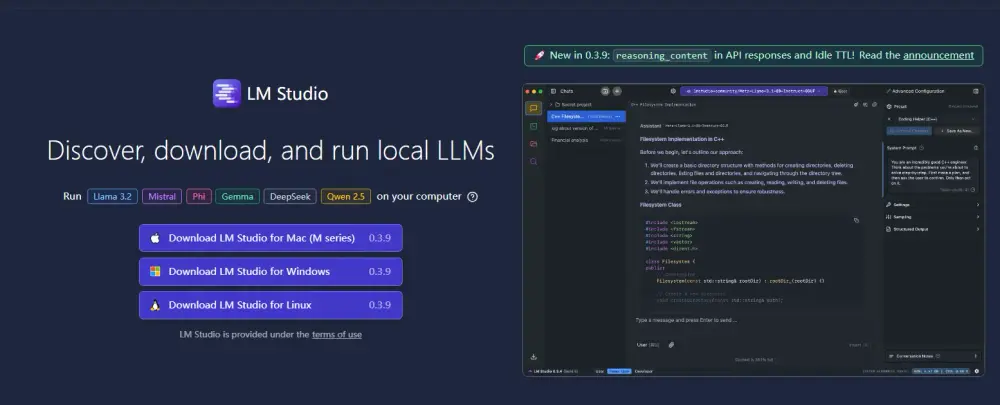

在本地运行大语言模型(LLMs)不仅可以保护数据隐私,还能避免网络延迟,提升使用体验。今天,我们来介绍一款开源程序——LM Studio,它可以帮助你在本地轻松运行和实验各种开源大语言模型。

什么是 LM Studio?

LM Studio 是一款跨平台的桌面应用程序,专为个人用户设计,支持在本地运行开源大语言模型。它提供了简单而强大的模型配置和推理界面,允许用户从 Hugging Face 下载并运行 ggml Llama、MPT 和 StarCoder 兼容的模型。LM Studio 的一大亮点是能够利用显卡加速,提升模型运行效率。

主要功能

- 桌面应用程序:用于运行本地 LLM,支持 macOS、Windows 和 Linux 系统。

- 熟悉的操作界面:提供类似聊天应用的界面,方便用户与模型交互。

- 模型搜索与下载:通过 Hugging Face 搜索和下载模型。

- 本地服务器功能:可以监听类似 OpenAI 端点的本地服务器。

- 模型管理:提供系统用于管理本地模型和配置。

- 隐私保护:完全离线运行,数据不会上传到任何服务器。

系统要求

LM Studio 支持以下系统:

- macOS:Apple Silicon Mac

- Windows:x64/ARM64 架构

- Linux:x64 架构

注意事项

目前,LM Studio 的一个缺点是强制安装在 C 盘,对于 C 盘空间不足的用户可能不太友好。不过,它的其他功能足以弥补这一不足。

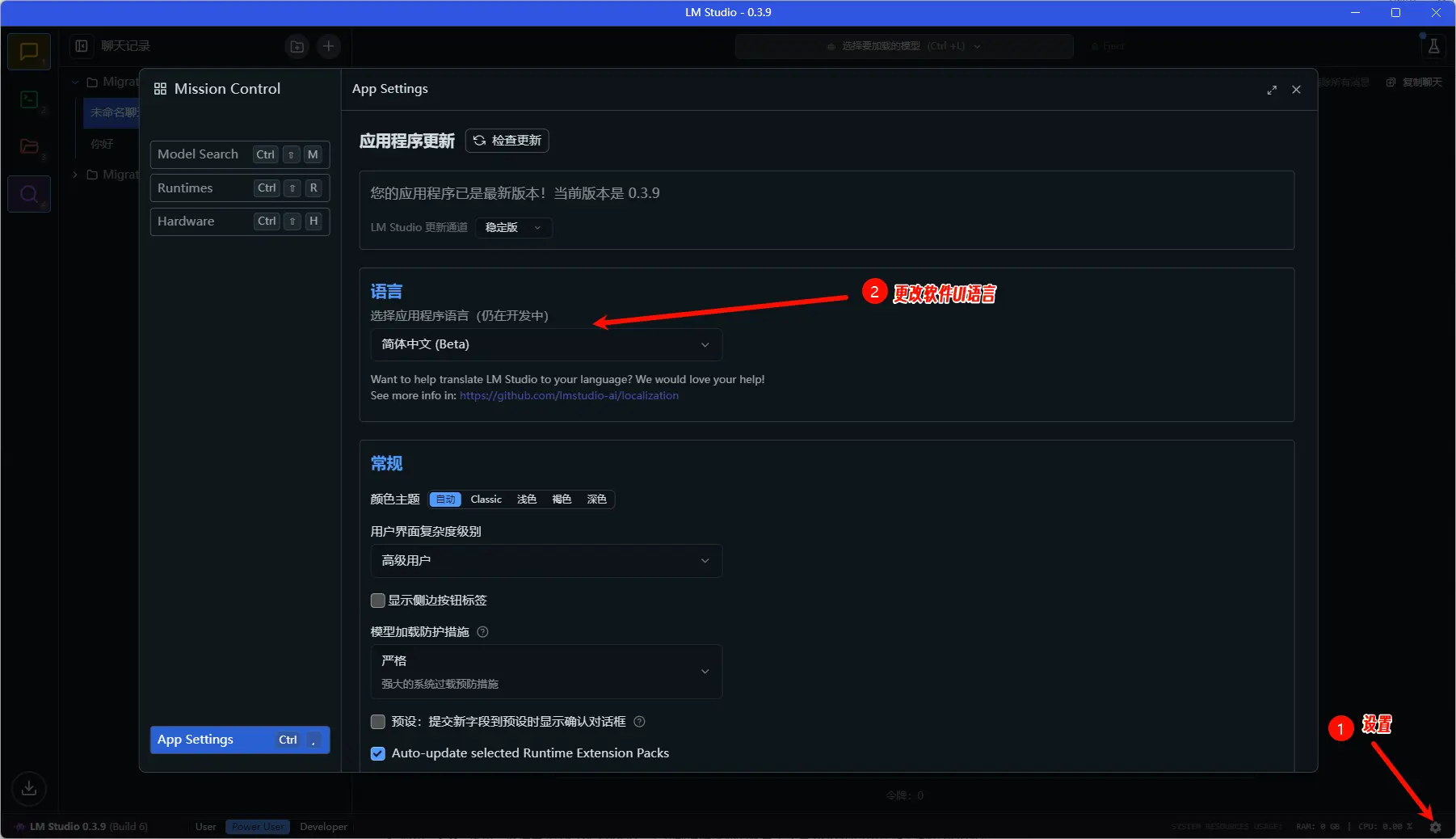

如何安装和使用 LM Studio?

安装步骤

- 访问官网:前往 LM Studio 官方网站,下载适用于你的操作系统的免费软件。

- 下载与安装:根据提示完成安装。

- 启动程序:安装完成后,启动 LM Studio。

运行模型

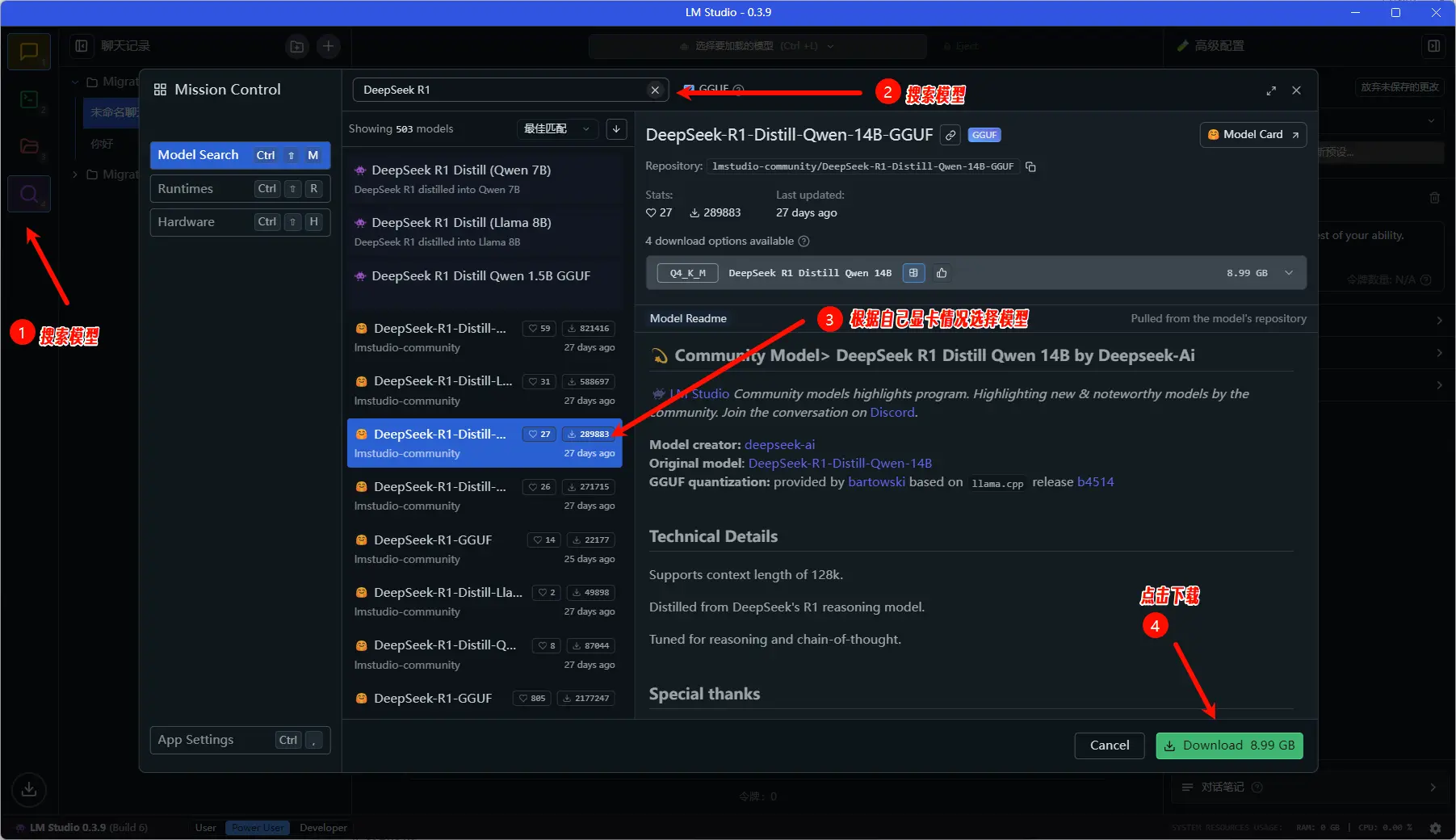

以 DeepSeek R1模型为例,以下是运行模型的详细步骤:

1、搜索并下载模型

- 启动 LM Studio 后,点击左侧窗格的 “模型搜索” 图标。

- 在搜索框中输入 “DeepSeek R1”,找到对应的模型,找到自己适合自己电脑硬件的参数的模型。

- 点击 “下载” 按钮。

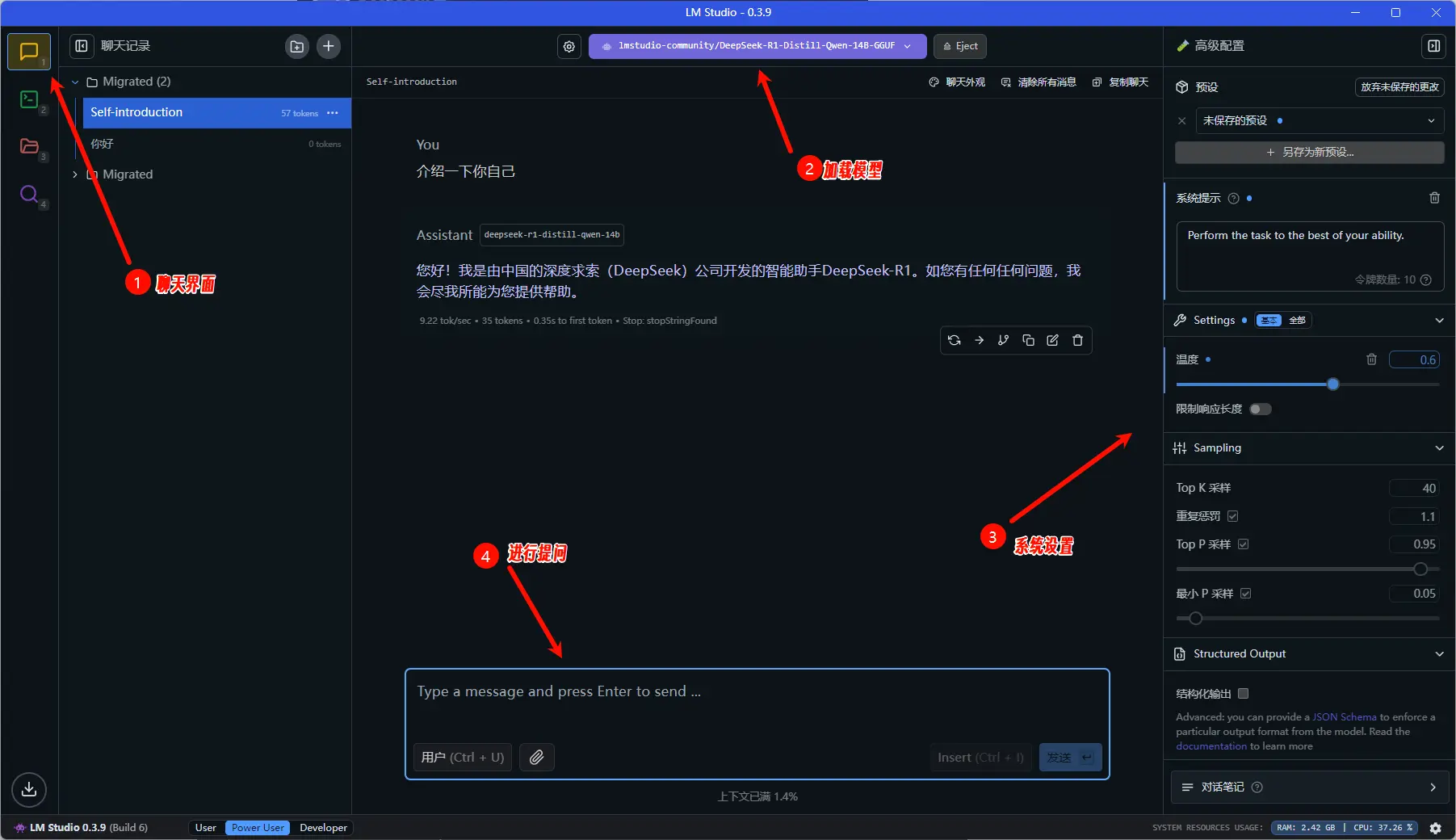

2、加载模型

- 下载完成后,前往 “聊天” 窗口。

- 选择已下载的模型,点击 “加载模型” 按钮。

- 如果遇到问题,可以尝试将 GPU 卸载调回 0 并重试。

3、开始使用

- 模型加载完成后,你就可以通过聊天界面与 DeepSeek AI 交互了。所有操作完全离线进行,无需担心数据隐私问题。

参考:DeepSeek R1模型的官方推荐设置,以获得最佳体验

高级功能

- 离线文档交互:你可以将文档附加到聊天消息中,与模型进行完全离线的交互,这种方式也被称为“RAG”。

- API 接口:LM Studio 提供 REST API,支持从自定义应用程序或脚本中调用本地模型。

- OpenAI 兼容性:LM Studio 的 API 与 OpenAI 兼容,方便用户无缝切换。

为什么选择 LM Studio?

- 隐私保护:完全离线运行,数据不会上传到任何服务器。

- 高效运行:支持显卡加速,提升模型运行效率。

- 简单易用:提供直观的聊天界面和强大的模型管理功能。

- 开源免费:适合个人用户在本地运行开源模型。

相关

LM Studio 0.3.17 版本正式引入MCP支持

LM Studio 0.4.0 发布:核心引擎与 GUI 分离,支持自托管服务器与多会话并发