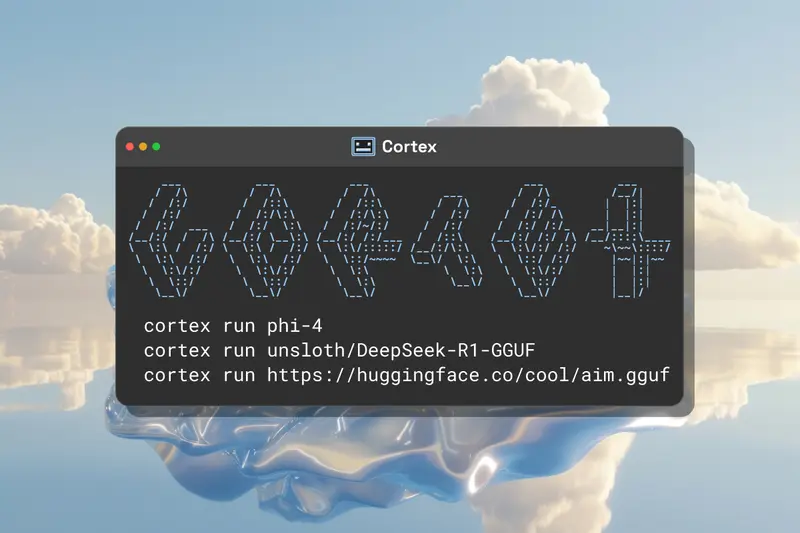

Cortex 是一款由 Homebrew 开发类似于 Ollama 的命令行工具,旨在帮助用户快速启动和运行开源大语言模型。它支持多种操作系统(macOS、Windows 和 Linux)。如果你不习惯使用命令行,Homebrew还提供了带有 UI 界面的 Jan 软件,方便不熟悉命令行操作的用户使用。

核心特点

- 多引擎支持:从 llama.cpp 开始,用户可以自由添加自己的引擎,满足多样化的使用需求。

- 硬件优化:Cortex 能够自动检测 GPU(支持英伟达、AMD 和英特尔),并根据硬件配置进行优化,确保最佳性能。

主要特性

- 简洁的 CLI:受 Ollama 启发,Cortex 提供了简洁高效的命令行界面,让用户能够快速上手。

- 完整的 C++ 实现:基于 C++ 开发,Cortex 可以轻松打包到桌面和移动应用中,具备高效的性能表现。

- 灵活的模型管理:支持从 Hugging Face 或 Cortex 内置模型库拉取模型,并以通用文件格式存储,方便管理和使用。

- 可交换的推理后端:默认支持 llamacpp 和 ONNXRuntime,用户可以根据需求选择不同的推理后端。

- 独立部署或集成:Cortex 可以作为独立的 API 服务器运行,也可以集成到 Jan.ai 等应用中,提供灵活的部署选项。

- 自动 API 文档:服务器端提供自动化的 API 文档,方便开发者快速接入和使用。

- 未来规划:Cortex 的路线图包括实现与 OpenAI API 的完全兼容,支持工具、运行、多模态和实时 API。

推理后端

- llama.cpp:跨平台,适合大多数笔记本电脑、台式机和操作系统。

- ONNX Runtime(未来支持):适用于 Windows Copilot+ PC 和 NPU,同时支持传统机器学习模型。

模型管理

Cortex.cpp 允许用户从多个模型中心拉取模型,提供广泛的模型访问权限。支持的模型中心包括:

硬件要求指南

作为参考,运行不同规模的模型需要以下显存容量:

- 3B 模型:建议至少 8 GB 可用显存

- 7B 模型:建议至少 16 GB 可用显存

- 14B 模型:建议至少 32 GB 可用显存

Cortex 适用场景

Cortex 适合以下用户和场景:

- 开发者:希望快速部署和运行开源大语言模型,进行开发和测试。

- 研究人员:需要灵活的模型管理和高效的推理后端,支持多种硬件平台。

- 企业用户:希望通过本地部署和 API 集成,将大语言模型应用于实际业务。

- 普通用户:通过 Jan.ai 的 UI 界面,轻松使用大语言模型,无需命令行操作。