Wan2.1-VACE是阿里巴巴通义团队推出的一款开源统一视频编辑模型。通过整合多任务能力、支持高分辨率处理和灵活的多模态输入机制,该模型显著提高了视频创作的效率和质量。ComfyUI官方今天发文表示已经原生支持Wan2.1-VACE模型。

亮点:一体化编辑

VACE在单一模型内创造性地提供视频生成和编辑解决方案,使用户能够探索多种可能性并有效简化工作流程,提供的功能包括移动任何内容、交换任何内容、引用任何内容、扩展任何内容、动画任何内容等。

该模型基于 Apache-2.0 协议开源,可用于个人商业用途。

以下是其核心特性与技术亮点的综合分析:

- 多模态输入:支持文本、图像、视频、遮罩、控制信号等多种输入形式

- 统一架构:单一模型支持多种任务,可自由组合功能

- 动作迁移:基于参考视频生成连贯动作

- 局部替换:通过遮罩替换视频中的特定区域

- 视频扩展:补全动作或扩展背景

- 背景替换:保留主体更换环境背景

目前 VACE 发布了 1.3B 和 14B 两个版本,14B 版本相比 1.3B 版本,支持 720P 分辨率输出,画面细节和稳定性更好。

| 模型 | 480P | 720P |

|---|---|---|

| VACE-1.3B | ✅ | ❌ |

| VACE-14B | ✅ | ✅ |

模型下载及在工作流中的加载

官方提供的几个工作流都使用同一套工作流模板,所以我们可以先完成模型下载及加载的信息介绍,然后通过 Bypass(绕过) 不同的节点来启用/ 禁用不同的输入来实现不同的工作流。 在具体示例中对应的工作流信息中已经嵌入了模型下载信息,所以你也可以在下载具体示例的工作流时来完成模型下载。

模型下载

- diffusion_models: wan2.1_vace_14B_fp16.safetensors|wan2.1_vace_1.3B_fp16.safetensors

- VAE:wan_2.1_vae.safetensors

- Text encoders :umt5_xxl_fp16.safetensors|umt5_xxl_fp8_e4m3fn_scaled.safetensors

如果你之前使用过 Wan Video 相关的工作流,上面的一些模型文件你已经下载过了。目前14B模型ComfyUI官方尚未释出FP8量化版,显存不足的朋友就不要尝试了。

国内朋友如果网络环境不允许,请从魔塔下载相关模型:https://www.modelscope.cn/models/Comfy-Org/Wan_2.1_ComfyUI_repackaged/files

文件保存位置

📂 ComfyUI/

├── 📂 models/

│ ├── 📂 diffusion_models/

│ │ └─── wan2.1_vace_14B_fp16.safetensors # 或 wan2.1_vace_1.3B_fp16.safetensors

│ ├── 📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors # 或 umt5_xxl_fp16.safetensors

│ └── 📂 vae/

│ └── wan_2.1_vae.safetensors模型加载

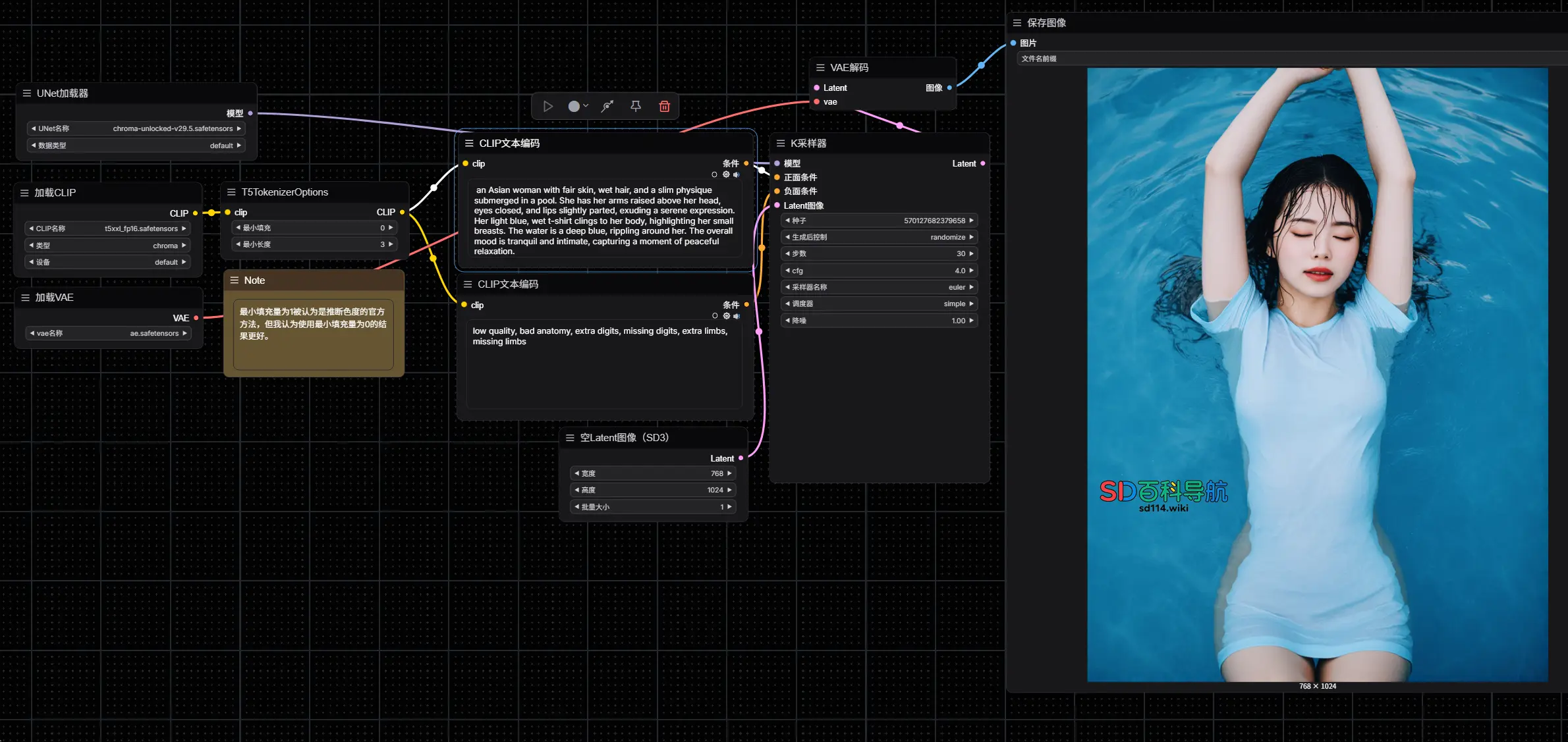

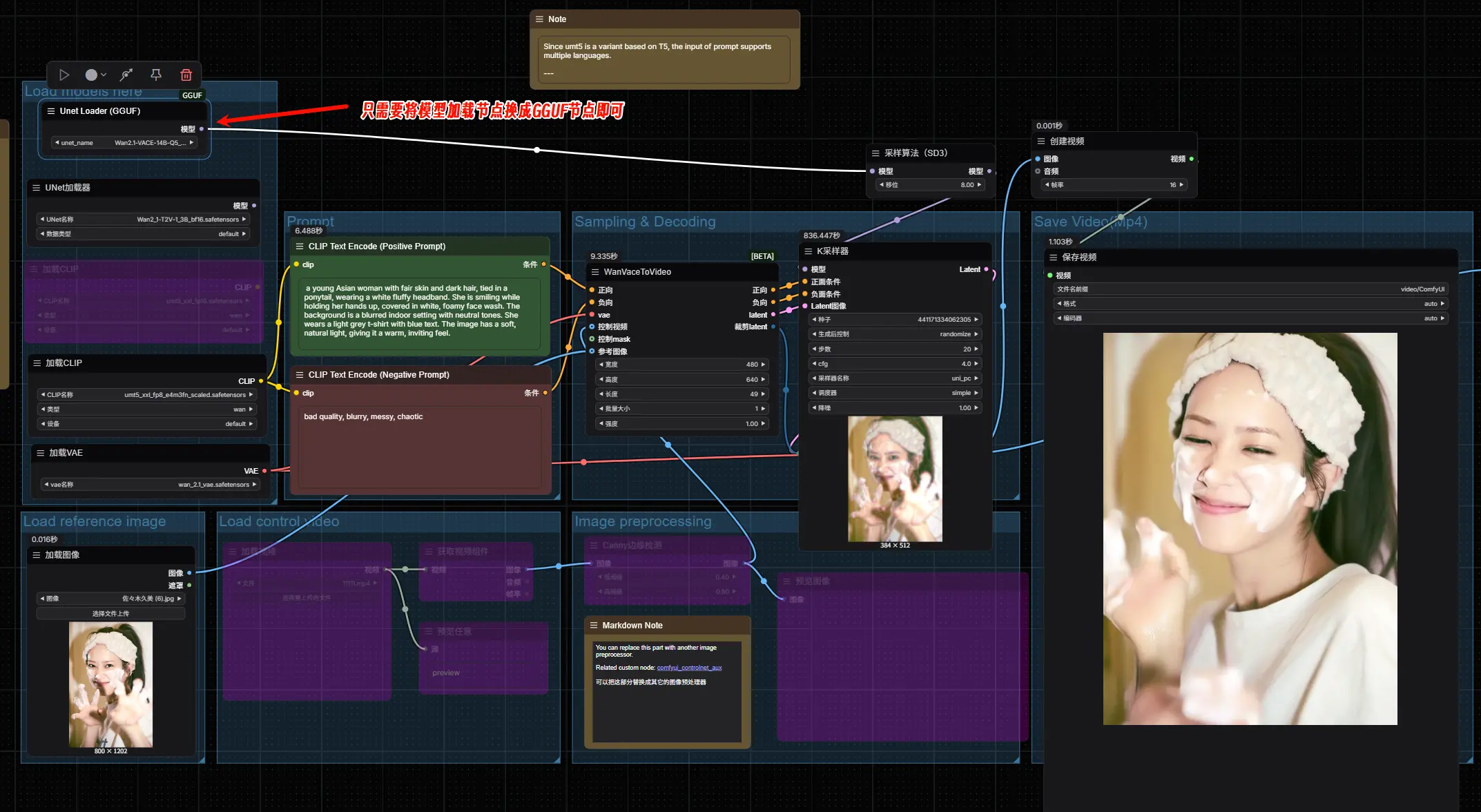

由于在本篇指南中,我们所使用的模型是一致的,工作流也相同,只是 Bypass 了部分的节点来启用/ 禁用不同的输入,请参考下面的图片确保在对应不同的工作流中,对应的模型都已正确加载

- 确保

Load Diffusion Model节点加载了wan2.1_vace_14B_fp16.safetensors或者wan2.1_vace_1.3B_fp16.safetensors - 确保

Load CLIP节点加载了umt5_xxl_fp8_e4m3fn_scaled.safetensors或者umt5_xxl_fp16.safetensors - 确保

Load VAE节点加载了wan_2.1_vae.safetensors

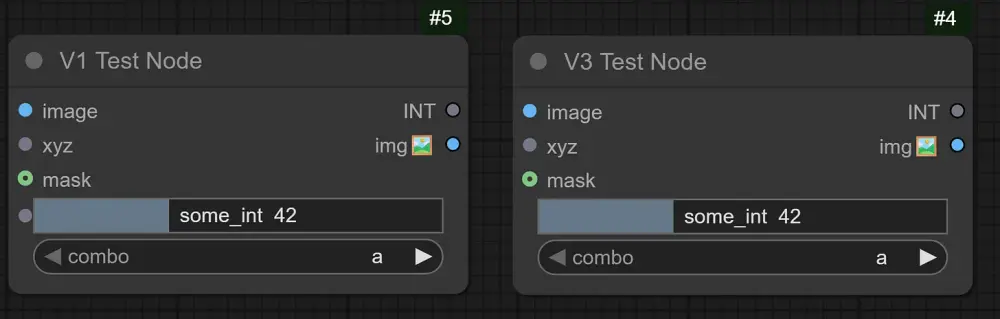

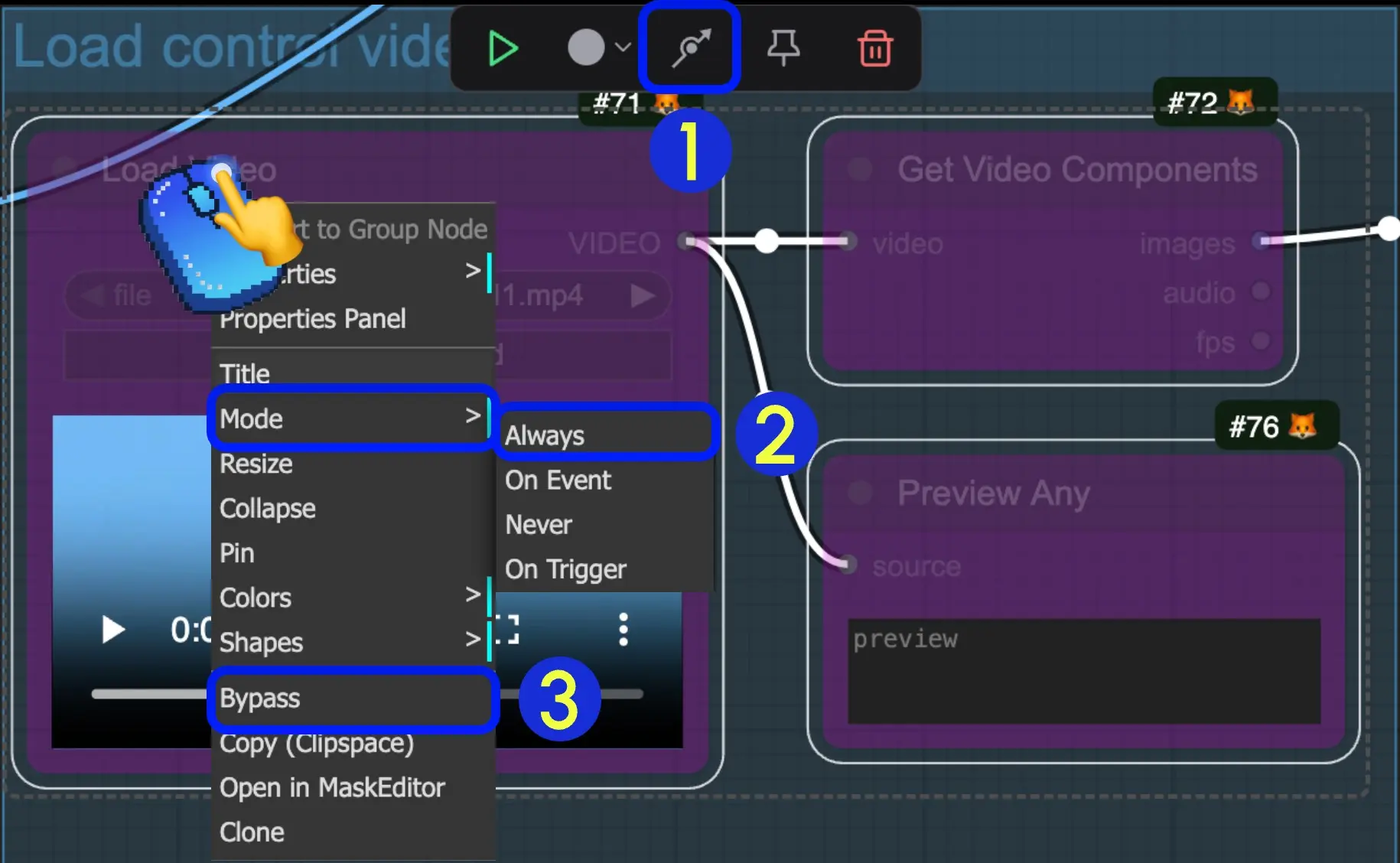

如何取消节点的绕过状态

当一个节点被设置为 Bypass(绕过) 状态时,通过该节点的数据将不受节点的影响,直接输出,下面是如何取消节点的 Bypass 状态的三种方法 我们通常在不需要一些节点时设置节点的 Bypass 状态,而不用将它们从节点中删除改变工作流。

- 选中节点后,在选择工具箱中点击标识部分的箭头,即可快速切换节点的 Bypass 状态

- 选中节点后,鼠标右键点击节点,选择

模式(Mode)->总是(Always)切换到 Always 模式 - 选中节点后,鼠标右键点击节点,选择

绕过(Bypass)选项,切换 Bypass 状态

注意:最简单的方式其实是使用快捷键,鼠标右键点击节点后,直接使用键盘上的Ctrl+B即可快速切换节点的 Bypass 状态

VACE 文生视频工作流

本文是在官方文档上做的一些增补,大家可以到官方文档下载工作流,如果网络不方面,也可以从网盘下载

- 官方文档:https://docs.comfy.org/zh-CN/tutorials/video/wan/vace

- 网盘:https://www.123865.com/s/hyQyTd-SFHDv 提取码:AHaE

按步骤完成工作流的运行

请参照图片序号进行逐步确认,来保证对应工作流的顺利运行

- 在

CLIP Text Encode (Positive Prompt)节点中输入正向提示词 - 在

CLIP Text Encode (Negative Prompt)节点中输入负向提示词 - 在

WanVaceToVideo设置对应图像的尺寸(首次运行建议设置 640*640 的分辨率),帧数(视频的时长) - 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行视频生成 - 生成完成后对应的视频会自动保存到

ComfyUI/output/video目录下(子文件夹位置取决于save video节点设置)

官方测试使用的是4090 显卡:

- 720*1280 的分辨率,生成 81 帧视频需要 40 分钟左右

- 640*640 的分辨率,生成 49 帧视频需要 7 分钟左右

但相对的 720P 的视频质量会更好

本人测试使用的是4070显卡

- 480*640的分辨率,生成49帧视频需要140秒左右

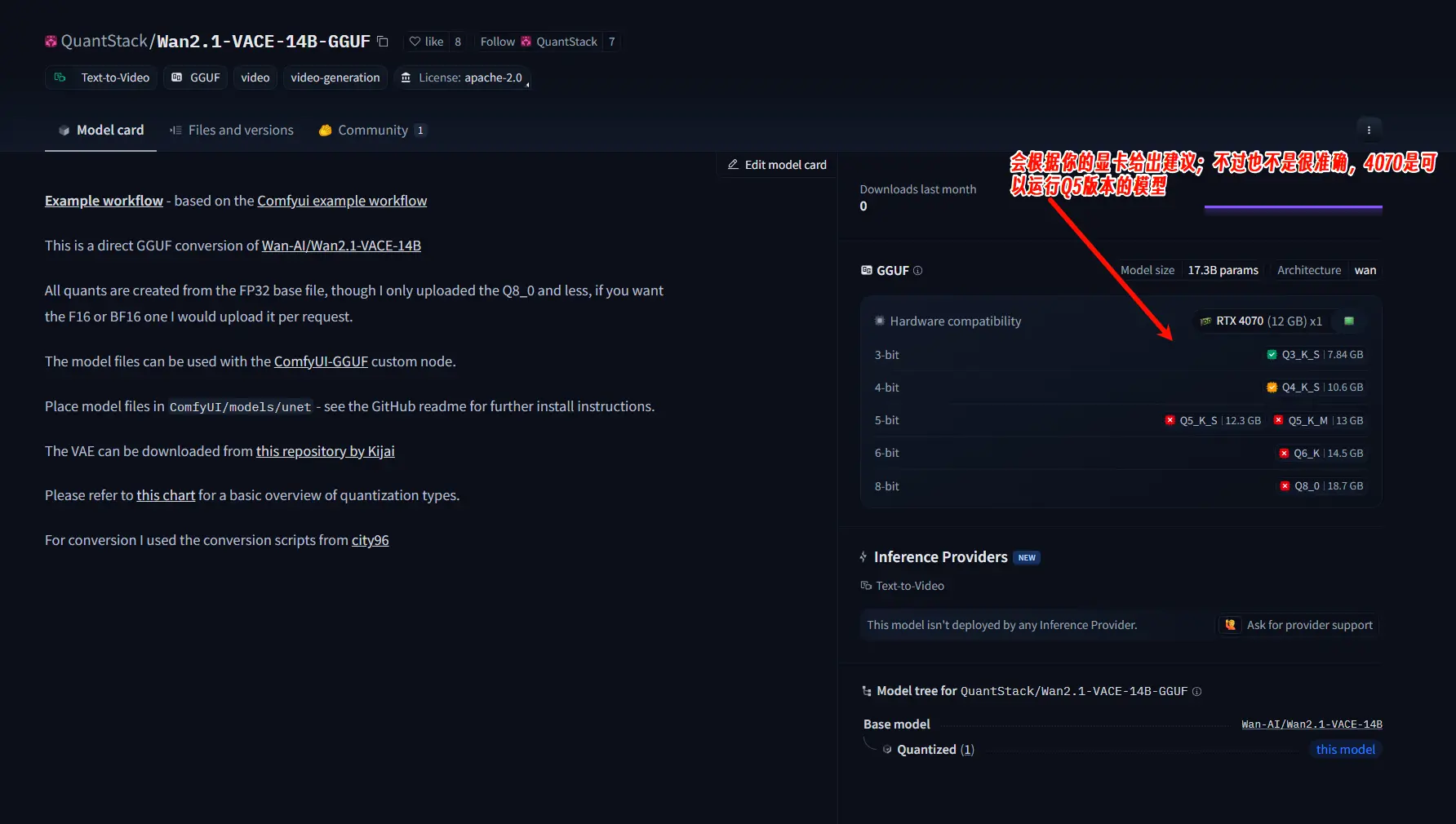

12G显存只能使用1.3B模型,未量化的14B模型会爆显存;如果想使用14B模型可尝试开发者Kijai推出的插件ComfyUI-WanVideoWrapper及量化的模型;或者使用GGUF版的量化模型

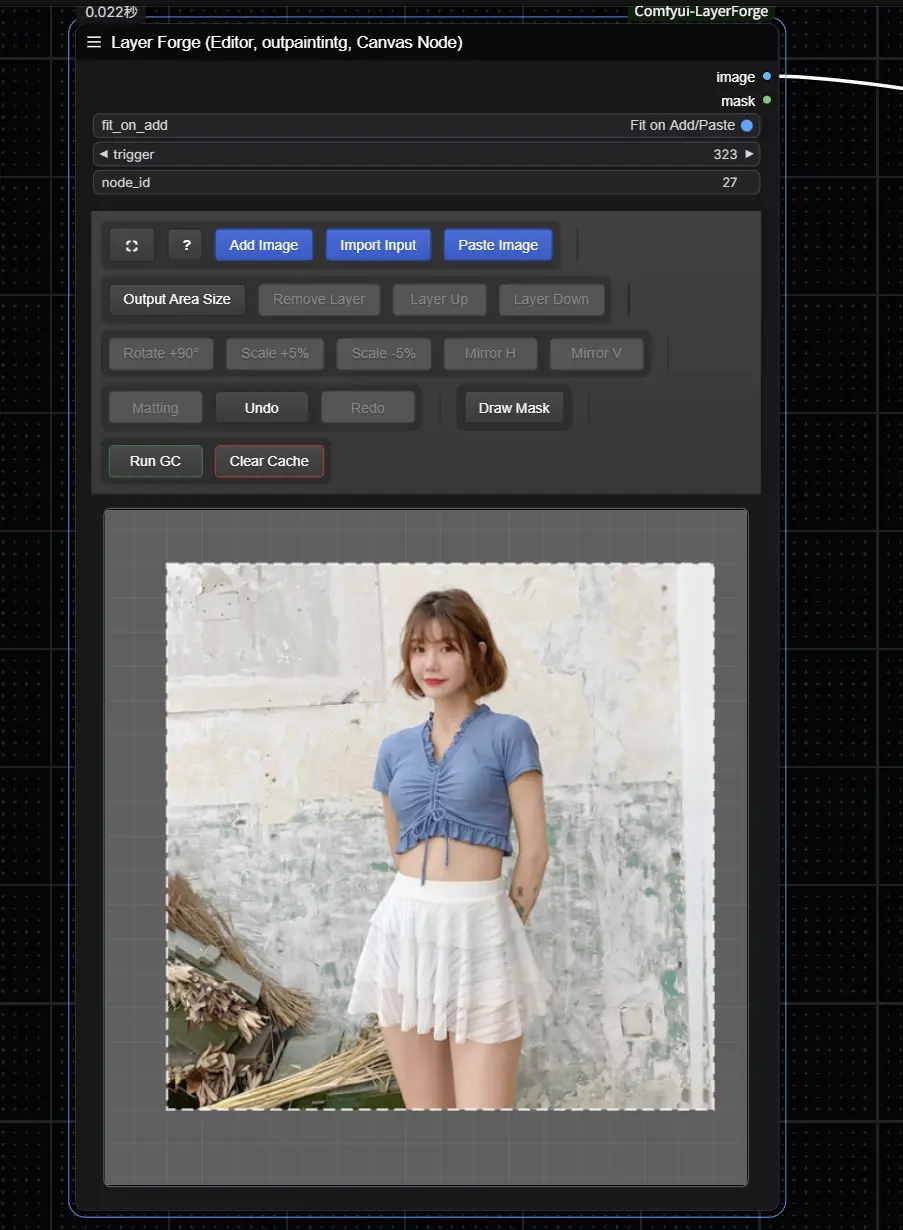

VACE 图生视频工作流

你可以继续使用文生视频工作流文件,只需要将 Load reference image 的 Load image 节点的 Bypass 取消,并输入对应的图片,你也可以使用下面的图片,在这个文件里,我们已经完成了对应的参数设置。

按步骤完成工作流的运行

请参照图片序号进行逐步确认,来保证对应工作流的顺利运行

- 在

Load image节点中输入对应的图片 - 你可以像文生图工作流一样完成来进行提示词的修改和编辑

- 在

WanVaceToVideo设置对应图像的尺寸(首次运行建议设置 640*640 的分辨率),帧数(视频的时长) - 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行视频生成 - 生成完成后对应的视频会自动保存到

ComfyUI/output/video目录下(子文件夹位置取决于save video节点设置)

你可能会使用类似获取图片尺寸一点的节点来设置对应的分辨率,但是由于对应节点有宽度和高度的步长要求,会导致如果你的图片尺寸无法被 16 整除时,可能会出现报错提示。

还有一点需要注意,那就是1.3B模型只支持文生视频,图生视频和视频生视频需要14B模型才可以。

VACE 还支持在一张图像中输入多个参考图像,来生成对应的视频。

VACE 视频到视频工作流

对应视频素材如何处理请查看官方文档,官方建议使用类似 comfyui_controlnet_aux 这样的预处理节点来对图像进行预处理

按步骤完成工作流的运行

请参照图片序号进行逐步确认,来保证对应工作流的顺利运行

- 在

Load reference image中的Load Image节点输入参考图片 - 在

Load control video中的Load Video节点输入控制视频,由于提供的视频是经过预处理的,所以你不需要进行额外的处理 - 如果你需要自己针对原始视频进行预处理,可以修改

Image preprocessing分组,或者使用comfyui_controlnet_aux节点来完成对应的节点预处理 - 修改提示词

- 在

WanVaceToVideo设置对应图像的尺寸(首次运行建议设置 640*640 的分辨率),帧数(视频的时长) - 点击

Run按钮,或者使用快捷键Ctrl(cmd) + Enter(回车)来执行视频生成 - 生成完成后对应的视频会自动保存到

ComfyUI/output/video目录下(子文件夹位置取决于save video节点设置)

目前还有扩展工作流,官方尚未释出;而前面也说了14B模型才支持图生视频和视频生视频,对于显存不足的朋友,推荐大家使用GGUF版模型,请根据自己的显存来选择适合的模型。(国内的朋友请使用 HF-Mirror镜像代理来下载)

- 地址:https://huggingface.co/QuantStack/Wan2.1-VACE-14B-GGUF

- 镜像:https://hf-mirror.com/QuantStack/Wan2.1-VACE-14B-GGUF

使用GGUF模型,需要GGUF节点,这里推荐ComfyUI-GGUF这个插件,只需要将官方工作流中的模型加载节点替换成GGUF模型加载节点即可。

相关:

相关文章