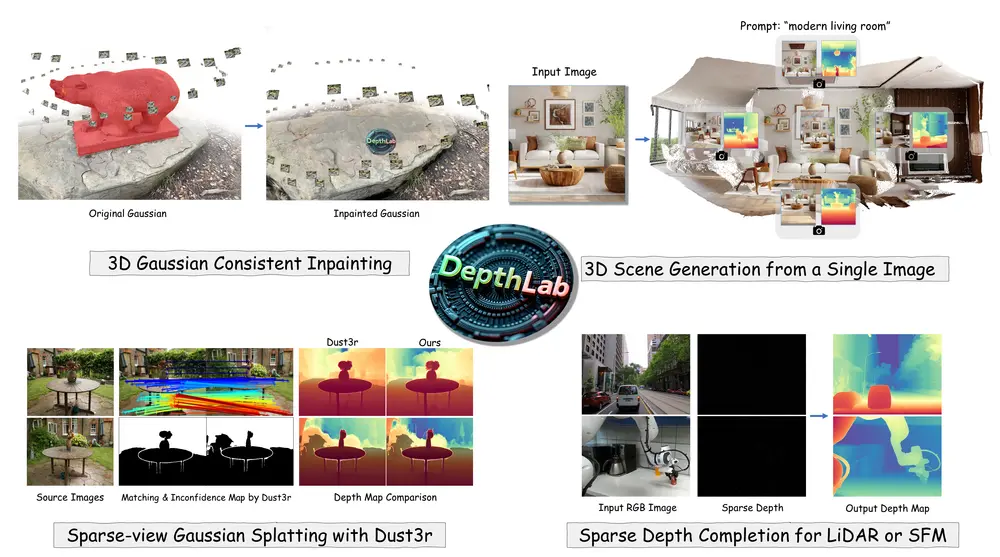

,它是一个基于图像扩散先验的深度修复模型,用于从单张图像中生成完整的3D场景。DepthLab旨在解决深度数据中普遍存在的缺失值问题,这个问题通常源于数据采集的不完整性和视角变化等因素。DepthLab通过利用已知的部分深度信息,提高了下游任务中的深度估计性能,例如3D场景修复、文本到3D场景生成、稀疏视图重建以及LiDAR深度补全等。

- 项目主页:https://johanan528.github.io/depthlab_web

- GitHub:https://github.com/Johanan528/DepthLab

- 模型:https://huggingface.co/Johanan0528/DepthLab

例如,我们有一个现代客厅的图像,并且只有部分深度信息。使用DepthLab,我们可以预测出完整的深度图,这有助于我们在3D空间中编辑和重建客厅的场景,比如添加或移除物体,或者从文本描述中生成整个3D场景。此外,DepthLab还可以用于改进LiDAR数据,填充由传感器捕获的不完整深度图像中的缺失部分,这对于自动驾驶和机器人导航等应用至关重要。

主要功能和特点:

- 鲁棒性:DepthLab能够处理连续区域和孤立点的深度缺失问题,提供可靠的补全。

- 尺度一致性:在填补缺失值时,DepthLab能够保持与已知深度的尺度一致性。

- 下游任务性能:在多个下游任务中,DepthLab在数值性能和视觉质量上都超过了当前的解决方案。

工作原理:

DepthLab采用双分支扩散框架,包括一个用于提取RGB特征的参考U-Net和一个用于深度估计的U-Net。参考U-Net处理单张参考图像,提取RGB特征作为条件输入;而深度估计U-Net则接收已知深度和需要修复的区域掩码作为输入。通过层与层之间的特征融合,DepthLab能够在大范围或复杂的掩码区域实现高质量的深度预测。

具体应用场景:

- 3D场景修复:在3D场景中,DepthLab可以从参考视图开始修复图像的深度,然后将点反投影到3D空间进行最佳初始化,显著提高3D场景修复的质量和速度。

- 文本到3D场景生成:DepthLab通过消除对齐需求,显著改进了从单张图像生成3D场景的过程,减少了几何不一致性问题,从而显著提高了生成场景的连贯性和质量。

- 稀疏视图重建:使用DUST3R进行稀疏视图重建时,DepthLab通过在缺乏视图对应区域的深度图中添加噪声作为潜在输入,来精细化深度估计,生成更精确、几何一致的深度图。

- LiDAR深度补全:在传感器深度补全任务中,DepthLab能够在零样本设置下实现可比的结果,并且通过最小微调即可提供更好的结果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...