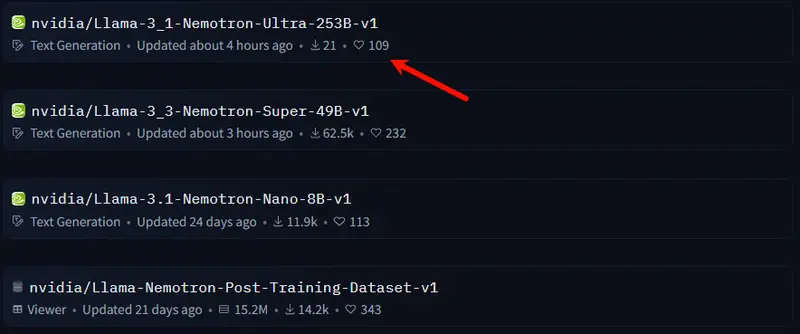

英伟达今天发布了一款全新的开源大语言模型—Llama-3.1 Nemotron Ultra-253B-v1,这款拥有2530亿参数的模型在多个基准测试中表现出色,甚至超越了竞争对手DeepSeek R1,尽管其参数数量不到后者的一半。这一成果不仅展示了英伟达在AI技术上的深厚实力,也进一步推动了开源LLM的发展。

Llama-3.1 Nemotron Ultra的核心优势

1. 高效的推理能力

Llama-3.1 Nemotron Ultra-253B-v1专为高效推理设计。其架构通过神经架构搜索(NAS)过程进行定制,引入了结构变化,如跳跃注意力层、融合前馈网络(FFNs)和可变的FFN压缩比率。这些调整减少了内存占用和计算需求,同时不显著影响输出质量,使其能够在单个8x H100 GPU节点上部署。

2. 强大的性能表现

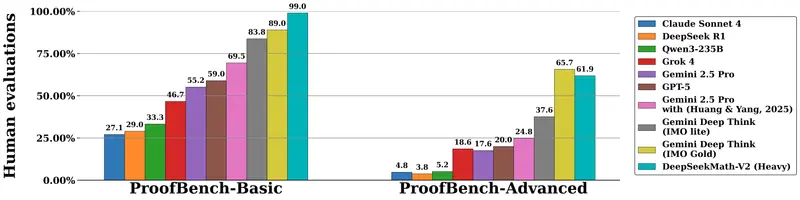

在多个基准测试中,Llama-3.1 Nemotron Ultra-253B-v1表现出色。例如:

- 在MATH500基准测试中,性能从标准模式的80.40%提升至97.00%。

- 在AIME25基准测试中,结果从16.67%上升至72.50%。

- LiveCodeBench得分翻倍以上,从29.03%跃升至66.31%。

- 在基于工具的任务(如BFCL V2和函数组合)以及一般问答(GPQA)中,推理模式下的得分显著高于非推理模式。

与DeepSeek R1相比,尽管参数数量不到一半,Llama-3.1 Nemotron Ultra-253B-v1在GPQA(76.01% vs. 71.5%)、IFEval指令遵循(89.45% vs. 83.3%)和LiveCodeBench编码任务(66.31% vs. 65.9%)等任务中表现出色。尽管在某些数学评估中DeepSeek R1略有优势,但Llama-3.1 Nemotron Ultra-253B-v1在推理和一般指令对齐任务上能够匹配甚至超越MoE替代品。

3. 灵活的推理模式

Llama-3.1 Nemotron Ultra-253B-v1支持“推理开启”和“推理关闭”模式,开发者可以通过系统提示在两种模式之间切换,以应对高复杂度的推理任务或更直接的输出。这种灵活性使其能够适应多种应用场景。

4. 广泛的多语言支持

该模型支持多语言应用,具备英语及多种其他语言能力,包括德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。这使其能够广泛应用于全球范围内的各种用例。

开发与训练

Llama-3.1 Nemotron Ultra-253B-v1基于Meta的Llama-3.1-405B-Instruct模型开发,并通过多阶段后训练流程进行了优化。这包括在数学、代码生成、聊天和工具使用等领域进行监督微调,随后使用群体相对策略优化(GRPO)强化学习进一步提升指令遵循和推理性能。模型经历了超过650亿个标记的知识蒸馏阶段,随后在额外880亿个标记上进行持续预训练。

使用与集成

Llama-3.1 Nemotron Ultra-253B-v1与Hugging Face Transformers库(推荐版本4.48.3)兼容,支持高达128,000个标记的输入和输出序列。开发者可以通过系统提示控制推理行为,并根据任务需求选择解码策略。对于推理任务,英伟达建议使用温度采样(0.6)和top-p值0.95;对于确定性输出,推荐使用贪婪解码。

商业许可与开源

该模型在英伟达开放模型许可和Llama 3.1社区许可协议下发布,可用于商业用途。英伟达强调了负责任AI开发的重要性,鼓励团队根据其具体用例评估模型的对齐性、安全性和偏见特征。

相关文章