美团技术团队于3月6日宣布对 DeepSeek R1 模型进行了 INT8 精度量化,使其能够在如 A100 等老型号 GPU 上进行部署。这一技术突破为 DeepSeek R1 的广泛应用提供了更多可能性。(技术报告)

DeepSeek R1 的部署难题

DeepSeek R1 自发布以来,受到了众多企业和个人的关注,许多用户尝试将其部署到生产环境中。然而,原生版本的 DeepSeek R1 模型权重采用 FP8 数据格式,对 GPU 芯片类型有严格限制,仅能被英伟达新型 GPU(如 Ada、Hopper 架构芯片)支持。其他型号 GPU(如 A100)无法直接部署该模型。

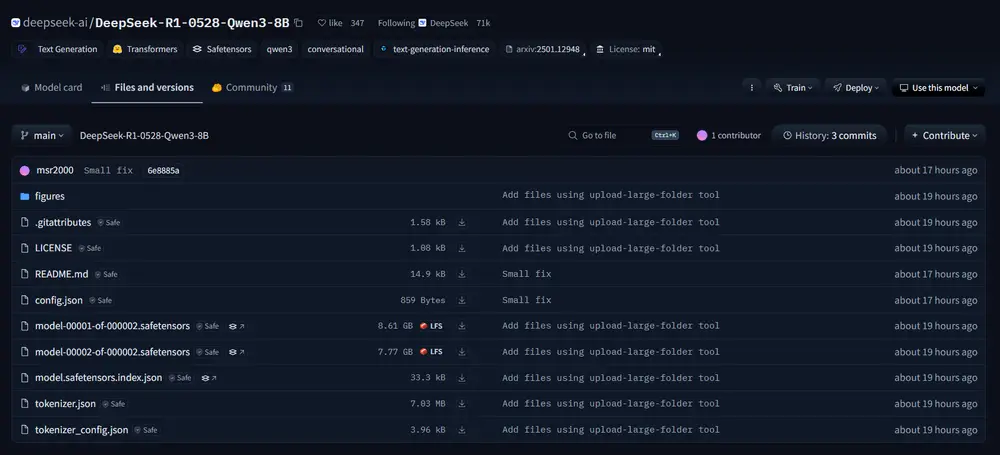

- https://huggingface.co/meituan/DeepSeek-R1-Block-INT8

- https://huggingface.co/meituan/DeepSeek-R1-Channel-INT8

虽然可以通过将 FP8 权重反量化为 BF16 权重的方式,在 A100 等 GPU 上进行推理,但这种方法会带来显著的性能问题:显存需求增加一倍,推理吞吐量也会大幅下降。

INT8 精度量化的突破

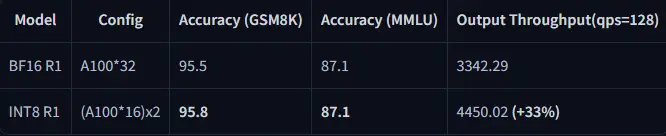

为了解决这一问题,美团搜索和推荐平台部对 DeepSeek R1 模型进行了 INT8 精度量化尝试,并取得了显著成果。经过量化后,DeepSeek R1 模型的精度基本无损,同时解锁了对老型号 GPU 的支持。

基于 INT8 量化,DeepSeek R1 模型不仅能够在 A100 等其他型号 GPU 上顺利部署,还实现了相比 BF16 权重 50% 的吞吐量提升,进一步降低了推理成本。这一改进为用户提供了更高效、更经济的部署方案。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...