在腾讯开源其混元视频模型HunyuanVideo之后,经过三个月的等待,腾讯终于推出了专注于图像到视频生成任务的混元图生视频模型HunyuanVideo-I2V。

- GitHub:https://github.com/Tencent/HunyuanVideo-I2V

- 模型:https://huggingface.co/tencent/HunyuanVideo-I2V

- 插件:https://github.com/kijai/ComfyUI-HunyuanVideoWrapper

- 量化模型:https://huggingface.co/Kijai/HunyuanVideo_comfy

此次开源不仅包含了模型权重和推理代码,还有LoRA训练代码,支持开发者基于此开发专属的LoRA等衍生模型。目前,该模型已在Github、HuggingFace等主流开发者社区上线,供用户下载体验。

HunyuanVideo-I2V 核心架构

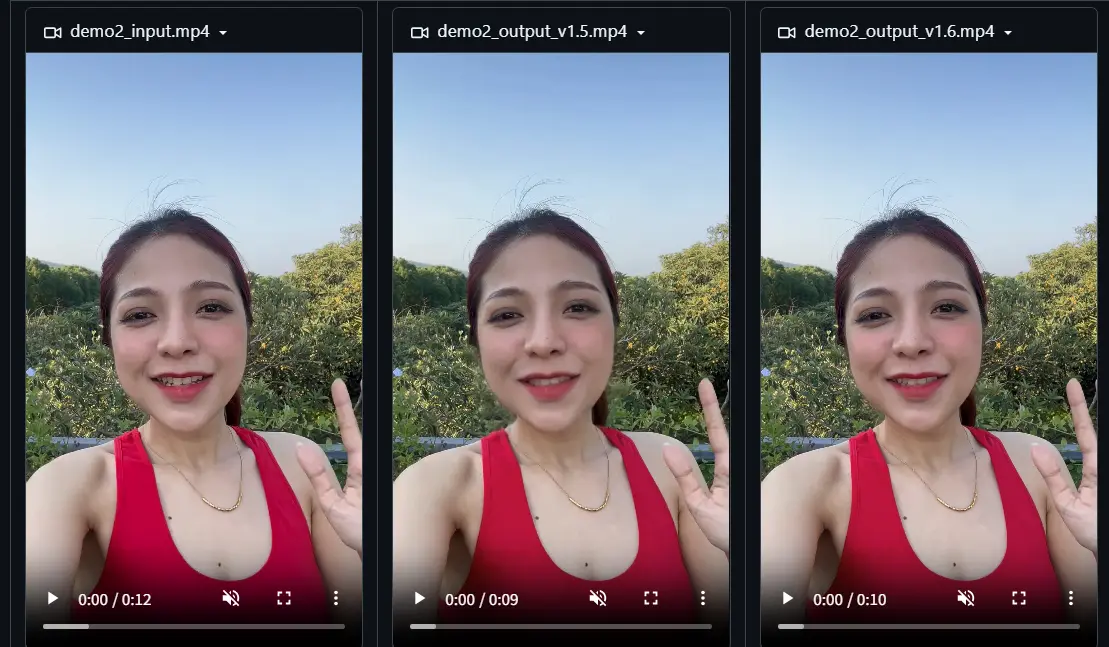

HunyuanVideo-I2V 基于 HunyuanVideo 先进的视频生成能力,专注于图像到视频的生成任务。通过采用图像潜在连接技术,该模型能够有效地将参考图像信息整合到视频生成过程中,从而实现高质量且连贯的视频输出。

关键技术特点

1、多模态大语言模型(MLLM):

- HunyuanVideo-I2V 使用预训练的多模态大语言模型作为文本编码器,采用 Decoder-Only 架构。

- 输入图像通过 MLLM 处理生成语义图像 token,这些 token 与视频潜在 token 连接,实现对组合数据的全面注意力计算。

- 这种设计显著增强了模型对输入图像语义内容的理解能力,并无缝整合图像及其相关描述信息。

2、图像与文本模态协同:

- 整体架构旨在最大化图像和文本模态之间的协同作用,确保从静态图像生成高质量且连贯的视频内容。

- 该模型不仅提高了生成视频的保真度,还增强了模型解释和利用复杂多模态输入的能力。

3、适用场景:

- HunyuanVideo-I2V 适用于多种类型的角色和场景,包括写实视频制作、动漫角色以及 CGI 角色制作的生成。

运行与训练要求

运行要求

- 分辨率:720p

- GPU 峰值内存:至少 60GB显存

- 硬件要求:需要支持 CUDA 的英伟达显卡

- 测试配置:建议使用 80GB 内存的 GPU 以获得更好的生成质量

- 操作系统:Linux

训练要求

- 分辨率:360p

- GPU 峰值内存:至少 79GB显存

- 硬件要求:需要支持 CUDA 的英伟达显卡

- 测试配置:建议使用 80GB显存的 GPU 以获得更好的生成质量

- 操作系统:Linux

- 注意事项:可以使用 360p 数据进行训练,并直接推理生成 720p 视频。

训练数据构建

提示描述

为了更好地训练 HunyuanVideo-I2V LoRA 模型,开发者需要构建合适的训练数据。提示描述中应包含触发词和视频描述,建议使用短语或短句。例如:

- 触发词:

rapid_hair_growth(AI 生发效果) - 视频描述:

The hair of the characters in the video is growing rapidly.(视频中角色的头发正在快速生长)

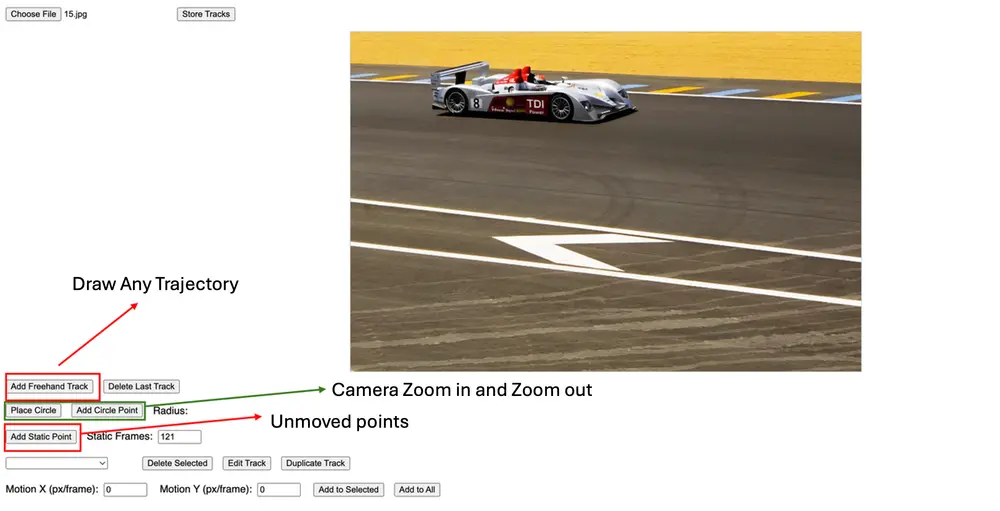

使用图生视频模型的建议

- 使用简短的提示:为了有效地引导模型的生成,请保持提示简短且直截了当。

- 包含关键元素:一个结构良好的提示应包括:

- 主体:指定视频的主要焦点。

- 动作:描述正在发生的运动或活动。

- 背景(可选):设置视频的场景。

- 镜头(可选):指示视角或视点。

- 避免过于详细的提示:冗长或高度详细的提示可能会导致视频输出中出现不必要的转场。

相关:

腾讯发布开源视频生成模型—混元文生视频模型HunyuanVideo

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...