字节跳动推出了AnimateDiff-Lightning模型,能够更快地根据文本描述生成视频,比起原来的AnimateDiff模型,速度提升十倍以上。

- 模型地址:https://huggingface.co/ByteDance/AnimateDiff-Lightning

- 论文地址:https://arxiv.org/abs/2403.12706

- DEMO:https://huggingface.co/spaces/ByteDance/AnimateDiff-Lightning

除了能够根据文本生成视频之外,AnimateDiff-Lightning还可以进行视频到视频的生成,可以将现有视频转换成不同风格的视频。

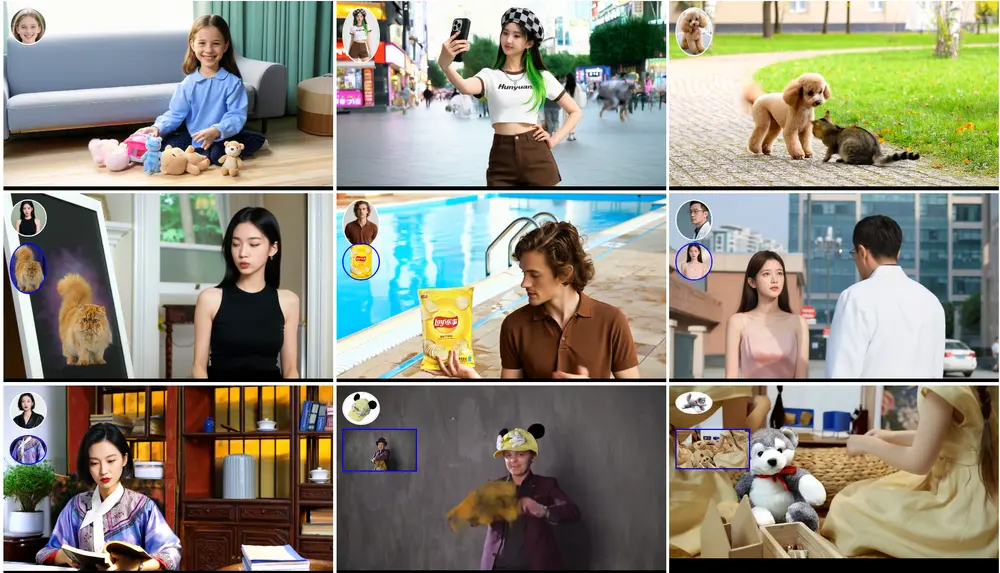

- 与多种风格的基础模型兼容:还可以与多种不同风格的基础模型结合使用,包括真实风格和动漫卡通风格,这样可以生成各种不同风格的视频。

- 支持多步骤蒸馏模型:提供1步、2步、4步和8步的蒸馏模型,用户根据自己的需求,在生成视频的速度和质量之间做出选择,以平衡生成速度和视频质量。

主要功能和特点:

- 快速视频生成: AnimateDiff-Lightning能够在几步内生成视频,相比传统的视频生成模型,它的速度更快。

- 风格兼容性: 该模型可以与多种基础扩散模型一起使用,这意味着它可以生成多种风格的视频,如现实风格或动漫风格。

- 无需特定调整: 即使在不同的基础模型上,AnimateDiff-Lightning也能保持高质量的视频生成,无需针对每个模型进行特定调整。

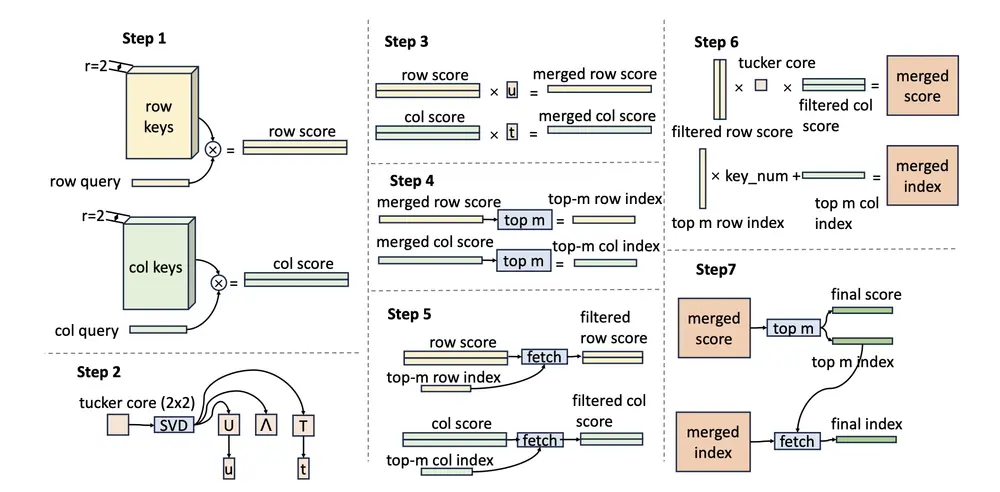

工作原理:

- 扩散模型: 扩散模型是一种生成模型,它通过逐步的迭代过程将随机噪声转化为有意义的数据分布。

- 蒸馏技术: 通过蒸馏技术,模型能够学习并预测数据分布的下一步,从而加快生成过程。

- 跨模型蒸馏: AnimateDiff-Lightning不仅在一个基础模型上进行蒸馏,而是同时在多个模型上进行,这样生成的动态模块就能够广泛适用于不同的风格。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...