加州大学圣克鲁斯分校、杭州电子科技大学和新加坡理工学院的研究人员推出一个用于长篇故事视觉化的迭代框架Story-Adapter,Story-Adapter能够根据长篇故事的文字描述生成一系列既连贯又具有丰富细节的图像。这就像是一个将文字故事变成电影画面的魔法师,它能够理解故事的情节,然后创造出一系列展现故事进程的图像。

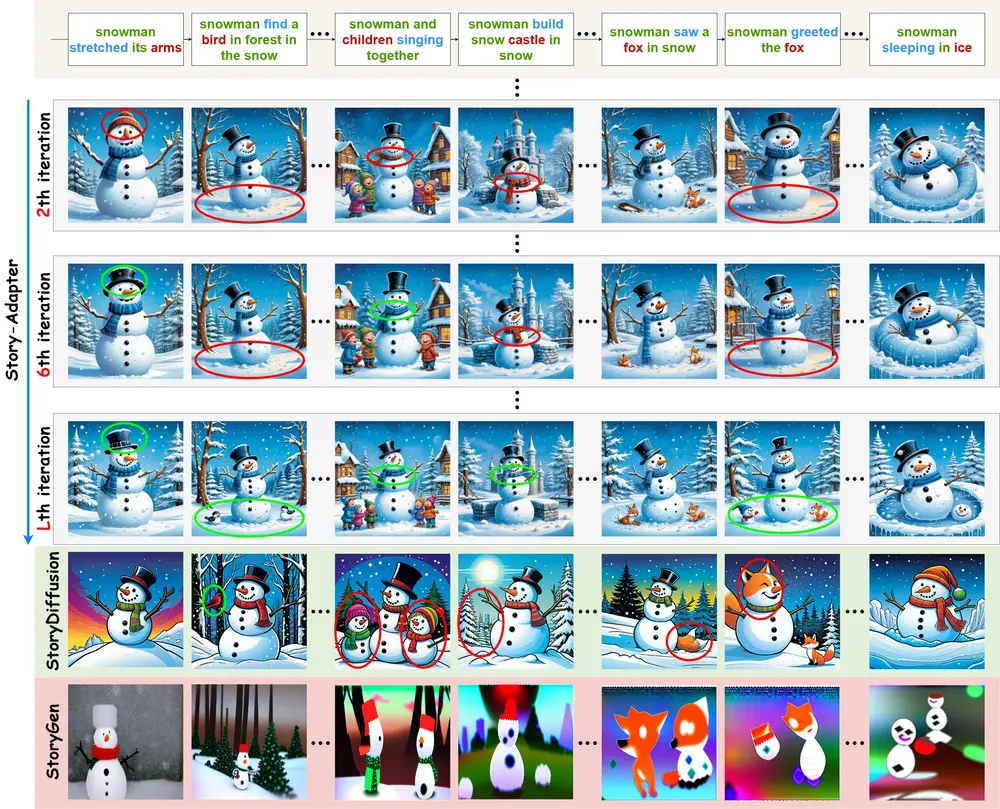

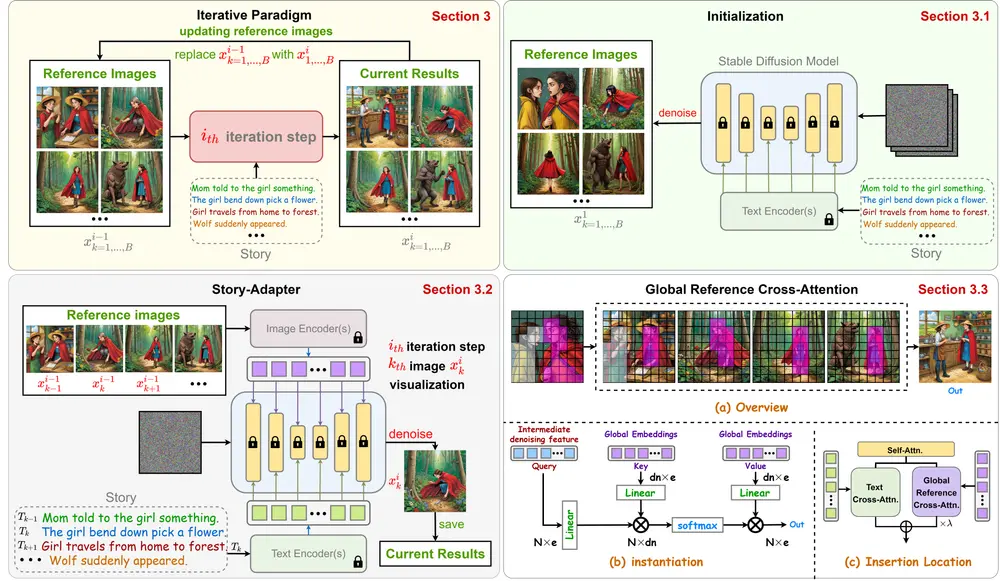

研究团队提出了一种迭代范式来细化每个生成的图像,利用文本提示和前一次迭代中生成的所有图像。Story-Adapter框架的核心是一个无需训练的全局参考交叉注意力模块,它从前一次迭代中聚合所有生成的图像,以在整个故事中保持语义一致性,同时通过全局嵌入最小化计算成本。这个迭代过程通过反复纳入文本约束,逐步优化图像生成,从而实现更精确和细粒度的交互。广泛的实验验证了 Story-Adapter 在提高语义一致性和细粒度交互生成能力方面的优越性,特别是在长故事场景中。

主要功能:

Story-Adapter的主要功能是将长篇故事的文字描述转换成一系列连贯的图像。它能够处理多达100帧的长故事,保持图像之间的语义一致性,并生成高质量的、细节丰富的交互画面。

主要特点:

- 无需训练:Story-Adapter是一个无需额外训练的框架,可以直接应用于预训练的稳定扩散模型(Stable Diffusion models)。

- 迭代优化:通过迭代的方式,Story-Adapter在每次迭代中都使用前一次生成的所有图像来指导当前图像的生成,这样可以逐步提升图像序列的语义一致性和视觉细节。

- 全局引用交叉注意力模块(GRCA):这是一个高效的插件式模块,它使用全局图像嵌入来降低计算成本,同时保持故事全局语义的一致性。

工作原理:

Story-Adapter的工作原理基于以下几个步骤:

- 初始化:首先,仅使用故事的文本提示来生成参考图像。

- 迭代过程:在后续的迭代中,Story-Adapter会利用前一轮生成的所有图像的全局嵌入,以及文本嵌入,共同指导图像生成过程。这个过程通过全局引用交叉注意力模块(GRCA)来实现,它聚合了前一轮生成的所有图像的全局嵌入,以保持整个故事的语义一致性。

- 平衡文本控制和视觉一致性:Story-Adapter引入了线性加权策略,在迭代过程中平衡文本控制和视觉一致性,以生成既符合文本描述又具有连贯视觉风格的图像序列。

具体应用场景:

Story-Adapter的应用场景包括:

- 故事创作:作家或编剧可以使用Story-Adapter将他们的故事草稿转换成一系列视觉化的画面,帮助他们更好地构思和规划故事。

- 教育和学习:在教育领域,教师可以利用Story-Adapter将教科书中的故事转换成图像序列,增强学生的学习体验。

- 娱乐和游戏:在游戏设计中,Story-Adapter可以用于生成游戏中的故事情节画面,提供更加丰富和动态的视觉体验。

- 广告和营销:营销人员可以利用Story-Adapter根据产品故事或广告文案生成一系列吸引人的图像,用于广告宣传。

总的来说,Story-Adapter是一个强大的工具,它能够将长篇故事的文字描述转换成一系列高质量、语义连贯的图像,为各种需要故事视觉化的应用提供了新的可能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...