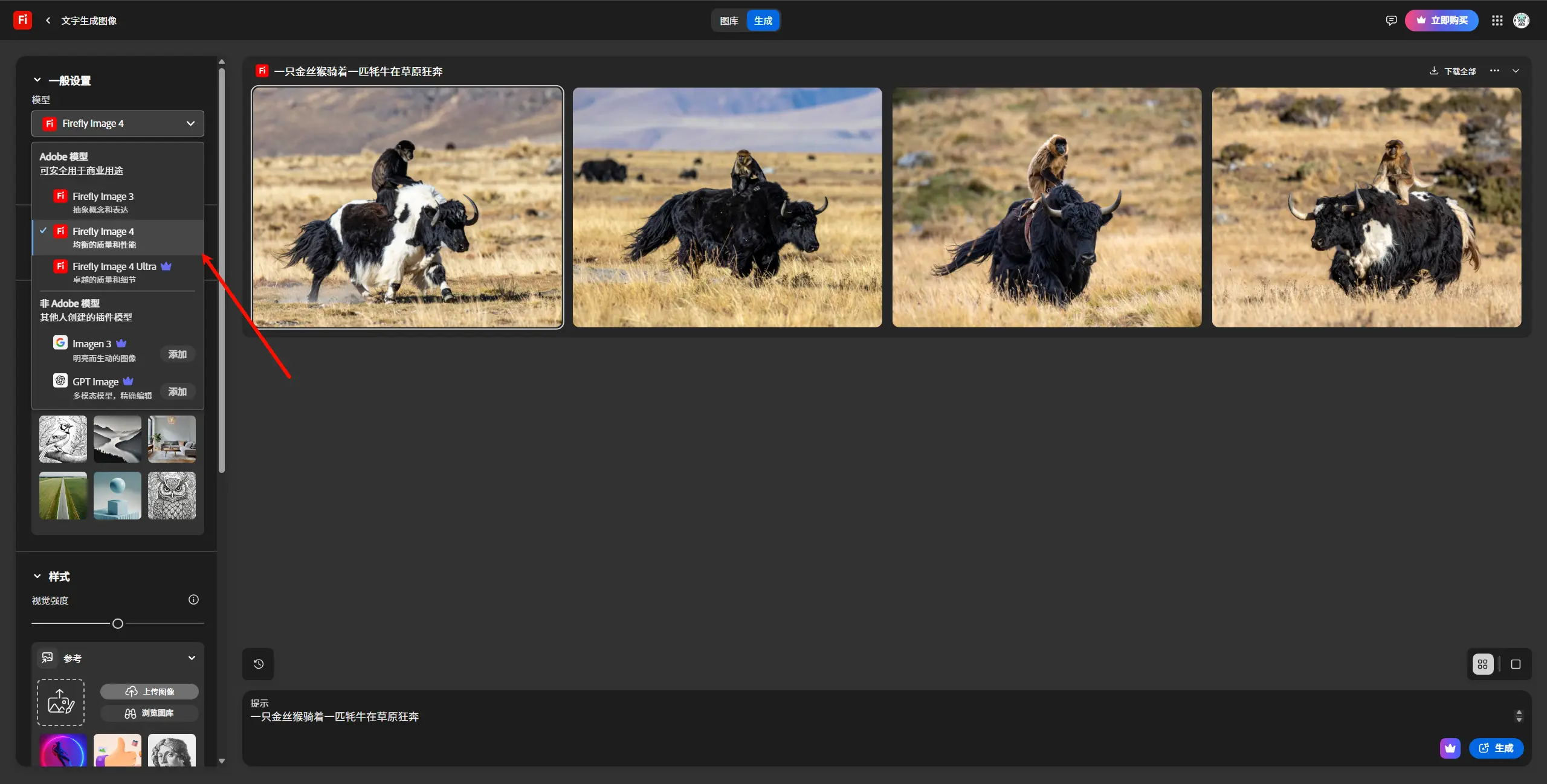

日本AI团队Sakana AI发布了专门用于生成浮世绘风格的生成模型Evo-Ukiyoe和浮世绘上色模型Evo-Nishikie,此模型是是以转为日语打造的图像生成模型Evo-SDXL-JP为基础,通过大规模学习浮世绘图像,创建了一个既能对应日语,又学习了浮世绘特征的图像生成模型,经测试也支持英文提示词。(官方介绍)

本次发布的要点如下:

- Evo-Ukiyoe可以根据输入的日语提示生成浮世绘风格的图像。对于风景和穿和服的人物等浮世绘常见主题,可以生成接近真实浮世绘品质的图像。

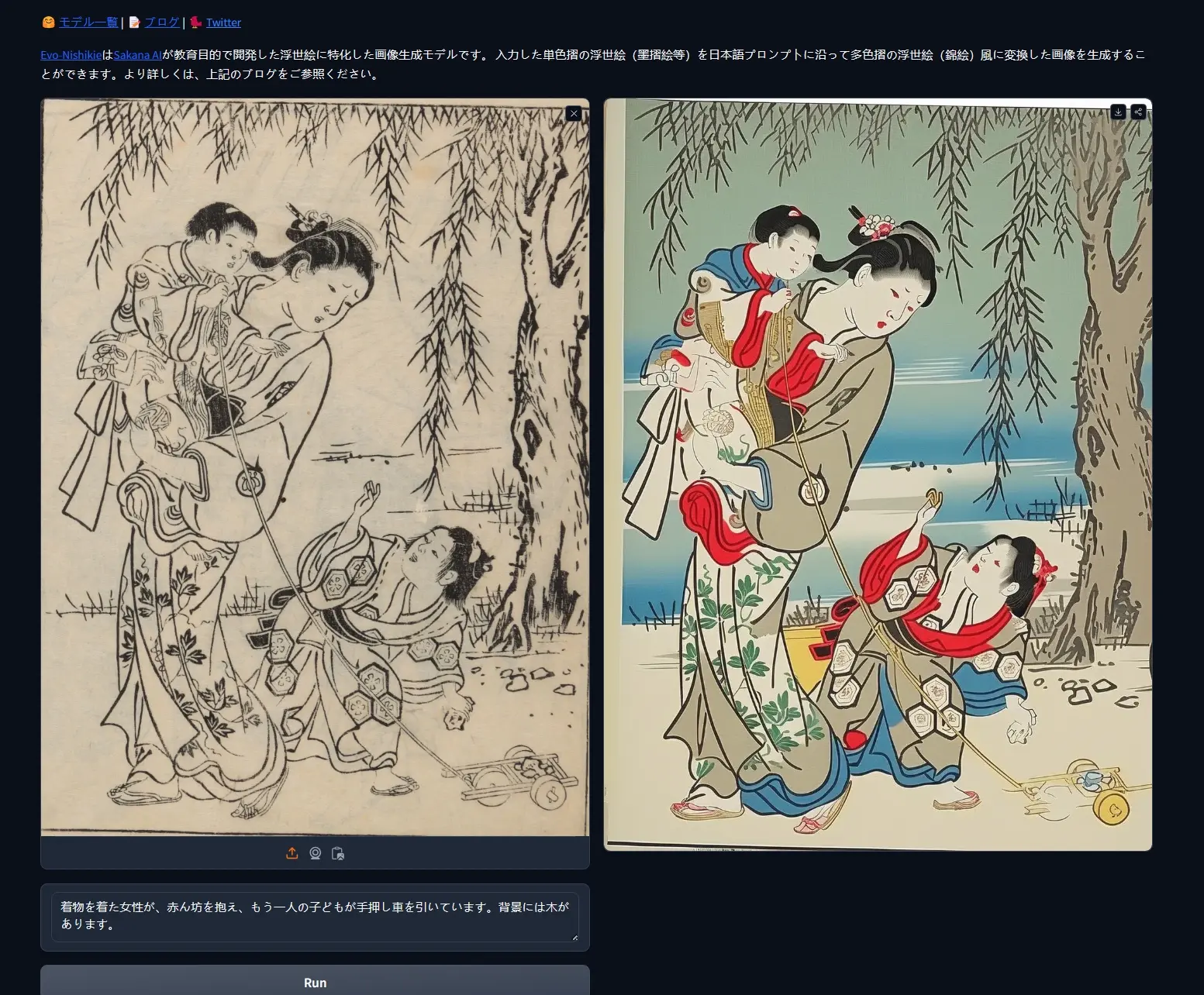

- Evo-Nishikie可以将单色印刷的浮世绘(如墨摺绘等)作为输入,生成多色印刷浮世绘(锦绘)风格的图像。它也可用于为江户时代单色印刷的书籍(古典籍)插图上色,或将多色印刷的锦绘转换为其他颜色。

- Evo-Ukiyoe和Evo-Nishikie的学习数据集使用了日本立命馆大学艺术研究中心(ARC)收藏的24,038张浮世绘作品的数字图像。

Evo-Ukiyoe和Evo-Nishikie已在HuggingFace网站上公开发布模型,也公开了Demo。

模型介绍

浮世绘是代表日本的艺术之一,在全球范围内知名度高且广受欢迎。因此,在图像生成模型领域,许多人尝试生成浮世绘风格的图像。然而,现有的图像生成模型并未专门针对浮世绘进行学习,即使在提示中输入"浮世绘(Ukiyoe)",也常常生成包含日本元素的插画风格图像,而不是真正的浮世绘风格。为了生成更接近实际浮世绘的图像,该团队致力于构建一个反映日本传统元素和色彩的图像生成模型。

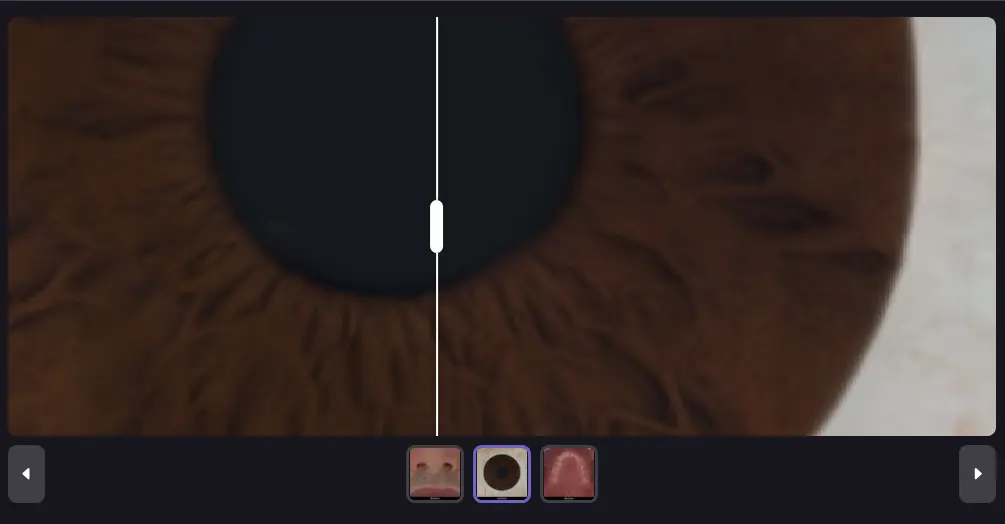

最重要的是数据集。为了让AI学习浮世绘,高质量、高分辨率的大规模浮世绘数据集至关重要。因此,Sakana AI在立命馆大学艺术研究中心(ARC)中心主任赤间亮教授的协助下,从ARC收藏的浮世绘作品数字图像中,主要选择了色彩优美的多色印刷锦绘,同时考虑多样性,选取了广泛主题的浮世绘。团队构建了一个包含24,038张图像的浮世绘数据集,包括全图和脸部中心图像。

Evo-Ukiyoe和Evo-Nishikie是基于这个浮世绘数据集学习的图像生成模型。Evo-Ukiyoe根据提示生成图像,而Evo-Nishikie则需要输入从古典籍插图创建的条件图像以及简单描述图像内容的提示,用于为插图上色。

Evo-Ukiyoe这个名字是基于SDXL构建的Evo-SDXL-JP中的"Evo"和"浮世绘(Ukiyoe)"组合而成。而Evo-Nishikie则是基于将单色图像转换为多色印刷(彩色印刷)的"锦绘(Nishikie)"这一目的命名的。

Evo-Ukiyoe

Evo-Ukiyoe是一个文生图模型,使用图像数据和说明文字对作为学习数据集。为了为浮世绘图像添加描述内容的说明文字,团队使用大规模多模态模型,通过少样本提示生成说明文字。然后手动修正说明文字中的错误(如人物性别等),并根据Evo-SDXL-JP的最大提示长度(77个标记)进行调整,如缩短说明文字、只添加明确特征、删除复杂的专业术语(如鸟笼纹样或梅花纹样)等。

使用这个学习数据集,团队以Evo-SDXL-JP为基础模型,通过LoRA进行了微调。

在生成时,输入提示来生成图像。然而,为了生成更接近浮世绘的图像,在提示中包含樱花、富士山、和服、鸟等浮世绘常见元素会更有效。另一方面,虽然也可以生成江户时代不存在的物品(如电脑或汉堡),但由于学习数据集中不存在这些物品,很难以浮世绘风格生成它们,可能会导致生成的整体图像不太像浮世绘。

Evo-Nishikie

Evo-Nishikie是一个Image-to-Image模型,使用提示和条件图像对作为学习数据集。首先,对于提示,我们对所有图像应用了简洁的固定提示,如"请将这个图像上色"。在学习时使用简洁的固定提示而不是复杂的提示,使任务变得更容易,精度也更好。对于条件图像,我们使用了Lineart,它在一定程度上保留了原始图像信息,同时留有创造性生成的空间。然而,由于浮世绘图像可能包含虫蛀、污渍和劣化等问题,需要进行噪声处理。因此,我们应用了ControlNet-Aux库的LineartDetector,使用OpenCV进行噪声去除,并通过二值化去除原始图像的浓淡信息,从而创建条件图像。

使用这个学习数据集,以Evo-Ukiyoe(Evo-SDXL-JP + LoRA)为基础模型,进行了ControlNet的学习。

在生成时,只需指定原始图像即可进行上色。然而,为了实现更美观的上色效果,在提示中包含有关所需颜色或目标物体的具体指示会更有效。

相关文章