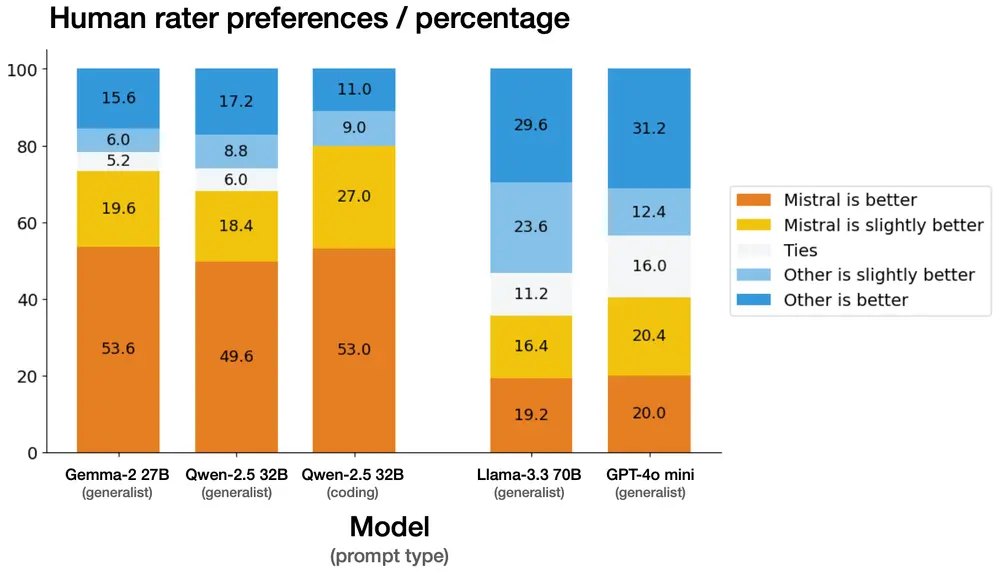

法国AI初创公司Mistral最近发布了其最新的人工智能模型——Mistral Small 3。这款拥有24亿参数的模型特别针对延迟进行了优化,并根据Apache 2.0许可证开放源代码。Mistral Small 3不仅能够与更大规模的模型(例如Llama 3.3 70B或Qwen 32B)相匹敌,而且相比专有的GPT4o-mini等不透明模型,它提供了一个优秀的开源替代方案。

- 官方介绍:https://mistral.ai/news/mistral-small-3

- Hugging Face:https://huggingface.co/mistralai/Mistral-Small-24B-Instruct-2501

- Ollama:https://ollama.com/library/mistral-small

主要特点

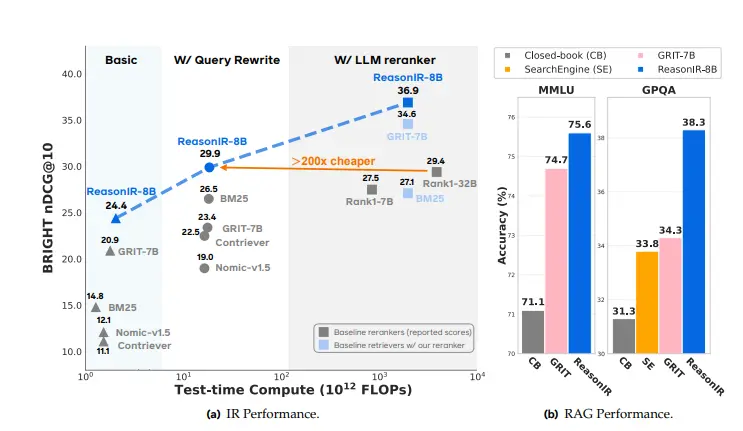

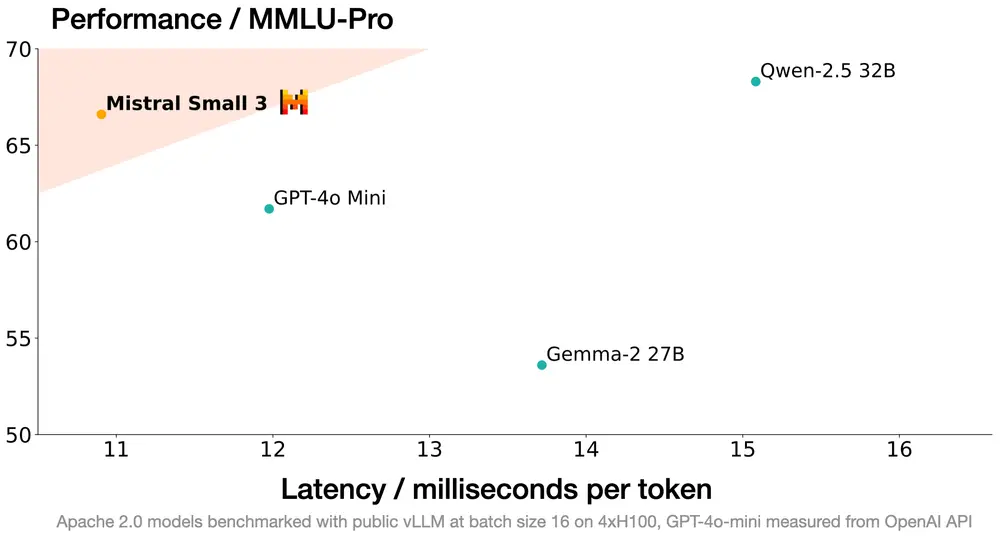

- 性能卓越:Mistral Small 3在执行速度上比同类硬件上的大型模型快3倍以上,同时保持了相当的性能水平。

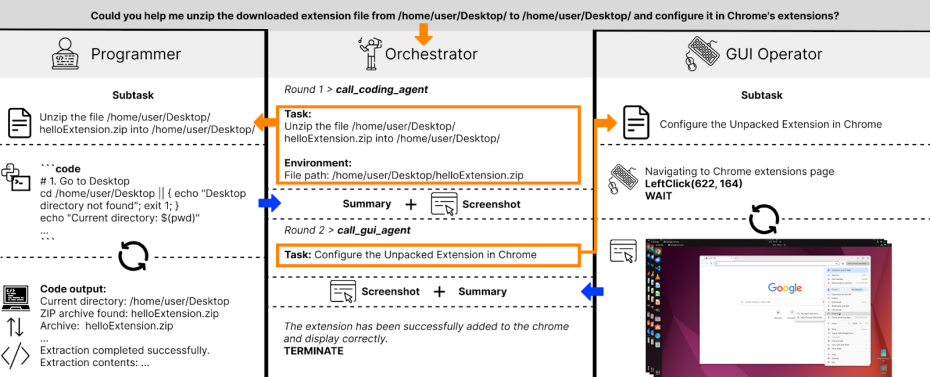

- 预训练和指令调整:该模型专为需要低延迟响应的生成式AI任务设计,如对话辅助、快速函数调用以及微调以创建领域专家。

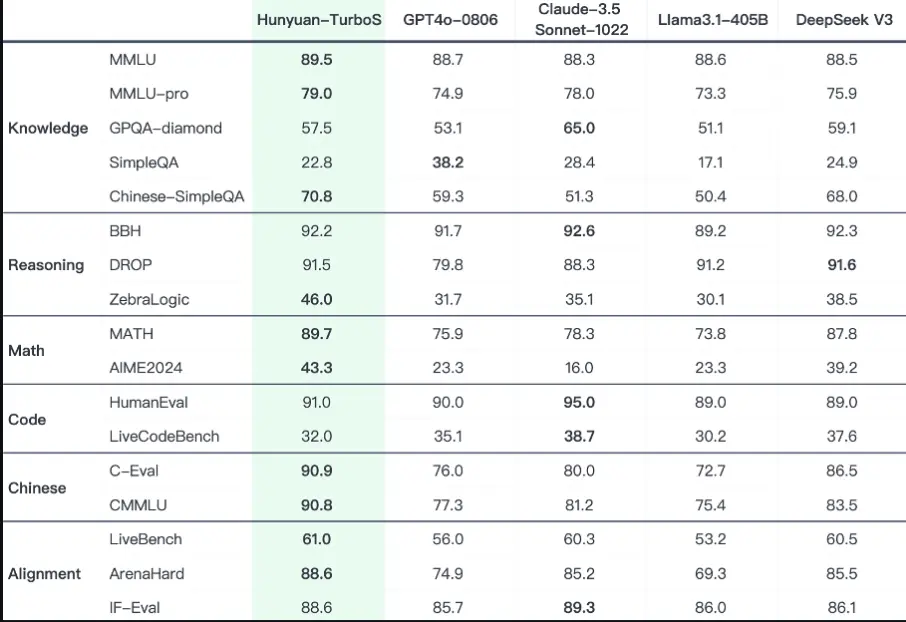

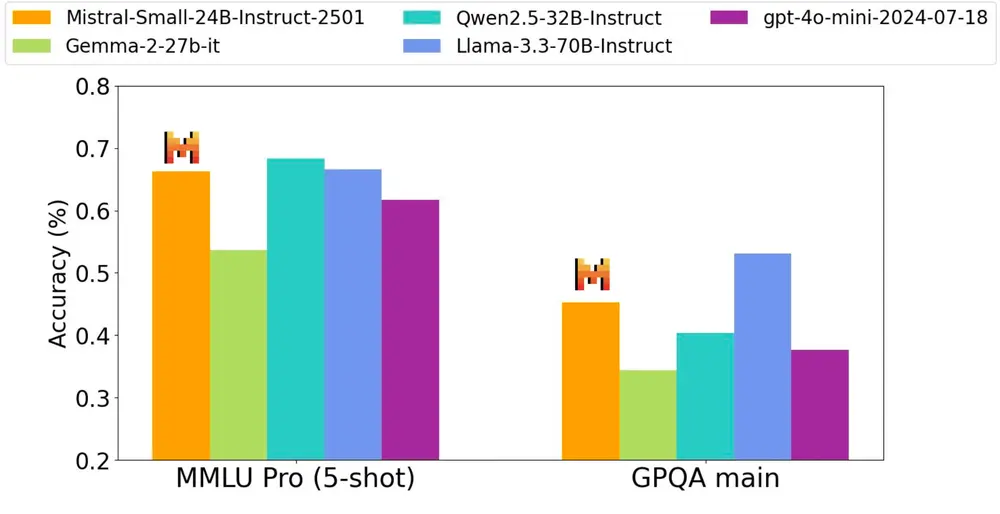

- 效率高:尽管层数较少,但Mistral Small 3在多项基准测试中表现出色,特别是在MMLU准确率上超过了81%,达到了每秒150个token的处理速度。

使用场景

Mistral Small 3适用于多种场景,包括但不限于:

- 快速响应的对话助手

- 需要低延迟执行的自动化流程

- 微调以产生特定领域的专家系统,如法律咨询、医疗诊断和技术支持

- 对敏感信息处理需求的本地推理

可访问性

Mistral Small 3现已可通过多个平台获取,包括Hugging Face、Ollama、Kaggle、Together AI、Fireworks AI等,方便开发者和研究人员使用。此外,Mistral计划在未来几周内推出增强版本,进一步提升推理能力。

社区贡献

Mistral承诺继续对其通用模型使用Apache 2.0许可证,鼓励开源社区的参与和改进。这表明了公司对推动技术进步和开放合作的支持态度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...