阿里巴巴通义实验室推出基于指令的图像生成和编辑框架ACE++,这是之前介绍过的新型多模态生成模型ACE升级版,ACE++ 通过改进的长上下文条件单元(LCU++)和两阶段训练方案,能够高效地利用预训练的文本到图像扩散模型(如 FLUX.1-dev),实现多种图像生成和编辑任务。它不仅支持通用的图像编辑指令,还针对特定场景提供了轻量级的微调模型,具有广泛的应用前景,如局部编辑、虚拟试穿、品牌 Logo 嵌入、海报编辑和角色替换等。

- 项目主页:https://ali-vilab.github.io/ACE_plus_page

- GitHub:https://github.com/ali-vilab/ACE_plus

- 模型:Hugging Face|ModelScope

- Demo:Hugging Face|ModelScope

主要功能

- 图像生成:根据文本指令生成高质量的图像。

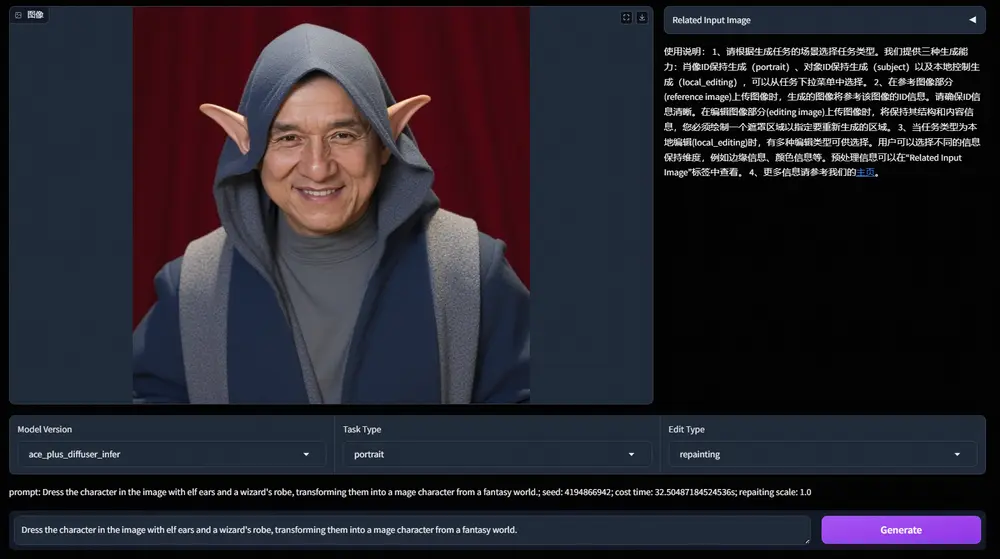

- 图像编辑:支持局部编辑、风格转换、内容替换等多种编辑任务。

- 参考图像生成:在给定参考图像的基础上生成新的图像,保持特定对象或风格的一致性。

- 多模态输入支持:支持文本、图像、掩码等多种输入形式,实现复杂的图像生成和编辑任务。

例如

- 图像生成:输入描述“一只在城市街道上的狐狸,周围是来来往往的人群”,ACE++ 可以生成符合描述的图像。

- 图像编辑:输入描述“将图像中的苹果移除”,ACE++ 可以根据掩码区域移除图像中的苹果。

- 参考图像生成:输入描述“将图像中的角色替换为穿着中世纪骑士盔甲的形象”,ACE++ 可以生成角色穿着盔甲的新图像。

主要特点

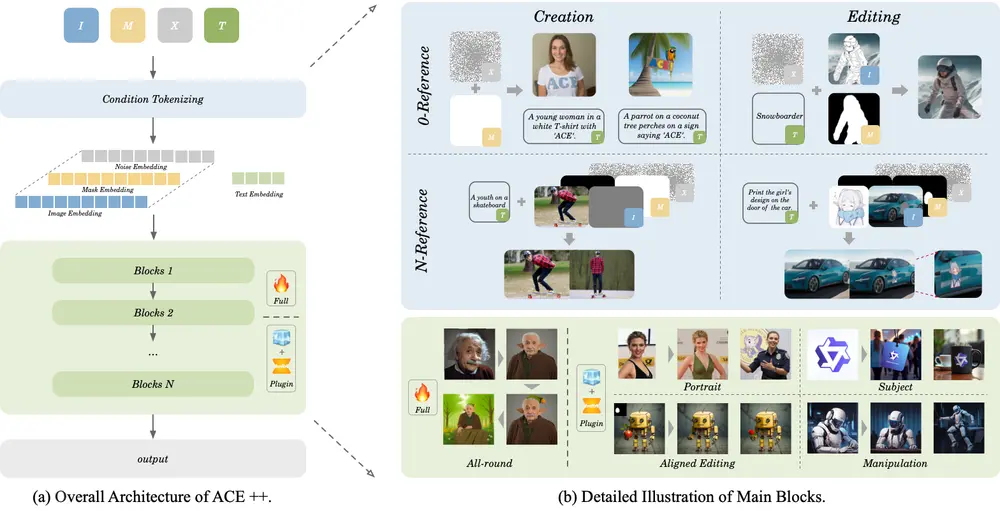

- 改进的长上下文条件单元(LCU++):通过将多模态输入沿通道维度拼接,而不是沿序列维度拼接,减少了模型适应多模态输入的训练成本。

- 两阶段训练方案:

- 第一阶段:基于文本到图像模型进行预训练,快速适应无参考图像的任务(0-ref tasks)。

- 第二阶段:在所有任务数据上进行微调,支持通用指令和多任务学习。

- 轻量级微调模型:针对特定应用场景(如肖像一致性、局部编辑等)提供轻量级模型,降低推理成本。

- 高质量生成和指令跟随能力:通过优化训练目标和上下文感知机制,生成高质量图像并准确跟随文本指令。

工作原理

- 输入定义:

- ACE++ 的输入包括文本指令、参考图像、掩码和噪声潜变量。通过 LCU++ 将这些输入沿通道维度拼接,形成统一的输入格式。

- 对于无参考图像的任务(0-ref tasks),输入格式为

[Iin; Min; Xt],其中Iin和Min是可选的输入图像和掩码,Xt是噪声潜变量。 - 对于有参考图像的任务(N-ref tasks),多个参考上下文沿序列维度拼接。

- 模型架构:

- 基于 FLUX.1-dev 的全注意力框架,将输入的图像、掩码和噪声通过 x-embed 层映射为序列化标记,然后输入到 Transformer 层。

- 训练目标是最小化预测速度

vt和真实速度ut之间的均方误差,通过上下文感知机制生成高质量图像。

- 两阶段训练:

- 第一阶段:使用文本到图像模型的 0-ref 任务数据进行预训练,快速适应多模态输入。

- 第二阶段:在所有任务数据上进行微调,支持通用指令和多任务学习。

- 优化和微调:

- 使用 AdamW 优化器进行训练,设置权重衰减和学习率,采用梯度裁剪稳定训练过程。

- 针对特定应用场景,采用轻量级微调策略(如 LoRA)训练轻量级模型。

具体应用场景

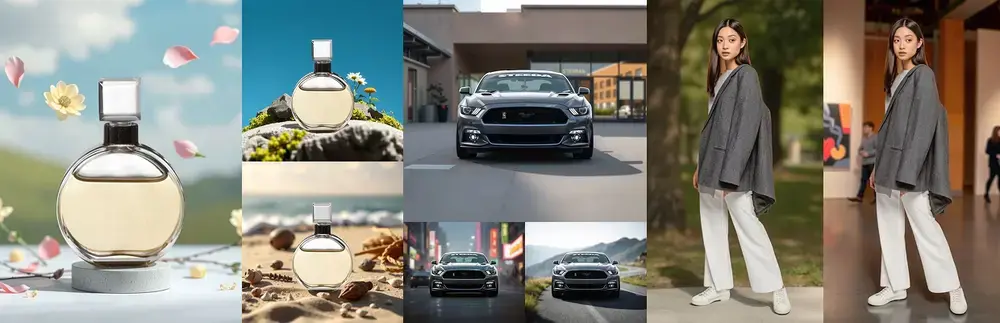

- 广告和营销:生成符合特定风格和场景的广告图像,如将品牌标志添加到产品图像中。

- 影视特效:生成高质量的肖像图像,用于电影和电视剧的特效制作。

- 电商设计:生成产品展示图像,如将商品放置在不同的背景或场景中。

- 游戏开发:生成游戏中的角色和场景,支持风格一致的图像生成。

- 社交媒体内容创作:快速生成符合用户需求的图像和视频内容。

- 教育和培训:生成教育材料中的图像,如将历史人物放置在特定的历史场景中。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...