阿里巴巴Wanx 团队推出新型多模态生成模型ACE,这个模型的核心功能是处理和生成图像,但它与传统的图像处理工具不同,因为它可以根据文本指令来执行复杂的图像编辑和生成任务。例如,你是一名摄影师,你拍摄了一张风景照片,但你想改变照片中的天空颜色,使其看起来更加鲜艳。你可以使用ACE模型,输入文本指令如“将天空颜色改为鲜艳的橙色”,模型就会根据你的指令生成修改后的照片。

- 项目主页:https://ali-vilab.github.io/ace-page

- GitHub:https://github.com/modelscope/scepter

- 模型:https://huggingface.co/scepter-studio/ACE-0.6B-512px

- Demo:https://huggingface.co/spaces/scepter-studio/ACE-Chat

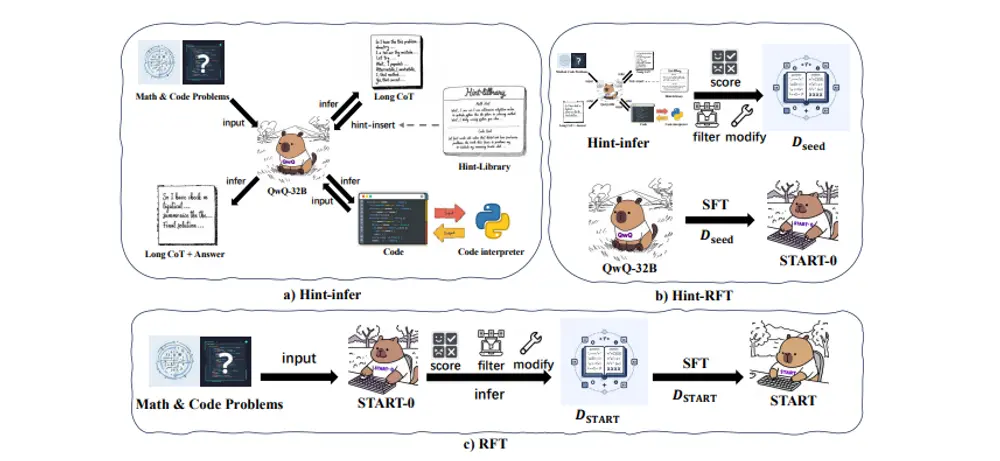

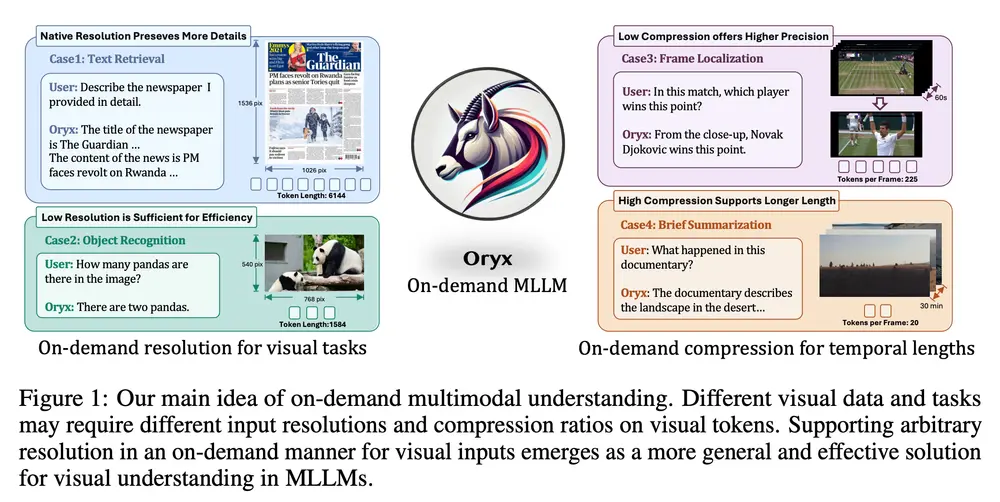

ACE在广泛的视觉生成任务中与那些专家模型相比达到了相当的性能。为了实现这个目标,研究人员首先引入了一种统一的条件格式,称为长上下文条件单元(LCU),并提出了一种新颖的基于Transformer的扩散模型,该模型使用LCU作为输入,旨在针对各种生成和编辑任务进行联合训练。此外,研究人员提出了一种高效的数据收集方法来解决这个问题,即缺乏可用的训练数据。它涉及使用基于合成或基于聚类的管道获取成对的图像,并通过利用微调的多模态大型语言模型为这些图像对提供准确的文本指令。为了全面评估此模型的性能,研究人员在各种视觉生成任务中发布了一个手动注释的图像对基准。

主要功能:

ACE的主要功能包括:

- 文本引导的图像生成:根据文本描述生成新的图像。

- 图像编辑:根据文本指令对现有图像进行编辑,如改变图像的风格、添加或删除对象等。

- 多模态条件输入:支持多种输入条件,包括文本、图像、遮罩等。

主要特点:

- 统一的条件格式:引入了一种名为长上下文条件单元(LCU)的统一条件格式,可以处理各种生成和编辑任务。

- Transformer-based 模型:基于Transformer的模型设计,可以处理长序列的文本和图像数据。

- 高效的数据收集方法:为了解决训练数据不足的问题,提出了一种高效的数据收集方法,通过合成或聚类生成图像对,并利用微调的多模态大型语言模型生成准确的文本指令。

工作原理:

ACE模型使用一个编码器-解码器架构,其中文本指令通过一个语言模型(如T5)进行编码,图像则通过一个变分自编码器(VAE)进行压缩和编码。这些编码后的数据被送入一个基于Diffusion Transformer的模型中,该模型通过多个注意力块和交叉注意力块来处理文本和图像数据,生成所需的输出图像。

具体应用场景:

- 内容创作:艺术家和设计师可以使用ACE根据文本描述生成新的艺术作品或设计草图。

- 社交媒体:用户可以快速编辑他们的照片,添加文本或改变风格,然后分享到社交媒体。

- 教育和培训:在教育领域,ACE可以用来生成教学材料中的图像,如科学图表或历史场景的插图。

总的来说,ACE模型通过其创新的输入格式和高效的数据处理能力,在视觉生成领域提供了一个多功能的工具,可以广泛应用于各种图像编辑和生成任务。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...