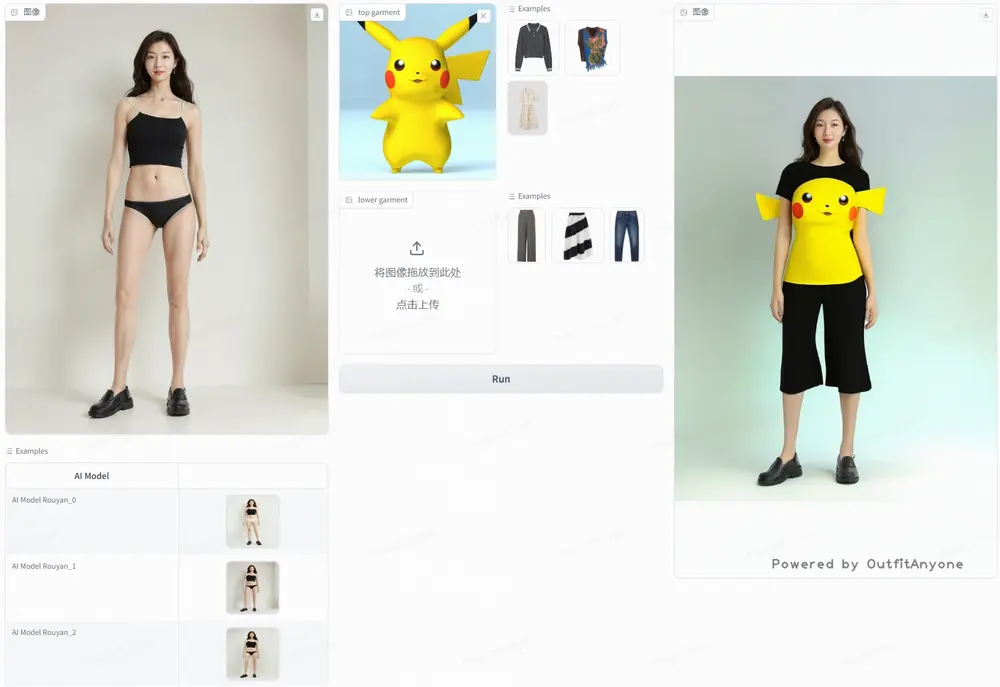

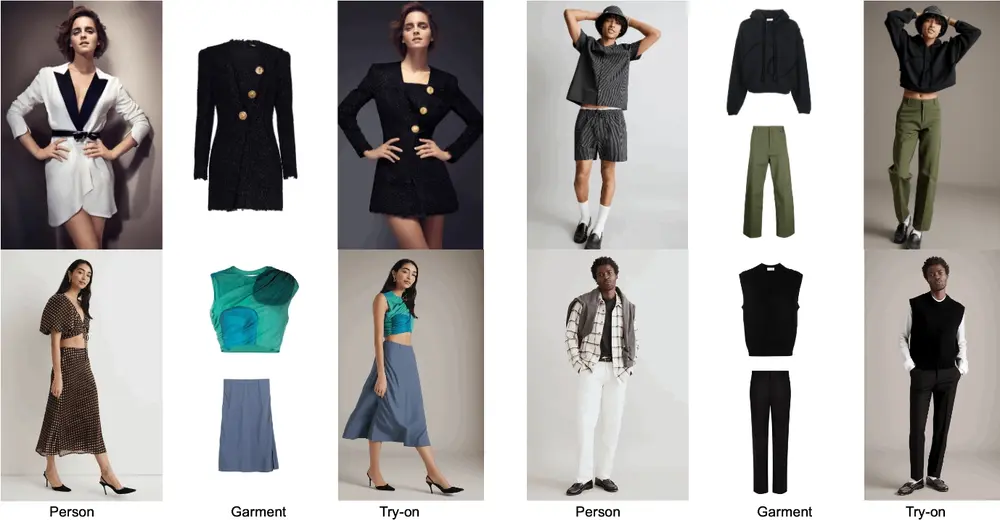

阿里巴巴和中国科学技术大学的研究人员推出新的虚拟试穿技术OutfitAnyone,它是一个基于扩散模型的2D虚拟试穿框架。Outfit Anyone 通过利用双流条件扩散模型解决了这些局限性,使其能够巧妙地处理服装变形,从而获得更逼真的效果。该技术以其可扩展性(如调整姿势和体型等因素)以及广泛的适用性(从动漫到真实世界的图像)而脱颖而出。

- 项目主页:https://humanaigc.github.io/outfit-anyone

- GitHub:https://github.com/HumanAIGC/OutfitAnyone

- Demo:https://modelscope.cn/studios/DAMOXR/OutfitAnyone

例如,你是一位时尚博主,想要为你的社交媒体账户创建一些独特的穿搭内容。使用OutfitAnyone,你只需上传自己的照片和你感兴趣的衣服图片,系统就会生成你穿着这些衣服的虚拟形象。无论是日常穿搭还是特殊场合的装扮,你都可以看到非常逼真的效果,这样你就可以选择最适合你的风格,并与你的追随者分享。此外,如果你是一个设计师,正在寻找灵感,OutfitAnyone可以帮助你快速预览不同设计元素的组合效果,加速你的创作过程。

主要功能

- 2D虚拟试穿:用户可以数字化地模拟衣服穿在自己身上的效果。

- 高保真和细节一致性:生成高清晰度、逼真的试穿图像,保持衣服图案和纹理的一致性。

主要特点

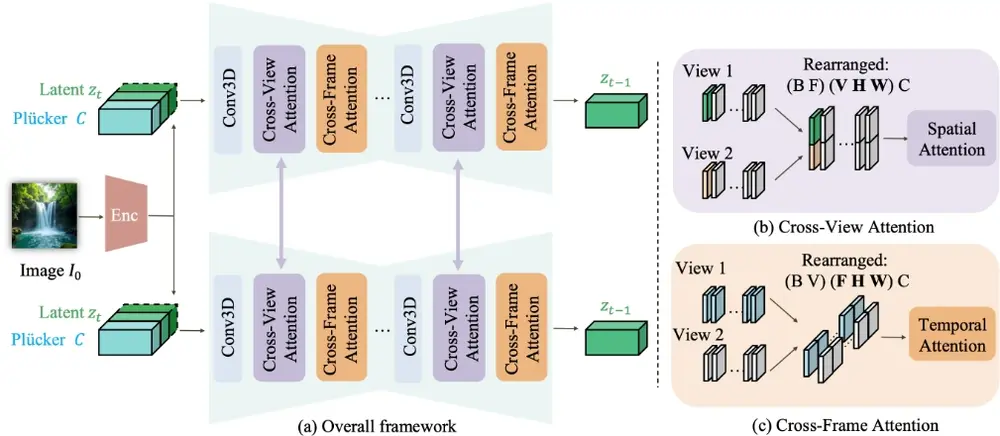

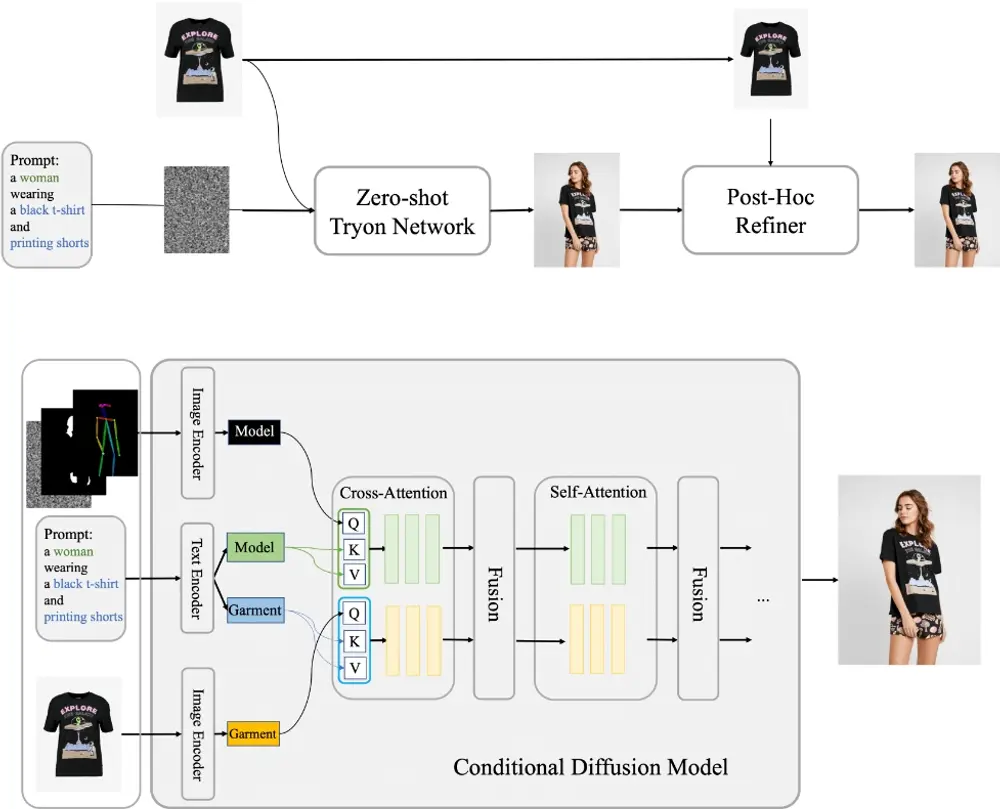

- 两流条件扩散模型:分别独立处理人体和衣服数据,然后融合以生成逼真的试穿效果。

- Zero-shot试穿网络:生成初始的试穿视觉效果。

- 事后细化器:细化最终输出图像中的衣物和皮肤纹理,提高细节质量。

工作原理

- 服装特征注入:使用预训练的自动编码器提取服装图像的特征,并将其注入到生成流程中。

- 无分类器引导:利用单一扩散模型处理条件和无条件数据,通过调整引导比例来控制生成过程。

- 背景和光照保留:通过人像分割模型获取服装遮罩,然后填充生成的服装区域,保持原有图像的背景和光照。

- 姿势和形状引导:使用姿势和形状引导器控制人体的姿势,确保在完整换装时保持身体轮廓的一致性。

- 细节细化:使用精选的高质量图像与模型生成的图像配对,训练扩散模型恢复细节,提高试穿效果的真实性。

具体应用场景

- 在线购物:顾客可以在家试穿网店的衣服,提高购物的便捷性和满意度。

- 时尚设计辅助:时尚设计师可以使用这项技术探索新款式和设计,甚至为单一上衣生成可能的下装搭配。

- 个性化推荐:根据用户的身形和偏好,推荐合适的服装搭配。

- 社交媒体:用户可以分享自己试穿不同服装的虚拟形象,增加互动乐趣。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...