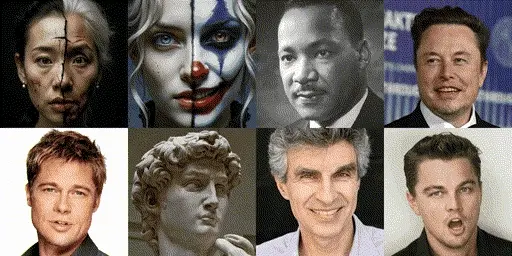

在处理真实场景图像时,实现一致的编辑效果是一个长期存在的技术挑战。这主要由于物体姿态、光照条件和摄影环境等不可控因素的影响。为了应对这些挑战,香港科技大学、蚂蚁集团、斯坦福大学和香港中文大学的研究人员共同提出了Edicho——一种基于扩散模型的图像编辑框架,它能够在野外环境(即非受控环境)中实现一致性的图像编辑。这个框架基于扩散模型,通过利用显式的图像对应关系来指导编辑过程,以确保在不同图像之间进行编辑时能够保持一致性。

例如,我们有两张不同角度拍摄的同一产品的图片,我们希望在这两张照片上应用相同的装饰元素(如添加相同的边框或文字标签)。Edicho能够确保这些编辑元素在两张图片上的位置和样式保持一致,即使这两张图片的拍摄条件、光照和背景都有所不同。

方法动机

在真实场景图像编辑中,现有方法通常存在以下问题:

- 基于学习的方法:缺乏适当的正则化,难以获取高质量的训练数据,并且难以强制执行一致性约束,导致编辑结果不稳定。

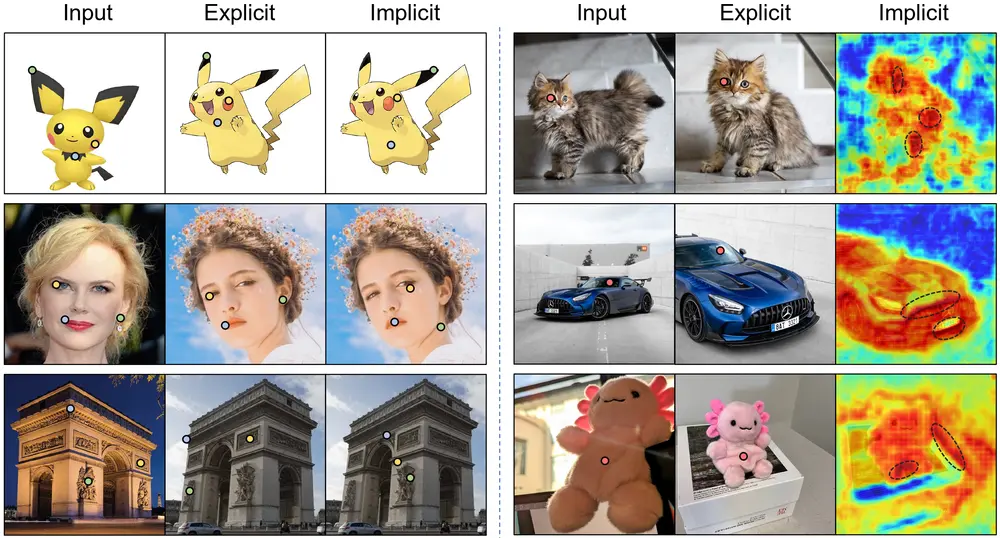

- 非优化方法:依赖于注意力特征的隐式对应关系进行外观迁移,但由于预测不稳定以及图像内在变化,经常产生不一致或失真的编辑结果。

为了解决这些问题,研究人员开发了Edicho,它通过显式地估计图像间的对应关系,提供了一种更稳定和可靠的方式来进行图像编辑。

主要功能

Edicho的主要功能包括:

- 一致性编辑:确保在多张图片上应用的编辑效果保持一致。

- 零样本学习:不需要额外的训练即可在新的图像上应用编辑。

- 显式对应关系:通过预测图像间的对应关系来指导编辑,提高编辑的准确性和一致性。

框架设计

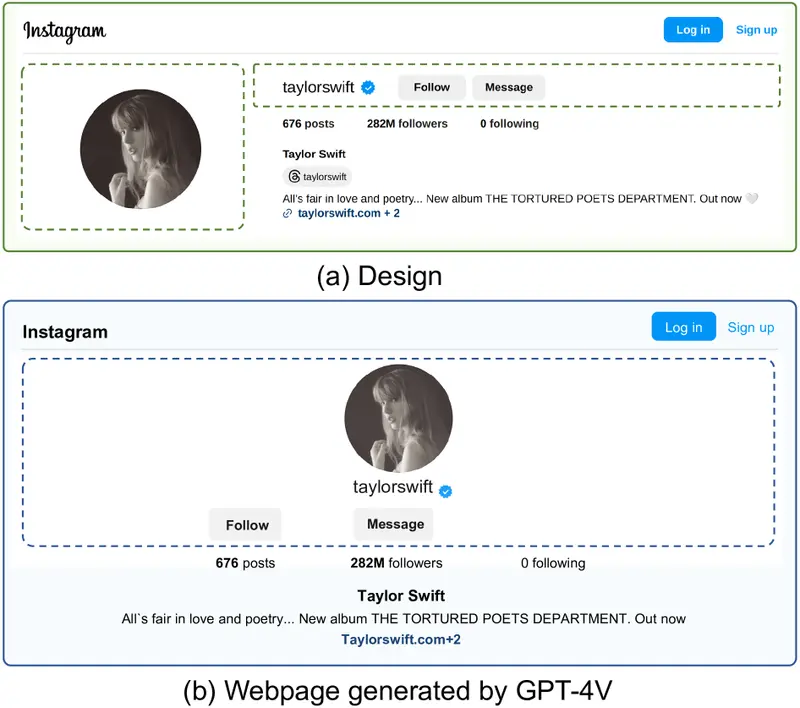

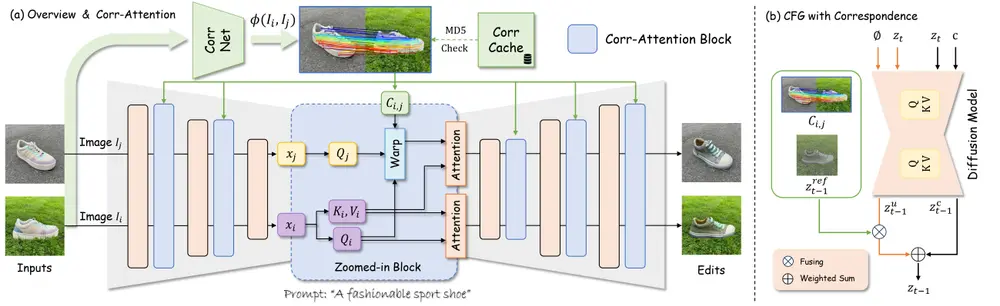

Edicho的主要贡献在于其即插即用特性及其与大多数基于扩散的编辑方法(如ControlNet和BrushNet)的兼容性。该框架包含两个关键组件:

- 注意力操纵模块:此模块利用预先估计的显式对应关系,在推理过程中动态调整注意力机制,以确保编辑过程中对重要区域的关注度。

- 精心优化的无分类器引导(CFG)去噪策略:这一策略同样考虑了预先估计的对应关系,通过在噪声潜在空间中应用CFG,使得生成的图像更加符合预期的编辑目标。

这两个组件共同作用,在两个层面上引导预训练扩散模型的去噪过程:一是注意力特征层面,二是噪声潜在空间层面。这样不仅提高了编辑的一致性,还增强了编辑结果的视觉质量。

工作原理

Edicho的工作原理包括以下几个关键步骤:

- 对应关系预测:使用预训练的对应关系提取器(如DIFT)预测输入图像间的对应关系。

- 注意力操作:根据预测的对应关系,调整源图像和目标图像间的注意力特征,以实现特征的有效转移。

- 无分类器引导(CFG):修改CFG计算,纳入对应关系信息,以更精细地控制编辑的一致性。

- 无条件嵌入融合:受NULL-text Inversion启发,融合无条件嵌入特征以增强一致性,同时不牺牲图像质量。

实验结果

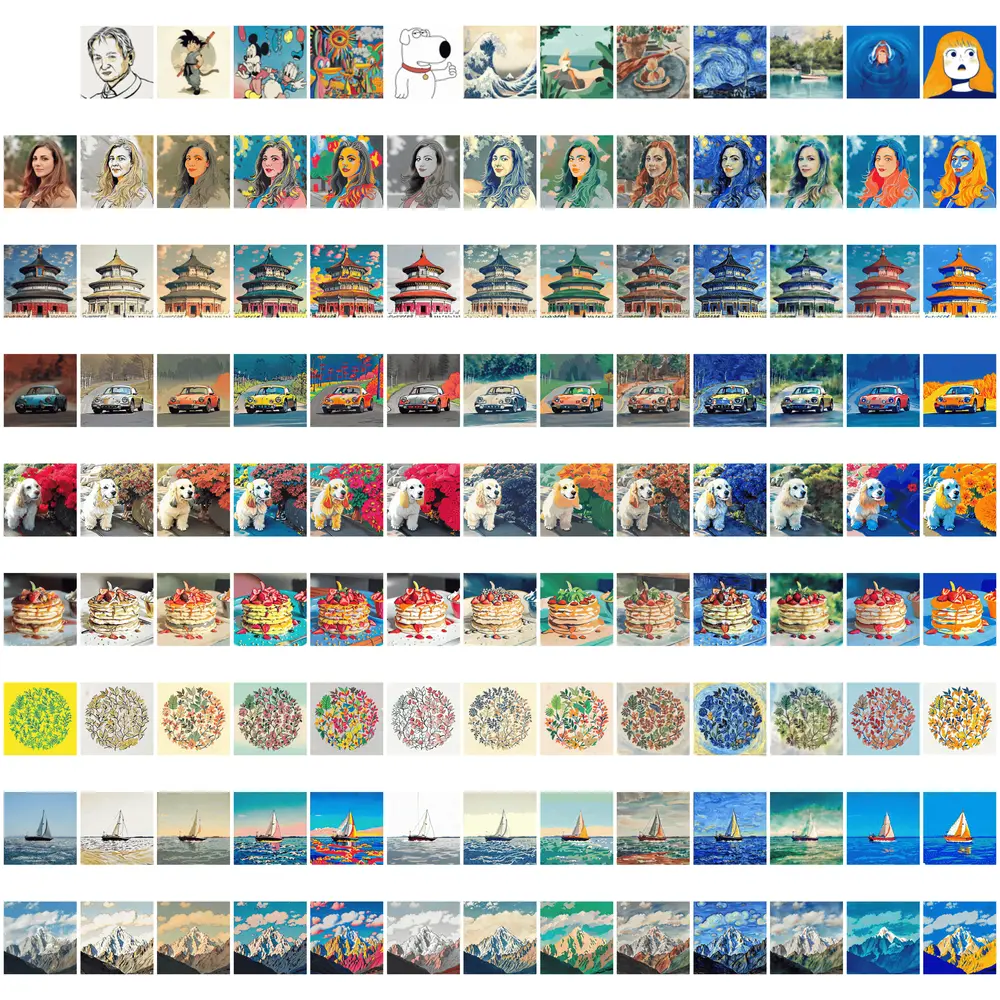

研究人员进行了大量的实验,验证了Edicho在多样化设置下能够有效实现跨图像的一致性编辑。实验包括全局编辑和局部编辑的定性比较,展示了Edicho相比其他定制化技术的优势。此外,研究团队还采用了神经回归器Dust3R,基于编辑结果进行3D重建,进一步证明了Edicho的有效性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...