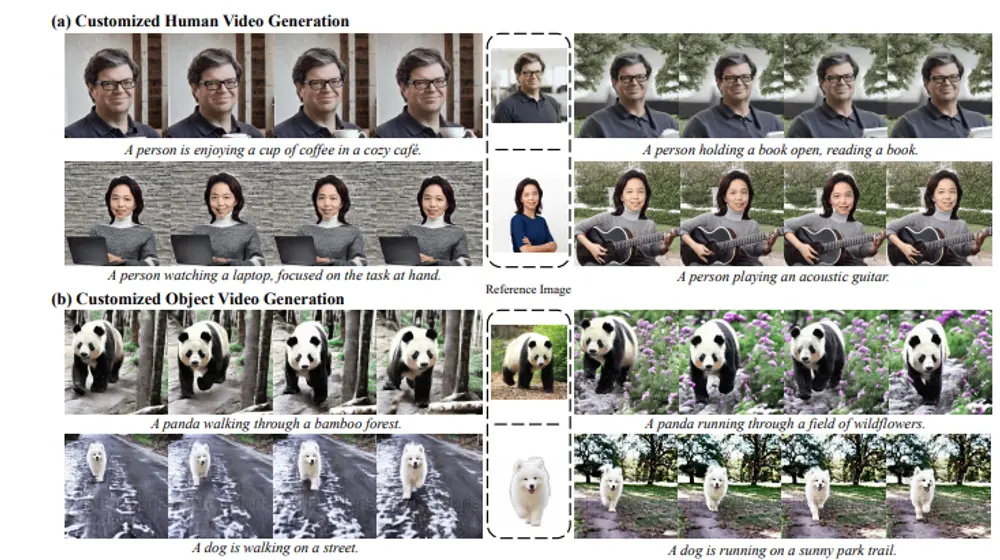

浙江大学计算机科学与技术学院、腾讯PCG ARC实验室、腾讯AI实验室和华为诺亚方舟实验室的研究人员推出新型框架VideoMaker,它能够实现高质量的零样本(zero-shot)定制化视频生成。这个框架利用视频扩散模型(Video Diffusion Models, VDMs)的内在力量来提取和注入主题特征,从而生成与给定主题(如人物或物体)一致的视频内容。

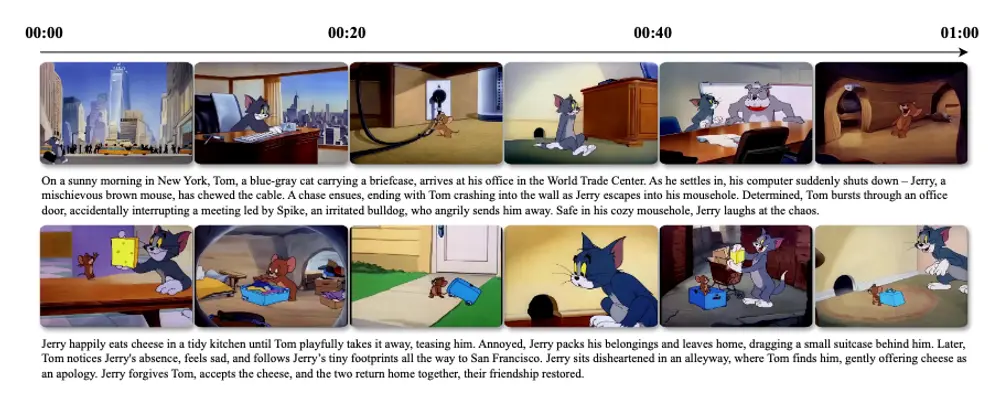

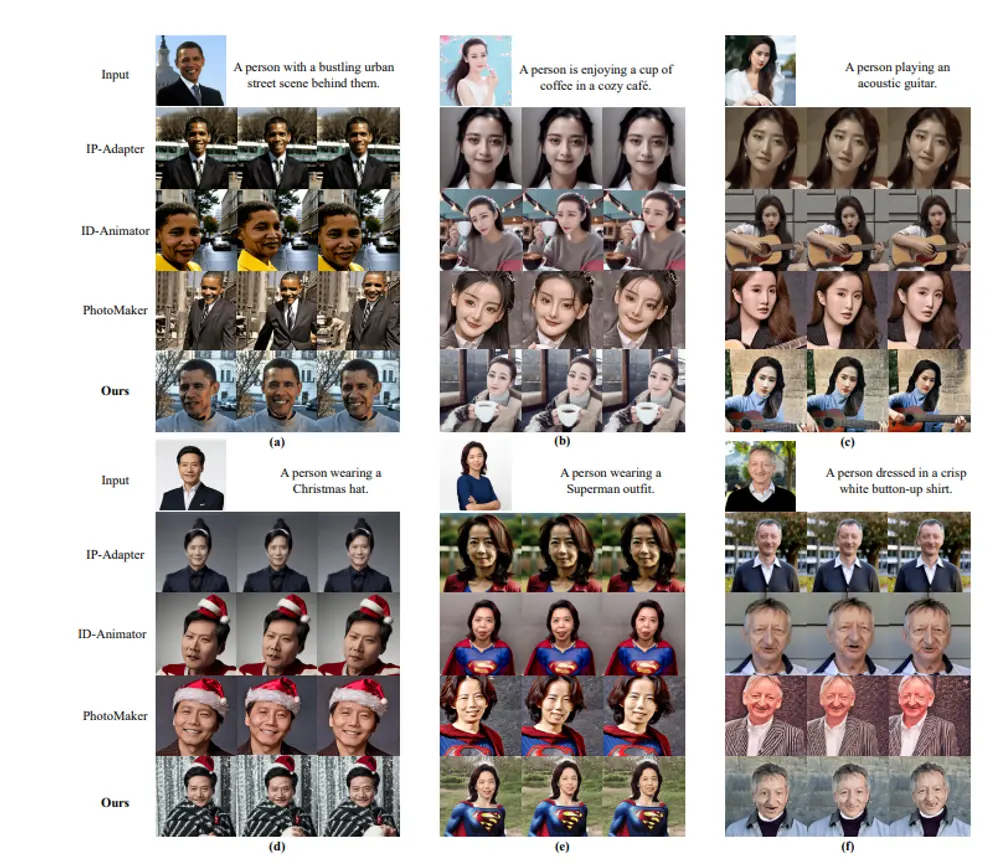

例如,我们有一张特定人物的照片,我们想要生成一个视频,视频中这个人物在不同的场景中进行各种活动,如喝咖啡、弹吉他或在公园散步。VideoMaker能够根据这张照片和给定的文字提示(如“一个人在咖啡馆享受咖啡”),生成一个视频,视频中的人物外观与照片保持一致,并且自然地执行指定的活动。

主要功能

VideoMaker的主要功能包括:

- 主题特征提取:直接输入参考图像到VDM中,利用模型的内在过程提取精细的主题特征。

- 主题特征注入:通过VDM中的空间自注意力机制,将主题特征与生成内容进行双向交互,确保生成的视频保持主题一致性。

- 零样本定制化视频生成:无需针对特定主题重新训练模型,即可生成与给定主题一致的视频。

主要特点

- 利用VDM的内在能力:不依赖于额外的模型来提取和注入主题特征,而是直接利用VDM的能力。

- 空间自注意力机制:通过空间自注意力机制实现主题特征与生成内容的交互,提高生成视频的多样性和质量。

- 简单的训练策略:通过设计的简单学习策略,提高模型在训练期间区分参考信息和生成内容的能力。

工作原理

VideoMaker的工作原理基于以下几个步骤:

- 主题特征提取:将参考图像输入到预训练的VDM中,模型在t=0时的特殊情况下(即无噪声输入)提取主题特征。

- 特征注入:在生成每一帧内容时,通过VDM的空间自注意力层将提取的主题特征与生成内容进行交互,确保主题在视频中的一致性。

- 训练策略:设计了一种简单的学习策略,通过引入引导信息识别损失(Guidance Information Recognition Loss),帮助模型在训练期间区分参考信息和生成内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...