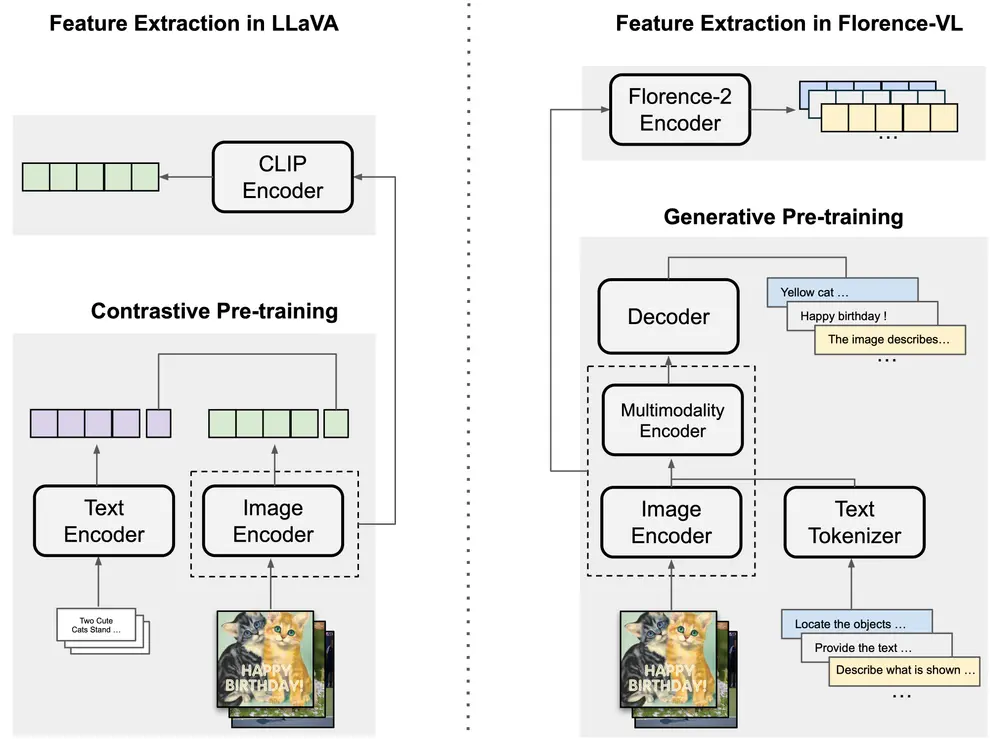

马里兰大学和微软研究院的研究团队共同提出了Florence-VL,这是一个全新的多模态大语言模型(MLLMs)家族。Florence-VL的视觉表示由生成式视觉基础模型Florence-2生成,与传统的通过对比学习训练的CLIP风格视觉变换器不同,Florence-2能够捕捉到更为丰富和多层次的视觉特征,适用于多样化的下游任务。

生成式视觉基础模型:Florence-2

Florence-2作为Florence-VL的核心,其优势在于能够生成具有多功能性的视觉特征。这些特征不仅涵盖了不同层次的视觉信息,还包含了多方面的视觉特性,如颜色、纹理、形状和空间关系等。这种丰富的视觉表示使得Florence-VL在处理复杂的视觉-语言任务时表现出色。

- 项目主页:https://jiuhaichen.github.io/florence-vl.github.io

- GitHub:https://github.com/JiuhaiChen/Florence-VL

- 模型:3B/8B

- Demo:3B/8B

例如,我们有一张图片,内容是“两只可爱的猫站在草地上”。传统的视觉编码器,如CLIP,可能只能提供一个高层次的、整体场景的语义表示,而忽略了图片中的具体细节,比如猫的局部特征或背景中的文本信息。Florence-VL则能够通过其深度和广度的视觉特征提取,不仅识别出图片的整体内容,还能捕捉到文本信息和对象间的空间关系等细节。

主要功能:

- 丰富的视觉表示:Florence-VL能够生成丰富的视觉特征,以适应不同的下游任务。

- 深度广度融合(DBFusion):模型能够融合来自不同深度和多种提示的视觉特征。

- 多模态理解:结合视觉和语言模型,以理解和生成跨模态内容。

主要特点:

- 生成性视觉编码器:使用Florence-2作为视觉编码器,能够生成多种任务特定的视觉特征。

- DBFusion架构:通过通道级联的方式融合不同深度和广度的视觉特征。

- 无需额外训练:Florence-VL可以直接在预训练的大型语言模型上进行微调,无需额外的训练过程。

特征融合架构与训练方法

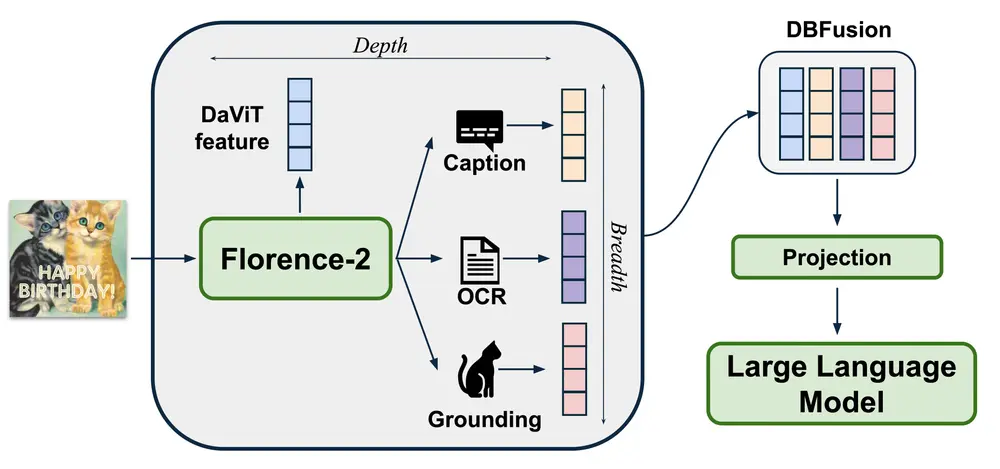

Florence-VL首先使用Florence-2从输入图像中提取不同深度(层次概念)和广度(提示)的视觉特征。然后,通过DBFusion将这些特征沿着通道维度进行融合,并将融合后的特征通过一个多层感知机(MLP)投影到语言模型的输入空间。在预训练阶段,使用详细的图像描述数据对Florence-2和语言模型进行端到端预训练。在指令调优阶段,使用多样化和高质量的指令调优数据集来适应下游任务。

为了有效地将Florence-2的视觉特征整合到预训练的大型语言模型中,研究人员提出了一种新颖的特征融合架构和创新的训练方法:

- 深度-广度融合(DBFusion):这一架构融合了从不同深度和多个提示下提取的视觉特征,确保了视觉信息的全面性和多样性。DBFusion通过结合浅层和深层特征,既保留了全局视觉结构,又捕捉到了局部细节。

- 端到端预训练与微调:模型首先进行端到端的预训练,随后在精心设计的包含高质量图像描述和指令调优对的多样化开源数据集上对投影层和大型语言模型(LLM)进行微调。这种方法确保了模型不仅在视觉-语言对齐方面表现优异,还能适应多种实际应用场景。

定量分析与可视化

通过对Florence-VL视觉特征的定量分析和可视化,研究人员展示了其在视觉-语言对齐方面的显著优势。丰富的深度和广度特征使得模型能够在复杂的视觉场景中准确地理解和生成相应的语言描述。Florence-VL在多个多模态和视觉中心基准测试中表现出色,涵盖了以下领域:

- 一般VQA(视觉问答)

- 感知任务

- 幻觉检测

- OCR(光学字符识别)

- 图表理解

- 知识密集型理解

实验结果显示,Florence-VL在这些任务上的表现显著优于现有的最先进MLLMs,证明了其在处理复杂多模态任务中的优越性。

相关文章