Moondream 是一款高效的开源视觉语言模型(VLM),它将强大的图像理解能力与极小的资源占用完美结合。这款模型设计初衷是为各种设备和平台提供多功能且易于访问的人工智能解决方案。

- 官网:https://moondream.ai

- GitHub:https://github.com/vikhyat/moondream

- 模型:https://huggingface.co/vikhyatk

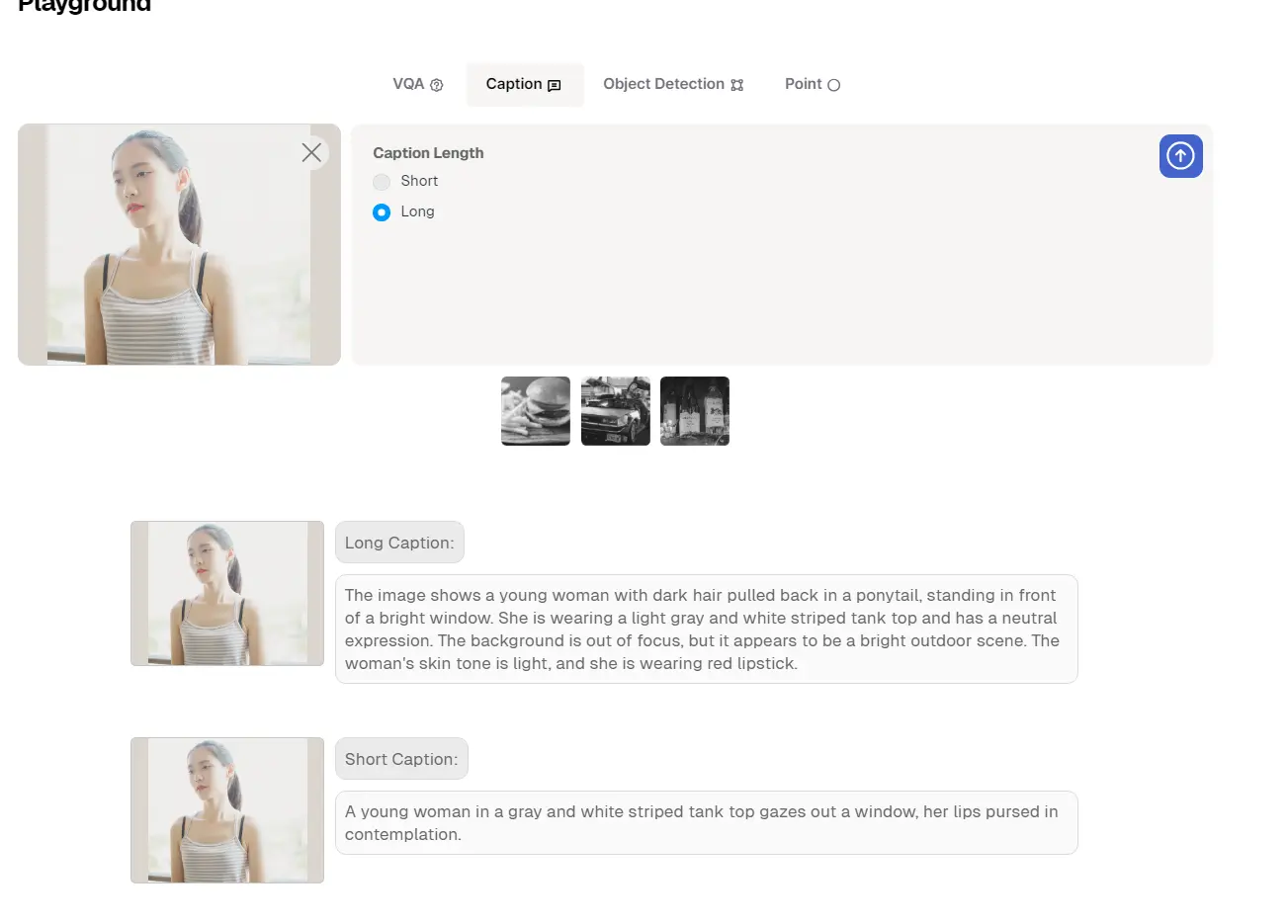

- Demo:https://moondream.ai/playground

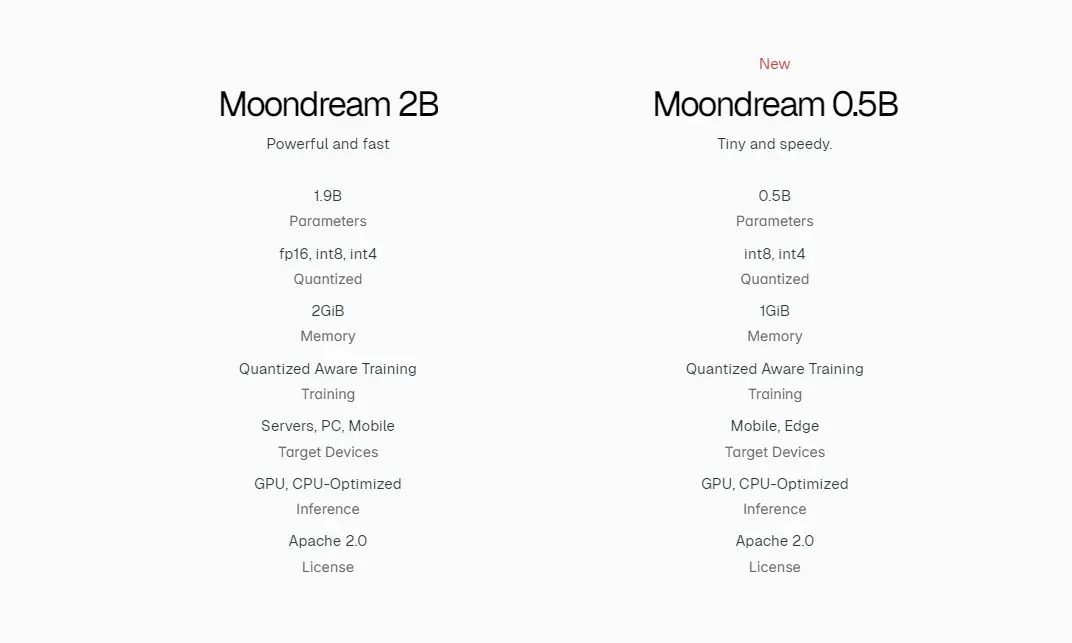

两种变体,满足不同需求

Moondream 提供了两个主要版本以适应不同的应用场景:

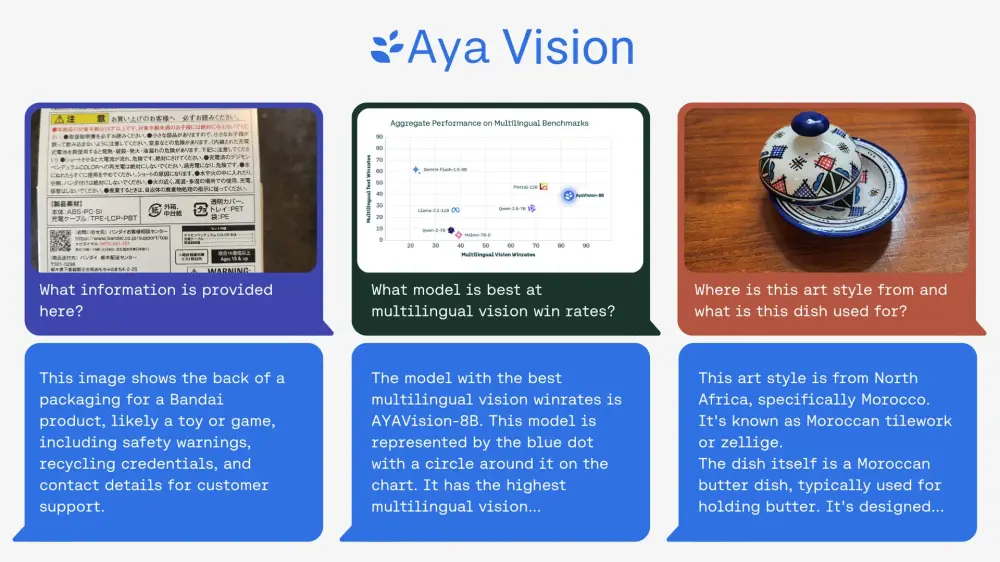

- Moondream 2B:作为核心产品,此模型拥有20亿参数,适用于需要高性能的通用图像理解任务,如字幕生成、视觉问答以及物体检测等。

- Moondream 0.5B:这是专为边缘设备优化的紧凑型模型,参数量为5亿,旨在资源受限的硬件上实现高效部署,同时保持卓越的性能。该版本于12月5日发布,成为目前世界上最小的视觉语言模型,致力于释放边缘设备和移动平台上的AI潜力。

紧凑尺寸,巨大潜能

尽管Moondream 0.5B仅有0.5亿参数,但它继承了Moondream 2B的成功,并在灵活的Apache许可证下开放给所有人使用。经过量化处理后,Moondream 0.5B的下载大小和运行时内存消耗显著减少,使其成为轻量级边缘设备的理想选择。具体来说:

- 8位量化时,压缩后的下载大小为479 MiB,运行时需996 MiB内存;

- 4位量化时,压缩后的下载大小降至375 MiB,运行时内存需求为816 MiB。

这意味着即便是在计算资源有限的情况下,用户也能享受到高质量的视觉语言处理服务。

拓展应用领域

Moondream 0.5B的小巧体积并未削弱其功能,反而为其在多个行业中的应用打开了大门:

- 零售业:通过智能化库存管理和个性化购物体验,甚至支持无收银员商店的概念;

- 制造业:强化质量监控和缺陷识别,辅助机器人进行更精准的操作;

- 交通运输:助力智能交通系统的发展,促进车辆自主驾驶技术的进步;

- 安全领域:实现在边缘侧快速部署AI监控系统,提升异常事件检测效率,保护数据隐私。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...