自动生成锚点风格的产品推广视频在在线商务、广告和消费者互动中展现出巨大的潜力。然而,尽管姿态引导的人类视频生成技术取得了显著进展,这一任务仍然充满挑战。特别是将人-物交互(Human-Object Interaction, HOI)整合到姿态引导的视频生成中,是实现高质量、可控交互的关键问题。

为了解决这一挑战,中国科学院计算技术研究所、美团、大湾区大学和腾讯的研究人员共同提出了一种基于扩散模型的人类视频生成框架AnchorCrafter,旨在生成包含目标人类和定制对象的2D视频,实现高视觉保真度和可控交互,用于创建高保真度的主播风格产品推广视频。

例如,有一个在线商店想要制作一个推广新手机的视频。他们可以提供一个主播的静态图片和新手机的多角度图片。AnchorCrafter能够利用这些图片,结合主播的动态姿势和手机的运动轨迹,自动生成一个视频,其中主播在讲解和展示这款手机时,手和手机之间的交互看起来非常自然和真实。

AnchorCrafter通过以下两项关键创新,显著提升了生成视频的质量和交互效果:

关键创新一:HOI-外观感知

增强多视角对象外观识别

- 解耦对象和人类外观:HOI-外观感知模块增强了从任意多视角识别对象外观的能力,并有效地解耦了对象和人类的外观特征。这使得生成的视频不仅能够准确呈现对象的细节,还能保持人类角色的真实感和自然性。

- 跨视角一致性:该模块确保对象在不同视角下的外观一致性,避免了因视角变化而导致的对象变形或失真,从而提高了视频的视觉保真度。

关键创新二:HOI-运动注入

复杂人-物交互的实现

- 对象轨迹条件管理:HOI-运动注入模块通过克服对象轨迹条件的挑战,实现了精确的对象运动控制。它能够在生成过程中动态调整对象的轨迹,确保其与人类动作自然协调。

- 相互遮挡管理:该模块还解决了人与物之间的相互遮挡问题,即使在复杂的交互场景中,也能保持物体和人物的连贯性和清晰度。

- 自然交互模拟:通过引入HOI-运动注入,AnchorCrafter能够模拟各种复杂的人-物交互,如拿起、放下、使用工具等,使生成的视频更加生动和真实。

HOI-区域重加权损失

为了进一步提升对象细节的学习效果,研究人员引入了一种新的训练目标——HOI-区域重加权损失。这种损失函数通过增强对对象细节的关注,确保生成的视频中对象的形状和外观得到更准确的保留。具体来说:

- 细节增强:HOI-区域重加权损失通过对对象区域进行加权,使得模型在训练过程中更加关注对象的细节,从而提高了对象的视觉质量。

- 形状意识:该损失函数还帮助模型更好地学习对象的形状特征,确保生成的视频中对象的形状保持一致,不会出现扭曲或变形。

主要功能:

- 人-物交互视频生成:能够根据给定的人物图像和产品图像生成包含复杂交互的2D视频。

- 对象外观保持:在视频生成过程中保持产品的外观和形状。

- 交互引导:精确控制人物与产品之间的交互动作。

主要特点:

- HOI-外观感知:通过多视角特征融合和解耦网络结构提高对象外观的识别准确性。

- HOI-运动注入:使用深度和手部3D网格输入精确控制对象轨迹,并处理遮挡问题。

- HOI区域重加权损失:在训练过程中增强对象细节的学习,特别是手-物交互区域。

工作原理:

AnchorCrafter基于视频扩散模型架构,包含一个扩散UNet和一个变分自编码器(VAE)。它通过以下步骤工作:

- 视频扩散模型:使用VAE将视频序列编码到潜在空间,并在训练期间通过添加噪声的方式进行扩散。

- HOI-外观感知:提取人物和对象的外观特征,并通过人-物双适配器将这些特征集成到UNet中。

- HOI-运动注入:考虑对象轨迹和人物手部的3D网格信息,以及它们之间的遮挡问题,来引导交互动作。

- HOI区域重加权损失:在训练过程中,通过增加手-物交互区域的权重来增强对象细节的学习。

实验验证

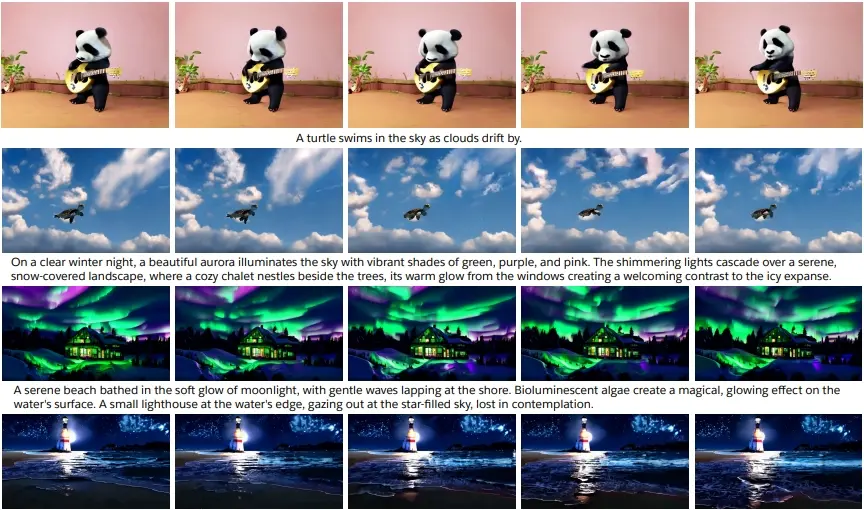

广泛的实验结果表明,AnchorCrafter在保留对象外观和形状意识方面显著优于现有方法,同时保持了人类外观和运动的连贯性。具体来说:

- 视觉保真度:生成的视频在视觉上高度逼真,对象和人类角色的细节都得到了很好的保留。

- 交互自然性:视频中的人-物交互非常自然,无论是简单的动作还是复杂的操作,都能流畅地呈现。

- 可控性:用户可以通过调整输入参数,灵活控制生成视频的内容和风格,满足不同的应用场景需求。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...