StdGEN 是由腾讯AI实验室、清华大学和北京航空航天大学的研究人员联合推出的一种创新管道,它能够从单张图片中生成语义分解的高质量3D角色模型。这项技术在虚拟现实、游戏和电影制作等领域有着广泛的应用前景。

- 项目主页:https://stdgen.github.io

- GitHub:https://github.com/hyz317/StdGEN

- 模型:https://huggingface.co/hyz317/StdGEN

- Demo:https://huggingface.co/spaces/hyz317/StdGEN

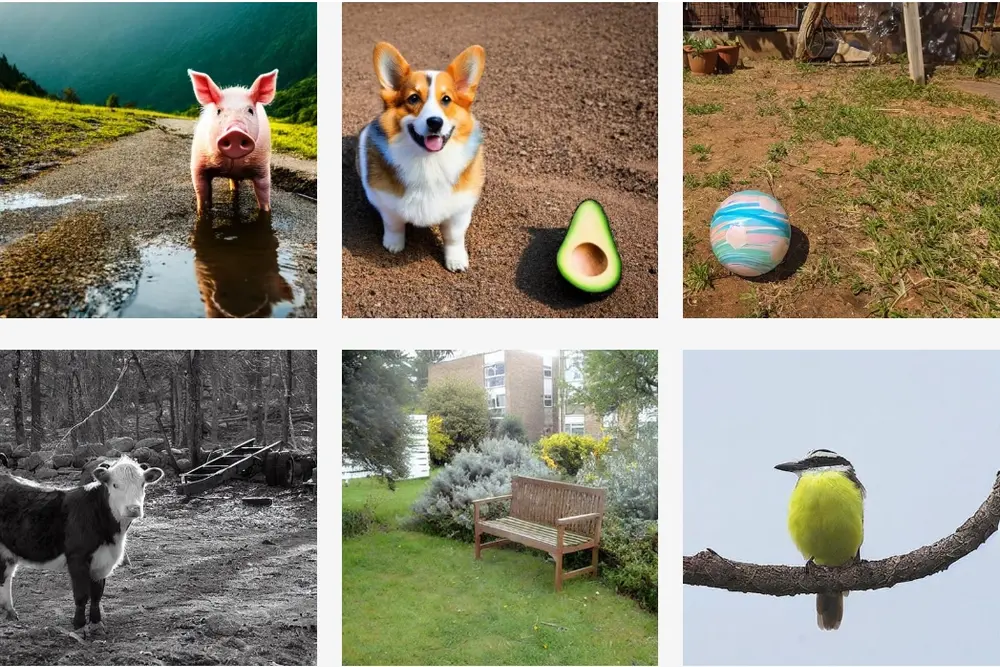

例如,在游戏开发中,设计师可能需要根据概念艺术图快速创建一个3D角色模型。使用StdGEN,他们只需提供一张角色的参考图片,系统就能自动生成一个包含身体、衣物和头发等语义分解组件的3D角色模型,这些组件可以单独编辑和动画化,大大提高了角色创建的灵活性和效率。

核心优势

与之前的生成方法相比,StdGEN 具有以下显著优势:

分解性:生成的3D角色具有精细的语义组件,包括身体、衣服和头发等分离的部分。 有效性:生成的3D角色具有高质量的几何和纹理细节。 高效性:整个生成过程仅需三分钟,大大缩短了优化时间。

技术细节

StdGEN 的核心是语义感知大重建模型(S-LRM),这是一个基于 Transformer 的可泛化模型,能够从前馈方式的多视图图像中联合重建几何、颜色和语义。

1、语义感知大重建模型(S-LRM):

基于 Transformer:S-LRM 使用 Transformer 架构,能够从前馈方式的多视图图像中联合重建几何、颜色和语义。 多视图图像:输入多视图图像,以获取更全面的3D信息。

2、可微分多层语义表面提取方案:

混合隐式场:从 S-LRM 重建的混合隐式场中提取网格。 多层语义表面:通过可微分的多层语义表面提取方案,确保生成的3D角色具有精细的语义组件。

3、高效多视图扩散模型:

多视图扩散:集成高效的多视图扩散模型,提高生成质量和速度。

4、迭代多层表面细化模块:

表面细化:通过迭代多层表面细化模块,进一步优化生成的3D角色的几何和纹理细节。

工作原理:

StdGEN的工作流程包括三个关键阶段:

多视图扩散:使用专门的多视图扩散模型从单张参考图片生成多个A姿势的RGB图像和法线贴图。 前馈重建:通过S-LRM处理生成的图像,以前馈方式重建几何、颜色和语义。 网格细化:通过迭代的多层网格细化方法进一步提高网格质量。

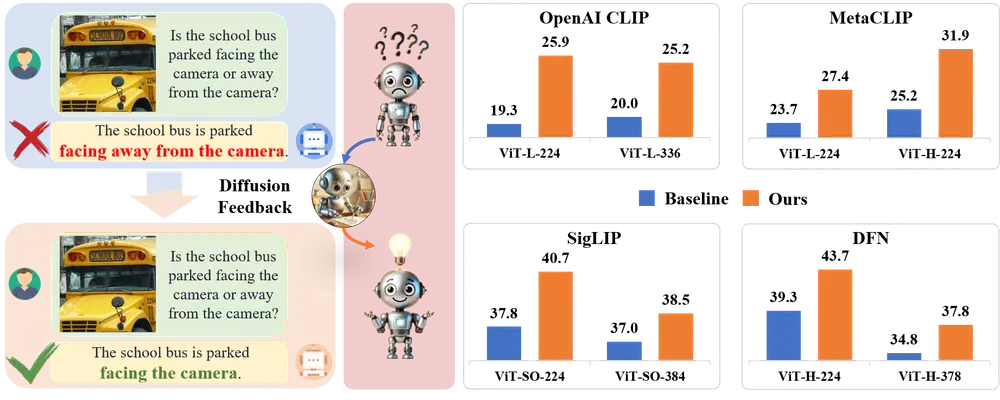

实验结果

广泛的实验证明了 StdGEN 在3D动漫角色生成方面的最先进性能,具体表现在以下几个方面:

几何:生成的3D角色具有高质量的几何细节。 纹理:生成的3D角色具有逼真的纹理效果。 分解能力:生成的3D角色具有精细的语义组件,便于后续的定制和编辑。

应用场景

StdGEN 提供了即用型的语义分解3D角色,并支持广泛应用的灵活定制,具体应用场景包括:

虚拟现实:生成高质量的3D角色,用于虚拟现实应用。 游戏开发:生成具有精细细节的游戏角色,提升游戏体验。 电影制作:生成高质量的3D角色,用于电影特效和动画制作。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...